题目: Weakly-Supervised Disentanglement Without Compromises

摘要:

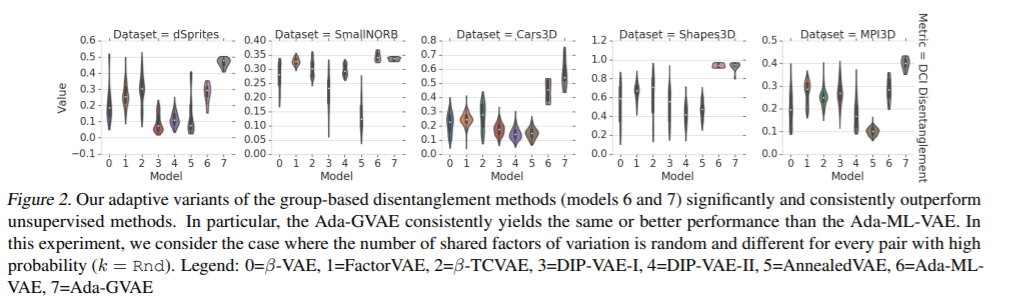

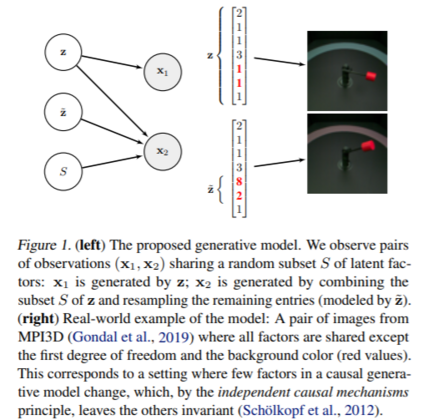

智能体应该能够通过观察其环境中的变化来学习有用的表示。首先,从理论上证明,只知道有多少因素发生了变化,而不知道哪些因素发生了变化,就足以学习解缠表示。其次,我们提供了实用的算法,可以从成对的图像中学习分离的表示,而不需要对组、单个因素或已更改的因素的数量进行注释。第三,我们进行了大规模的实证研究,并表明这样的观测对足以可靠地学习几个基准数据集上的解缠表示。最后,我们评估我们的表示学习,并发现它们在不同的任务集合上同时是有用的,包括协变量转移下的泛化、公平性和抽象推理。总的来说,结果表明,在现实场景中,弱监督能够帮助学习有用的解缠表示。

成为VIP会员查看完整内容

相关内容

弱监督学习:监督学习的一种。大致分3类,第一类是不完全监督(incomplete supervision),即,只有训练集的一个(通常很小的)子集是有标签的,其他数据则没有标签。这种情况发生在各类任务中。例如,在图像分类任务中,真值标签由人类标注者给出的。从互联网上获取巨量图片很容易,然而考虑到标记的人工成本,只有一个小子集的图像能够被标注。第二类是不确切监督(inexact supervision),即,图像只有粗粒度的标签。第三种是不准确的监督(inaccurate supervision),模型给出的标签不总是真值。出现这种情况的常见原因有,图片标注者不小心或比较疲倦,或者某些图片就是难以分类。

专知会员服务

36+阅读 · 2020年3月13日