![]()

来源:arXiv

编辑:肖琴

【新智元导读】南京大学周志华团队最新研究首次将深度森林引入到多标签学习中,提出多标签深度森林方法MLDF,在9个基准数据集上都实现了最佳的性能。你怎么看这一深度森林的最新应用,来新智元 AI 朋友圈和AI大咖们一起讨论吧。

2017年,南京大学机器学习与数据挖掘研究所(简称LAMDA 团队)的周志华教授与他的团队,提出了

“深度森林”(Deep forest)

:一种基于树的方法,拓展了深度学习的体系。

在设置可类比的情况下,新方法 gcForest 取得了和深度神经网络相当甚至更好的结果,而且更容易训练,小数据也能运行,更重要的是相比神经网络,基于树的方法不会存在那么困难的理论分析问题。

![]()

周志华和冯霁在论文里写道,“我们认为,要解决复杂的问题,学习模型也需要往深了去。然而,当前的深度模型全部都是神经网络。这篇论文展示了如何构建深度森林(deep forest),为在许多任务中使用深度神经网络之外的方法打开了一扇门”。

最近,周志华教授团队再次拓展了深度森林的应用范围,

将深度森林方法用于多标签学习(multi-label learning)

。

在多标签学习中,每个实例都与多个标签相关联,而关键的任务是如何在构建模型中利用标签相关性(label correlation)。

深度神经网络方法通常将特征信息和标签信息一起嵌入到一个潜在空间中,以利用标签的相关性。然而,这些方法的成功在很大程度上取决于对模型深度的精确选择。

深度森林是一种基于树模型集成的深度学习框架,它不依赖于反向传播。周志华团队认为,深度森林模型的优点非常适合解决多标签问题。

因此,他们使用两种机制设计了

多标签深度森林方法(Multi-Label Deep Forest MLDF)

:度量感知特性重用(measure-aware feature reuse)和度量感知层增长(measure-aware layer growth)。

MLDF同时处理两个具有挑战性的问题:一个是限制模型的复杂性以缓解过拟合问题;另一个是根据用户需求优化性能指标,因为在多标签评估任务中有许多不同的指标。

实验结果表明,MLDF方法不仅在基准数据集上优于其他6种作为比较的方法,而且在多标记学习中具有标记相关性发现等特性。

在多标签学习中,每个实例都同时与多个标签相关联,多标签学习的任务是为未见过的实例预测一组相关标签。多标签学习被广泛应用于文本分类、场景分类、功能基因组学、视频分类、化学品分类等多种问题。多标签学习任务在现实问题中无所不在,吸引了越来越多的研究关注。

通过将多标签学习问题转化为每个标签独立的二元分类问题,即Binary Relevance 算法[Tsoumakas and Katakis, 2007]是一种简单的方法,已在实践中得到广泛应用。虽然它的目标是充分利用传统的高性能单标签分类器,但是当标签空间较大时,会导致较高的计算成本。此外,这种方法忽略了一个标签上的信息可能有助于学习其他相关标签的事实,从而限制了预测性能。研究标签之间的相关性已被证明是提高多标签学习性能的关键。因此,越来越多的多标签学习方法旨在探索和利用标签的相关性。在多标签学习方法中,标签相关性的探索和利用受到了相当多的关注。

与传统的多标签方法不同,深度神经网络模型通常尝试学习一个新的特征空间,并在顶部使用一个多标签分类器。最早利用网络架构的是BP-MLL [Zhang and Zhou, 2006],它不仅将每个输出节点视为一个二元分类任务,还利用了依赖于该架构本身的标签相关性。随后,在BP-MLL的基础上, [Nam et al., 2014]提出一种比较简单的神经网络方法,用熵损失代替 pairwise ranking损失,利用深度神经网络技术,在大规模文本分类中取得了良好的效果。然而,深度神经模型通常需要大量的训练数据,因此通常不适合小规模的数据集。

南京大学周志华教授和冯霁认识到深度学习的本质在于逐层处理、模型内特征转换和足够的模型复杂度,提出深度森林(Deep forest)[Zhou and Feng, 2018]。

深度森林是建立在决策树之上的集成深度模型,在训练过程中不使用反向传播。具有级联结构的深度森林集成系统能够像深度神经模型一样进行表示学习。深度森林更容易训练,因为它的超参数更少。深度森林已经在大规模金融欺诈检测、图像、文本重构等许多任务中取得了优异的性能。虽然深度森林在传统的分类任务中已经被证明有用,但是在本工作之前,尚没有人注意到将其应用于多标签学习的潜力。

深度森林的成功主要来自于以集成方式进行的逐层特征转换。而另一方面,多标签学习的关键是如何利用标签相关性。受这两个事实的启发,我们提出了多标签深度森林(MLDF)方法。

简而言之,

MLDF使用不同的多标签树方法作为深度森林的构建块,并通过逐层表示学习来利用标签相关性

。

由于多标签学习中的评估比传统的分类任务更复杂,因此有多种性能度量方法[Schapire and Singer, 2000]。值得注意的是,不同的用户有不同的需求,不同的算法在不同的度量上的表现也不同。

为了在特定度量上获得更好的性能,我们提出了两种机制:度量感知特性重用(measure-aware feature reuse)和度量感知层增长(measure-aware layer growth)。

受置信度筛选启发的度量感知特征重用机制重用了前一层中的良好表示。度量感知层增长机制则旨在通过各种性能度量来控制模型的复杂性。

接下来,本文将介绍MLDF方法和两种度量感知机制,并报告实验的结果。

MLDF方法和框架:两种机制,更好地利用标签相关性

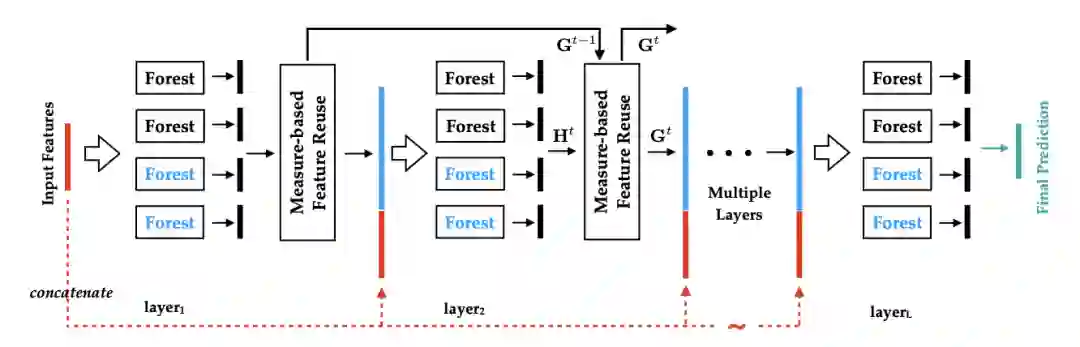

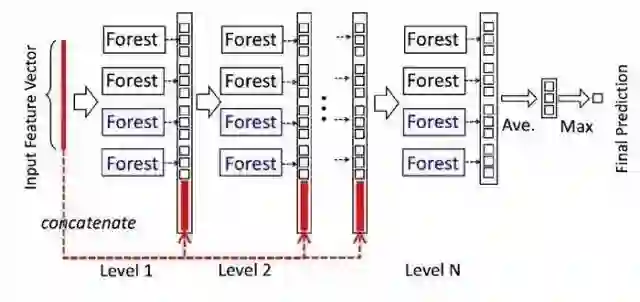

图1展示了MLDF的框架。MLDF的每一层都集成了不同的多标签森林(上方的黑色森林和下方的蓝色森林)。由

![]() ,我们可以得到

,我们可以得到

![]() 表示。度量感知特征重用部分将接收表示

表示。度量感知特征重用部分将接收表示![]() ,并在不同度量性能的指导下,通过重用

,并在不同度量性能的指导下,通过重用

![]() 中学习到的表示

中学习到的表示

![]() 来更新

来更新![]() 。然后,新的表示法

。然后,新的表示法

![]() (蓝色部分)将与原始的输入特性(红色部分)连接在一起,进入下一层。

(蓝色部分)将与原始的输入特性(红色部分)连接在一起,进入下一层。

图1:多标签深度深林(MLDF)的框架。每一层由两组不同的森林组成(上方的黑色森林和下方的蓝色森林)。

在MLDF中,每一层都是森林的集合。为了提高集成的性能,我们考虑使用不同的树生长方法来鼓励多样性,这是集成方法成功的关键[Zhou, 2012]。

在MLDF,我们采用RF-PCT [Kocev et al ., 2013)作为森林的block,以及两种不同的方法在树中生成节点以形成森林:一种方法考虑每个特性所有可能的分割点,即RF-PCT;另一种方法随机考虑一个分割点,我们称为ERF-PCT。

如前面所述,给定一个实例,森林将产生对标签分布的估计值,可以将其视为属于每个标签的实例的置信度。在每一层中学习的表示将采用可度量的特性重用,并将原始输入特性输入到下一层。具有丰富标签信息的实值表示将被输入到下一层,以便MLDF更好地利用标签相关性。

预测过程可以总结如下。如图1所示,假设森林已经很好地拟合了。首先,我们将实例预处理为标准矩阵X。其次,实例矩阵X通过第一层,得到表示H¹。通过度量感知特性的重用,我们可以得到G¹。然后我们将G¹与原始输入特性X连接起来,并将它们放到下一层。在多层之后,我们得到了最终的预测。

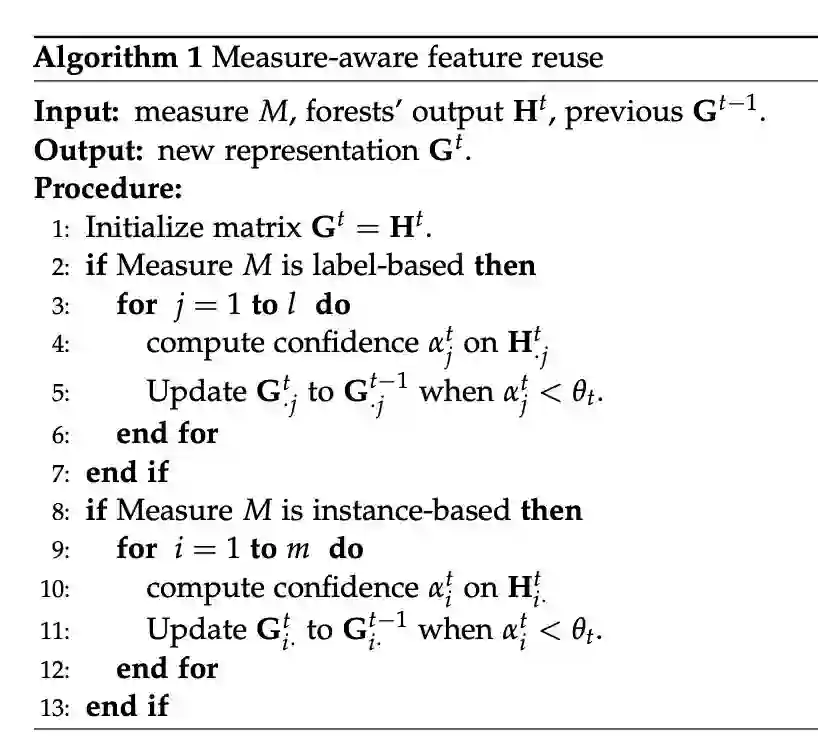

算法1总结了Measure-aware feature reuse的过程。

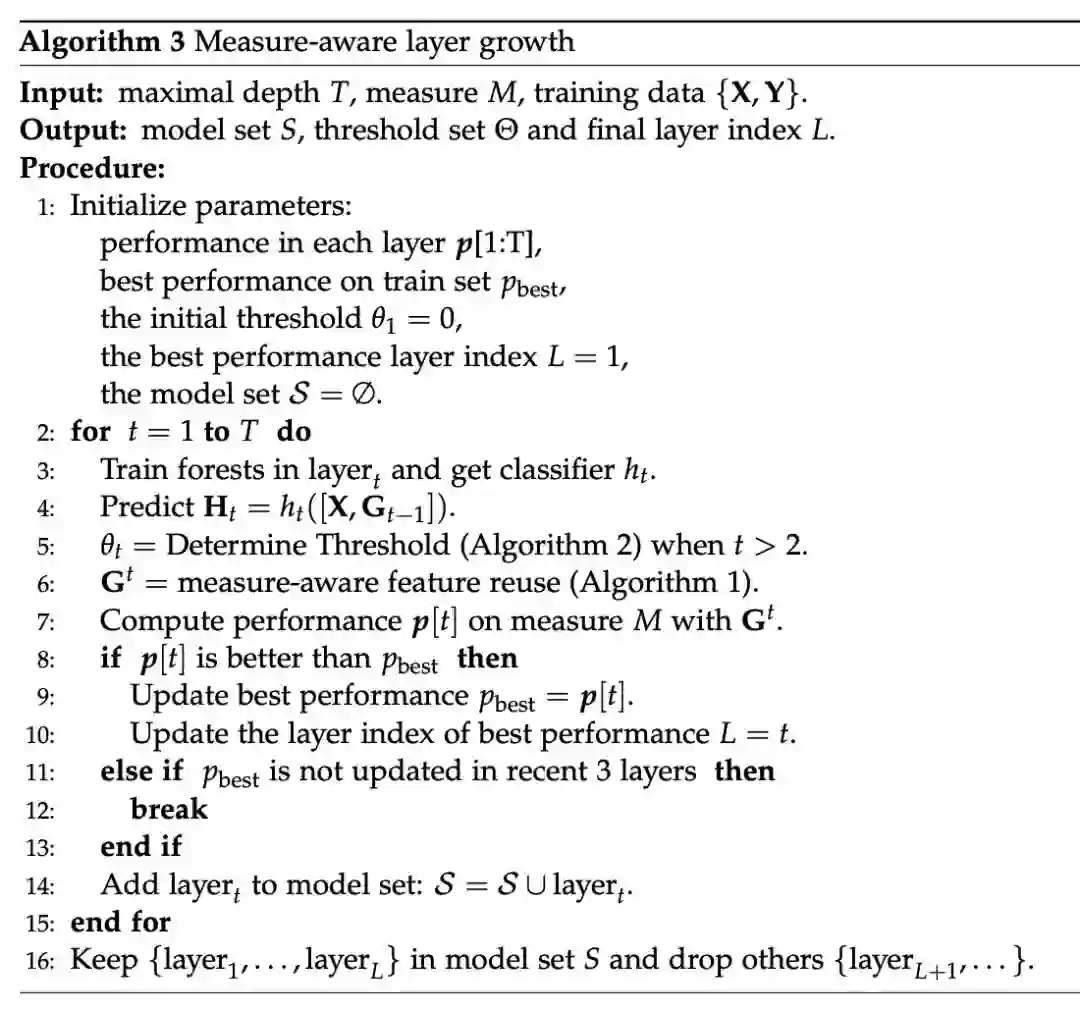

算法3总结了用于MLDF训练的measure-aware layer growth的过程。

本研究使用MLDF对不同的多标签分类基准数据集进行了实验。实验的目标是验证MLDF可以在不同的度量上获得最佳的性能,并且两种度量感知机制都是必要的。此外,我们还从各个方面通过更详细的实验展示了MLDF的优点。

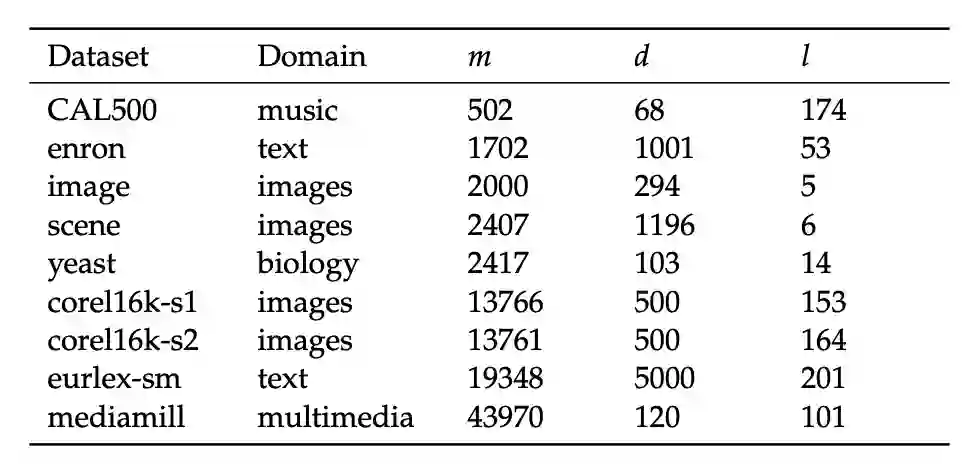

我们选择了9个来自不同应用领域、不同规模的多标签分类基准数据集。表3给出了这些数据集的基本统计信息。

表3:数据集的域(Domain)、实例数量(m)、特征数量(d)和标签数量(l)

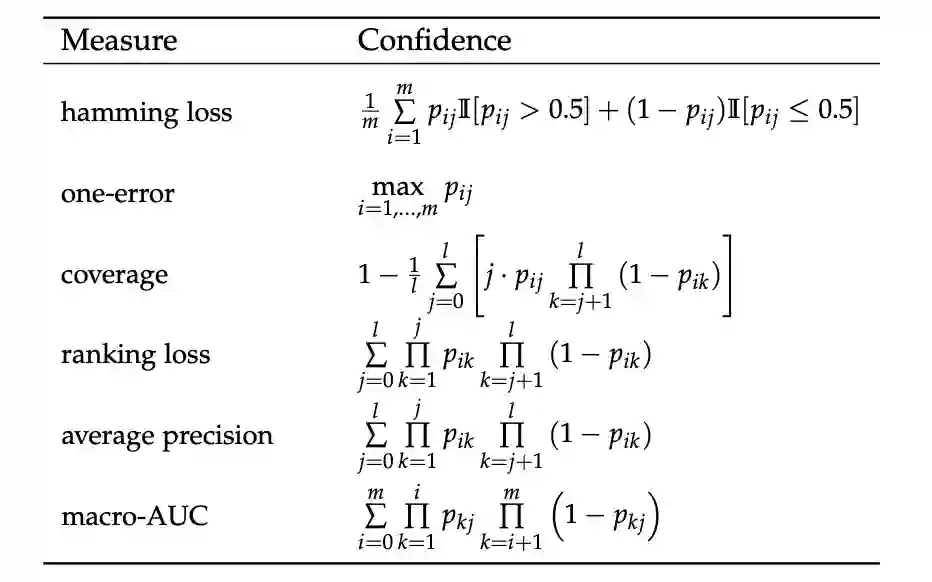

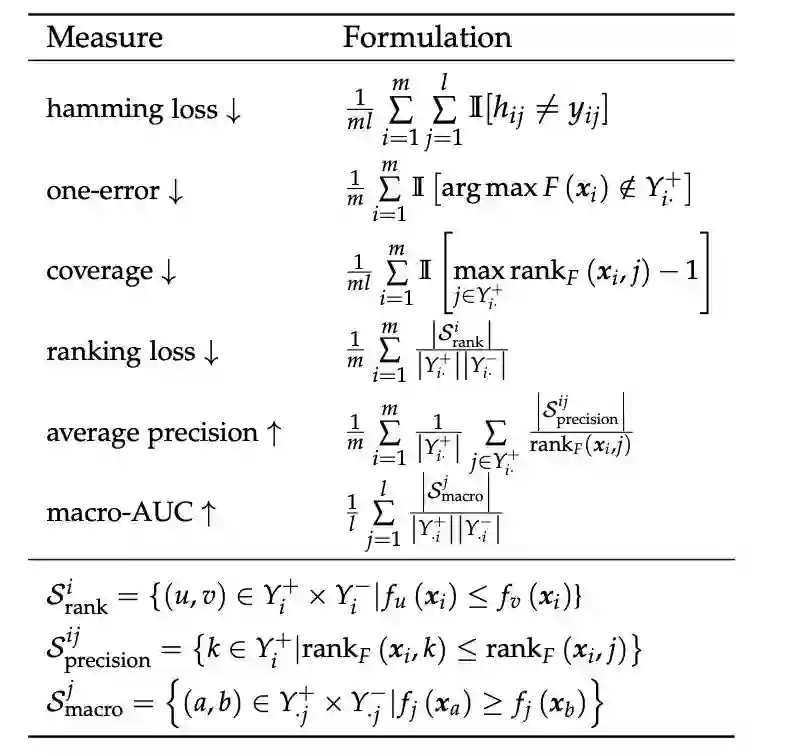

本文采用了在多标签学习中广泛使用的6种评估方法,分别是:hamming loss, one-error, coverage, ranking loss, average precision, 以及 macro-AUC [Wu and Zhou, 2017]。

表1:六种多标签性能指标的定义:↓表示越低越好,↑表示越高越好。

a) RF-PCT [Kocev et al., 2013],

b) DBPNN [Hinton and Salakhutdinov, 2006; Read et al., 2016],

c) MLFE [Zhang et al., 2018a],

d) RAKEL [Tsoumakas and Vlahavas, 2007]

e) ECC [Read et al., 2011].

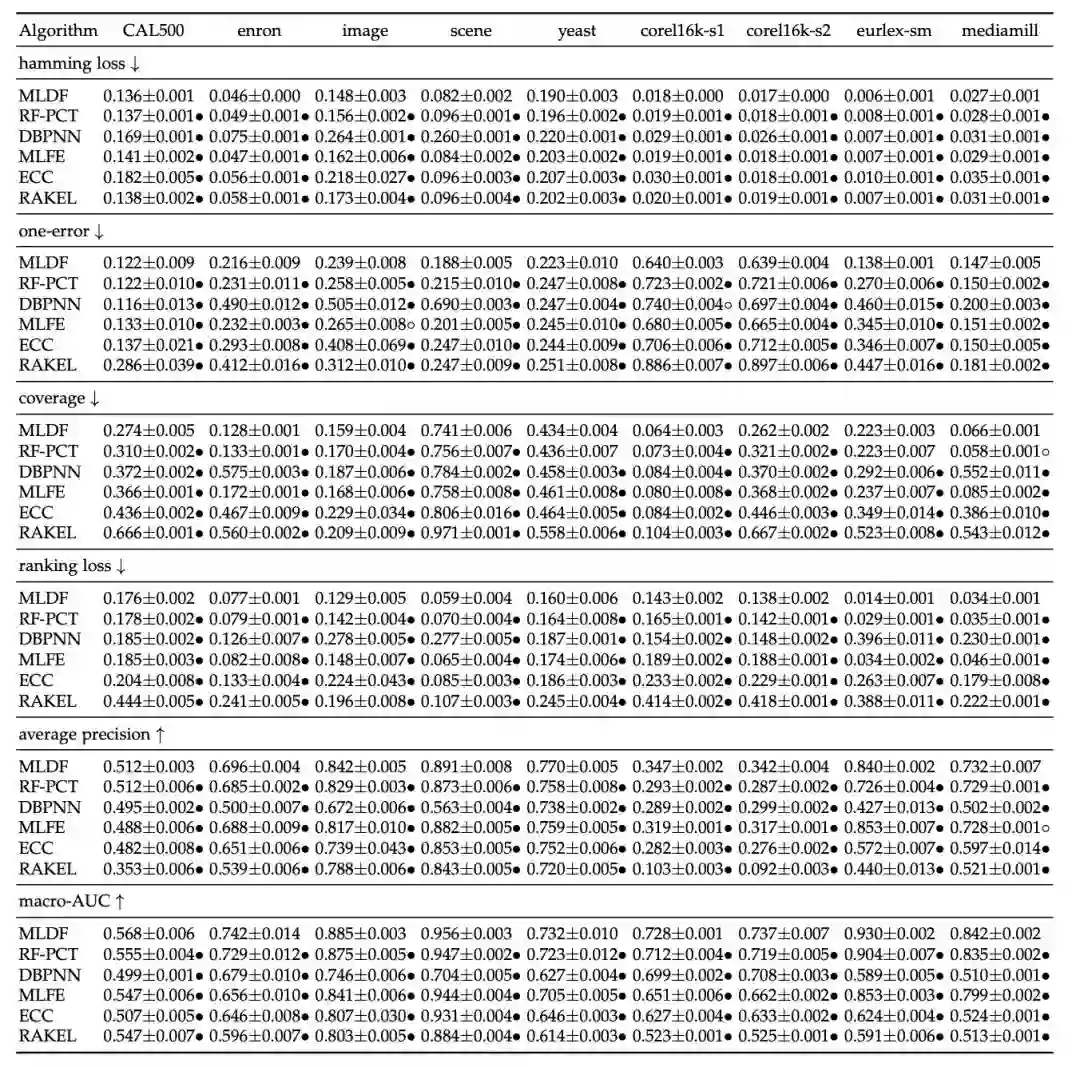

我们对每个算法进行了十次实验。记录10个训练/测试试验的平均值和标准偏差,以进行比较研究。表4给出了比较算法的详细实验结果。

表4:9个数据集上每种比较方法的预测性能(均值±标准差)。•(◦)表明在95%显著水平,MLDF明显优于(差于)基于paired t-test 的比较方法。↓(↑)表示值越小(越大),性能越好。

实验结果显示,MLDF在每个评价指标上都达到了最佳(最低)的平均排名。在9个基准数据集中,所有评价指标中,MLDF在98.46%的案例中排名第一,在1.54%的案例中排名第二。

与这6项指标相比,MLDF分别在100.00%、96.29%、96.29%、100.00%、98.15%、100.00%的案例中排名第一。

总而言之,

MLDF在各种评估方法的广泛基准数据集上,与其他成熟的竞争方法相比,均取得了最佳的性能,这验证了MLDF的有效性

。

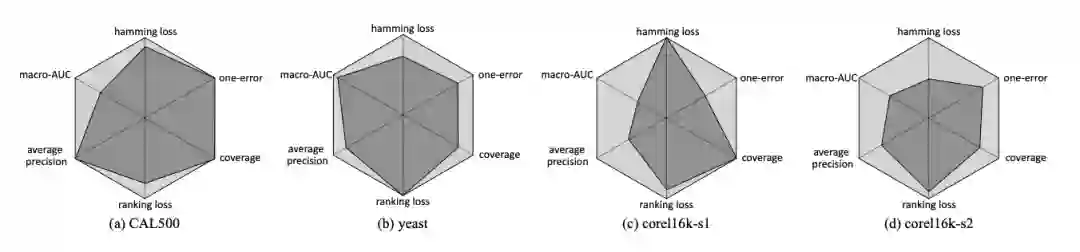

measure-aware feature reuse的影响

图2显示了在CAL500、yeast、corel16k-s1和corel16k-s2上使用该机制和不使用该机制的结果比较。

图2:

在CAL500、yeast、corel16k-s1和corel16k-s2上的性能比较。浅色的六边形代表采用measure-aware feature reuse机制的MLDF的性能,深色的六边形代表不采用该机制的MLDF的性能。面积越大,性能越好。

直观地说,级联结构使MLDF能够利用标签相关性。我们的分层方法通过在高层建模中使用低层标签表示来逐步考虑更复杂的标签相关性。

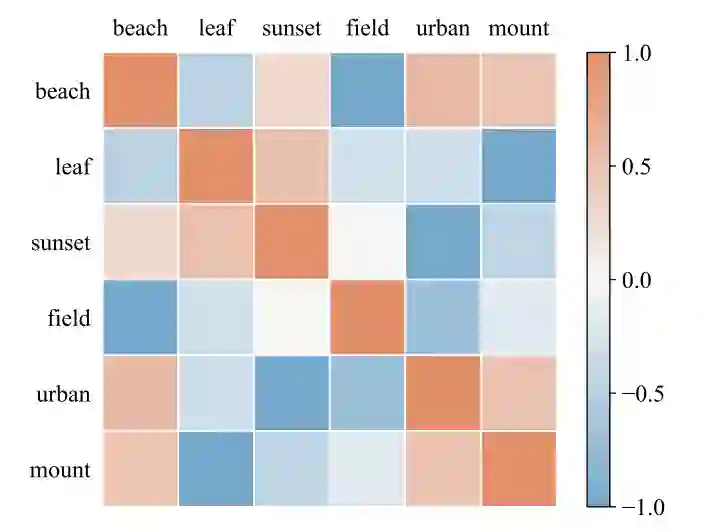

如图4所示,标签“Sunset”高度影响标签“Leaf”,因为丢失一个标签的信息会严重影响另一个标签的性能。此外,标签“Beach”与标签“Urban”高度相关,因为有时它们一起存在于场景数据集中。这表明,MLDF利用标签之间的相关性来获得更好的性能。

图4:缺失的表示信息对每个标签的影响。场景数据集有6个标签(从上到下,从左到右):“Beach", “Leaf", “Sunset", “Field", “Urban" 和 “Mountain”.

![]()

新智元AI朋友圈详细使用教程,8000名AI大玩家和实践者都在这里!

,我们可以得到

,我们可以得到

表示。度量感知特征重用部分将接收表示

表示。度量感知特征重用部分将接收表示 ,并在不同度量性能的指导下,通过重用

,并在不同度量性能的指导下,通过重用

中学习到的表示

中学习到的表示

来更新

来更新 。然后,新的表示法

。然后,新的表示法

(蓝色部分)将与原始的输入特性(红色部分)连接在一起,进入下一层。

(蓝色部分)将与原始的输入特性(红色部分)连接在一起,进入下一层。