【干货】Geoffrey Hinton《神经网络机器学习》经典课程(附课程PPT下载)

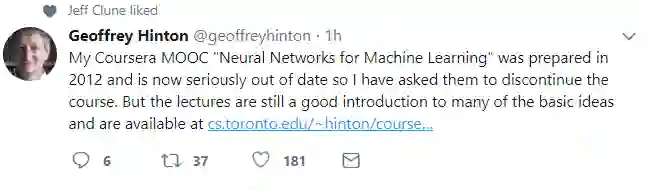

【导读】今日,深度学习三巨头之一,Geoffrey Hinton通过twitter公布了自己在2012年准备的MOOC课程——机器学习中的神经网络。课程中详细介绍了神经网络的各种概念与特点,虽然来自于5年前,但仍不失为一份很有意义的讲解,特此编译如下。

作者简介:

Geoffrey Hinton,被称为“神经网络之父”、“深度学习鼻祖”,他曾获得爱丁堡大学人工智能的博士学位,并且为多伦多大学的特聘教授。在2012年,Hinton还获得了加拿大基廉奖(Killam Prizes,有“加拿大诺贝尔奖”之称的国家最高科学奖)。2013年,Hinton 加入谷歌并带领一个AI团队,他将神经网络带入到研究与应用的热潮,将“深度学习”从边缘课题变成了谷歌等互联网巨头仰赖的核心技术,并将反向传播算法应用到神经网络与深度学习。

作者主页:

https://www.cs.toronto.edu/~hinton/

介绍:

本次公布的课程共有16节,基本涵盖了神经网络相关的各个知识点,正如hinton所说,课程中有些算法已经过时,但其中的理论基础仍然在为今天的各类主流算法提供着可靠的支持,对于算法研究者来说,重温经典有助于加深对这一领域的理解,并对未来的研究方向起到一定的借鉴意义。

视频链接:

https://www.cs.toronto.edu/~hinton/coursera_lectures.html

请关注专知公众号(点击标题下方蓝色专知关注)

后台回复“GHNM” 就可以获取Hinton课程全套ppt下载链接~

专知《深度学习:算法到实战》2019年1月正在开讲,欢迎报名!

专知开课啦!《深度学习: 算法到实战》, 中科院博士为你讲授!

整体课程内容大纲如下:

第一节

我们为什么需要神经网络

什么是神经网络

一些简单的神经元模型

一些简单的例子

三种学习任务

第二节

主要神经网络类型概览

感知机:第一代神经网络

感知机的几何视角

为什么学习方法有用

感知机不能做什么?

第三节

线性神经元的权重学习

线性神经元的误差表现

逻辑回归神经元的权重学习

反向传播算法

如何使用反向传播算法计算

学习下一个单词的预测模型

认知科学

在神经概率语言模型中解决大规模输出的办法

第五节

目标识别问题的难点所在

得到观点不变性的方法

面向手写字体识别的卷积神经网络方法

面向目标识别问题的卷积神经网络方法

第六节

小批量梯度下降问题概览

小批量梯度下降的训练技巧

动力学方法

针对每个连接的独立、自适应的学习率

rmsprop

序列建模:简要概述

使用反向传播训练RNN

RNN训练样例

为什么RNN难以训练

长短期记忆网络

第八节

Hessian-Free优化问题概述

字符串建模

使用HF预测下一个字符

状态网络

增强泛化指标方法概述

限制权重规模

使用噪声进行正则

贝叶斯方法介绍

解决权重开销的快速方法

第十节

为什么有助于模型联结

混合系统

完整贝叶斯学习方法

全贝叶斯学习实践

Dropout

第十一章

Hopfield网络

处理hopfiled网络的局部最小值问题

使用随机单元提高搜索能力

玻尔兹曼机模型数据

第十二章

玻尔兹曼机学习网络

更高效的方法

限制玻尔兹曼机

对比发散学习的例子

协同过滤中的RBM模型

第十三章

反向传播方法

Belief 网络

Sigmoid Belief 网络学习

wake-sleep算法

第十四章

层叠玻尔兹曼机特征学习

DBN微调

在调试过程中发生了什么?

RBM是有限的Sigmoid Belief Net

第十五章

从原理层面分析自编码器方法

深度自动编码器

用于文档检索与可视化的深度自编码器

语义哈希

图像检索

用于与训练的窄自编码器

第十六章

图像与描述信息的联合学习模型

分层协调框架

神经网络超参的贝叶斯优化

前进的迷雾

-END-

专 · 知

专知《深度学习: 算法到实战》课程正在开讲! 中科院博士为你讲授!

请加专知小助手微信(扫一扫如下二维码添加),咨询《深度学习:算法到实战》参团限时优惠报名~

欢迎微信扫一扫加入专知人工智能知识星球群,获取专业知识教程视频资料和与专家交流咨询!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程