【泡泡一分钟】视觉(-惯性)里程计定量轨迹评估教程

每天一分钟,带你读遍机器人顶级会议文章

标题:A Tutorial on Quantitative Trajectory Evaluationfor Visual(-Inertial) Odometry

作者:Zichao Zhang, Davide Scaramuzza

来源:IEEE/RSJ International Conference on Intelligent Robots and Systems(IROS),2018

翻译:孙钦

审核:颜青松,陈世浪

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

在本教程中,我们提出了通过视觉(-惯性)里程计(VO / VIO)定量评估估计轨迹质量的原则性方法,这是对不同算法的准确性进行基准测试的基础。首先,我们展示如何基于特定的感知模态(即单目,双目和视觉加惯性)确定在轨迹对齐中使用的变换类型。其次,我们描述了常用的误差度量(即绝对轨迹误差和相对误差)及其优缺点。

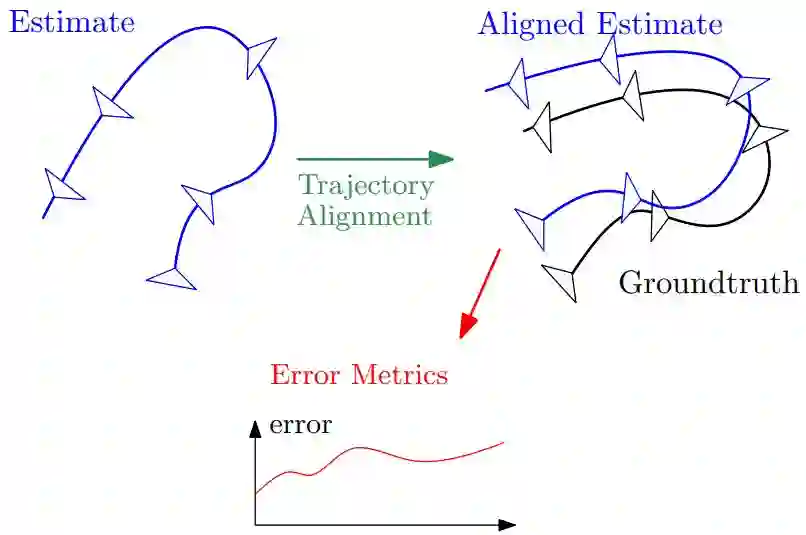

图1 定量轨迹评估过程,首先估计的轨迹(蓝色)需要和真值(黑色)对齐;然后利用特定的误差度量计算对齐后的轨迹估计误差。

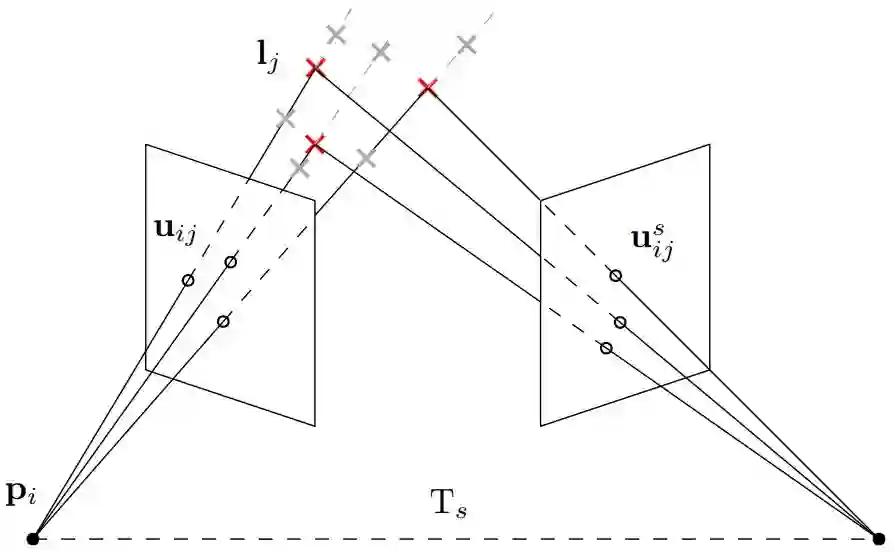

图2 单目相机的相机测量模型和尺度歧义性,相机将3D点(红色十字)投影到图像平面上的2D点(黑色圆圈)。对于单目相机,相同方向但不同距离(灰色十字)的3D点投影到相同的2D点,从而导致尺度歧义性。当添加相对于第一个具有恒定变换Ts的第二个相机时,就能消除该歧义性。

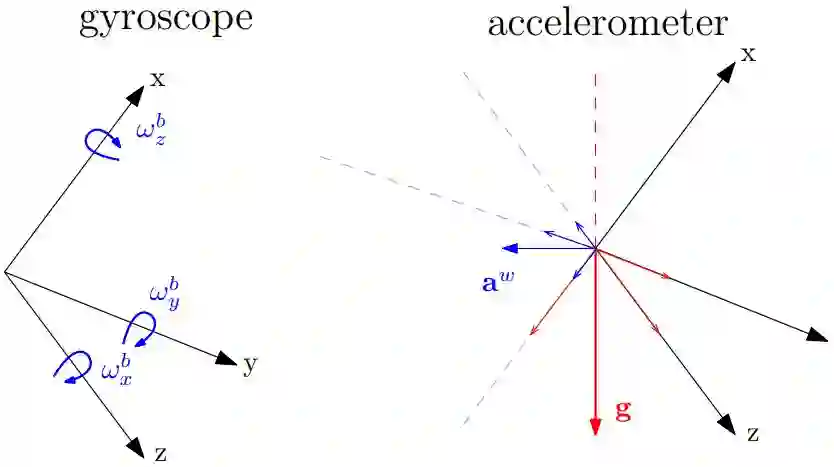

图3 IMU测量模型,如右图所示,如果本体坐标系绕重力方向(红色)旋转,本体坐标系的重力分量是不变的,而对于围绕任何其他轴的旋转,重力分量会改变。

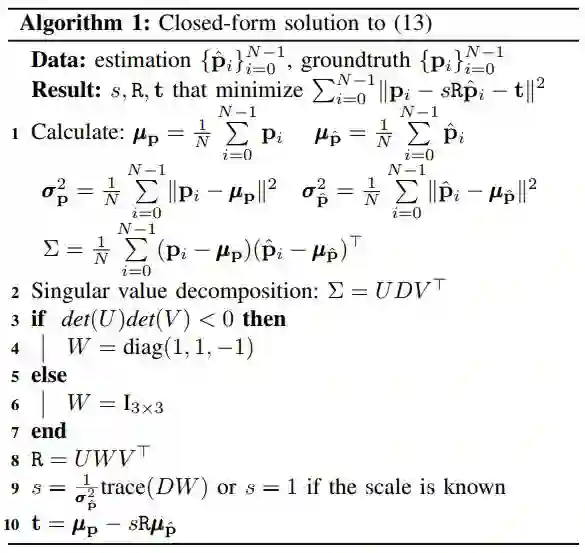

使用多状态实现轨迹对齐:

绝对轨迹误差和相对轨迹误差:

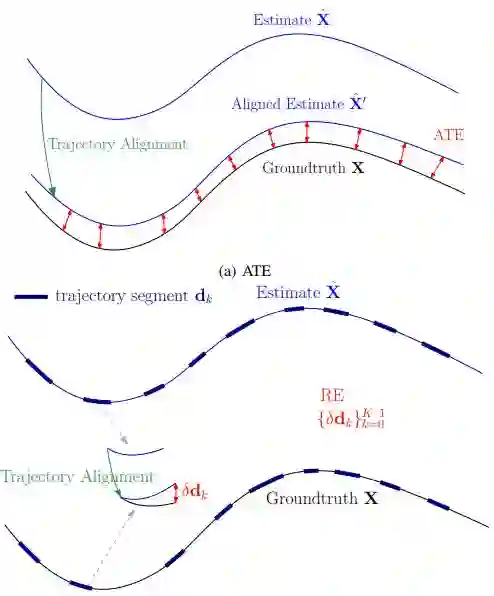

图4 绝对轨迹误差和相对误差说明,图中对齐后的误差在视觉上放大了,对于相对误差,轨迹段应该是所有满足特定判据的可能状态对。为了显示方便,它们在图中没有重叠。

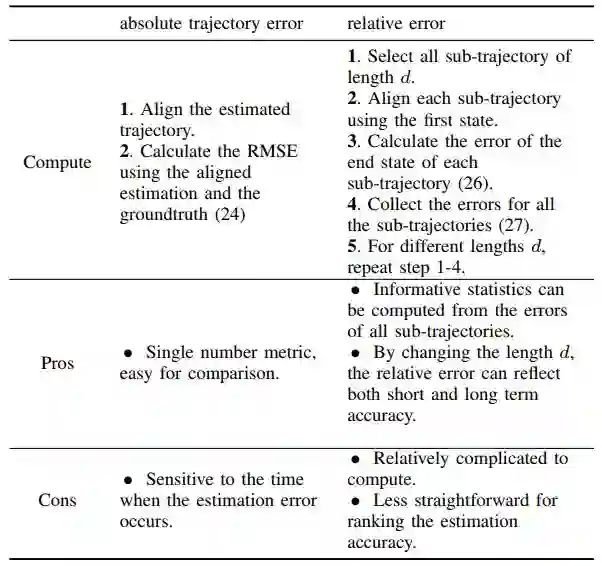

绝对轨迹误差和相对误差计算方式比较:

定量评估示例:

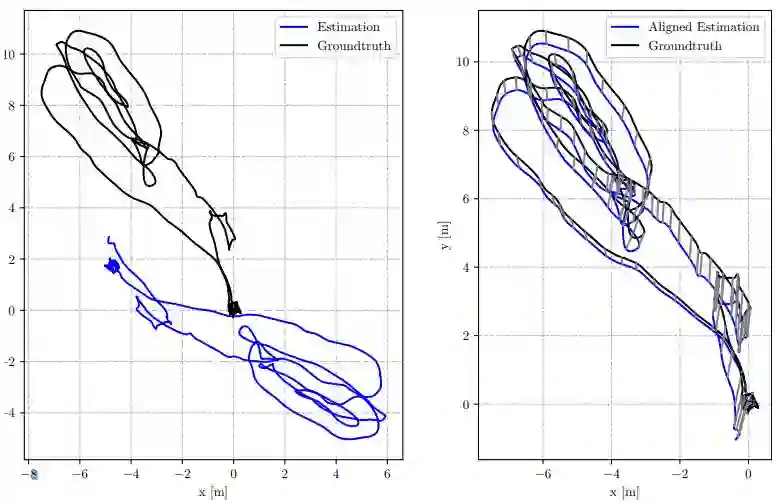

图5 左图是对齐前,右图是对齐后的图。右图中灰色的线为对应的状态。

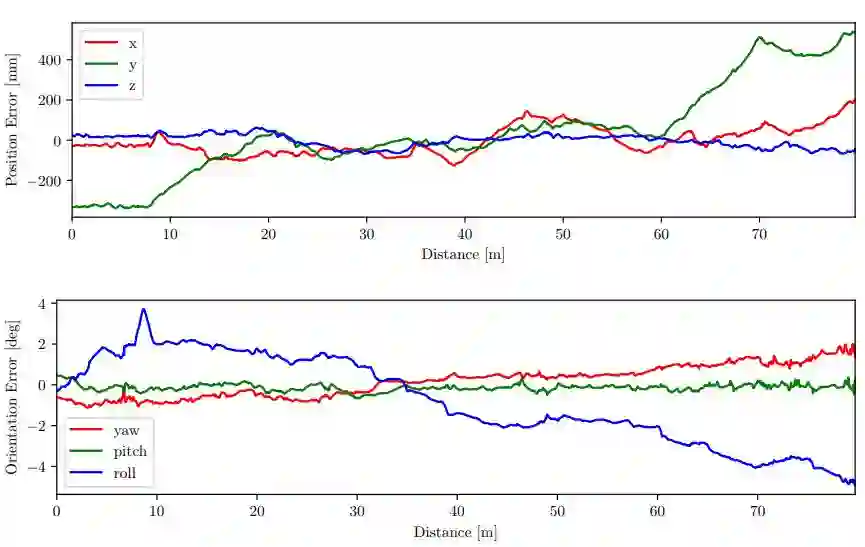

计算图5中每个状态的绝对误差:

图6 相对于行走距离的绝对位置误差和绝对方向误差,计算图5中对齐后的轨迹误差。

计算图5中的相对误差:

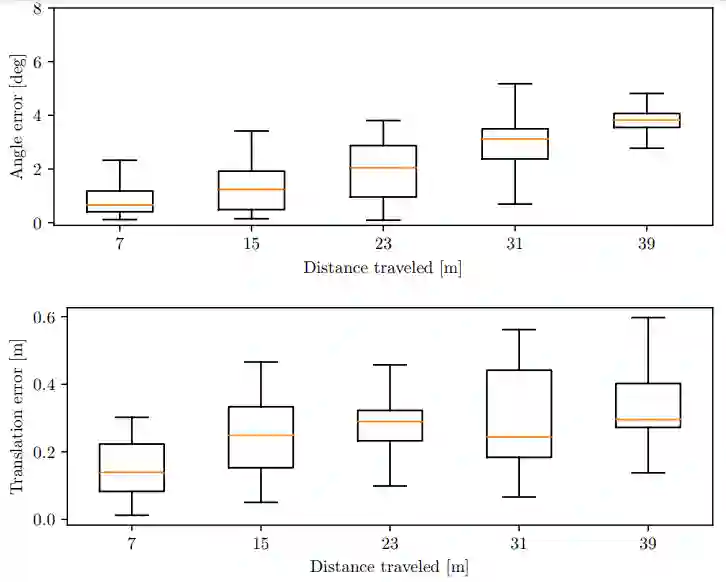

图7 不同轨迹长度的相对平移误差和相对旋转误差显示为一系列方框图,方框图的中间显示所有估计误差的两个四分位数。

最后,为了使VO / VIO的方法适用于其他设置,我们还将我们的公式推广到任何给定的感知模态。为了促进相关研究的可重复性,我们公开发布了本教程中描述的方法的实现。实现本教程中方法的轨迹评估开源工具箱:

https://github.com/uzh-rpg/rpg_trajectory_evaluation

Abstract

In this tutorial, we provide principled methods to quantitatively evaluate the quality of an estimated trajectory from visual(-inertial) odometry (VO/VIO), which is the foundation of benchmarking the accuracy of different algorithms. First, we show how to determine the transformation type to use in trajectory alignment based on the specific sensing modality (i.e., monocular, stereo and visual-inertial). Second, we describe commonly used error metrics (i.e., the absolute trajectory error and the relative error) and their strengths and weaknesses. To make the methodology presented for VO/VIO applicable to other setups, we also generalize our formulation to any given sensing modality. To facilitate the reproducibility of related research, we publicly release our implementation of the methods described in this tutorial.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com