【泡泡图灵智库】全向DSO:基于鱼眼相机的直接稀疏里程计(IROS)

泡泡图灵智库,带你精读机器人顶级会议文章

标题:Omnidirectional DSO:Direct Sparse Odometry with Fisheye Cameras

作者:Hidenobu Matsuki,Lukas von Stumberg,Vladyslav Usenko, Jörg Stückler and Daniel Cremers

来源:IROS 2018

编译:林瑞豪

审核:张蕾

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天为大家带来的文章是——全向DSO:基于鱼眼相机的直接稀疏里程计,该文章发表于IROS 2018。

我们提出了一个适用于全景相机的实时的直接单目视觉里程计。我们的方法通过使用统一的全向模型作为投影函数来扩展直接稀疏里程计(DSO),其可以应用于视角(FoV)远大于180度的鱼眼摄像机。这个构思允许我们使用输入图像全部区域的数据,即使具有强烈的失真,而大多数现有的视觉里程计方法只能使用其预处理和裁剪后的部分区域。活跃关键帧窗口内的模型参数被联合优化,包括内在/外在相机参数,点的3D位置和仿射亮度参数。因为拥有更加宽阔的视角,两帧图像的重叠区域变得更大并且点在空间上更加分散。我们的结果表明,我们的方法比起最先进的视觉里程计算法拥有更高的准确性和鲁棒性。

主要贡献

1、本文提出了DSO的全向扩展,这是第一个基于 鱼眼相机的直接视觉里程计,

2、该里程计能实时运行并且联合优化了多个模型参数:相机位姿,点的深度,相机内参和仿射亮度参数。

算法流程

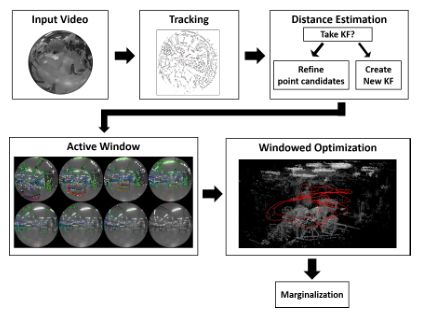

图1 全向DSO的系统预览

1、模型公式化

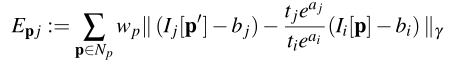

DSO联合优化最近帧窗口内的相机位姿,点的深度和仿射亮度参数。作为直接法,优化目标是光度一致性。DSO也将图像形成过程的光度校准考虑在内。表达两帧之间的光度误差的能量函数如下:

帧的活动窗口的光度误差项是:

2、沿着极曲线的距离估计

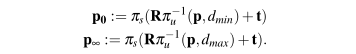

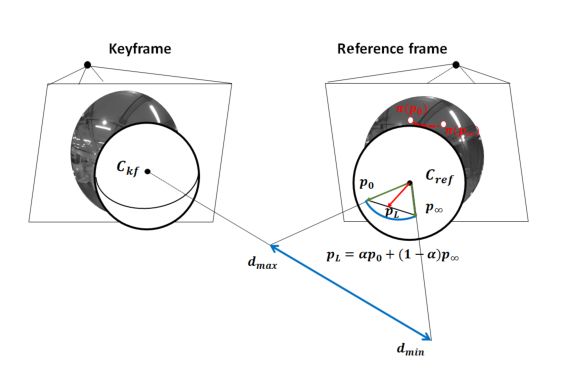

成功跟踪帧后,我们执行立体匹配以细化候选点的逆距离。 当候选点被包括在光度集束调整中时,该估计距离用作初始化。按照一定步长沿着极曲线搜索对应关系。极曲线的数学描述如下:

图2 与统一全方位相机模型的立体匹配:通过将沿着光线的距离搜索间隔映射到另一相机的投影单元球面上的方向间隔来执行对立体匹配的对应搜索。

3、帧管理

活跃帧数量为常量。它通过跟踪最新的关键帧及其稀疏距离图(步骤1)来跟踪每个新帧中的摄像机运动。如果观察到的场景中的变化对于最新的关键帧太大,则从新帧创建关键帧(步骤2)。 然后,我们边缘化一个或多个帧以保持关键帧的数量受到限制(步骤3)。

3、窗口的优化

为所有活跃关键帧的所有激活的点做联合优化。光度误差函数的非线性优化使用高斯-牛顿算法。所有的变量,包括相机位姿、活跃点的逆深度、相机内参和仿射亮度参数都联合优化。最小化光度误差之后,如果活跃的关键帧的数量超过阈值,使用舒尔补来边缘化老的关键帧和点。

主要结果

1、用于全向相机的TUM SLAM数据集

1.1 精度比较

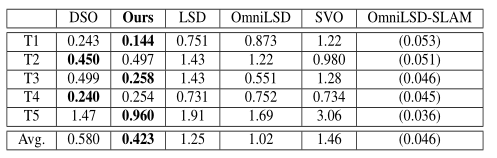

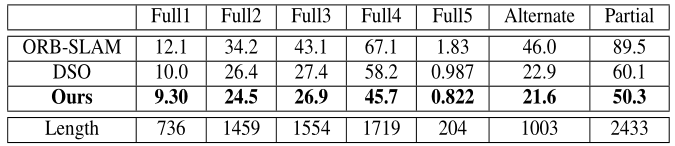

表1 绝对的RMSE误差,以米为单位。

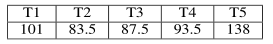

表2:轨迹长度,以米为单位

1.2 使用更大视角的好处:更有可能包含强梯度像素。两帧之间有更大的重叠区域。

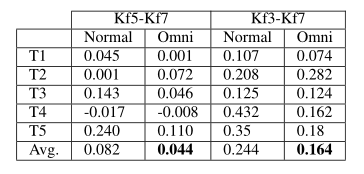

表3:关键帧数量减少时性能下降量

1.3 时间测量

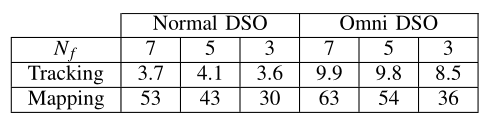

表4:运行平均时间(关键帧数量减小时)

2、Oxford Robotcar数据集

表5: 轨迹的RMSE绝对值,单位为米

Abstract

We propose a novel real-time direct monocular vi- sual odometry for omnidirectional cameras. Our method extends direct sparse odometry (DSO) by using the unified omnidirec- tional model as a projection function, which can be applied to fisheye cameras with a field-of-view (FoV) well above 180 degrees. This formulation allows for using the full area of the input image even with strong distortion, while most existing visual odometry methods can only use a rectified and cropped part of it. Model pa- rameters within an active keyframe window are jointly optimized, including the intrinsic/extrinsic camera parameters, 3D position of points, and affine brightness parameters. Thanks to the wide FoV, image overlap between frames becomes bigger and points are more spatially distributed. Our results demonstrate that our method provides increased accuracy and robustness over state- of-the-art visual odometry algorithms.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

点击阅读原文,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com