NLP小样本研究往往使用人为构造的N分类任务来评价模型性能。然而,一方面,这些人造的简单任务不能反映真实世界NLP问题的复杂性;另一方面,现有NLP小样本研究缺乏一个统一的benchmark,导致实验效率低下。

为此,我们标注了全新的小样本联合学习基准数据集FewJoint,并基于该数据集组织了SMP2020-ECDT小样本对话语言理解评测,同时提供了适配FewJoint的全新小样本工具平台MetaDialog。

2. SMP2020-ECDT小样本对话理解评测介绍

FewJoint基准数据集介绍

小样本学习(Few-shot Learning)旨在像人一样只用几个样本学习新的任务,近年来已经成为受到整个机器学习社区关注的热点问题,并被看作是让机器智能接近人类智能的关键方向。

图1:小样本学习旨在让机器像人一样用几个样本进行学习

Few-shot Learning在计算机视觉领域和理论领域快速发展,但在NLP领域的进展却相对缓慢。造成这种差异性的一个主要原因是缺少公共的评价基准(benchmark)。已有的Few-shot NLP研究多是在自己构造的数据集上进行实验,研究者经常需要复现前人工作而不同论文的结果也往往不是直接可比较的。这种低效的实验方式极大地影响了研究效率,也阻碍了方法的累积进步。

为此,我们推出了一个全新的小样本基准数据集 – FewJoint,基于该数据集,我们还组织了SMP 2020的小样本对话语言理解评测。不同于过往的NLP小样本研究使用人为构造的简单文本分类任务,我们引入了包含59个真实领域的对话语言理解任务(Spoken Language Understanding,SLU)。SLU任务在简单文本分类(Intent Detection)之外,还涵盖了序列标注(Slot Filling)与多任务联合学习(Joint Learning)。这些更高级且真实的任务使得FewJoint能比现有的简单文本分类任务更好地反映真实世界NLP任务的难度和复杂性。

• 包含59个真实domain,目前domain最多的对话数据集之一,可以避免构造模拟domain,非常适合小样本和元学习方法评测。

• 反映真实NLP任务难度,打破目前Few-shot NLP只做文本分类等简单人造任务的局限性。

• 完全公开,提供易用的NLP Few-shot Learning Benchmark。

• 提供配套NLP few-shot learning 工具平台——MetaDialog,方便快速开展实验。

我们选取了讯飞AIUI开放平台上的59个真实对话机器人API作为我们的领域。用户语料的来源主要包括两部分:

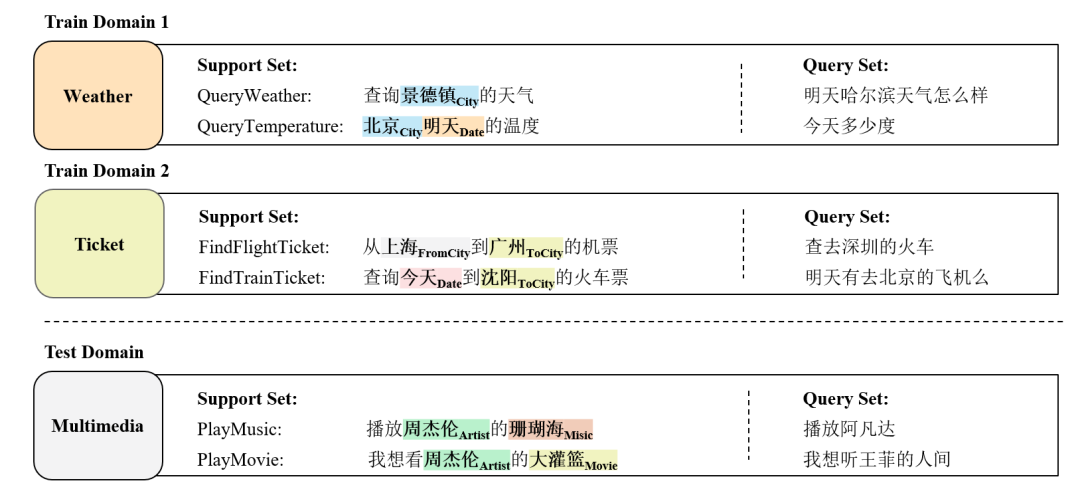

在对每一条数据进行用户意图和语义槽标注后,我们将所有59个domain分成3个部分:45个训练domain,5个开发domain,9个测试domain。我们将测试和开发domain数据重构为小样本学习形式:每个domain 包含一个人工构造的K-shot 支持集(support set),以及一个由剩余其他数据组成的查询集(query set)。

如图2所示,在FewJoint上实验时,模型先在训练domain上学习通用的先验知识。然后在每个测试domain上,模型根据少量support set中的样例,预测查询集中的样本的用户意图(Intent)和语义槽(Slot)。

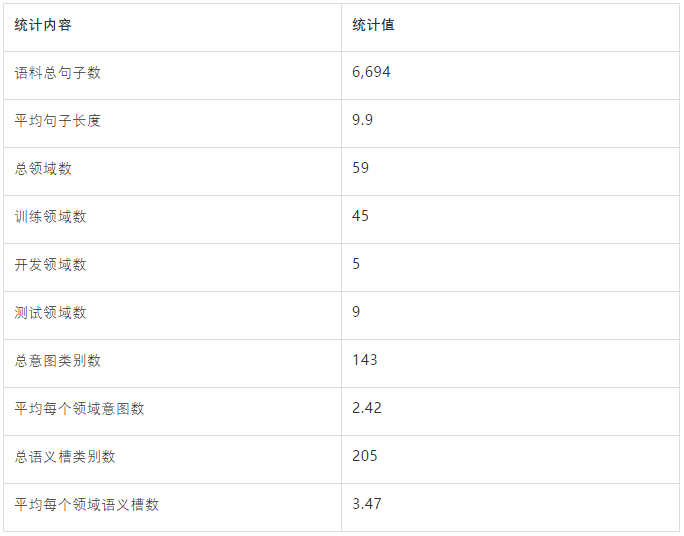

表1是我们收集的原始用户语料信息以及相应的语义框架标注信息。

![]() 表1:FewJoint 原始数据统计

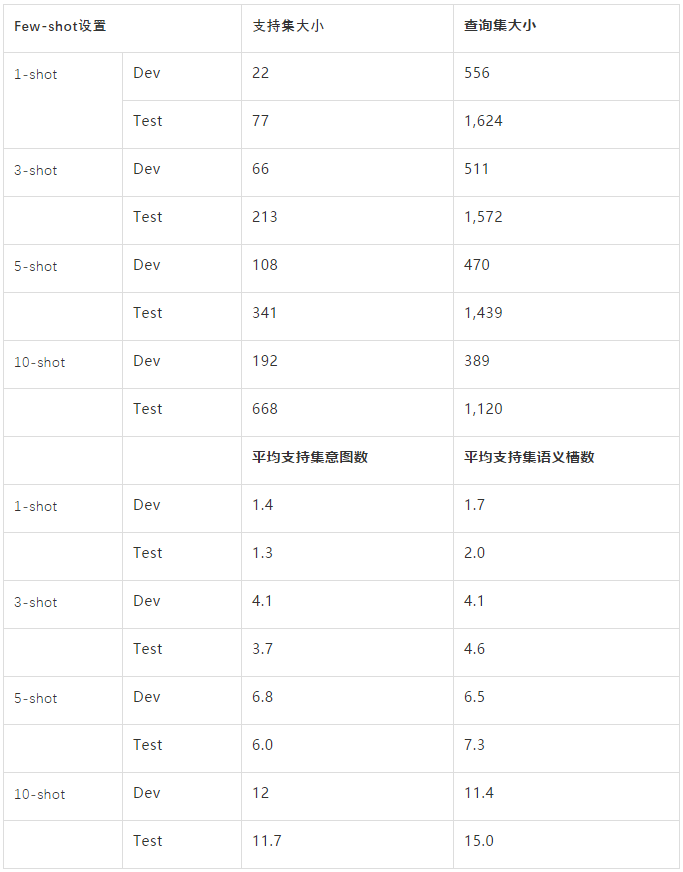

表2是我们重构后的小样本评测集信息,我们提供4种shot 设置:1,3,5,10。其中,3-shot是我们所推荐的主设置。

表1:FewJoint 原始数据统计

表2是我们重构后的小样本评测集信息,我们提供4种shot 设置:1,3,5,10。其中,3-shot是我们所推荐的主设置。

![]() 表2:小样本数据统计信息

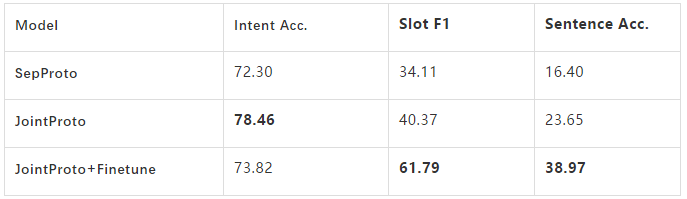

这里我们给出基于该数据集的baseline结果,在Prototypical Network (SepProto)[1] 基础上,我们尝试了两种常用的trick:

(1) Joint:联合学习Intent和Slot。

(2) Finetune: 在目标domain精调Metric函数。

实验结果如表3所示,可以看到JointProto明显地优于SepProto,这体现出了联合学习Intent和slot的必要性。同时Finetune的结果提升也显示出了通过精调来适应目标领域的重要性。

表2:小样本数据统计信息

这里我们给出基于该数据集的baseline结果,在Prototypical Network (SepProto)[1] 基础上,我们尝试了两种常用的trick:

(1) Joint:联合学习Intent和Slot。

(2) Finetune: 在目标domain精调Metric函数。

实验结果如表3所示,可以看到JointProto明显地优于SepProto,这体现出了联合学习Intent和slot的必要性。同时Finetune的结果提升也显示出了通过精调来适应目标领域的重要性。

![]() 表3:主要Baseline实验结果

表3:主要Baseline实验结果

SMP2020-ECDT小样本对话理解评测介绍

ECDT中文人机对话技术评测(The Evaluation of Chinese Human-Computer Dialogue Technology)是SMP全国社会媒体处理大会的评测项目之一,我们在今年的评测中首次引入了小样本对话语言理解技术任务。

经过近4个月的激烈角逐,来自招行AI Lab、上海交通大学、北京大学、香港中文大学等队伍获得了奖项。完整的获奖名单如下:

![]() 表4:评测获奖名单

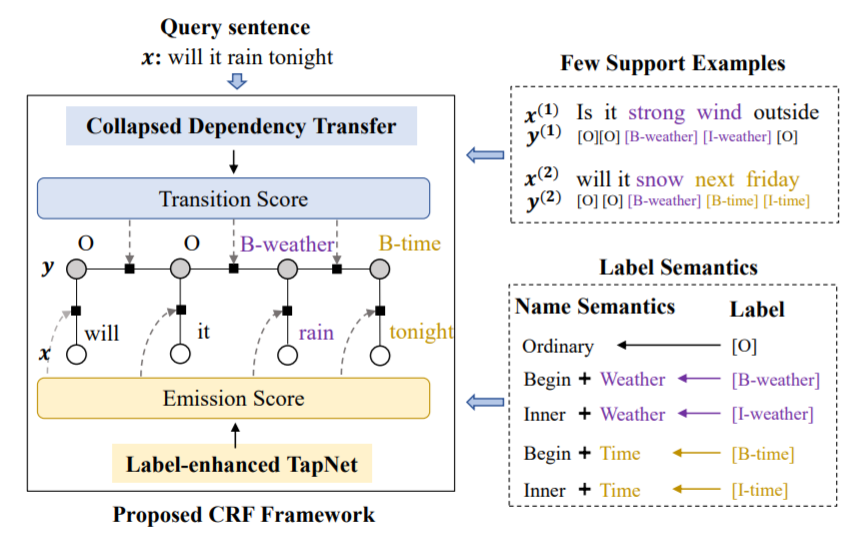

在采用的比赛方法方面,参赛队基本都使用了Finetuning和Joint Learning的技巧,前几名的方法都使用了基于Metric Learning的小样本学习框架,并采用了Collapse Dependency Transfer [2] 策略处理小样本下的序列标注问题。第一名的解决方案的模型主体构建于本基准数据集提供的平台MetaDialog,在语义槽识别中还引入了L-TapNet模型 [2]。在解决意图识别上,参赛队主要Finetune简单的分类器,或者利用原型网络Prototypical Network。其中,前者展示出更好的效果。

Collapsed Dependency Transfer和L-TapNet是ACL 2020 长文Few-shot Slot Tagging [1] 中提出的方法。具体的,为了建模标签之间的依赖关系(Transition Score),该工作提出了一种跨领域建模标签依赖关系的方法——坍缩依赖迁移(Collapsed Dependency Transfer, CDT)。CDT首先从数据充足的源域(Source Domain)学习抽象标签依赖关系,并在小样本的目标域中泛化学到的依赖关系来辅助标签序列的预测。

为了在小样本情形下得到每个词的标签概率(Emission Score),该工作还提出了L-TapNet,来基于每个词和不同标签表示的相似度计算属于不同标签的概率。L-TapNet在计算时利用了label名字中的语义信息,并通过线性偏差消除法(Linear-error Nulling)构造映射空间来将不同标签类别在embedding空间有效分开。

表4:评测获奖名单

在采用的比赛方法方面,参赛队基本都使用了Finetuning和Joint Learning的技巧,前几名的方法都使用了基于Metric Learning的小样本学习框架,并采用了Collapse Dependency Transfer [2] 策略处理小样本下的序列标注问题。第一名的解决方案的模型主体构建于本基准数据集提供的平台MetaDialog,在语义槽识别中还引入了L-TapNet模型 [2]。在解决意图识别上,参赛队主要Finetune简单的分类器,或者利用原型网络Prototypical Network。其中,前者展示出更好的效果。

Collapsed Dependency Transfer和L-TapNet是ACL 2020 长文Few-shot Slot Tagging [1] 中提出的方法。具体的,为了建模标签之间的依赖关系(Transition Score),该工作提出了一种跨领域建模标签依赖关系的方法——坍缩依赖迁移(Collapsed Dependency Transfer, CDT)。CDT首先从数据充足的源域(Source Domain)学习抽象标签依赖关系,并在小样本的目标域中泛化学到的依赖关系来辅助标签序列的预测。

为了在小样本情形下得到每个词的标签概率(Emission Score),该工作还提出了L-TapNet,来基于每个词和不同标签表示的相似度计算属于不同标签的概率。L-TapNet在计算时利用了label名字中的语义信息,并通过线性偏差消除法(Linear-error Nulling)构造映射空间来将不同标签类别在embedding空间有效分开。

小样本平台工具MetaDialog

我们为FewJoint数据集提供了一个完全适配的自然语言小样本工具平台——MetaDialog。它为两种主要的自然语言任务(文本分类和序列标注)提供Few-shot Learning下的解决方案。该平台的主要特点如下:

• 支持CDT[2] 用于序列标记任务的Few-shot Learning。

• 支持与huggingface/transformers兼容的各种深度预训练词表示,例如BERT和Electra。

• 支持成对嵌入表示机制 (Pair-wise Embedding) [2][3]。

• 提供通用的Train & Testing工具。

• 支持具有统一接口的各种小样本模型,例如ProtoNet和TapNet。

• 支持多种可以快速切换的相似性度量方式和logits缩放方法。

相关链接

数据集论文:https://arxiv.org/abs/2009.08138

数据集下载地址:https://atmahou.github.io/attachments/FewJoint.zip

小样本工具平台主页地址:https://github.com/AtmaHou/MetaDialog

[1] Jake Snell, Kevin Swersky, and Richard Zemel. 2017. Prototypical networks for few-shot learning. In NIPS, pages 4077–4087.

[2] Yutai Hou, Wanxiang Che, Yongkui Lai, Zhihan Zhou, Yijia Liu, Han Liu, and Ting Liu. 2020. Few-shot slot tagging with collapsed dependency transfer and label-enhanced task-adaptive projection network. In Proc. of the ACL.

[3] Gao T, Han X, Zhu H, Liu Z, Li P, Sun M, Zhou J. FewRel 2.0: Towards more challenging few-shot relation classification. arXiv preprint arXiv:1910.07124. 2019 Oct 16.

NeurIPS 2020论文接收列表已出,欢迎大家投稿让更多的人了解你们的工作~

![]()

![]()

点击阅读原文,直达NeurIPS小组~

表1:FewJoint 原始数据统计

表1:FewJoint 原始数据统计

表2:小样本数据统计信息

表2:小样本数据统计信息

表3:主要Baseline实验结果

表3:主要Baseline实验结果

表4:评测获奖名单

表4:评测获奖名单