小样本自然语言处理(NLP)是指NLP任务只具有少量标注的样例。这是人工智能系统必须学会处理的现实挑战。通常我们依赖于收集更多的辅助信息或开发一个更有效的学习算法。然而,在高容量模型中,一般基于梯度的优化,如果从头开始训练,需要对大量带标记的样例进行很多参数更新步骤,才能表现良好(Snell et al., 2017)。

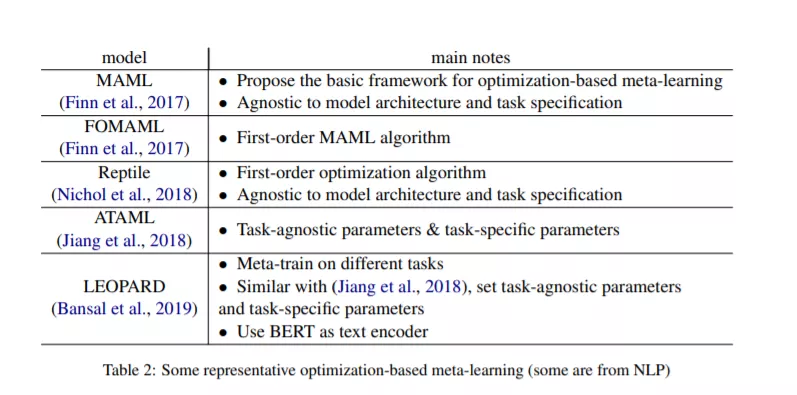

如果目标任务本身不能提供更多的信息,如何收集更多带有丰富标注的任务来帮助模型学习?元学习的目标是训练一个模型在各种任务上使用丰富的标注,这样它就可以用少量标记的样本解决一个新的任务。关键思想是训练模型的初始参数,这样当参数通过零阶或几个梯度步骤更新后,模型在新任务上有最大的性能。

已经有一些关于元学习的综述,例如(Vilalta和Drissi, 2002;Vanschoren, 2018;Hospedales等,2020)。然而,本文的研究主要集中在NLP领域,尤其是小样本的应用。本文试图对元学习应用于较少次数的神经语言处理提供更清晰的定义、进展总结和一些常用的数据集。

成为VIP会员查看完整内容