点击蓝字

关注我们

极市导读

一般来说,损失函数都是需要我们手动设计的,而本文则提出了一种新思路:使用AutoML技术来搜索损失函数,不仅设计了损失函数搜索空间,还提出了一个bilevel的优化框架。>>极市直播预告:CSIG-ECCV2020 论文预交流会,29位ECCV2020一作联合直播

1. 论文贡献

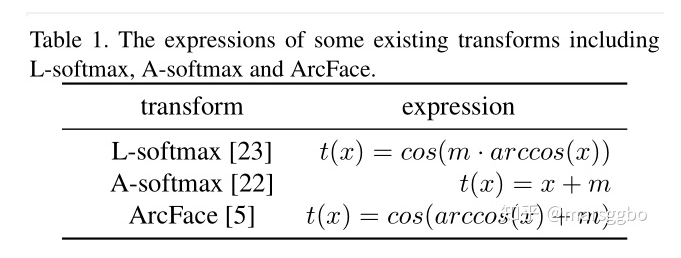

2. 回顾之前的损失函数

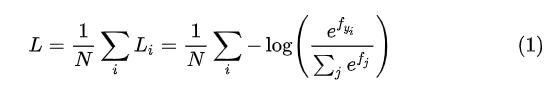

Softmax Loss

N表示数据集大小,

是最后全连接层输出的预测向量(还没有做softmax运算),

表示向量

的第

位置上的值,因为真实值是one-hot的向量(即只有一个1,其余全是0),

中的

表示1的索引值。

3. Loss函数分析

3.1 Focal Loss

4. 搜索空间

-

-

-

-

所以 -

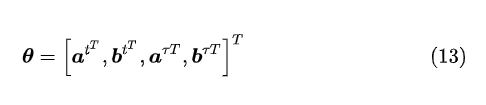

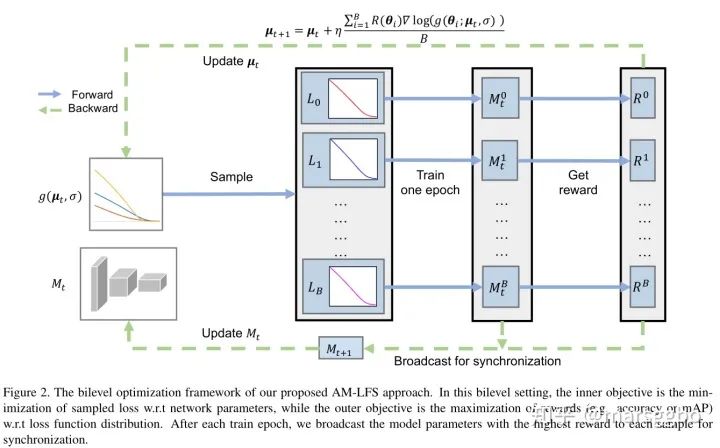

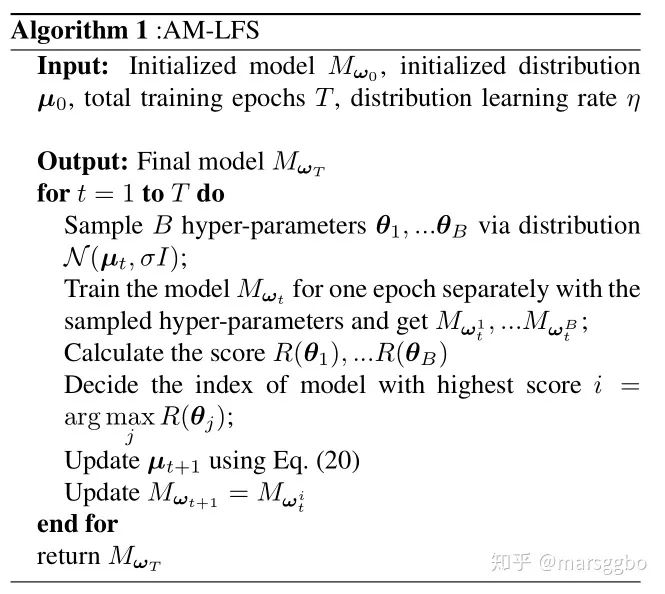

5. 优化

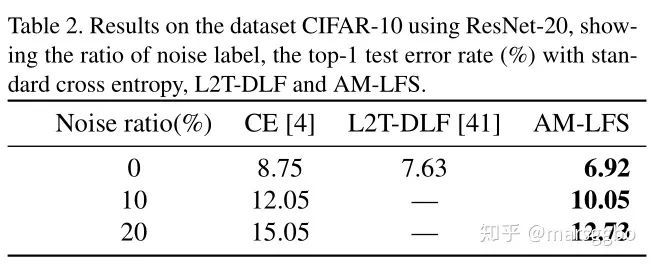

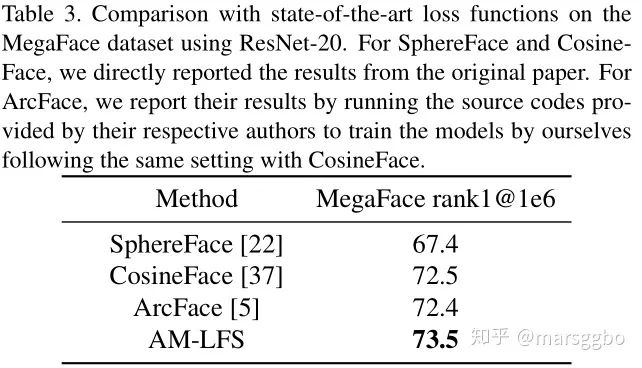

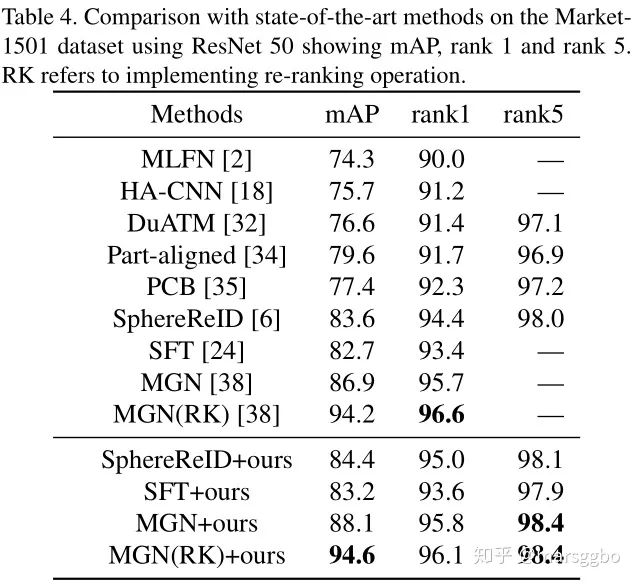

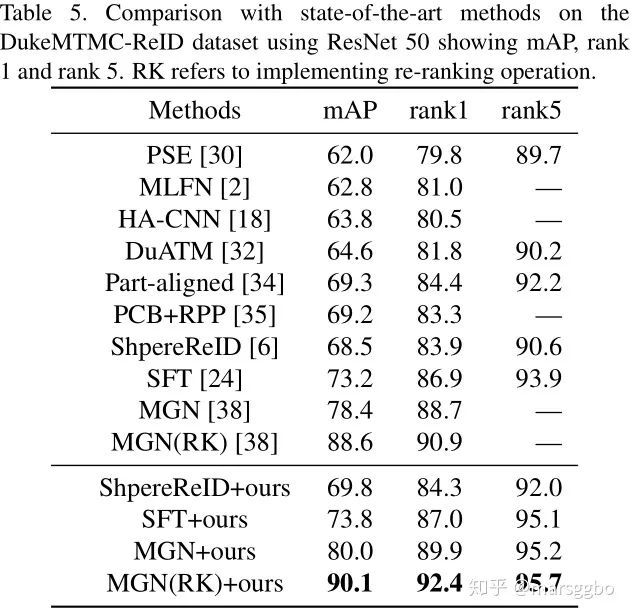

6. 实验结果

7. 讨论

本篇文章是基于自己的理解写的,所以可能会有不正确的地方,欢迎指正!