TP-GAN 让图像生成再获突破,根据单一侧脸生成正面逼真人脸

C新智元报道

作者:闻菲

【新智元导读】中科院自动化所(CASIA),中科院大学和南昌大学的一项合作研究,提出了双路径 GAN(TP-GAN),通过单一侧面照片合成正面人脸图像,取得了当前最好的结果。研究人员提出了一个像人类一样能够考虑整体和局部信息的 GAN 结构,合成的图像非常逼真且很好地保留了身份特征,并且可以处理大量不同姿势的照片。研究人员指出,这些合成的图像有可能用于人脸分析的任务。

首先,让我们来看上面这张图,中间一栏是侧面 90°照片,你能看出计算机根据侧面照合成的正脸是左边一栏,还是右边一栏吗?

答案将在文末揭晓。

作为补充信息,下面这张图全部是计算机合成的,展示了从90°、75°和45°的轮廓的合成正面人脸视图。

根据侧面照片合成正面人脸一直是个难题,现在,由中科院自动化所(CASIA)、中科院大学和南昌大学的 Rui Huang、Shu Zhang、Tianyu Li、Ran He 合作的一项研究,首次解决了这一个问题,他们受人类视觉识别过程启发,结合对抗生成网络(GAN)的强大性能,提出了一个双路径 GAN(TP-GAN),能够在关注整体结构的同时,处理人脸面部细节,在不同的角度、光照条件都取得了很好的结果。不仅如此,这种方法还能够处理大量不同姿势的照片。

作者表示,他们这项工作是使用合成的人脸图像进行图像识别任务的首次有效尝试。

作者在论文中写道,他们的这项工作主要贡献在于三个方面:

1)提出了一个像人类一样能够考虑整体和局部信息的 GAN 结构,能够根据单一的图像合成正面人脸视图,合成的图像非常逼真且很好地保留了身份特征,而且可以应对大量不同的姿势。

2)将从数据分布(对抗训练)得来的先验知识,和人脸领域知识(对称性、身份保留损失)结合起来,将从三维物体投射到二维图像空间时固有的缺失信息精确地恢复了出来。

3)展示了一个“通过生成进行识别”(recognition via generation)的框架的可能性,并且在大量不同姿势下取得了目前最好的识别结果。

虽然计算机识别图像已经在多个基准数据集中超越了人类,但真实应用场景中,对于不同姿势的识别问题仍然没有得到很好地解决。

现有方法可以分为两类,一类是采用手绘的(hand-crafted)特征或学习不同姿态的特征,另一类则是致力于在大量不同姿态的人脸中获取(recover)一个正面人脸视图,然后用这个视图进行人脸识别。

但是,第一类方法由于要在不变和可识别之间做出权衡,往往无法有效处理大量不同的姿势。

第二类方法,早期的尝试是先将二维图像与通用或有确切身份的3D模型对齐,然后利用三维几何变换渲染正面人脸视图。但是,这种方法遇到大量不同姿势的图像时,纹理损失严重,性能也不好。

近来,有研究者提出了由数据驱动的深度学习方法,让系统在学习估计正面视图的同时,分辨身份和姿势表征。虽然结果喜人,但合成的图像在细节方面有所欠缺,再一次地,这种方法也无法很好应对大量不同的姿势,因此合成的图像也无法用于法医取证或属性估计。

更重要的是,从优化的角度看,从观察到的不完全侧面脸部恢复正面视图,本身就是一个不合理而且也没有很好定义的问题。恢复的图像的质量严重依赖于训练过程中的先验或约束条件。

以往的方法通常采用配对监督学习的方式(pairwise supervision),极少在训练过程中引入约束条件(constraints),因此,才导致合成的图像模糊不清。

当人类在进行视觉合成的时候,我们首先是通过观察到的侧脸,在以往的经验/知识基础上,推测出整张脸的结构(或草图)。然后,我们会将注意力转向脸部的细节,比如眼睛、鼻子、嘴唇,将这些细节在刚才那张草图上“填满”。

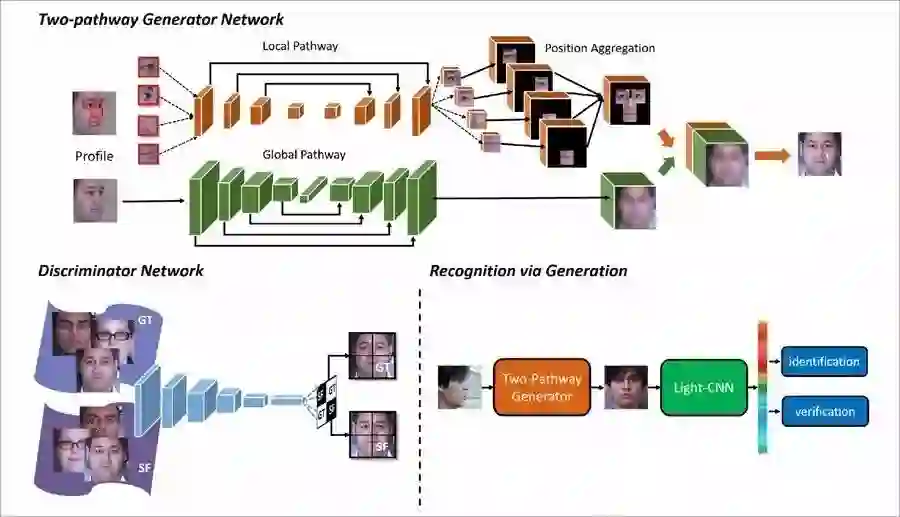

受此启发,作者提出了一个有两条路径的深度架构(TP-GAN),用于正面人脸图像合成。这两条路径,一条专注于推理全局结构,另一条则推理局部的纹理,分别得到两个特征地图。这两个特征图会融合在一起,用于接下来的最终合成。

TP-GAN总结构示意图。生成器包含两个路径,一个处理全局信息,一个处理局部变换。判别器在合成的正面(SF)视图和真实相片(GT)。

不仅如此,作者还将正面人脸分布的信息并入了一个生成对抗网络(GAN),由此对恢复过程进行了很好的约束。

GAN 在二维数据分布建模方面的卓越性能(capacity)极大地改善了很多不合理的低级视觉问题,比如超分辨率和修复(inpainting)。

作者还根据人脸是对称结构这一点,提出了一个对称性损失(symmetry loss),用于补全被遮挡住的部分。

困难场景。面部特征,包括胡须、眼镜,TP-GAN 都保留了下来。最右边一栏,上面那张图将脸颊恢复了出来,下面那张图则是侧面看不见额头,但 TP-GAN 成功地将额头恢复了出来。

为了忠实地保留一个人脸部最突出的特征,作者在压缩特征空间中除了像素级别的 L1 loss,还使用了一个感知损失(perceptual loss)。

最后,关键一环,将身份保留损失(identity preserving loss)整合进来,实现忠实的正面脸部合成,图像质量得到大幅提升。

TP-GAN 根据不同姿势合成的结果。从左到右:90°、75°、45°、60°、30°和 15°。最后一栏是真实相片。

在不同的光线条件下合成的结果。上面一行是合成结果,下面一行是原始照片。

作者指出,这些图像有可能用于人脸分析的任务。

使用单一脸部图像合成逼真的正面脸部视图在人脸识别领域中有着广泛的应用。尽管此前有研究试图从大量面部数据中寻求解决方案,也即数据驱动的深度学习方法,但这个问题仍然具有挑战性,因为它本质上是个不合理的问题(ill-posed)。

本文提出了双通道生成对抗网络(Two-Pathway Generative Adversarial Network,TP-GAN),通过同时感知全局结构和局部细节,合成逼真的正面人脸视图。

除了常用的全局编码器-解码器网络之外,论文还提出了4个定位标记的补丁网络(landmark located patch networks)处理局部纹理。除了全新的架构,我们将这个不合理的问题进行了很好的转化,引入了对抗性损失(adversarial loss)、对称性损失(symmetry loss)和身份保留损失(identity preserving loss)的组合。这一损失的组合能够利用正面脸部的分布和预训练识别深度脸部模型(pre-trained discriminative deep face models),指导身份保留推理从正面脸部视图合成侧面照。不同于以往的深度学习模型主要依靠中间特征用于识别的方法,我们的方法直接利用合成的、保留身份的图像用于下游任务,比如人脸识别和归因估计。实验结果表明,我们的方法不仅在视觉上令人信服,也在多种人脸识别中超越了现有最佳方法。

对了,还有一开始问题的答案:左边一栏是 TP-GAN 合成的结果。你答对了吗?

论文地址:https://arxiv.org/pdf/1704.04086.pdf

3月27日,新智元开源·生态AI技术峰会暨新智元2017创业大赛颁奖盛典隆重召开,包括“BAT”在内的中国主流 AI 公司、600多名行业精英齐聚,共同为2017中国人工智能的发展画上了浓墨重彩的一笔。

点击阅读原文,查阅文字版大会实录

访问以下链接,回顾大会盛况:

阿里云栖社区:http://yq.aliyun.com/webinar/play/199

爱奇艺:http://www.iqiyi.com/l_19rrfgal1z.html

腾讯科技:http://v.qq.com/live/p/topic/26417/preview.html