【KDD2022】GraphMAE:自监督掩码图自编码器

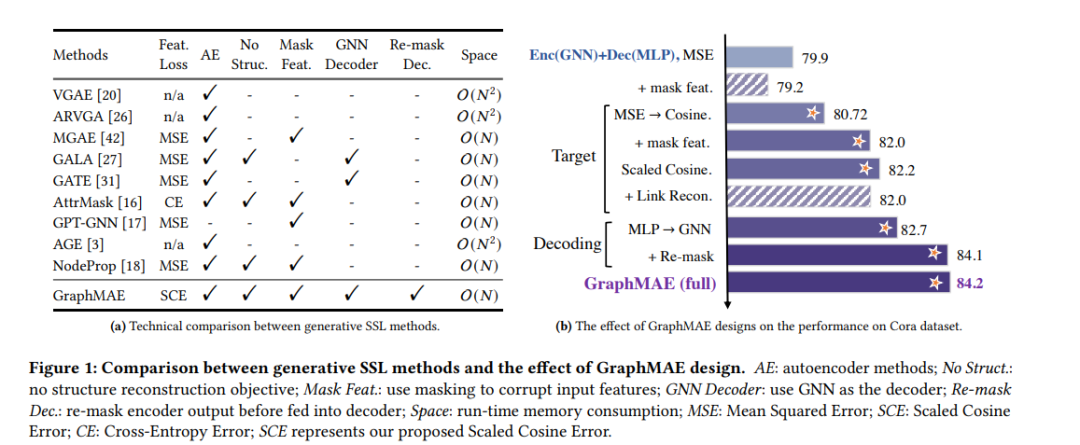

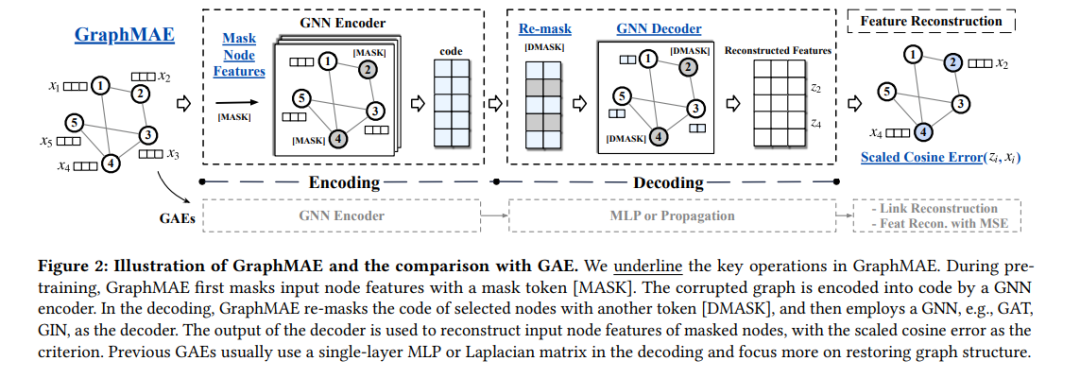

自监督学习(Self-supervised learning, SSL)是近年来的研究热点。特别是,生成式SSL已经在自然语言处理和其他领域取得了成功,例如BERT和GPT的广泛采用。尽管如此,对比学习(严重依赖结构化数据增强和复杂的训练策略)一直是图SSL的主要方法,而在图上生成SSL的进展,特别是图自编码器(GAEs),迄今尚未达到其他领域所承诺的潜力。在本文中,我们识别并研究了对GAEs发展产生负面影响的问题,包括它们的重建目标、训练鲁棒性和误差度量。我们提出了一个掩码图自编码器GraphMAE,它缓解了生成式自监督图学习的这些问题。而不是重建结构,我们建议集中在特征重建与掩蔽策略和缩放余弦误差,有利于GraphMAE的鲁棒训练。我们在21个公共数据集上进行了广泛的实验,用于三种不同的图学习任务。结果表明,GraphMAE—一个经过我们精心设计的简单图自编码器—能够始终如一地生成优于对比基线和生成基线的性能。本研究提供了对图自动编码器的理解,并展示了在图上生成式自监督学习的潜力。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“GMAE” 就可以获取《【KDD2022】GraphMAE:自监督掩码图自编码器》专知下载链接

登录查看更多