【KDD2022】基于对抗性知识蒸馏的深度图神经网络压缩

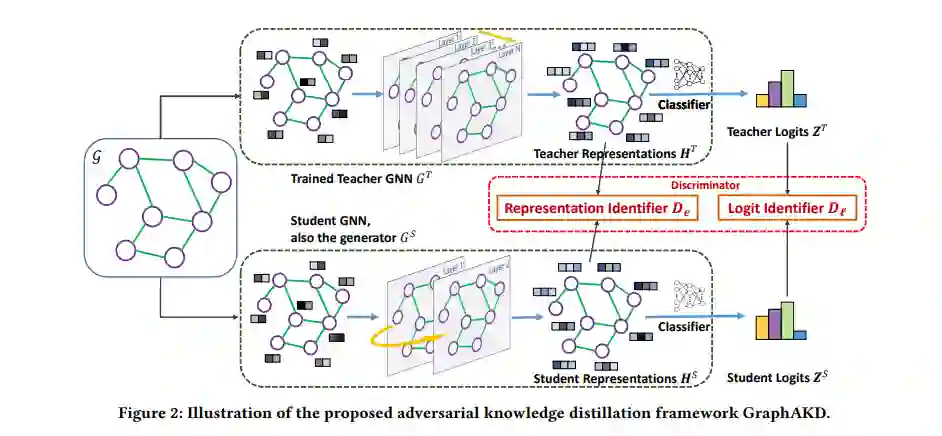

深度图神经网络(Deep graph neural networks, GNNs)能够很好地表达图结构数据的建模。然而,深度图模型的过载架构使得其难以在移动或嵌入式系统上部署和快速测试。为了压缩重叠的GNN,通过师生架构进行知识蒸馏是一种有效的技术,其中的关键步骤是用预定义的距离函数测量教师和学生网络之间的差异。然而,对各种结构的图使用相同的距离可能是不合适的,最优距离公式难以确定。为了解决这些问题,我们提出了一种新的对抗性知识蒸馏框架,命名为GraphAKD,它对抗性训练一个鉴别器和一个生成器,自适应检测和减少差异。特别地,注意到良好捕获的节点间和类间相关性有利于深度GNN的成功,我们提出使用可训练的鉴别器来批判从节点级和类级视图继承的知识。鉴别器区分老师的知识和学生继承的知识,而学生GNN作为生成器,目的是欺骗鉴别器。据我们所知,GraphAKD是第一个将对抗性训练引入到图领域知识蒸馏的系统。在节点级和图级分类基准上的实验表明,GraphAKD在很大程度上提高了学生的表现。结果表明,GraphAKD能够准确地将知识从复杂的教师GNN传递到紧凑的学生GNN。

https://arxiv.org/pdf/2205.11678.pdf

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“GAKD” 就可以获取《【KDD2022】基于对抗性知识蒸馏的深度图神经网络压缩》专知下载链接

登录查看更多

相关内容

Arxiv

20+阅读 · 2021年5月27日