【马毅老师新书课件】低维模型进行高维数据分析:原理、计算和应用,710页pdf

加州大学伯克利分校电气工程与计算机科学系教授马毅(Yi Ma)的新书《High-Dimensional Data Analysis with Low-Dimensional Models: Principles, Computation, and Applications》已经出版,与此配套的是最新相关课件,可以进一步参考学习。

课件

https://book-wright-ma.github.io/Lecture-Slides/

-

Chapter 1 and 2:

Lecture 01: Introduction: Background, History, and Overview.

Lecture 02: Sparse Models and L0 Minimization.

Lecture 03: Relaxing the Sparse Recovery Problem via L1 Minimization.

Chapter 3 and 6:Lecture 04: Convex Methods for Correct Sparse Recovery.

Lecture 05: Convex Sparse Recovery: Towards Stronger Correctness Results.

Lecture 06: Convex Sparse Recovery: Matrices with Restricted Isometry Property.

Lecture 07: Convex Sparse Recovery: Noisy Observations and Approximate Sparsity.

Lecture 08: Convex Sparse Recovery: Phase Transition in Sparse Recovery.

Chapter 4 and 5:Lecture 09: Convex Low-Rank Matrix Recovery: Random Measurements.

Lecture 10: Convex Low-Rank Matrix Recovery: Matrix Completion.

Lecture 11: Convex Low-Rank and Sparse Decomposition: Algorithms.

Lecture 12A: Convex Low-Rank and Sparse Decomposition: Analysis (jamboard notes by Jiantao Jiao).

Lecture 12B: Convex Low-Rank and Sparse Decomposition: Extentions.

Chapter 8:Lecture 13: Convex Optimization for Structured Data: Unconstrained.

Lecture 14: Convex Optimization for Structured Data: Constrained & Scalable.

Chapter 7 and 9:Lecture 15: Nonconvex Formulations: Sparsifying Dictionary Learning.

Lecture 16: Nonconvex Methods: Dictionary Learning via L4 Maximization.

Lecture 17: Nonconvex Optimization: First Order Methods.

Lecture 18: Nonconvex Optimization: Power Iteration and Fixed Point.

Chapter 12 and 15:Lecture 19: Nonlinear Structured Models: Sparsity in Convolution and Deconvolution.

Lecture 20: Nonlinear Structured Models: Transform Invariant Low-Rank Texture.

Chapter 16 and beyond:Lecture 21: Deep Discriminative Models: The Principle of Maximal Coding Rate Reduction.

Lecture 22: Deep Discriminative Models: White-Box Deep Convolution Networks from Rate Reduction.

Lecture 23: Deep Generative Models: Closed-Loop Data Transcription via Minimaxing Rate Reduction.

地址:

https://book-wright-ma.github.io/

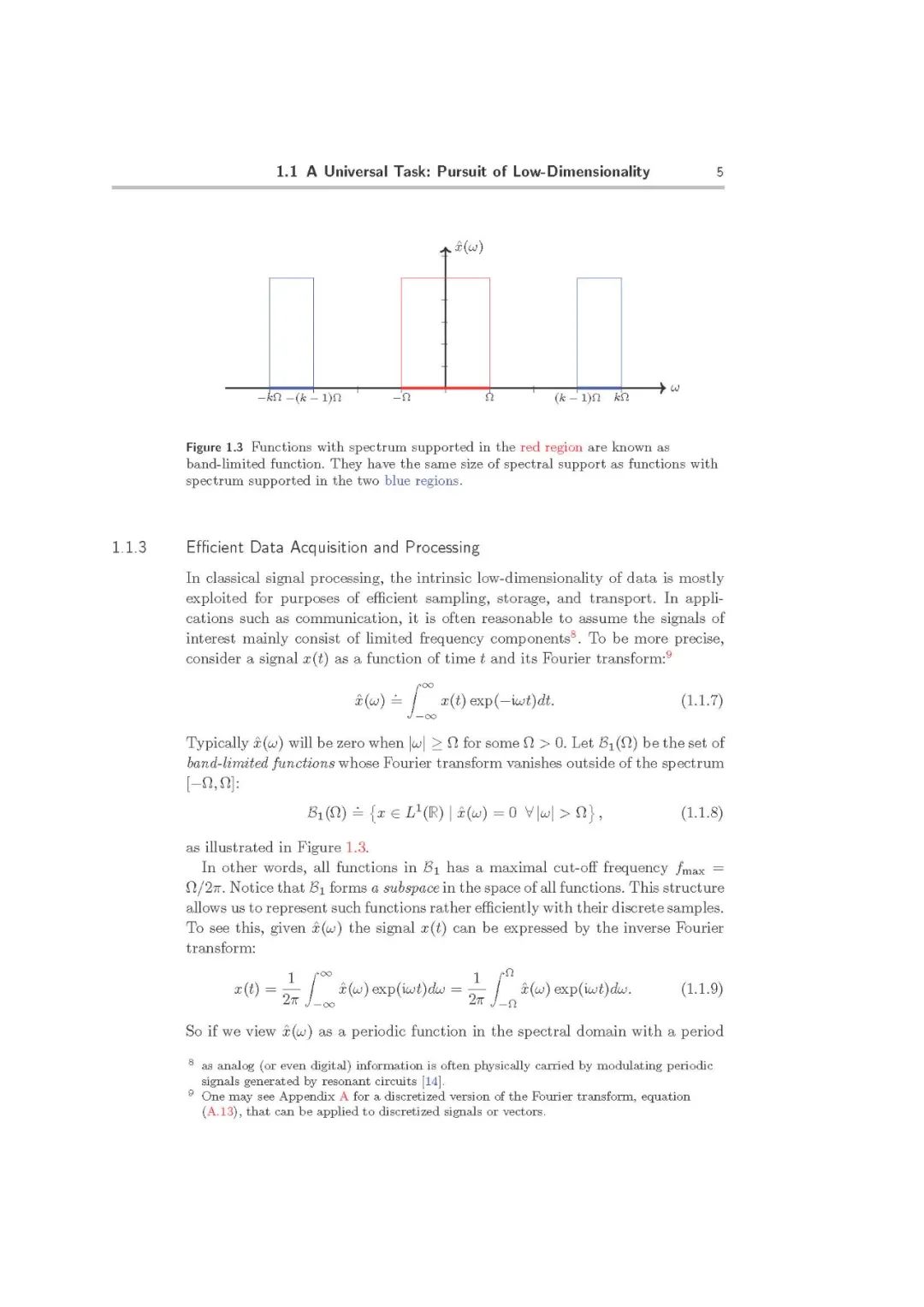

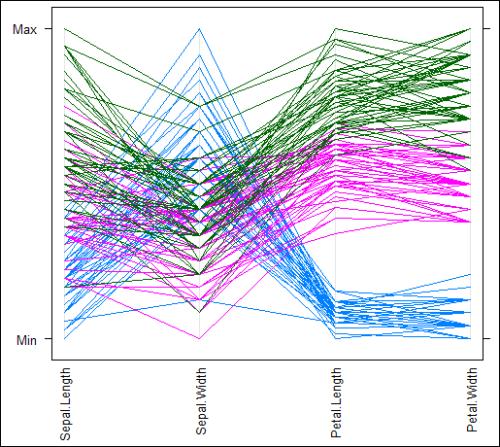

本书涵盖了用于高维数据分析的新的数学原理(统计学和几何学习)、可扩展(凸和非凸)优化方法,以及重要的应用,如科学成像、宽带通信、人脸识别、3D视觉和深度网络。这本书将被用作数据科学、信号处理、优化和机器学习领域的研究生入门教科书。它已被用于课程EECS 290(伯克利)和ELEN 6886(哥伦比亚)。

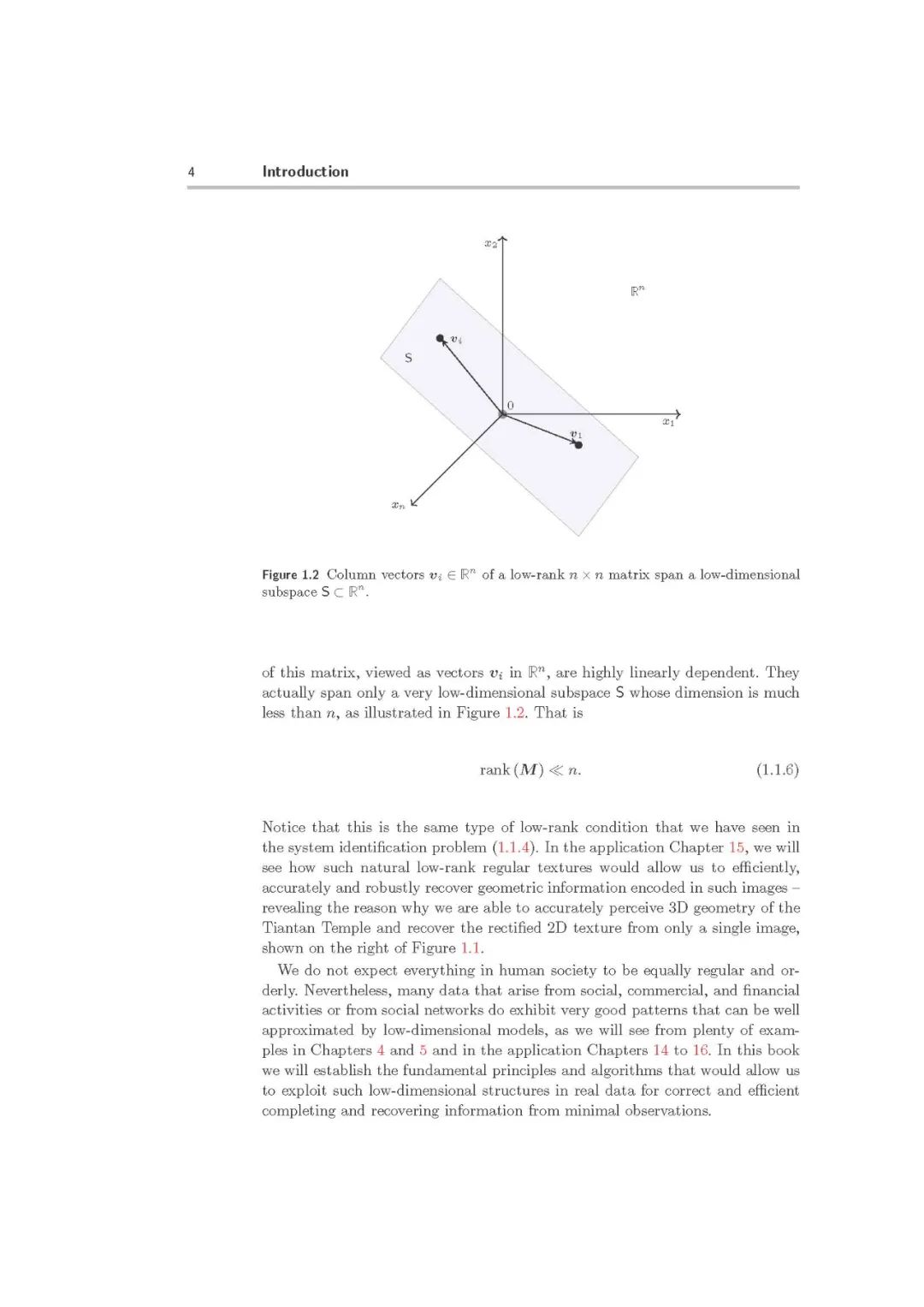

在过去的二十年里,高维空间中低维结构的研究有了巨大的发展。在很大程度上,具有代表性的低维模型(如稀疏和低秩以及它们的变体和扩展)的几何和统计特性现在已经很好地理解了。在何种条件下,这些模型可以有效地和高效地从(最小采样量)数据中恢复,已经清楚地描述了。为了从高维数据中恢复低维模型,已经开发了许多高效和可扩展的算法。对这些算法的工作条件和计算复杂性也进行了详细的描述。这些新理论结果和算法已经彻底改变了科学和信号处理的实践数据, 并对传感、成像和信息处理产生了重要的影响。在科学成像、图像处理、计算机视觉、生物信息学、信息检索和机器学习等领域,我们已取得了显著的技术进步。正如我们将从本书中介绍的应用程序中看到的,其中一些发展似乎违背了传统智慧。

见证了这一历史性的进步,我们认为,现在是全面研究这一新知识体系并在统一的理论和计算框架下组织这些丰富成果的时候了。关于压缩感知和稀疏模型的数学原理,已有许多优秀的书籍。然而,本书的目标是通过真正有效的计算,弥合低维模型在高维数据分析中的原理和应用之间的差距:

本书将为学生提供关于高维几何、统计和优化概念和方法的系统性和严谨的训练。通过多样化丰富的应用设置和编程练习,本书还将教导学生如何在模型真实数据中正确使用这些概念和方法,以及如何解决现实世界的工程与科学问题。

本书结构

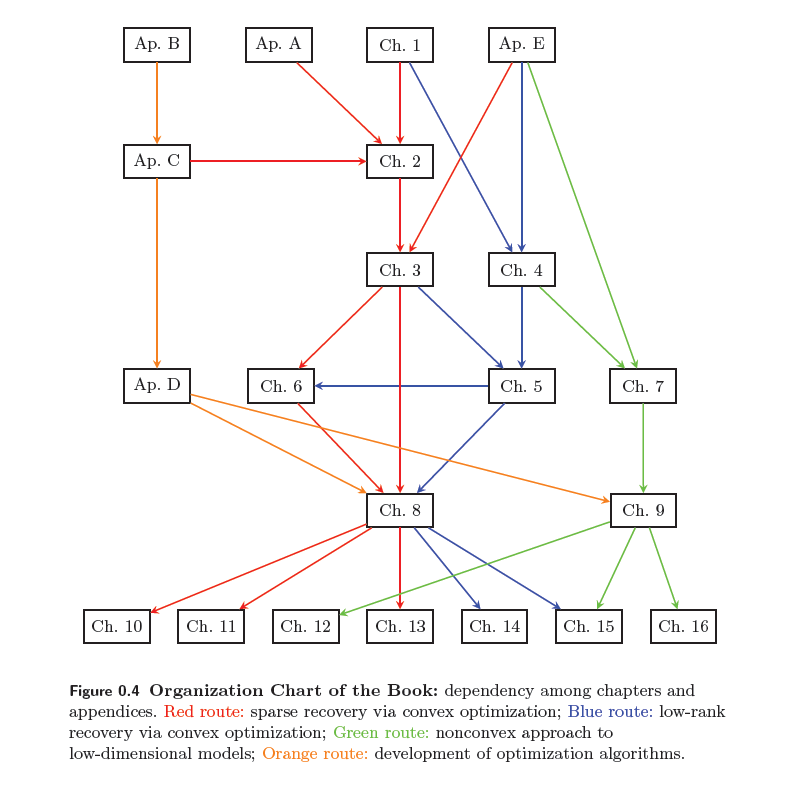

这本书的主体包括三个相互关联的部分: 原理、计算和应用(PCA)。本书还对相关的背景知识做了附录。

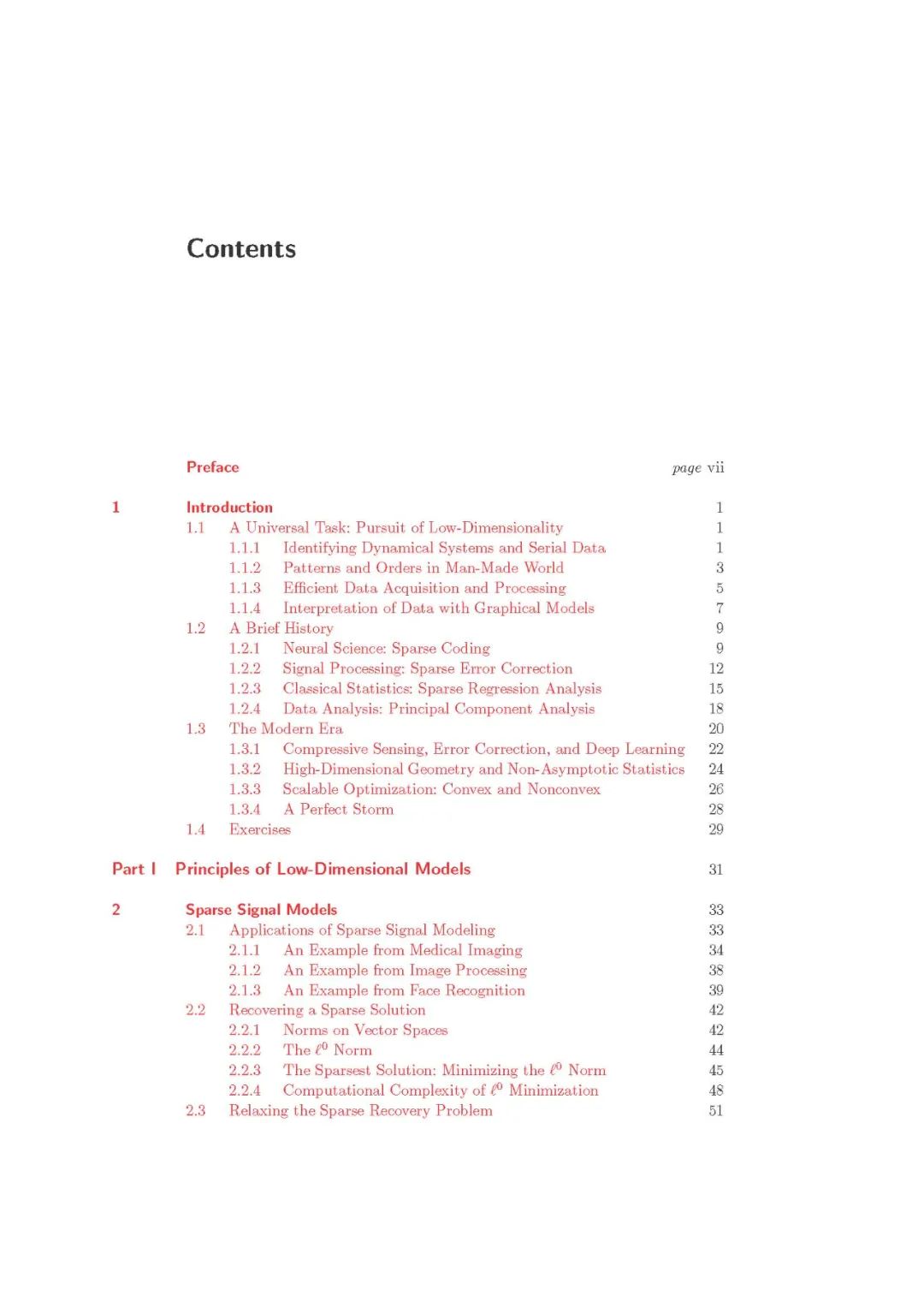

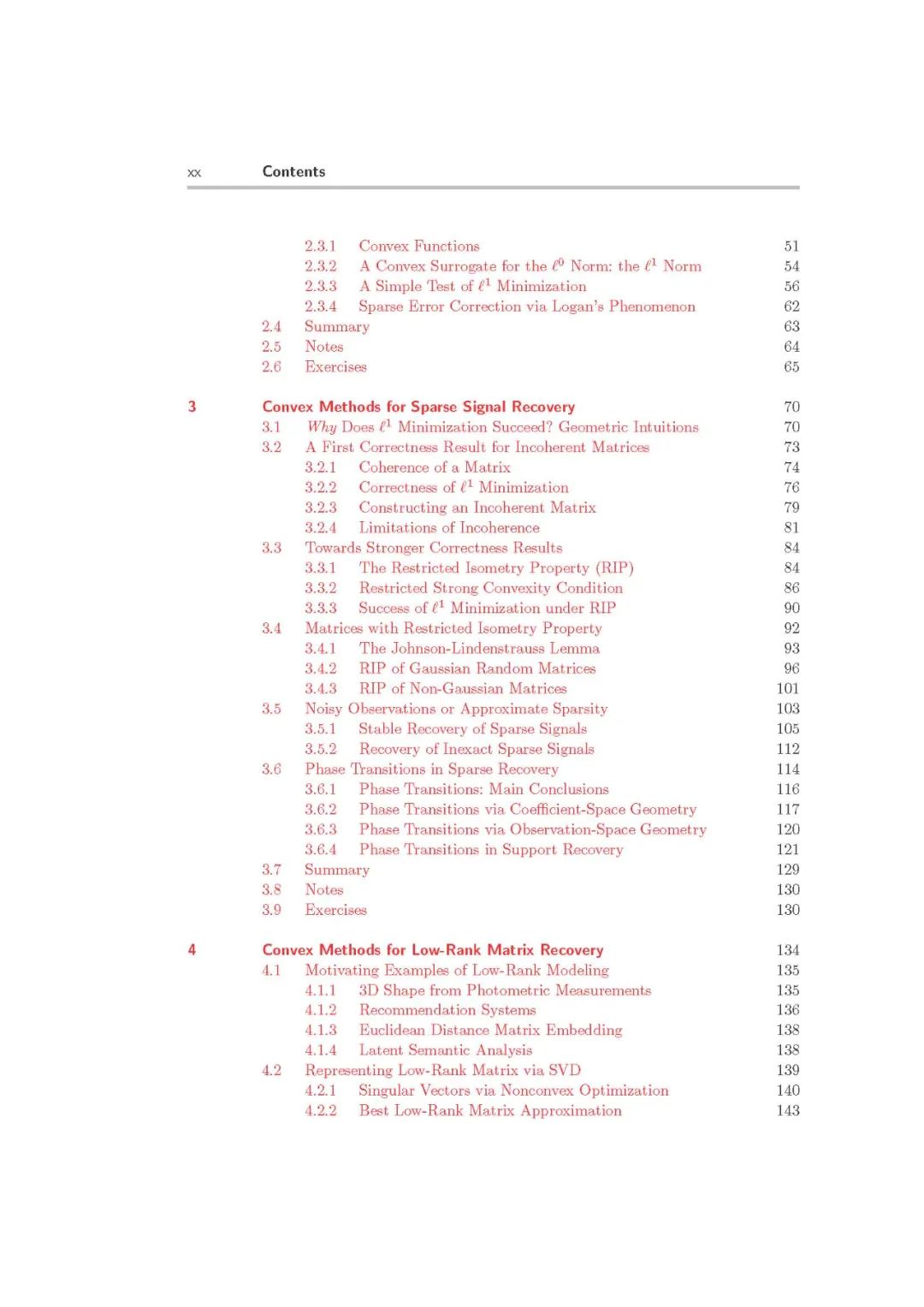

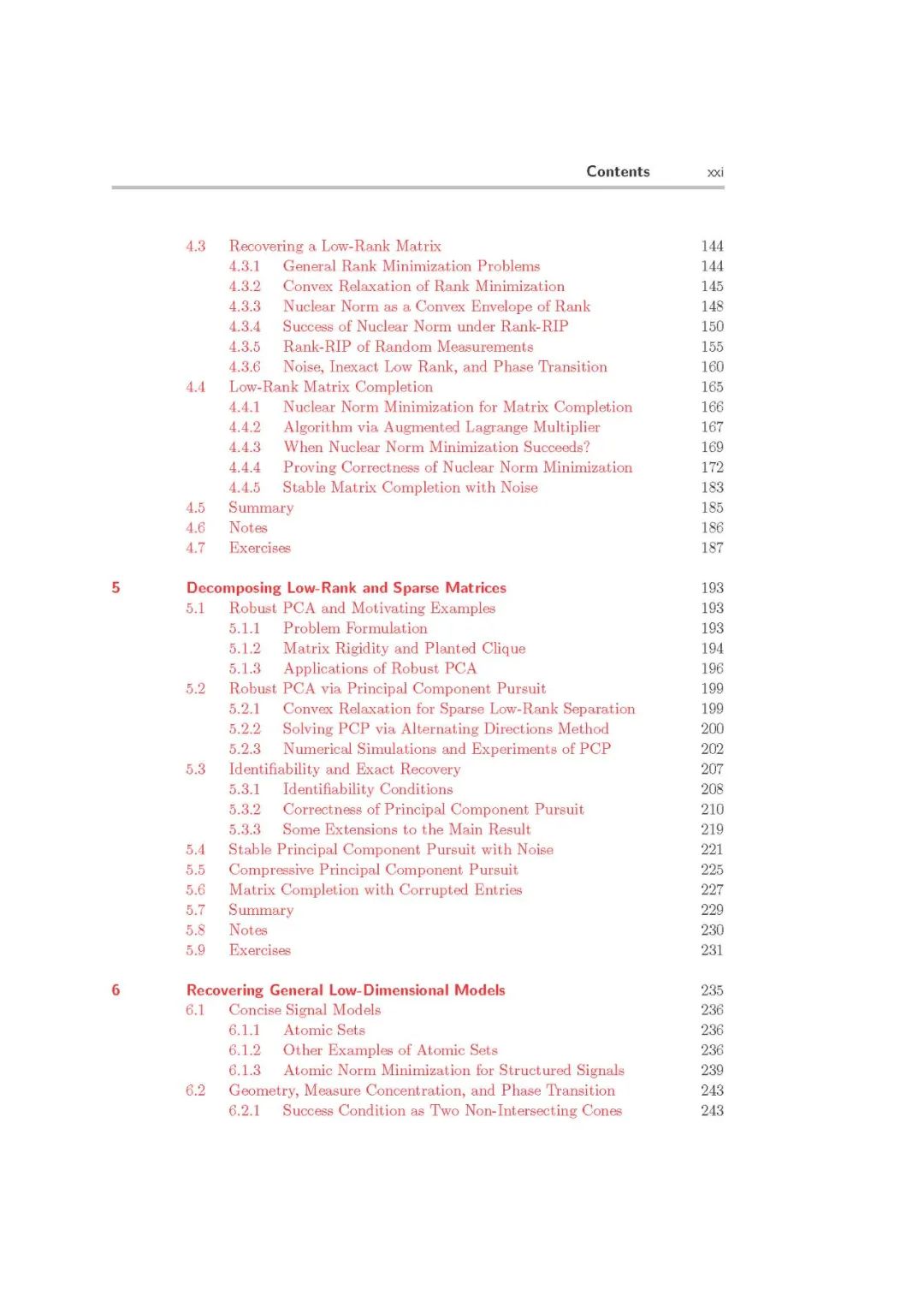

第一部分: 原理(2-7章)提出了稀疏、低秩和一般低维模型的基本性质和理论结果。它描述了在保证正确性或精度的情况下,恢复这种低维结构的逆问题变得易于处理并且能够有效地解决的条件。

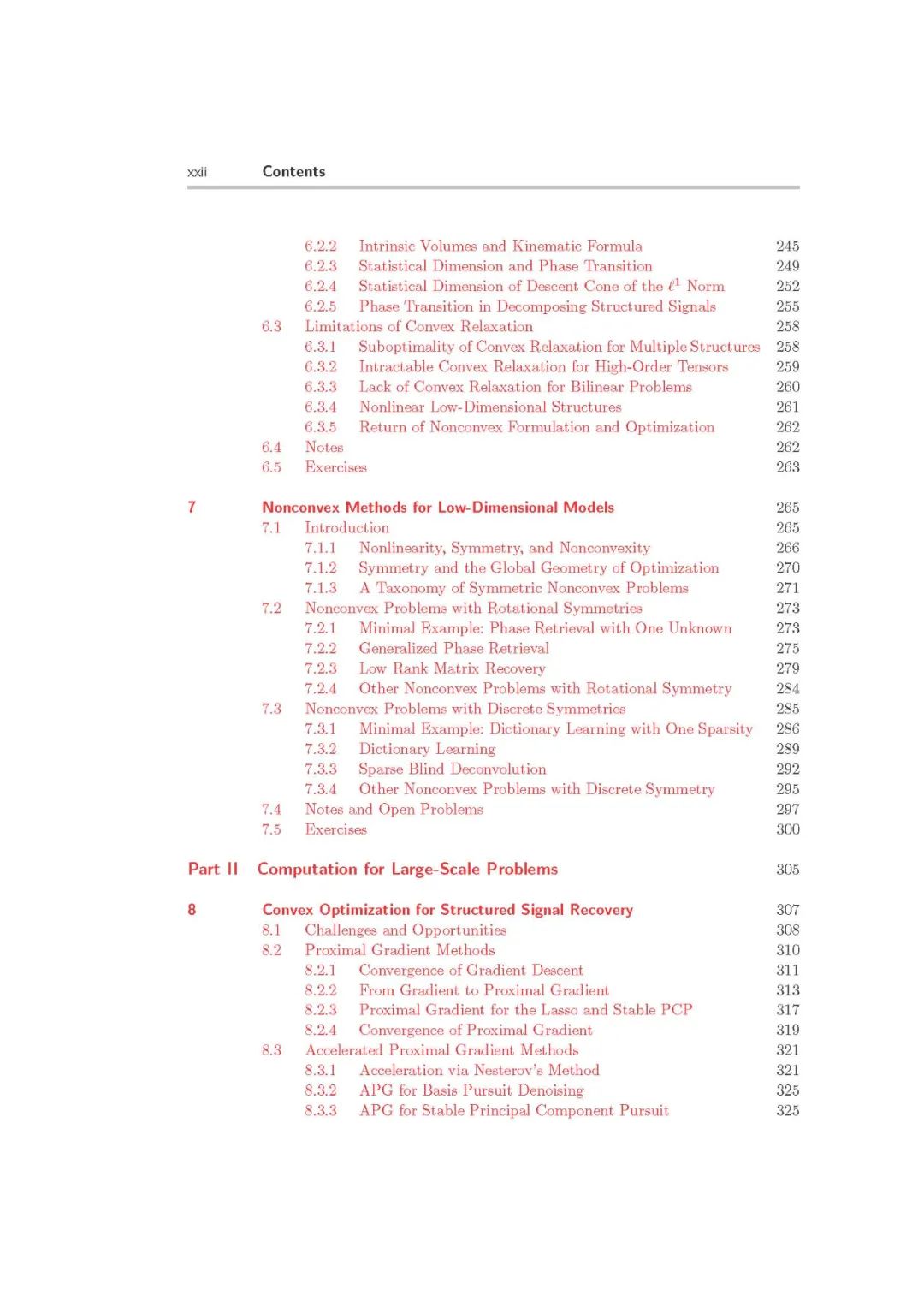

第二部分: 计算(第8章和第9章)介绍了凸和非凸优化的方法,以开发用于恢复低维模型的实用算法。这些方法展示了如何系统地提高算法效率和降低整体计算复杂度,从而使生成的算法快速、可扩展到大尺寸和高维数据的强大思想。

第三部分: 应用(10到16章)演示了如何前面两部分的原理和计算方法可能价格不能提高解决各种现实问题和实践。这些应用还指导如何适当地定制和扩展本书中介绍的理想化的模型和算法,以包含关于应用的其他领域特定知识(先验或约束)。

最后的附录(A-E)在本书的最后是独立使用的。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“低维学习” 就可以获取《【伯克利马毅老师等重磅新书】低维模型进行高维数据分析:原理、计算和应用,710页pdf》专知下载链接