AAAI 2020 | 北大:图卷积中的多阶段自监督学习算法

作者 | 孙科

编辑 | 唐里

本文对北京大学林宙辰团队完成,被AAAI-20录用的论文《Multi-Stage Self-Supervised Learning for Graph Convolutional Networks on Graphs with Few Labeled Nodes》进行解读。

图卷积网络GCN[1,2,3,4]在图学习任务中扮演着关键的角色,然而在一张只有弱监督[5]信号的图上如何高效地完成学习任务仍是一个困难的问题。

具体来说,由于过度平滑问题[6]的存在,已有的图卷积网络很难做深,这使得高阶邻居的信息无法利用,而很多现实中的graph通常只有少量监督信号,这一缺陷使得仅有的少量的监督信息无法在graph上得到有效传播,制约了图卷积的效率。

另一方面,自监督学习[7]被大量应用在各种学习任务中,如何在图卷积网络中引入自监督学习,来解决图卷积模型自身的问题,比如层数不能做深影响弱监督信号的传播,仍然值得探索。

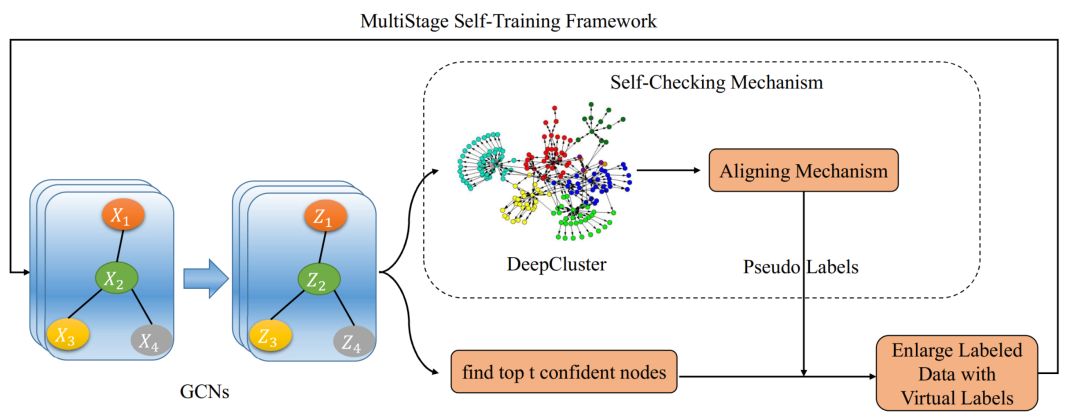

本文首先针对少量监督信息无法在graph上传播这一问题提出了不断加标签的多阶段学习框架,然后将这一框架整合到图卷积神经网络中。同时为了提高添加标签的正确率,本文通过在embedding空间实施DeepCluster自监督聚类构造了一种自我检查机制,从而在算法中额外利用了embedding空间的信息,最后建立了本文中的Multi-Stage Self-Supervised Learning (M3S)训练算法,并在解决graph上只有弱监督信号的任务设置下取得了一致最优的结果。

图卷积中的多阶段自监督学习算法

1、图卷积神经网络

两层GCN[2]的公式如下:

Li, Han, and Wu 2018[6]分析了图卷积本质的作用机制是一种对称的拉普拉斯平滑,但是堆叠多层反复施加这一平滑会使得信号过度平滑而丢失信息。没有办法做深这一图卷积神经网络的缺陷限制了有限监督节点的弱监督信号在graph上的传播。

2、多阶段训练算法框架

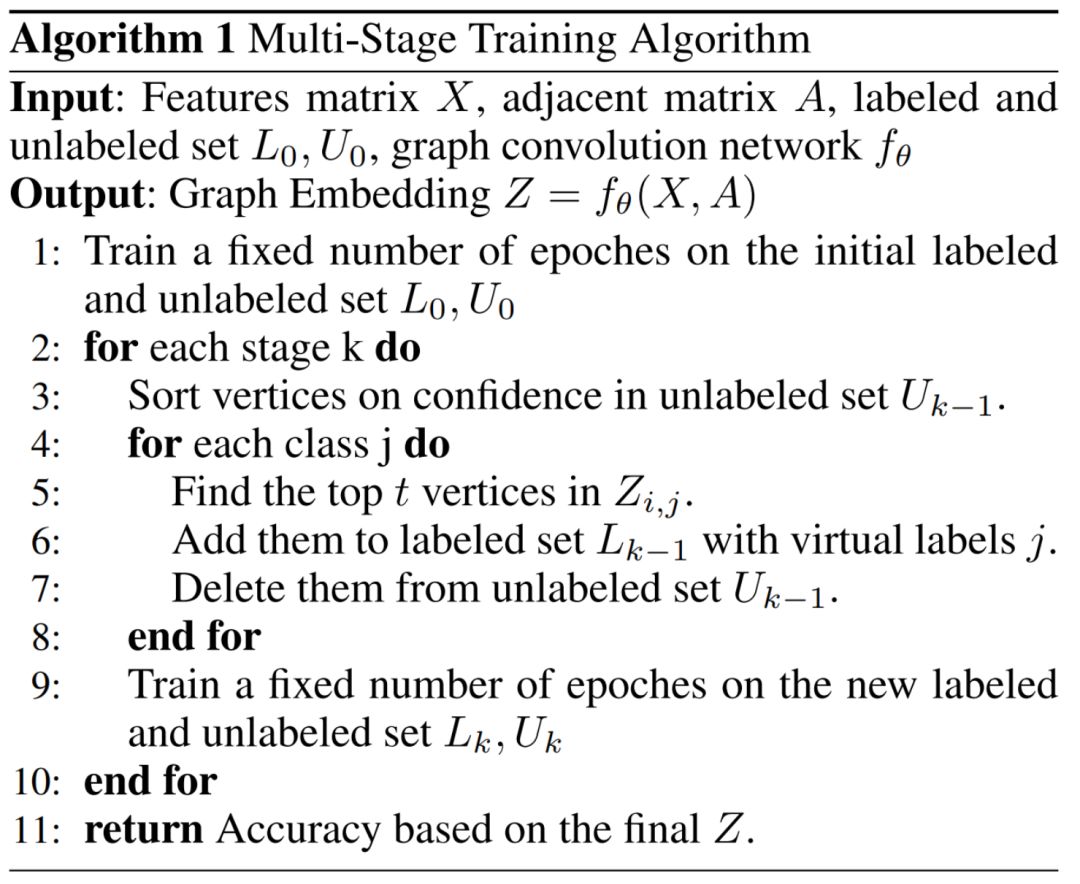

受到self-training[6]的启发,我们进一步拓展这种自训练的方式到多阶段。通过每一阶段将图卷积模型预测节点中confidence高的节点加入到有标签的训练集中,不断在整个图中扩大监督信息的利用。多阶段训练算法流程如下:

3、深度聚类

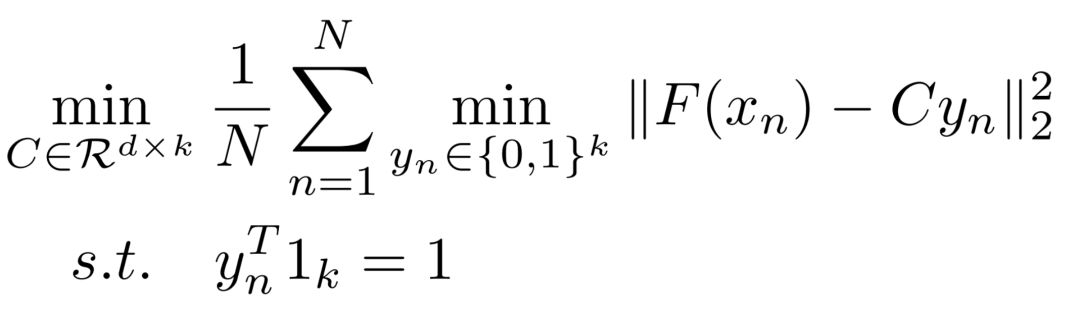

作为一种典型的自监督学习方法,DeepCluster[7]通过求解下面的优化问题来构造每个样本的虚拟标签,从而进一步提供网络训练的监督信息。

我们借助了DeepCluster[7]的思想,在graph embedding空间中实施DeepCluster[7]来构造每个节点的虚拟标签。

进一步,我们在embedding空间中设计了对齐机制,将没有标签的节点根据空间中的距离远近自动对齐到最近的类别中,从而完成监督标签的构建。对齐机制等价于求解如下优化问题:

算法流程

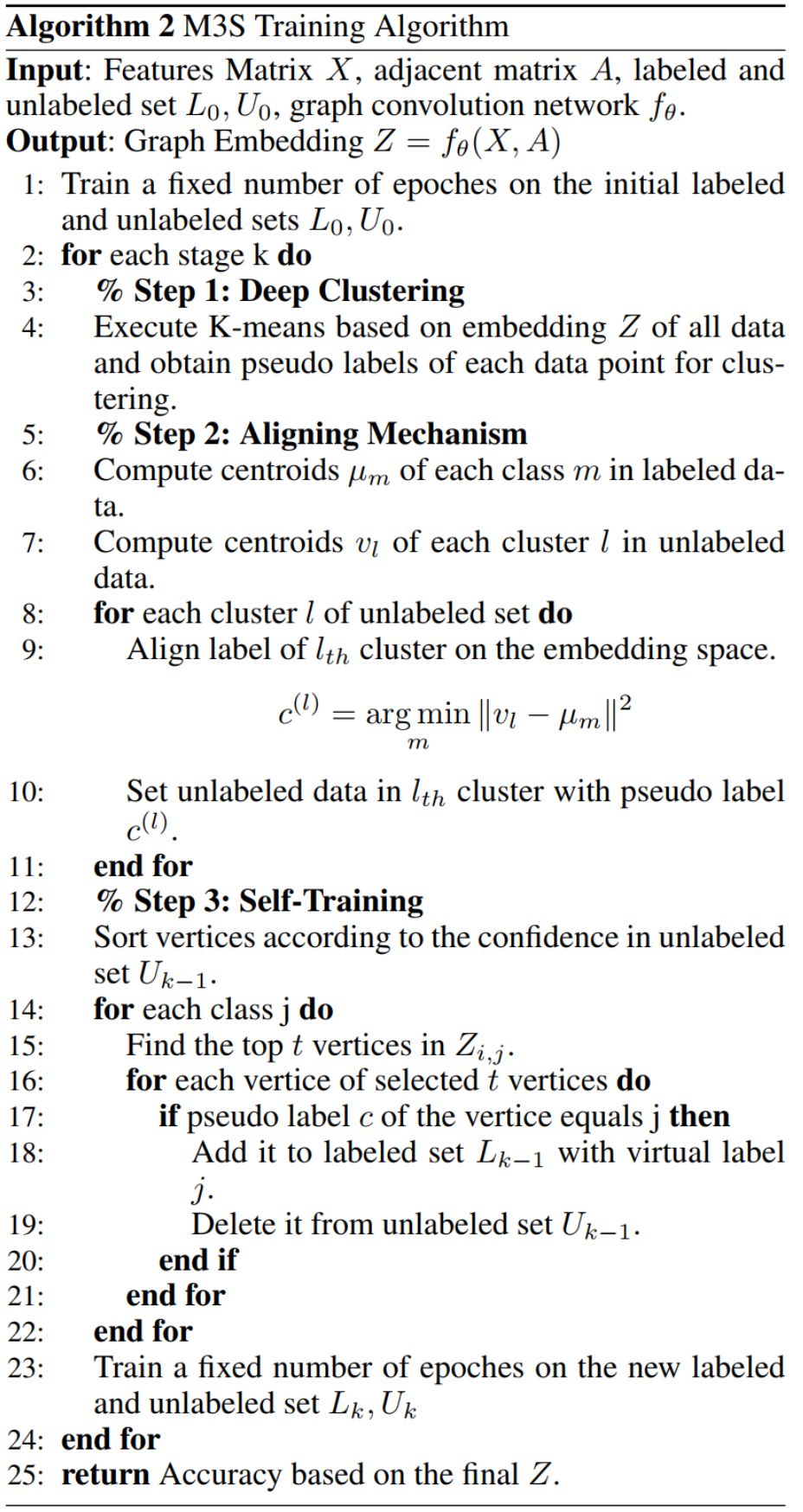

图1显示了我们M3S的训练算法流程:首先在整个算法是嵌入在多阶段训练算法框架中的,在每一阶段通过找到top t confident节点加入到有标签的节点集合中来不断扩大监督信号;另一方面,在graph embedding空间中实施DeepCluster,并通过对齐机制建立和监督标签一样的虚拟标签,构造的虚拟标签作为一种自我检查机制Self-Checking,只有当多监督训练框架中探索的top-t confident的标签和DeepCluster的虚拟标签一致的情况下,才将该节点极其更加确信的标签加入到有标签的节点集合中,进而进入下一阶段的训练。具体算法流程如下:

实验

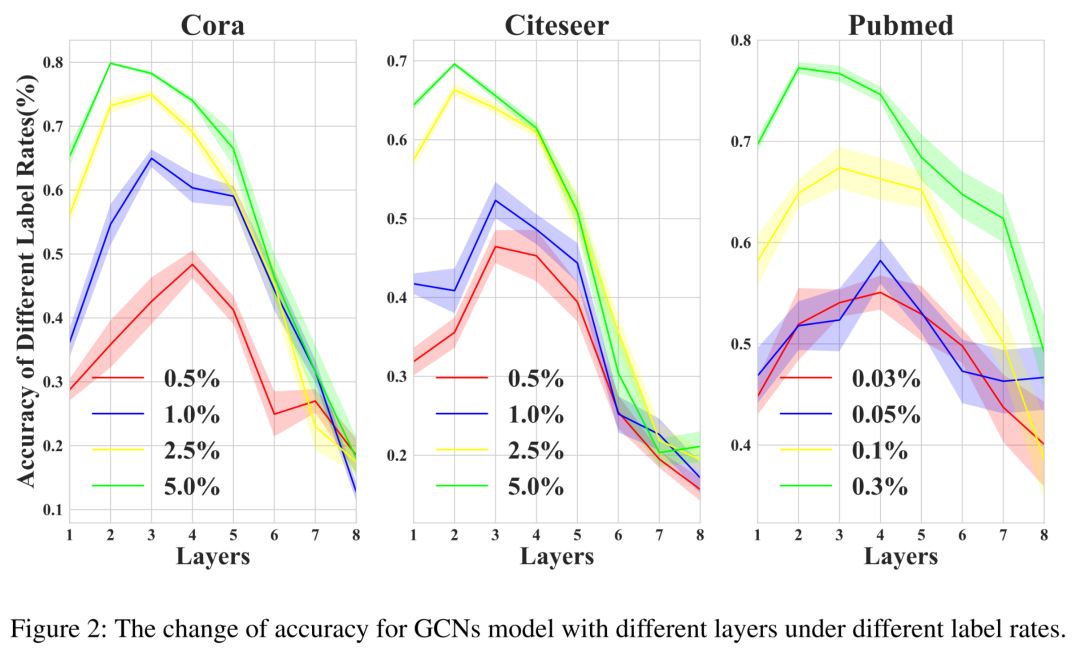

1、层数效应

在本文的实验部分我们先探究了图卷积神经网络的层数效应,即当标签比率越低时最优的层数呈现增长的趋势。这一层数效应证明了弱监督信号需要更多层数来传播的必要性。

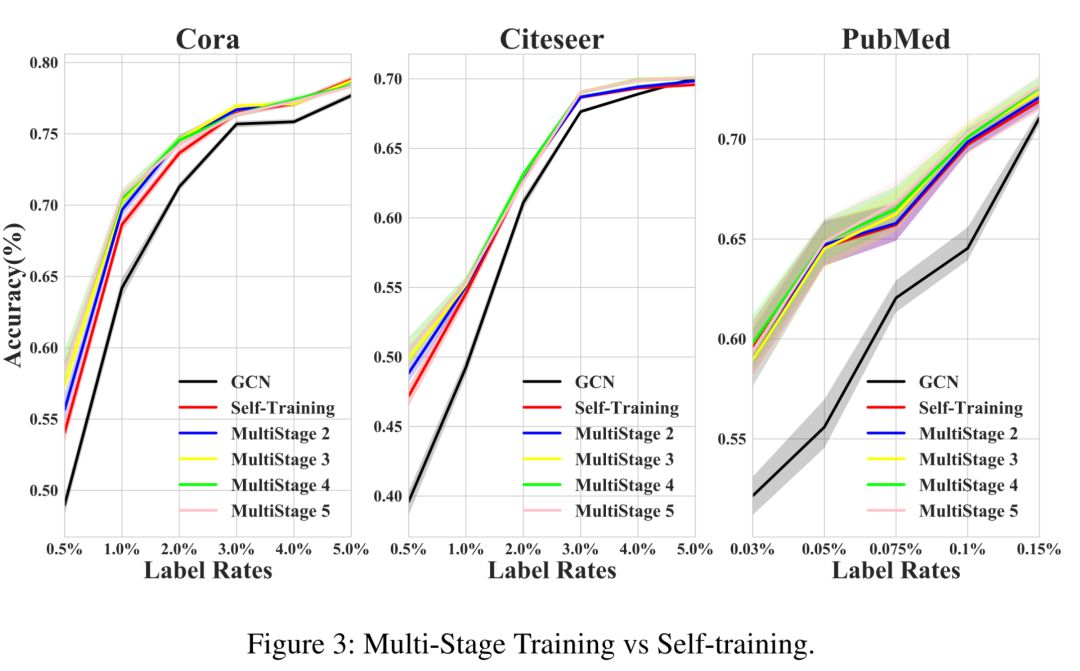

2、多阶段训练算法框架的优势

进一步地,我们通过探讨不同K阶段的训练算法相比于只有一个阶段训练算法的优势,可以看出,当label rate越低的时候多阶段训练框架效果提升地越明显。

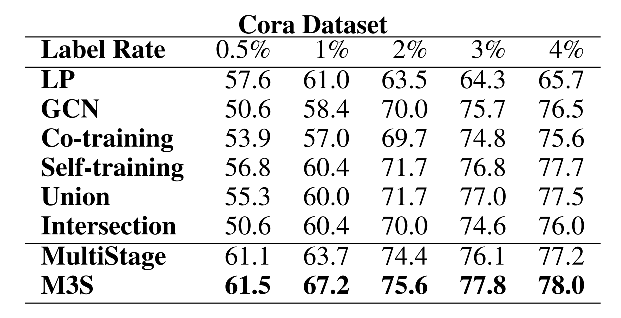

3、M3S的进一步提升

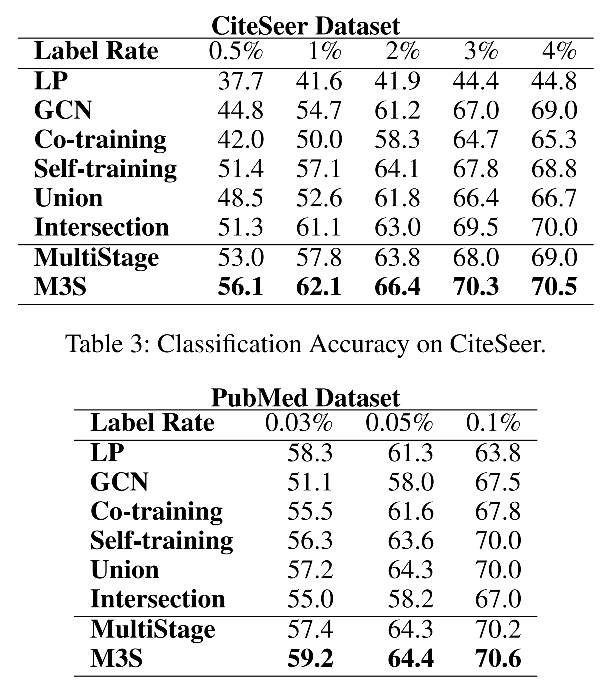

最后,我们将DeepCluster的自监督机制引入多阶段训练框架。从表格中的结果来看,我们容易发现最后得到M3S算法不仅对多阶段训练算法框架效果进一步提升,而且在三个数据集不同的标签比率下取得了一致最好的结果,这充分证明了我们算法的有效性。

同时本文也提供了参数的灵敏度分析,为我们的M3S在实际中的部署提供了具体的指导。

相关论文

[1] Will Hamilton, Zhitao Ying and Jure Leskovec. Inductive representation learning on large graphs. NIPS 2017.

[2] Thomas N Kipf, and Max Welling . Semi-supervised classification with graph convolutional networks. ICLR 2017.

[3] Petar Velickovic, Guillem Cucurull, Arantxa Casanova, Adriana Romero, Pietro Lio and Yoshua Bengio. Graph attention networks. ICLR 2018.

[4] Jie Zhou, Ganqu Cui, Zhengyan Zhang, Cheng Yang, Zhiyuan Liu and Maosong Sun. Graph neural networks: A review of methods and applications. arXiv 2018.

[5] Zhihua Zhou. A brief introduction to weakly supervised learning. National Science Review 2017.

[6] Qimai Li, Zhichao Han and Xiaoming Wu. Deeper insights into graph convolutional networks for semi-supervised learning. AAAI 2018.

[7] Mathilde Caron, Piotr Bojanowski, Armand Joulin and Matthijs Douze. Deep clustering for unsupervised learning of visual features. ECCV 2018.

更多AAAI 2020信息,将在「AAAI 2020 交流群」中进行,加群方式:添加AI研习社顶会小助手(AIyanxishe2),备注「AAAI」,邀请入群。

AAAI 2020 论文解读系列:

13. [中科院自动化所] 通过解纠缠模型探测语义和语法的大脑表征机制

14. [中科院自动化所] 多模态基准指导的生成式多模态自动文摘

16. [UCSB 王威廉组] 零样本学习,来扩充知识图谱(视频解读)

18. [奥卢大学] 基于 NAS 的 GCN 网络设计(视频解读)

19. [中科大] 智能教育系统中的神经认知诊断,从数据中学习交互函数