大合集 | GNN相关视频/博客/代码等

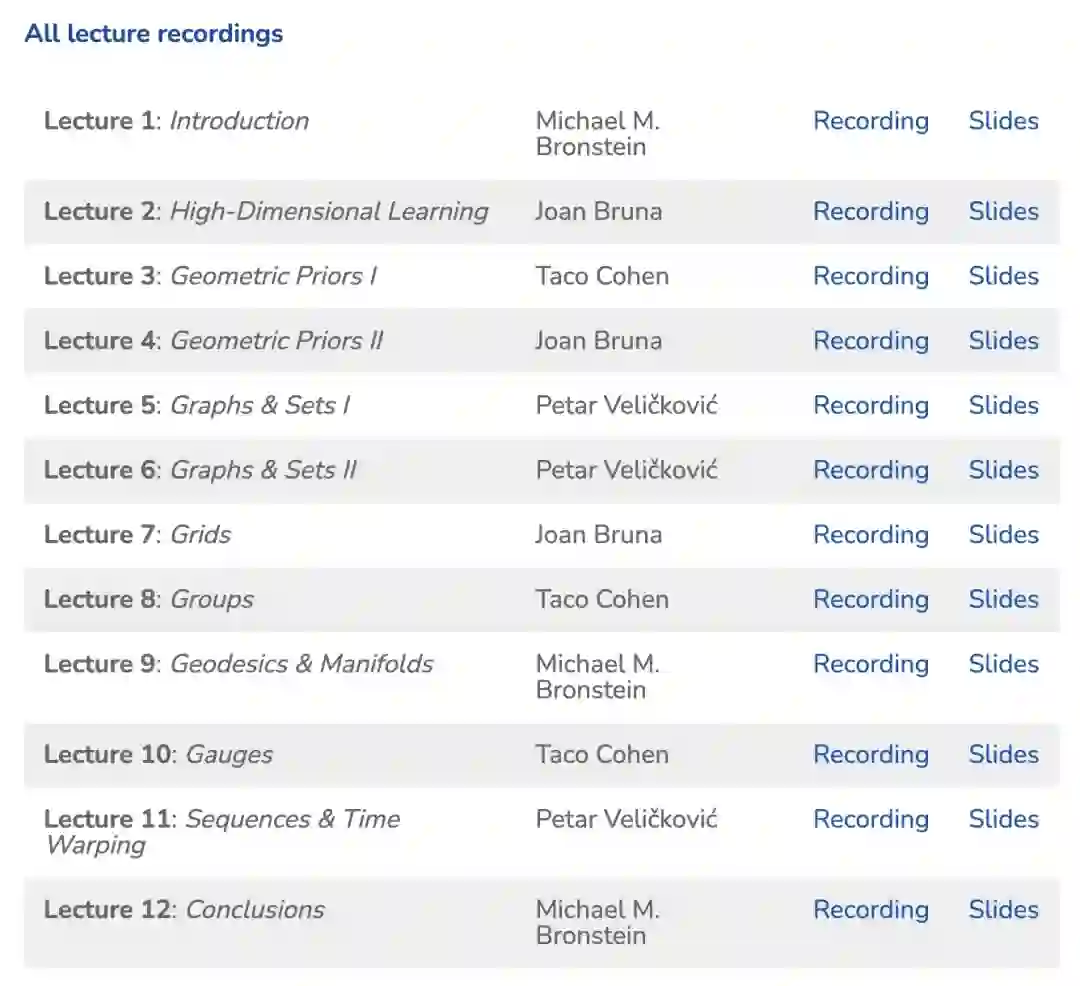

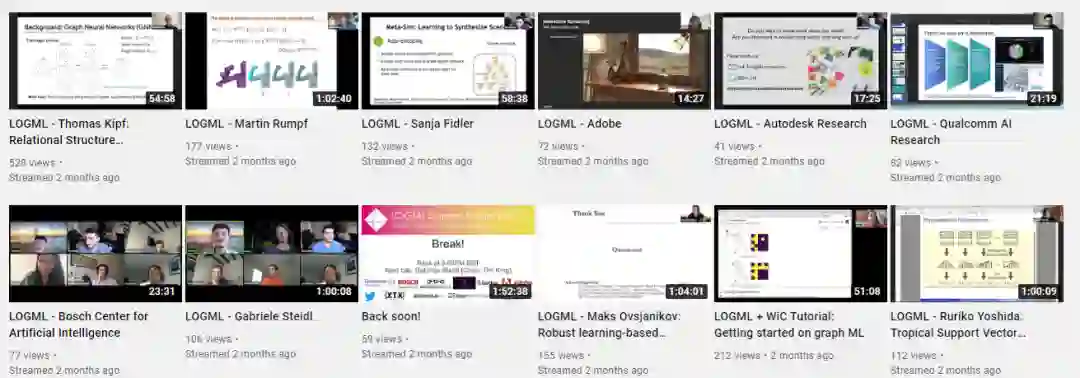

1. 视频Videos

ICML 2021 Videos

2 代码/软件等

3. 博客

登录查看更多

1. 视频Videos

ICML 2021 Videos

2 代码/软件等

3. 博客