【EMNLP2020】自然语言生成,Neural Language Generation

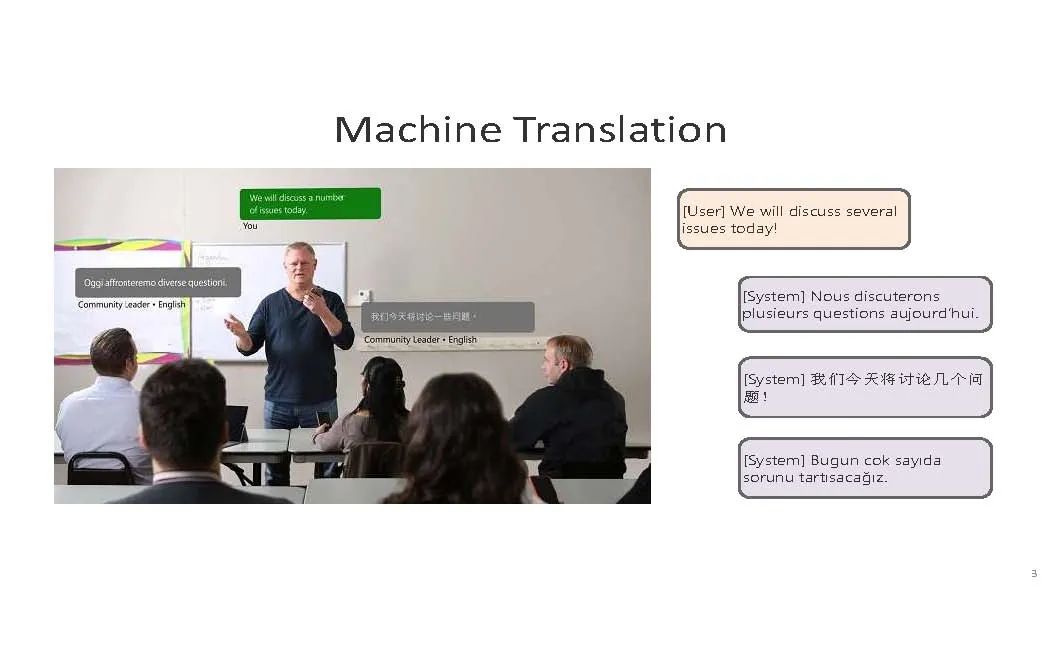

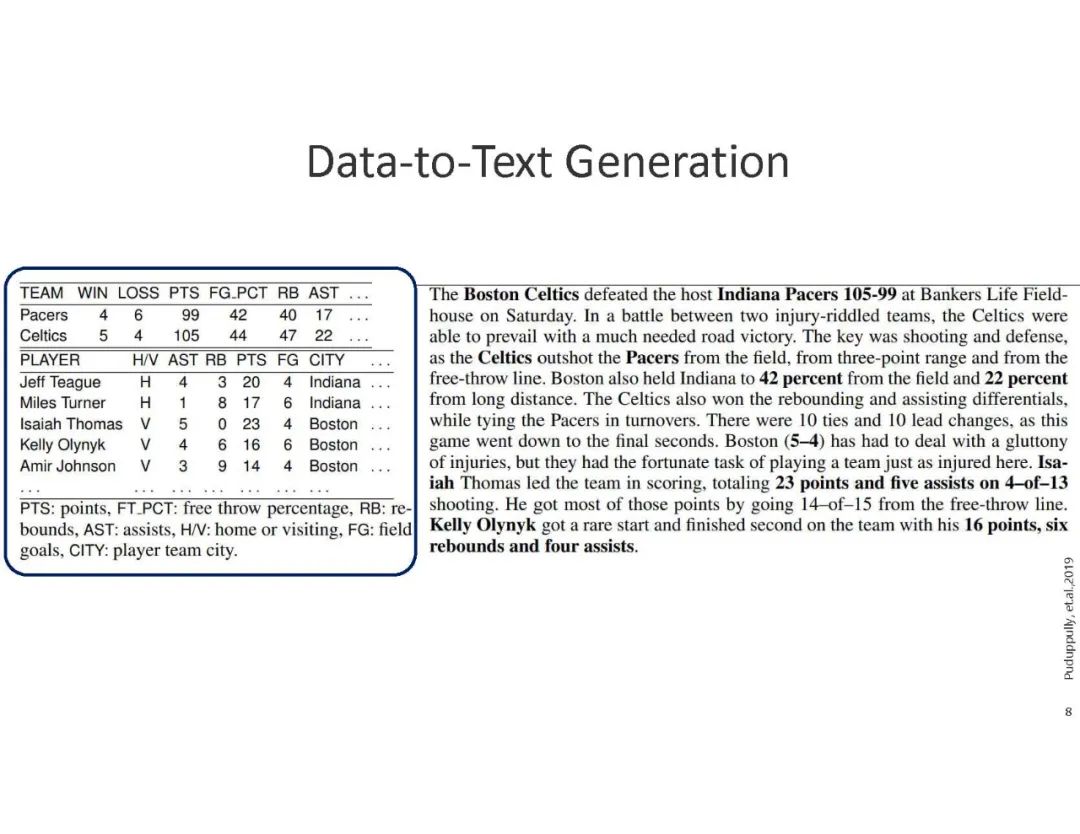

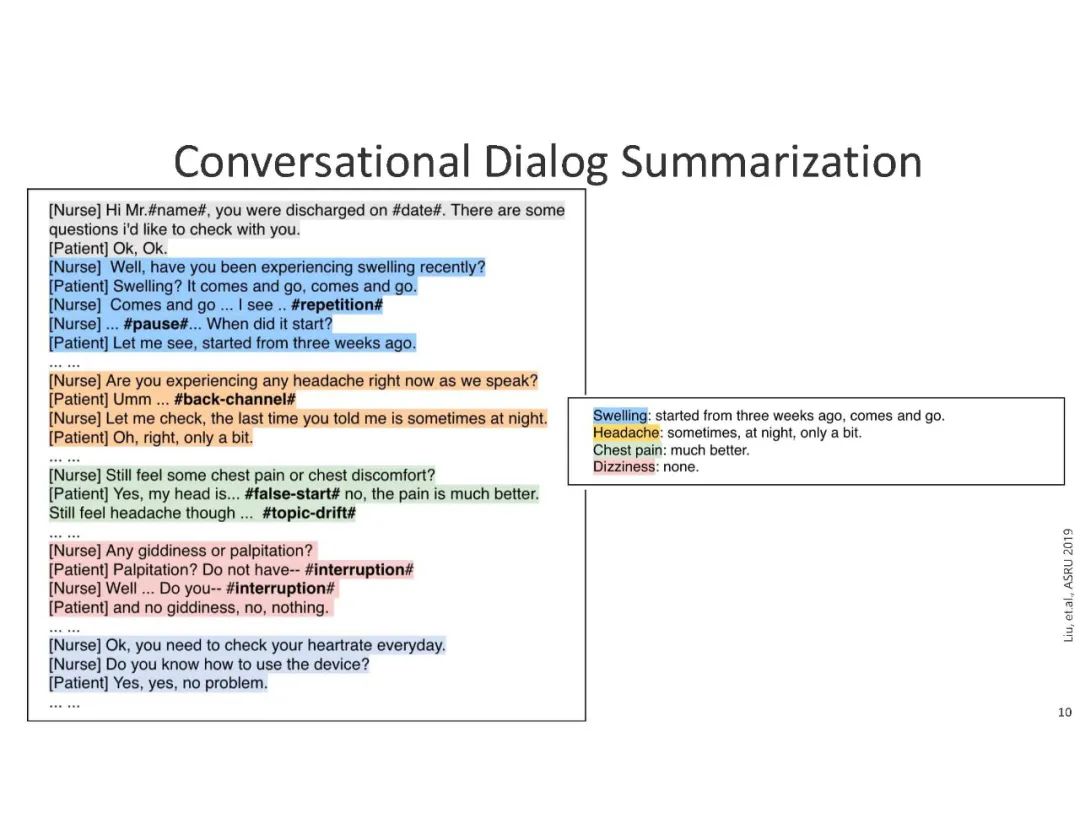

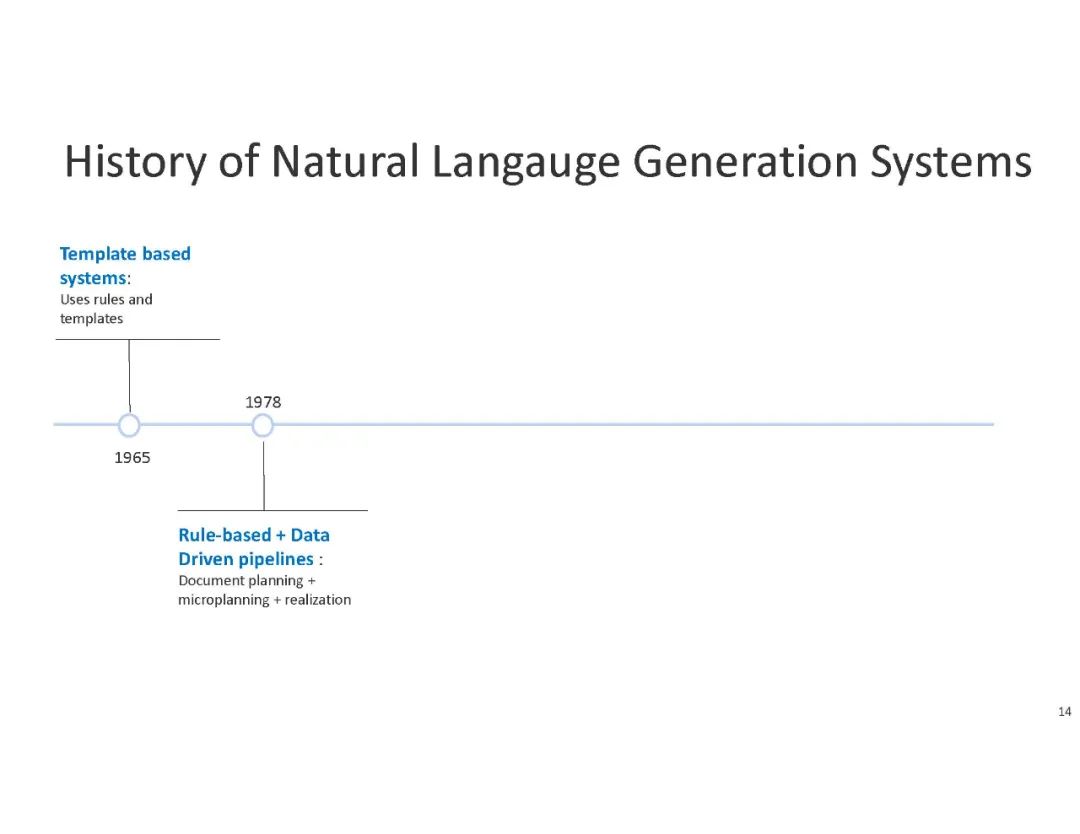

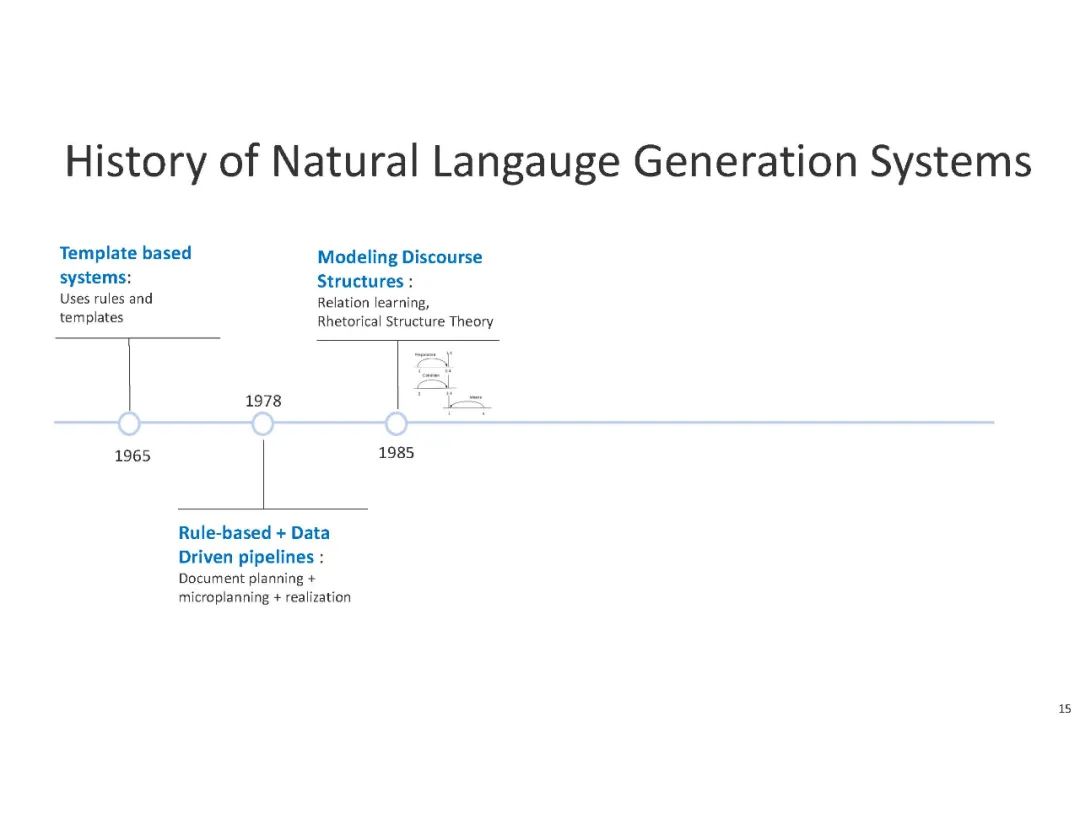

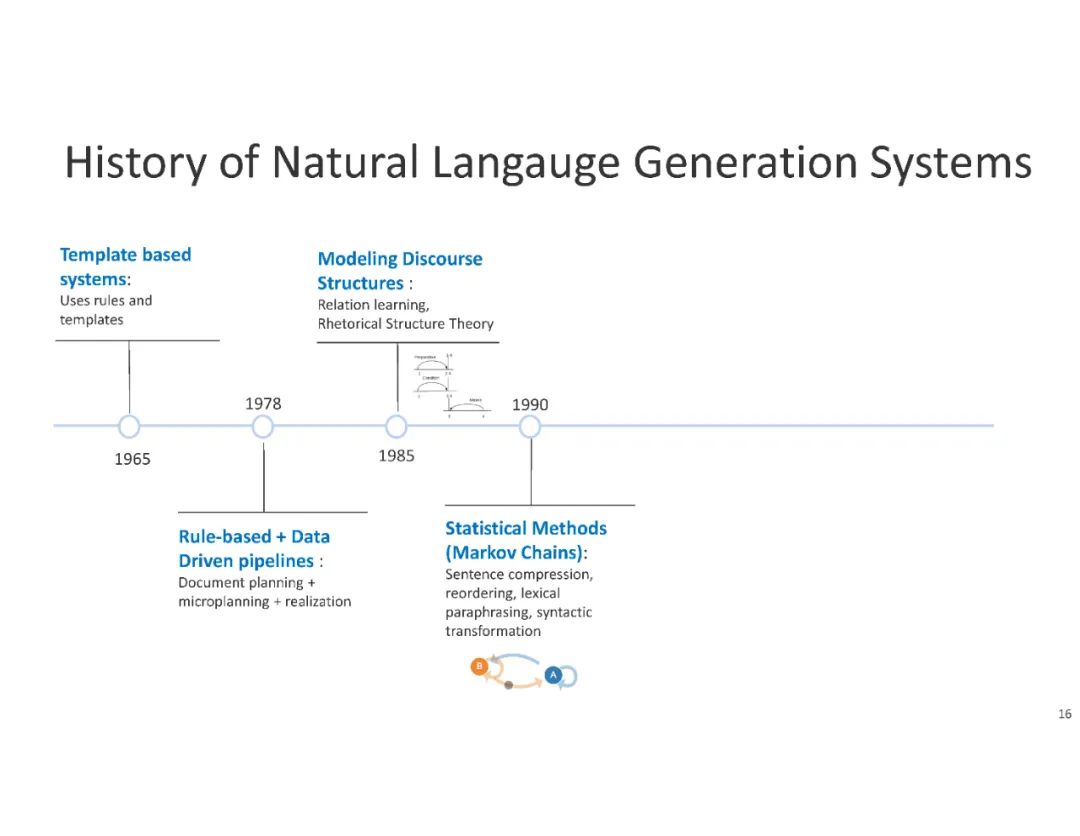

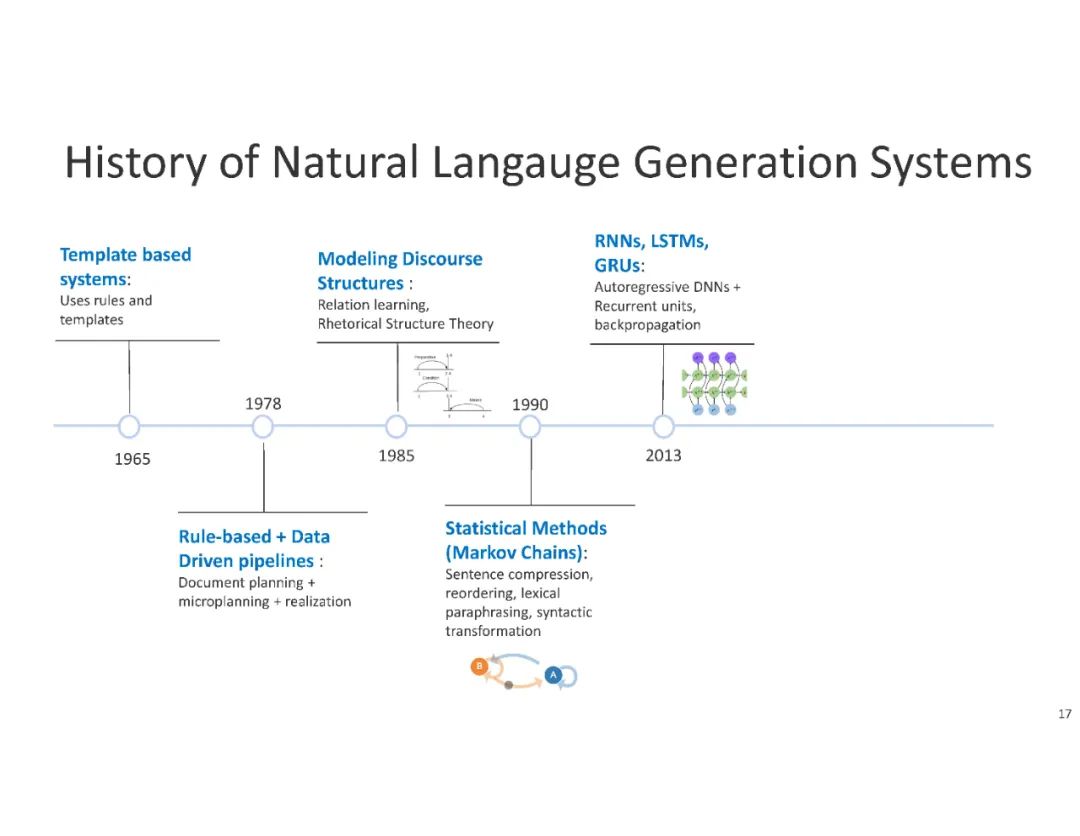

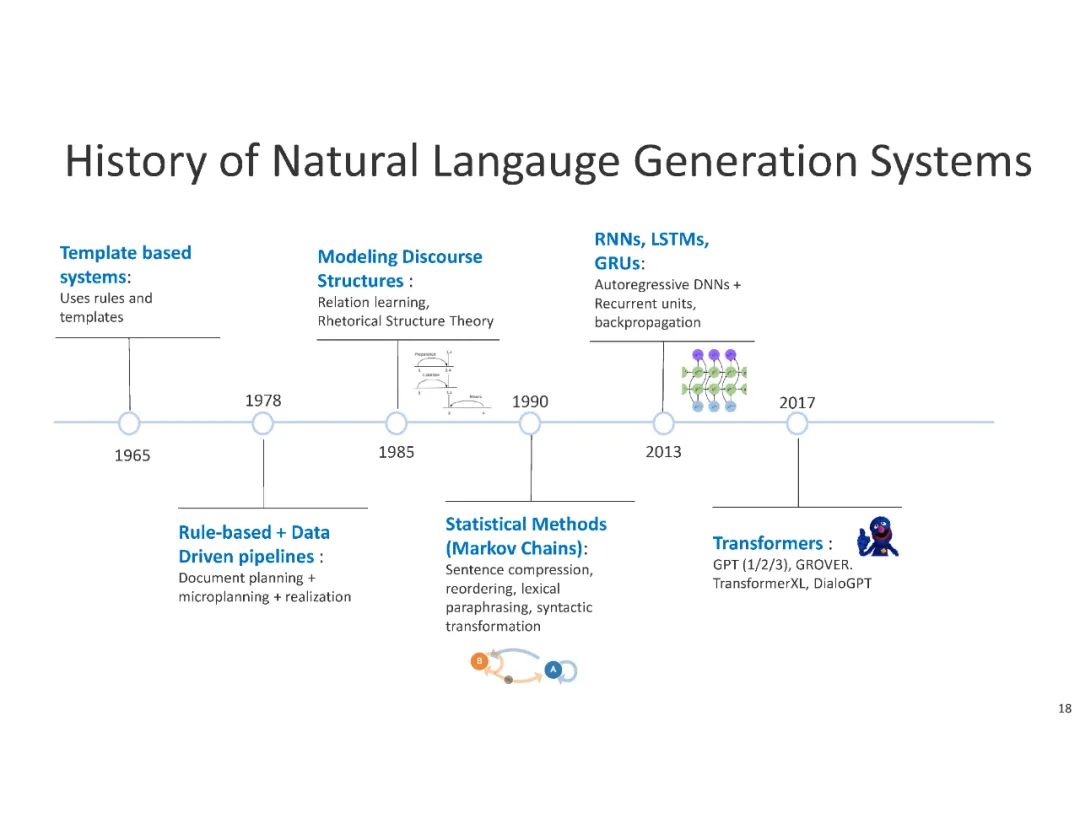

神经语言生成(NLG)——使用神经网络模型生成连贯的文本——是自动化文本创建最有前途的方法之一。近年来,随着深度语境语言建模(如LSTMs、GPT、GPT2)和迁移学习(如ELMo、BERT)的发展,神经文本生成出现了范式转变。虽然这些工具极大地改善了NLG的状态,但是对于低资源任务,最先进的NLG模型仍然面临许多挑战: 生成的文本缺乏多样性,描述的情况违反常识性规则,使用事实信息的困难,以及设计可靠的评估指标的困难。在本教程中,我们将概述当前神经网络架构的最新技术,以及它们如何形成文本生成的最新研究方向。我们将讨论这些模型在生成连贯文本时如何以及为什么成功或失败,并对几个应用程序提供见解。

目录内容:

| Title | Description |

|---|---|

导论 Introduction |

本节将通过介绍神经网络建模方法。This section will introduce the tutorial by presenting the recent impact of neural network modeling approaches on the field. |

神经网络建模 Neural Network Modeling |

自然文本生成建模策略。Modeling strategies for natural text generation |

训练与编码 Training and Decoding |

神经自然语言生成模型的编码与解码策略,Various decoding and learning strategies for neural NLG models |

基准与评价 Benchmarks and Evaluation |

自动与人工评价,Automatic and human evaluation of NLG |

构建神经生成模型 Building Neural Generation Models |

部署自然语言生成模型的挑战,Challenges for deploying natural language generation models in production. |

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“NLG” 就可以获取《【EMNLP2020】自然语言生成,Neural Language Generation》专知下载链接

登录查看更多

相关内容

专知会员服务

78+阅读 · 2020年8月13日

专知会员服务

99+阅读 · 2020年7月3日

专知会员服务

52+阅读 · 2020年1月20日