编辑:袁榭 好困

【新智元导读】最近MIT的一项研究显示,费时费力的DeepFake换脸大法甚至还不如单纯的文字假消息能唬人。

DeepFake,自面世以来就被列为了潜在的「坏AI」。

不论是著名的「加朵换头色情片」,还是各种用DeepFake变声的银行转账骗局,DeepFake的相关消息似乎都摆脱不了负面背景。

不过MIT的最新研究表明,伪造文字信息的破坏力要远高过伪造的图片或视频。

这与传播领域的旧观点相反,过往学界认为当同一版本的内容以视频而不是文本形式呈现时,人们会更容易被假消息欺骗。

超现实视觉效果技术的最新进展引发了人们的担忧,即政治演讲的DeepFake视频很快将与真实的视频在视觉上无法区分。

然而,视听信息如何影响人们对假消息的易感性,针对此项目的实证研究很少。

最近,MIT媒体实验室的科学家向5727人展示了16篇真实的政治演讲片段和16篇被DeepFake加工篡改过的演讲片段。

声音片段以文本、视频和音频的排列形式呈现,例如带有字幕的视频等。

![]()

论文链接:https://arxiv.org/pdf/2202.12883.pdf

受试者被告知其中一半的内容是假的,并被询问他们认为其中哪些片段是伪造的。

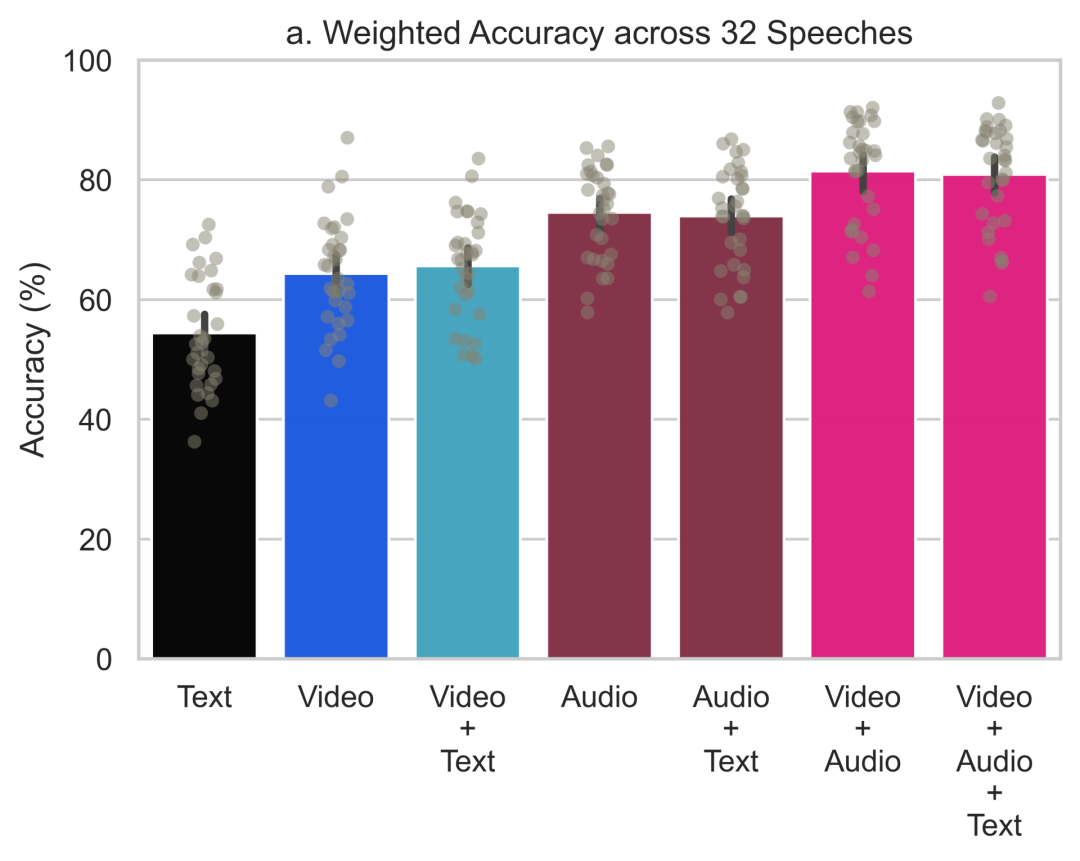

在仅显示文本时,受访者在识别谎言(57% 的准确率)方面仅比随机猜测好一点。

当给出带字幕的视频时,受访者的猜测更准确(66%),而在同时显示视频和音频时更成功(82%)。

也就是说,受试者在观看视频或听音频时比阅读文字记录时更能识别事件是否真的发生。

这些发现还表明,普通人有时(但并非总是)能够识别出由DeepFake同步变造产生的视觉失真效果。

按照论文作者的解释,受试者的判断基础更多依赖于内容表达的方式而非内容本身。

受试者在带音轨视频上的判断率比无声视频更准确、在无声视频上的判断率又比文字更准确,是因为影、音、文字三种载体中,影、音除了内容本身,还有说话人的各种微小表情、动作、语音模式等方面的细微差异。

如果旁观者无法观察这些细微差异,光从书面文字上判定何为真实演讲、何为AI生成,准确率是只能达到一半一半的抛硬币程度。

论文作者称:「伪造的政治演讲视频比伪造的文字记录更容易识别,这一发现强调了重新让人们忆起常被遗忘的『眼见为实』格言的必要性。」

不过此研究有明显局限:研究者生成的DeepFake材料并不是真实性超级出众的。

研究者自己都警告:「真正危险的伪造视频,可能并不是普通算法随便生成的DeepFake视频,而是经过精加工、极引人入信的单一视频。」

在当下时局中,这一警示尤有现实意义。公众一直在怀疑东欧冲突中的一方会制造另一方总统宣布投降的DeepFake视频。

这些担忧可以理解,不过当下散播的各种假消息还几乎没用到DeepFake技术。

按《今日美国》事实核查组的成员称,在动荡时局中,造假者搜索、剪裁旧的影音材料,安上时下新消息的名目再贴出,这种造假行为的难度比DeepFake低多了。

例如,一段TikTok视频声称展示了最近在乌克兰发生的爆炸,但实际来源在1月份就已经有了。

正如本研究所揭示的,DeepFake可能会影响公众事件的结果,但彻头彻尾的谎言和简单剪切编辑,是传播假消息的更为突出的形式。

与不同演讲和模式条件下准确性的高变异性相比,受试者的确信程度变化较小。

在文字记录中,受试者的平均确信度为81%。在视频和音频呈现的演讲上,受试者的确信度分别提高了6%和9%。如果把所有内容都提供给受试者,则可以让确信度提高12%。

也就是说当受试者通过视频和音频接收到更多的信息时,受试者的加权准确性、确信度、对捏造的演讲的辨别力和对真实演讲的辨别力都会平均增加。

不过,研究人员发现字幕似乎对结果并没有明显的影响。

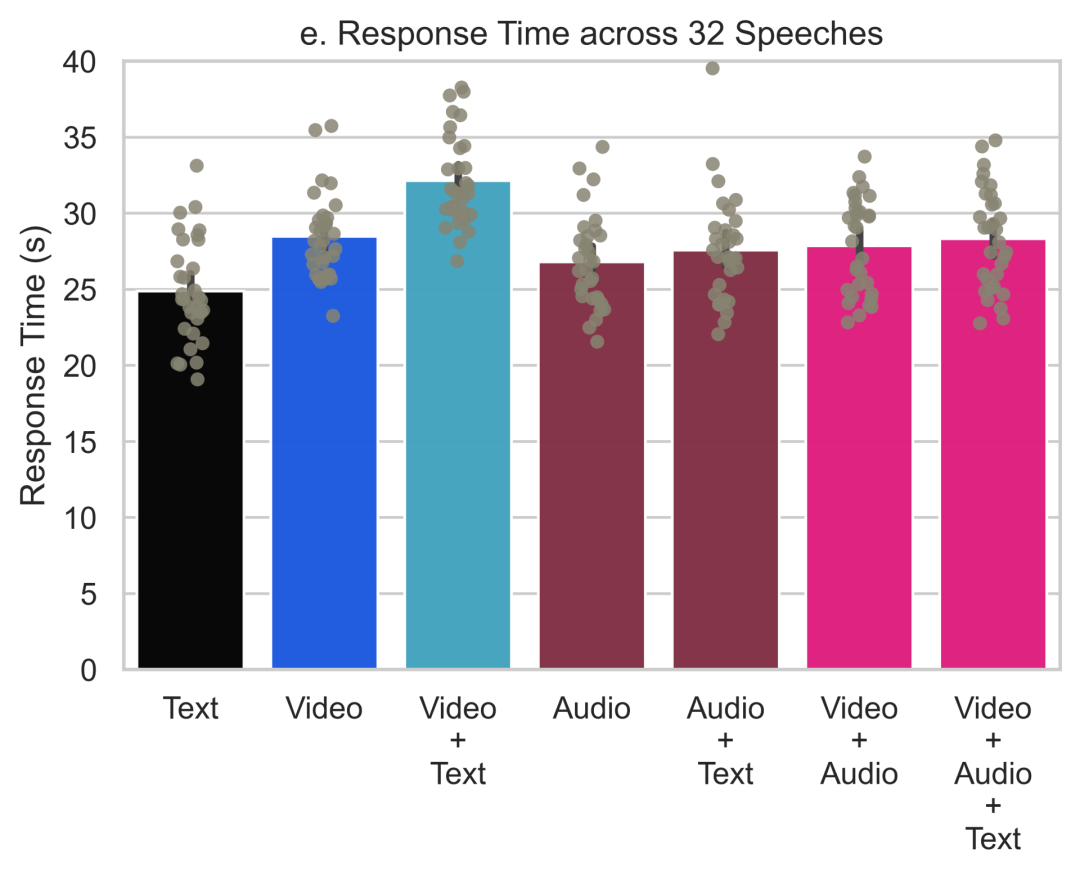

受试者反应时间的中位数是24秒,比视频的平均长度长3秒。无声的、有字幕的视频的反应时间中位数是31秒,比其他所有模式条件的反应时间略长。

在所有7种模式条件下,受试者对伪造内容的反应时间比真实内容要短。其中,文字、视频和音频分别为3.8秒、2.5秒和3.7秒。

此外研究人员发现,相对于所有其他模式的条件,受试者对识别文字记录的真实性有更大的偏差。

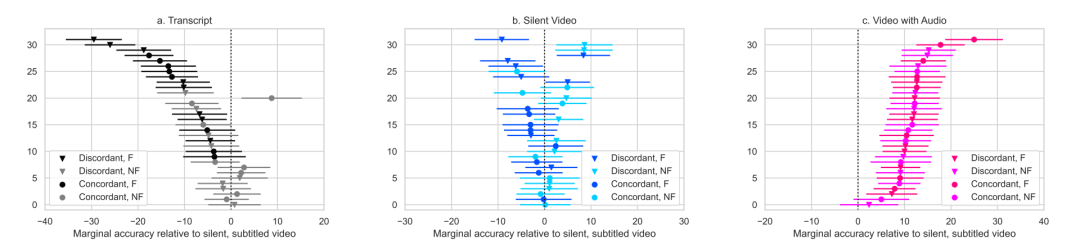

下图a显示,受试者对文字稿的准确度大多低于无声的字幕视频。同样地,c显示受试者对有声视频的准确率始终高于无声字幕视频。与此相反,b显示了受试者在有字幕和无字幕的情况下表现的异质性。

受试者对32个演讲中的每个演讲的文字记录、无声视频和有声视频判断的准确性

总的来说,信息载体的确影响辨别准确性:受试者在判断有音频的视频时,比无声视频更准确;在判断无声视频时,比文本记录更准确。同时,研究者发现受试者更多地依赖于说话人的语言方式、微表情、动作等视听线索,而非内容本身来判断。

评估伪造和非伪造演讲之间的这种难度上的不对称加剧了「说谎者的红利」,即消息会被伪造的普遍可能性,会让公众质疑所有消息都是伪造的,从而使撒谎者能够避免对真实的负面新闻负责。

不过,研究者发现当演讲与政治家固有的公众印象不符时,会降低参与者对视觉线索的依赖。演讲者所说的话与受试者对说话者的期望相匹配的程度,被研究者称为「期望违反启发式」。

而且,研究者发现反思性推理会影响受试者依靠视觉信息的程度:受试者「认知反思测试」的低分数,与对视觉线索的依赖不足、对内容的同时过度依赖是正相关的。

用白话说,越笨、越不动脑子的人,越容易单纯取信于政客演讲的内容,而不观察政客说话时的表情与动作。

MIT的研究人员从100,000个DeepFake视频和19,154个在公开的Kaggle竞赛中,训练了一系列神经网络来检测DeepFake。

根据机器学习模型的表现,研究人员筛选出了3000个最容易被误判的视频。这些视频不仅仅是机器学习模型难以辨别的,而且对许多人来说也很难辨别真假。

研究人员认为,多接触接触被DeepFake编辑了的视频可以提高人们的判断力。

于是便建立了之前提到的「Detect Fakes」网站,并公开展示了数千个高质量的DeepFake和真实视频。

虽然不能靠着单一的线索来辨别哪个是假的,不过可以留意一下以下这8个要点。

-

-

注意脸颊和额头:皮肤是否显得太光滑或皱纹过多?皮肤的老化程度是否与头发和眼睛的老化程度相似?DeepFake在某些方面往往是不协调的。

-

请注意眼睛和眉毛:阴影是否出现在应该出现的地方?DeepFake往往不能对真实的物理学进行重现。

-

注意眼镜:是否存在眩光,还是炫光过多?移动时,眩光的角度是否改变?再一次,DeepFake表现出了物理学方面的弱点。

-

注意面部的毛发:看起来是否真实?DeepFake可能会添加或去掉鬓角或胡须,但通常会有违和感。

-

-

-

注意嘴唇的大小和颜色:是否与此人面部的其他部分相匹配?

参考资料:

https://detectfakes.media.mit.edu

https://www.media.mit.edu/projects/detect-fakes/overview/

https://arxiv.org/pdf/2202.12883.pdf

![]()

![]()