NeurIPS 2018 | 基于学习的多任务框架L2MT,为多任务问题选择最优模型

极市平台是专业的视觉算法开发和分发平台,加入极市专业CV交流群,与6000+来自腾讯,华为,百度,北大,清华,中科院等名企名校视觉开发者互动交流!更有机会与李开复老师等大牛群内互动!

同时提供每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流。点击文末“阅读原文”立刻申请入群~

来源:腾讯AI实验室

由腾讯AI Lab 和香港科技大学的研究者合作完成的论文,提出一种新型框架 L2MT(learning to multitask),用基于学习的方法为多任务问题选择最优模型,本文为NeurIPS 2018收录文章。

论文链接:https://arxiv.org/abs/1805.07541

多任务学习旨在利用多个任务中包含的有用信息来帮助提高这些任务的泛化性能。最近几十年诞生了众多多任务模型。根据最近的一项调查,这些模型可以分为两大类:基于特征的方法和基于参数的方法。

基于特征的方法用数据特征作为媒介,在所有任务中共享知识,通常会学习所有任务的共同特征表示。这种方法可以进一步分为两类:浅层共享和深层共享。不同于基于特征的方法,基于参数的方法通过使用正则化项或贝叶斯先验处理模型参数来实现不同任务之间的知识迁移,从而连接不同任务。

该方法可以细分为五类:低秩法、任务聚类法、任务关系学习法、脏方法和多层法。

多任务模型如此之多,如何为给定的多任务问题选择最优模型呢?一种解决方案是做模型选择,即使用交叉验证或其变体。该解决方案的局限性之一是计算量很大,因为每个候选模型都需要进行多次训练。

本论文提出了一个学习多任务(learning to multitask,L2MT)的框架,以基于学习的方法解决这个问题。L2MT 的主要思想是利用已有的多任务经验来学习如何为新的多任务问题选择合适的多任务模型。为了实现这一目的,研究者把已有的多任务经验表示为由元组组成的训练集,其中每个元组都有三个条目:一个多任务问题、一个多任务模型和相对测试误差,该误差等于多任务问题的多任务模型的平均测试误差与单任务学习模型的平均测试误差的比率。

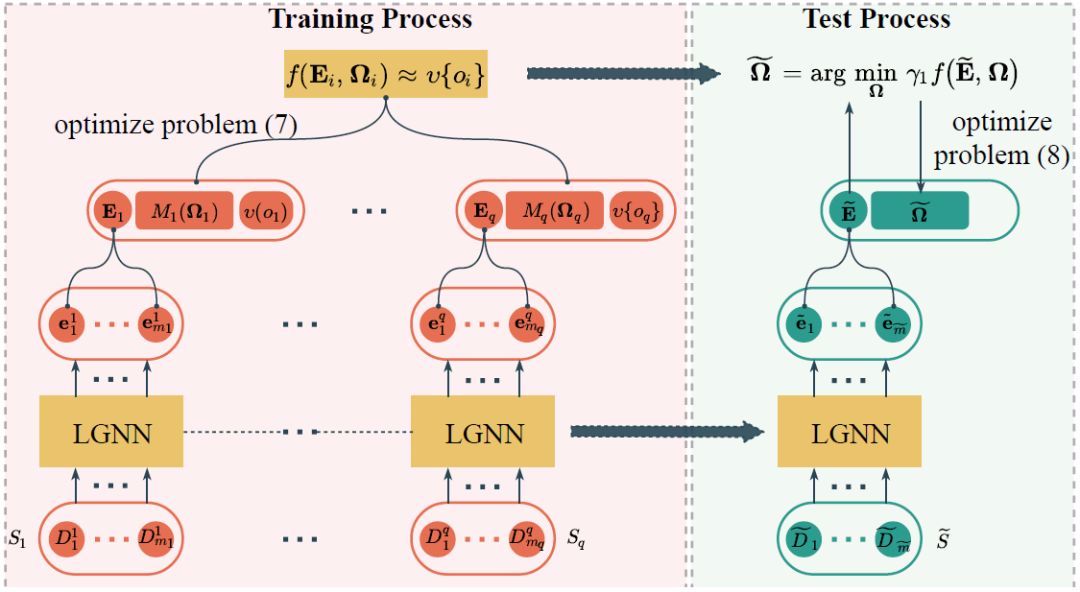

基于该训练集,研究者提出了一个端到端的方法来学习从多任务问题和多任务模型到相对测试误差的映射关系,这里需要确定多任务问题和多任务模型的表征。首先,研究者提出一种分层图神经网络(LGNN)来学习作为多任务问题中单个任务表征的任务嵌入,并将聚合所有任务嵌入得来的任务嵌入矩阵作为多任务问题的表征。对于那些公式统一的多任务模型,由于任务协方差矩阵扮演重要的角色且揭示了成对任务间的关系,所以使用协方差矩阵来表示任务。然后,将多任务问题和模型的表征都编码进评估函数以估计相对测试误差。对于一个新的多任务问题,我们可以通过 LGNN 学习任务嵌入矩阵,然后通过优化评估函数来学习任务协方差矩阵以及整个多任务模型,以取得较低的相对测试误差。在基准数据集上的实验结果显示了 L2MT 框架的有效性。

图 1:L2MT 框架图示,该框架由两个阶段组成。训练阶段基于训练数据集和特定多任务模型学习评估函数 f(·, ·),以逼近相对测试误差。测试部分则通过最小化相对测试误差(即来学习任务协方差矩阵。

表示第 i 个多任务问题 S_i 中第 j 个任务的训练数据集,Si 和

示测试多任务问题 S˜ 中第 i 个任务的训练数据集。LGNN 基于训练数据集进行训练学习,且被训练和测试多任务问题中的所有任务共享,研究者绘制了多个副本以便清晰呈现。

L2MT 框架有一些相关的学习范例,包括多任务学习、迁移学习和终身学习。但是,L2MT 框架与这些相关范例相去甚远。在多任务学习中,训练集只包含一个多任务问题,即 S_1,其目标是在给定多任务模型的情况下学习模型参数。迁移学习和 L2MT 的区别与多任务学习和 L2MT 的区别类似。终身学习可以看作是在线迁移/多任务学习,因此它也与 L2MT 不同。

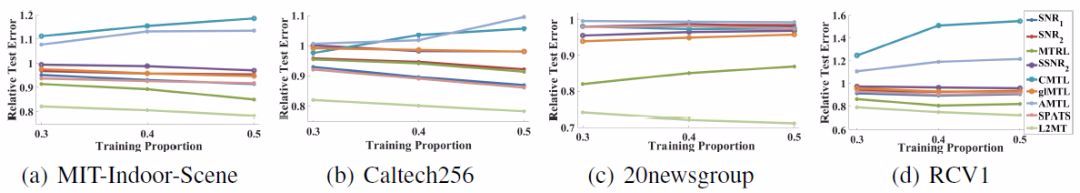

图 2:训练数据量改变时,不同模型在四个数据集上的结果

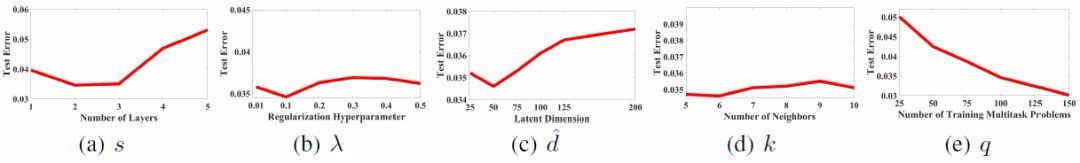

图 3:使用 30% 的数据进行训练时,L2MT 在 20newsgroup 数据集上的灵敏度分析

*推荐文章*