Deep Learning 三剑客 | 30年不悔坚持终成传奇

人工智能的主流算法Deep Learning深度学习的历史,堪称Deep History, 也是深度学习三剑客Geoff Hinton, Yann LeCun 和Yoshua Bengio共同走过的30年艰难而辉煌的不悔人生。他们如何从当年的地下小团体成为今天引领人工智能的风云人物,我们来看看其中的精彩故事。

Geoff Hinton,谷歌大脑研究小组的负责人,出生在英国,1977年在爱丁堡大学获得博士学位,之后在加拿大多伦多大学任教,他被称为深度学习教父。

Yann LeCun, Facebook人工智能研究小组FAIR的主任,出生在巴黎,在 Université Pierre et Marie Curie获得博士学位。曾在AT&T Bell Labs工作多年,2003年起在纽约大学NYU任教,2013年获小扎邀请加盟Facebook。

Yoshua Bengio – Université de Montréal大学教授。出生在法国,在McGill University获得博士学位,曾在MIT跟随Michael Jordan教授做博士后研究,后任职 AT&T Bell Labs,1993年起在Université de Montréal任教。

Geoff Hinton, Godfather of Deep Learning

Geoff Hinton 和Yann LeCun已成为深度学习的领袖人物,人们津津乐道于他们提出的后传播算法Backpropagation。其实在人工智能的研究中,他们只是复活了一个早已被遗忘的理论。

当人工智能领域在20世纪50年代起步的时候,生物学家开始提出简单的数学理论,来解释智力和学习的能力如何产生于大脑神经元之间的信号传递。当时的核心思想一直保留到现在 - 如果这些细胞之间频繁通信,神经元之间的联系将得到加强。

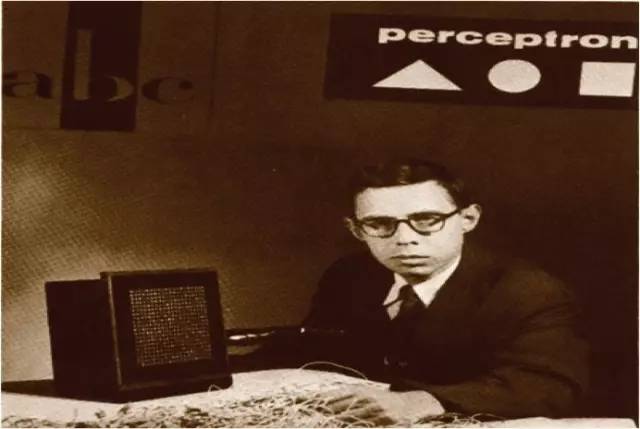

Frank Rosenblatt invented Perceptron

1956年,美国认知心理学家弗兰克·罗森布拉特(Frank Rosenblatt)基于神经元的理论发明了一种模拟神经元的方法。这个被称为感知器Perceptron的发明,可以学习如何将简单的图像分类为三角形和正方形,这为神经网络创立了理论和实验基础。

Rosenblatts发明的电脑有八个模拟神经元,由电机和拨号盘连接到400个光检测器。Rosenblatt使用一种称为监督学习的方法来训练感知器,以正确区分不同形状。他向感知器显示一个图像以及正确的答案,然后,机器将调整每个神经元对其输入信号的关注度,将这些“权重”转移到将产生正确答案的设置。

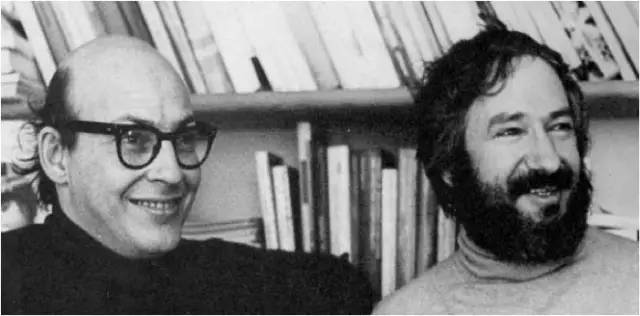

Marvin Minsky and Seymour Papert at MIT

今天的深度学习网络使用复杂的算法,并拥有数百万个模拟神经元,它们之间有数十亿个连接,也是以同样的方式训练的。Rosenblatt预测,感知器很快就能够学会向人打招呼。他的想法成为人工智能新生领域的基石。

不幸的是,Rosenblatt的学习算法当时对于多层结构的神经网络不起作用。在1969年,曾与他一起上过高中的人工智能先驱,MIT的权威人士Marvin Minsky,和知名专家Seymour Papert一起,写了一本批评感知器学派的书Perceptrons,扼杀了当时对神经网络的研究兴趣。Minsky表示,多层次神经网络的结构并不会使感知器强大到有实用价值。人工智能学者们也因此放弃了学习式软件的想法。神经网络则被推到了计算机科学的边缘。

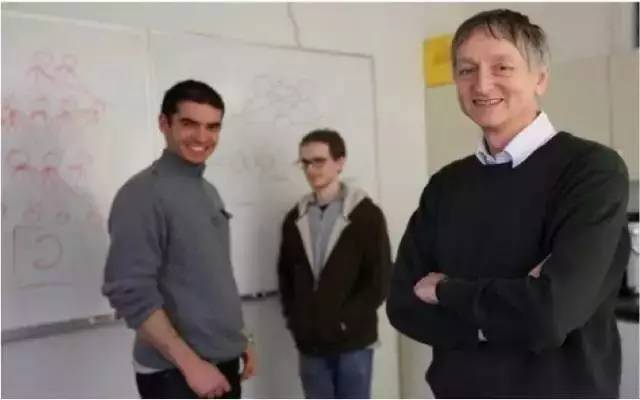

Geoff Hinton and Yann Lecun

尽管如此,20世纪80年代初,LeCun在巴黎读博士时,第一次读到感知器perceptrons还是被迷住了。 “我很惊讶,这种算法很有价值,不知道为什么人们会放弃它。”他在图书馆度过了几天,疯狂寻找感知器消失之前发表的论文。然后他发现,在美国有一小群研究人员正在秘密地继续神经网络的工作。

1985年,LeCun遇到了这个地下组织的核心人物Geoff Hinton,便加入了这个小团队。LeCun和Hinton很快成为好朋友,相互崇拜,他们一起成为恢复神经网络思想的小团体的核心。他们认为模拟自然智力中看到的核心机制是构建人工智能的唯一途径。 “智能产生于人脑,所以从长远来看,人工智能应该像大脑系统一样工作,”Hinton说。

之后Lecun和Hinton等人完善了一个具有多层神经网络的学习算法,称为反向传播算法Backpropagation,引起了心理学家和计算机科学家的兴趣。但是,在LeCun的支票识别项目结束之后,反向传播似乎很难适用于其他问题。而这时一个新的数据排序的方法是由贝尔实验室的研究员发明,它不涉及模拟神经元,被视为数学上更为优雅的方法。很快,这个方法成为很多互联网公司的基石,如谷歌,亚马逊和LinkedIn。

Yoshua Bengio and Yann Lecun

但Lecun并未放弃多层神经网络的研究。2003年,他到纽约大学之后,就和Hinton, 及蒙特利尔大学教授Yoshua Bengio,一起组成了所谓的“深度学习的阴谋 Deep Learning Conspiracy”。为了证明神经网络是有用的,他们悄悄地开发了更多层的神经网络,用更大的数据集来训练,并在更强大的计算机上运行。

到了2010年,深度学习算法在很多实际应用上开始超越其他技术,例如图像排序。 Microsoft,Google和IBM均将深度学习的算法添加到语音识别系统中。但神经网络对大多数研究人员来说仍然很陌生,并未被广泛接受。 2012年初,当一篇取得视觉识别新纪录的论文被一个领先的会议拒绝之后,LeCun甚至写了一封措辞激烈的信,最初是匿名公布的,他指责论文评审人员“无知”和“有偏见”。

Geoff Hinton and his team won ImageNet Challenge

六个月后,Hinton和两位研究生采用深度学习算法,参加了ImageNet竞赛并获得第一名。Hinton带领的多伦多大学团队在五次尝试之内,以85%的准确度成功地识别出图像中的物体,比第二名超出10个百分点。深度学习软件的初始层的神经元在优化后可找出简单的特征,例如边缘和角落,更深层的神经元可找出更复杂的功能,如形状,直至识别出狗或人。此后,从事计算机视觉的学者们很快就放弃了之前的方法,深度学习算法从此成为人工智能研究的主流。

Mark Zuckerberg and Yann LeCun

LeCun至今仍然对Hinton 2012年在ImageNet大赛上的突破颇有感慨,这一年世界终于接受了他最早提出的观点。 “在某种程度上,这应该是从我的实验室出来的,” Hinton也表示赞同。“对于Yann来说,很可惜,这个突破不是他完成的。” 其实,对于赢得ImageNet挑战背后的技术,LeCun的研究团队作出的贡献最大。很可惜Lecun的学生们毕业的时间不凑巧,忙于其他事情,让他们错过了参加ImageNet大赛。” 目前LeCun正在寻求深度学习的下一个突破,希望能和Hinton打个平手。

2015年5月,他们三人联名在美国《Nature自然》杂志上发表了一篇论文-Deep Learning深度学习。经过30多年的不悔坚持,深度学习的三剑客终于从最初的秘密小团队,成为AI主流研究的领袖人物,笑到了最后。

文章来源:千读(QianduSV)

识别二维码,进入德先生旗下求知书店,选购更多德先生推荐书籍

德先生精彩文章回顾

在公众号会话位置回复以下关键词,查看德先生往期文章!

人工智能|类脑研究|人机大战|机器人

虚拟现实|无人驾驶|智能制造|无人机

科研创新|网络安全|数据时代|区块链

……

更多精彩文章正在赶来,敬请期待!

点击“阅读原文”,移步求知书店,可查阅选购德先生推荐书籍。