【图灵奖得主Yann Lecun最新演讲】基于能量的自监督学习,68页ppt,了解后深度学习发展趋势

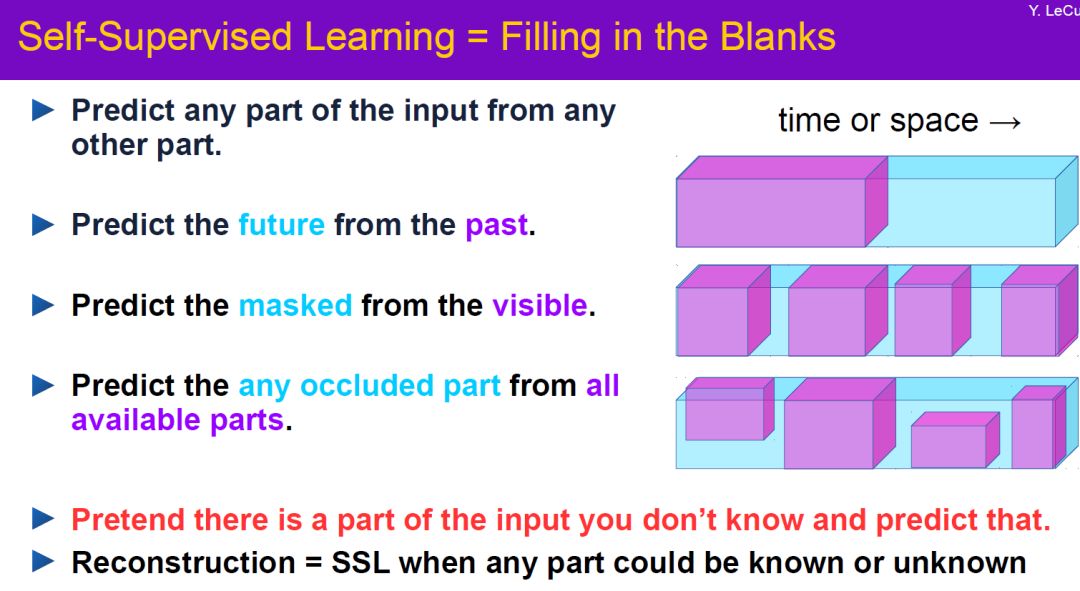

【导读】在最近的物理机器学习交叉论坛上,Facebook人工智能总监、图灵奖得主Yann Lecun给了自监督学习的报告《Energy-Based Self-Supervised Learning 》,68页ppt,介绍了自监督学习的光明前景,基于能量学习的因变量模型,介绍最新自监督学习的进展与问题,是非常值得看的报告。

链接地址:

https://www.ipam.ucla.edu/programs/workshops/workshop-iv-using-physical-insights-for-machine-learning/?tab=schedule

Yann LeCun

在人工智能研究领域,Yann LeCun、Geoffrey Hinton 和 Yoshua Bengio一直被公认为深度学习三巨头,一起获得2018年图灵奖。

Yann LeCun,自称中文名“杨立昆”,计算机科学家,被誉为“卷积网络之父”,为卷积神经网络(CNN,Convolutional Neural Networks)和图像识别领域做出了重要贡献,以手写字体识别、图像压缩和人工智能硬件等主题发表过 190 多份论文,研发了很多关于深度学习的项目,并且拥有14项相关的美国专利。他同Léon Bottou和Patrick Haffner等人一起创建了DjVu图像压缩技术,同Léon Bottou一起开发了一种开源的Lush语言,比Matlab功能还要强大,并且也是一位Lisp高手。(Backpropagation,简称BP)反向传播这种现阶段常用来训练人工神经网络的算法,就是 LeCun 和其老师“神经网络之父”Geoffrey Hinton 等科学家于 20 世纪 80 年代中期提出的,而后 LeCun 在贝尔实验室将 BP 应用于卷积神经网络中,并将其实用化,推广到各种图像相关任务中。

Yann LeCun 也是Facebook人工智能研究院院长,纽约大学的 Silver 教授,隶属于纽约大学数据科学中心、Courant 数学科学研究所、神经科学中心和电气与计算机工程系。加盟Facebook之前,Lecun已在贝尔实验室工作超过20年,期间他开发了一套能够识别手写数字的系统,叫作LeNet,用到了卷积神经网络,已开源。他在 1983 年在巴黎 ESIEE 获得电子工程学位,1987 年在 Université P&M Curie 获得计算机科学博士学位。在完成了多伦多大学的博士后研究之后,他在 1988 年加入了 AT&T 贝尔实验室(AT&T Bell Laboratories /Holmdel, NJ),在 1996 年成为 AT&T Labs-Research 的图像处理研究部门主管。2003 年,他加入纽约大学获得教授任职,并在 NEC 研究所(普林斯顿)呆过短暂一段时间。2012 年他成为纽约大学数据科学中心的创办主任。2013 年末,他成为 Facebook 的人工智能研究中心(FAIR)负责人,并仍保持在 NYU 中兼职教学。从 2015 到 2016 年,Yann LeCun 还是法兰西学院的访问学者。

Energy-Based Self-Supervised Learning 自监督学习

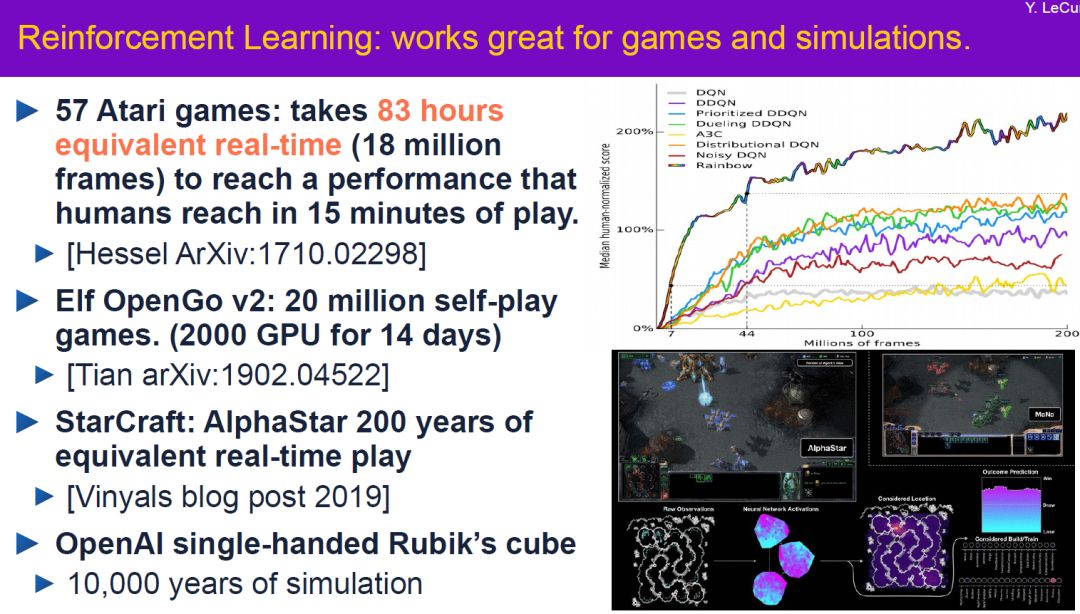

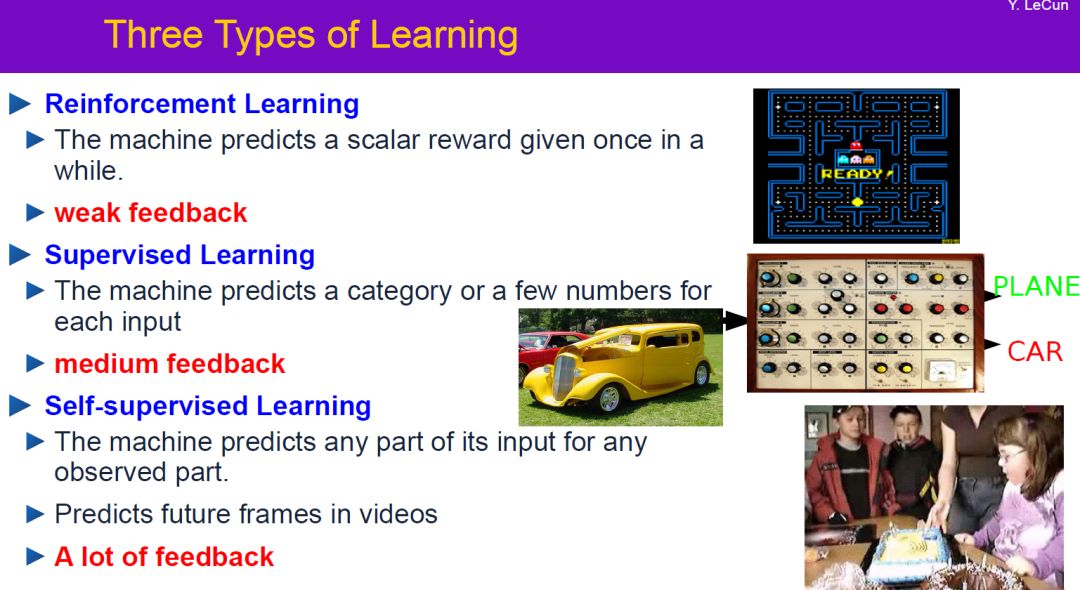

2. 强化学习对于游戏和仿真十分有效,但在现实世界很难奏效

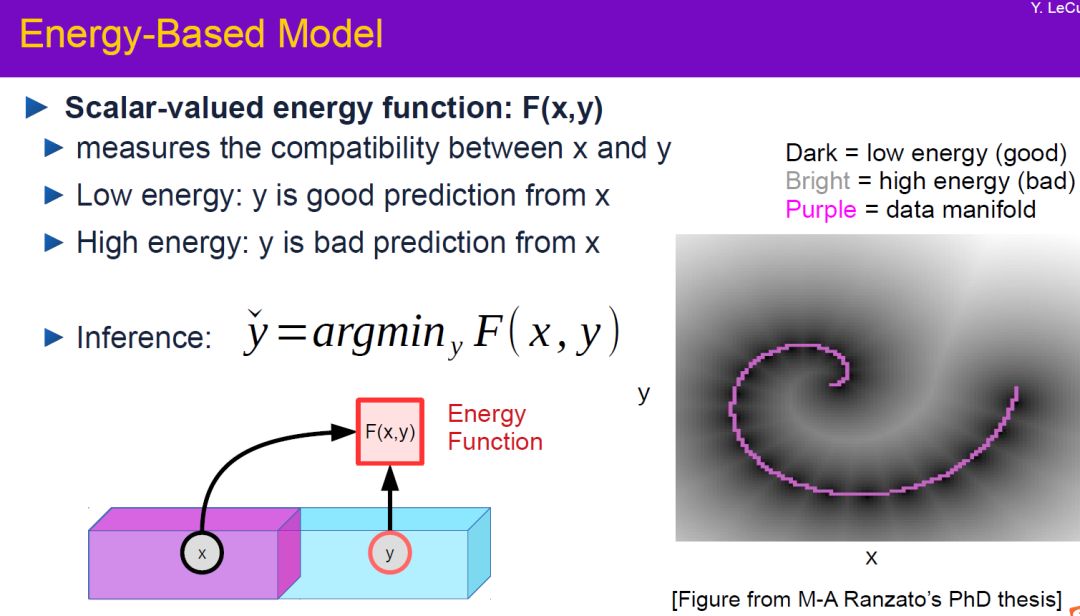

能量模型

SSL是未来

低资源任务的层次特征学习

大规模网络的层次特征学习

学习基于模型的控制/RL的正向模型

我的钱花在:

能源为基础的方法

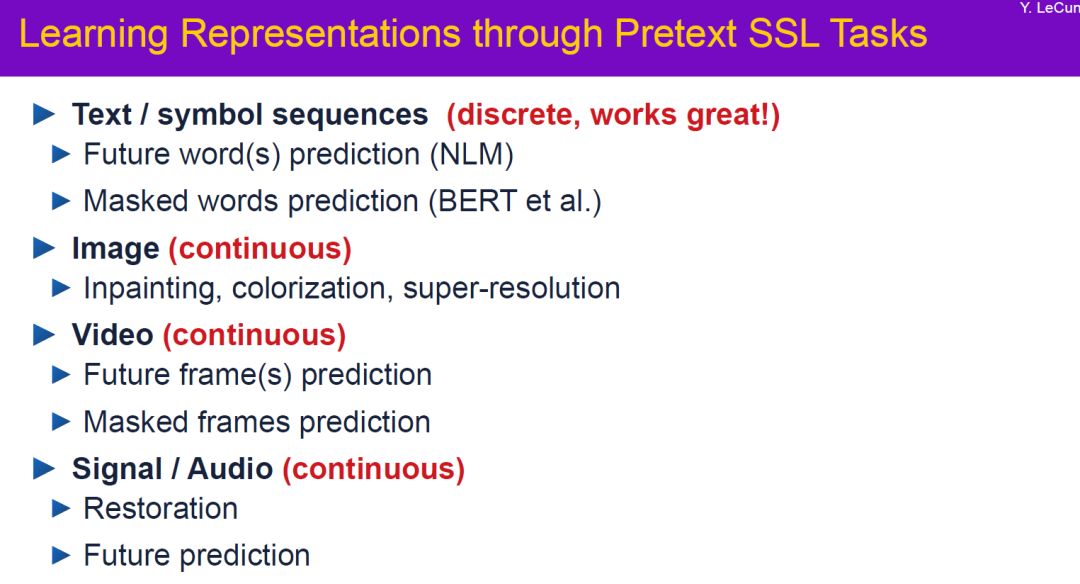

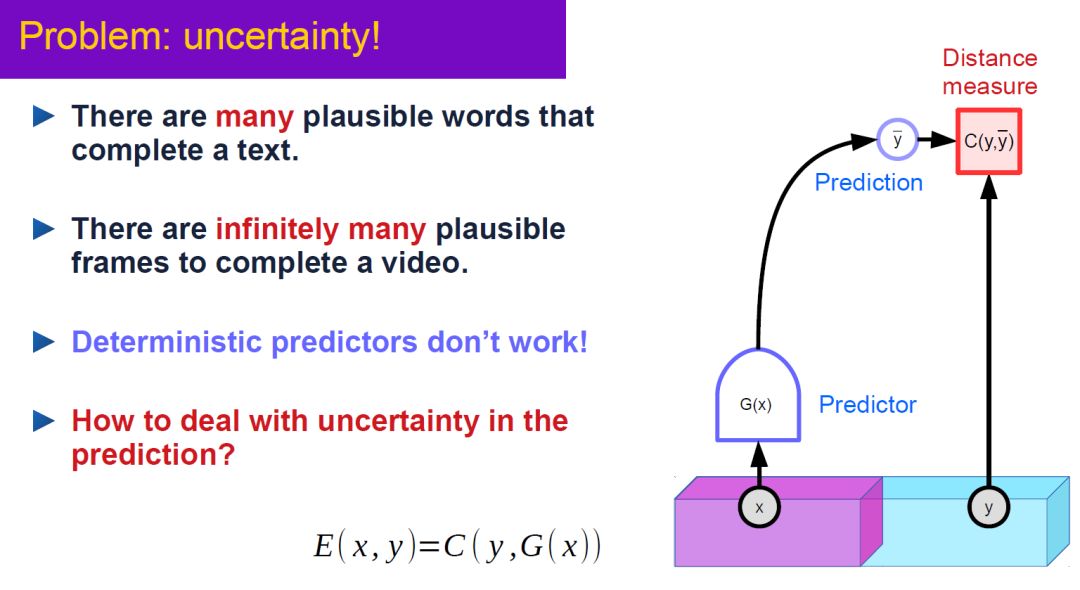

处理多模态的潜在变量模型

正则化潜在变量模型

稀疏潜变量模型

潜在变量预测通过一个可训练的编码器

后台回复“ESSL” 咨询获取Lecun《Energy-Based Self-Supervised Learning 》PPT下载链接

更多"自监督学习"请关注登录专知网站www.zhuanzhi.ai, 实时更新关注:

https://www.zhuanzhi.ai/topic/2001172374045048/vip