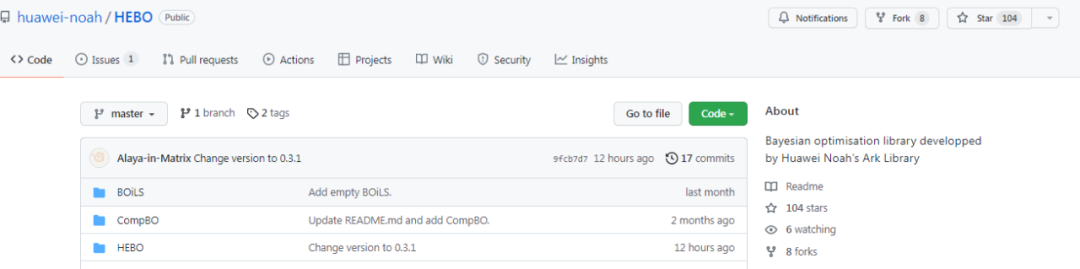

华为诺亚开源了一个贝叶斯优化的库,该库包含三个部分:河伯、T-LBO、CompBO。

贝叶斯优化可以说是一种黑盒优化算法,该算法用于求解表达式未知函数的极值问题。因其具有极强的样本有效性,近年来被广泛使用,研究者只需较少地迭代次数,即可得到一个较好的结果,因此可用于机器学习模型算法调参。

近日,华为诺亚开源了一个新的关于贝叶斯优化的库,该库可用于低维和高维领域的贝叶斯优化,主要包含:

![]()

项目地址:https://github.com/huawei-noah/HEBO

![]()

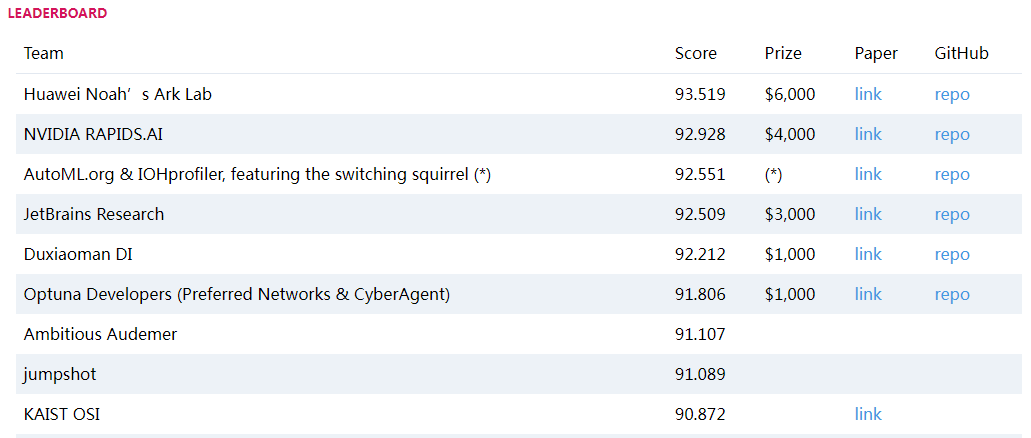

河伯算法是华为诺亚方舟决策与推理(DMnR)实验室开发的贝叶斯优化库。该算法击败了 NVIDIA、IBM、Jetbrain 等,以 93.519 得分赢得了 AI 国际顶会 NeurIPS 2020 的黑盒优化竞赛冠军。

HEBO 是与前 5 名竞争对手之间差异最大的算法,以非常大的优势获胜。下面是比赛结果的截图:

![]()

完整榜单:https://bbochallenge.com/leaderboard/

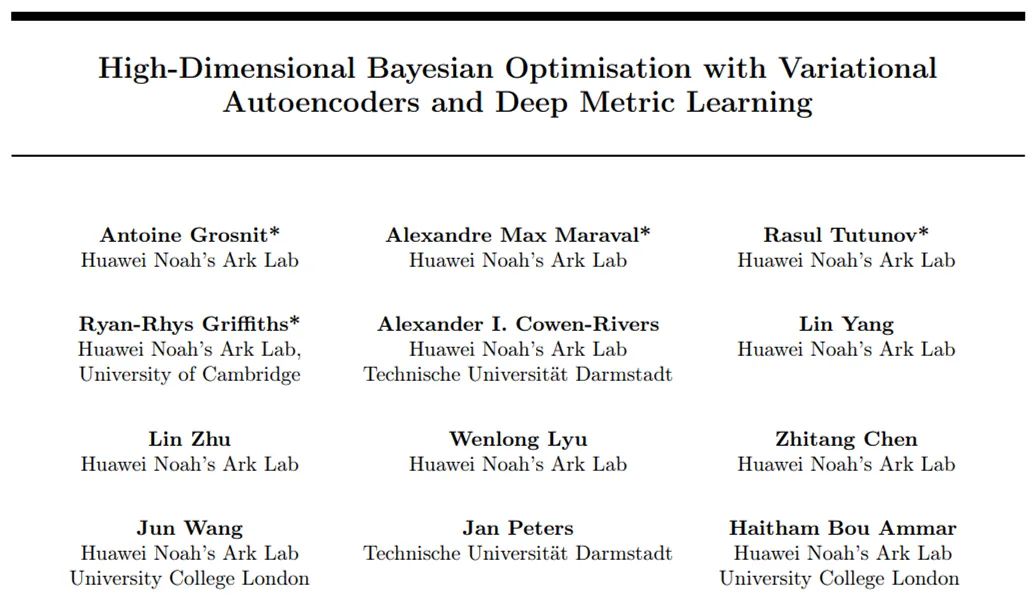

该算法出自论文《High-Dimensional Bayesian Optimisation with Variational Autoencoders and Deep Metric Learning》,全篇 42 页,研究者来自华为诺亚方舟实验室。

![]()

论文地址:https://arxiv.org/pdf/2106.03609.pdf

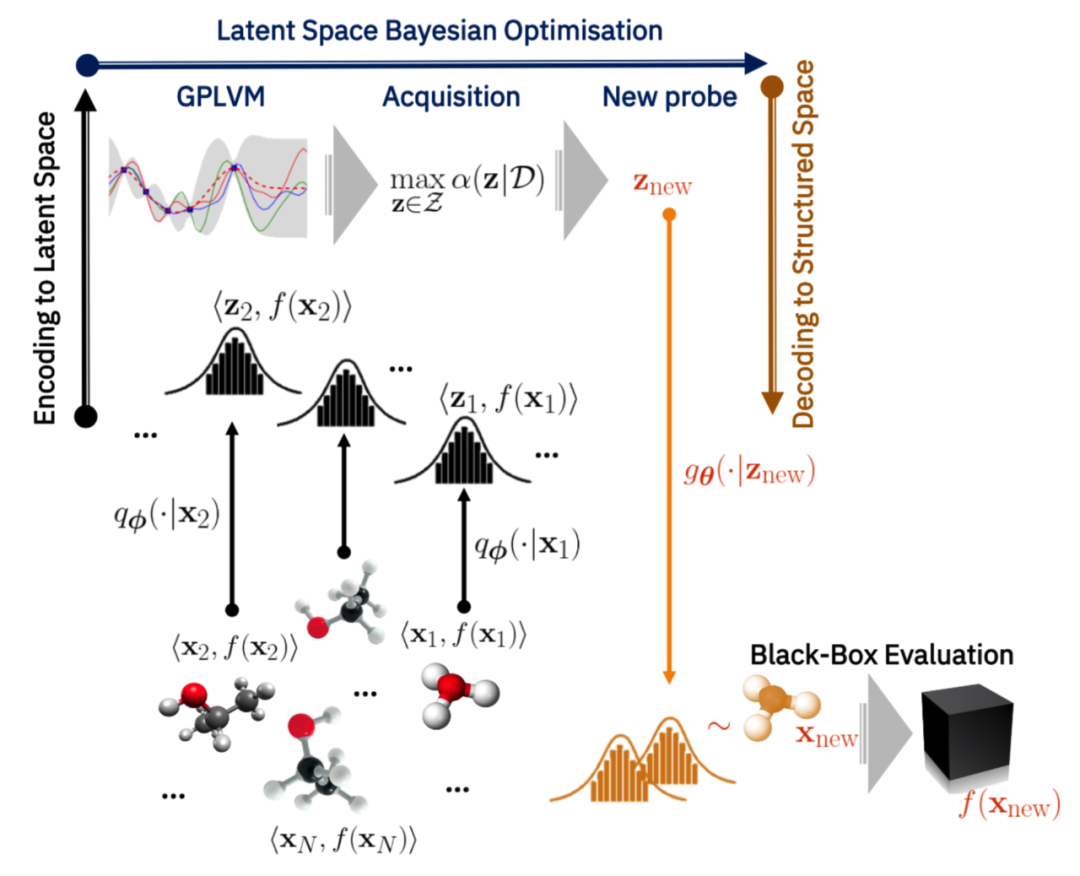

研究者提出了一种基于深度度量学习的方法,以使用变分自编码器(VAE)在高维结构化空间中执行贝叶斯优化。通过扩展监督深度度量学习的想法,他们解决了高维 VAE 贝叶斯优化中长期存在的一个问题,即如何将判别式隐空间作为归纳偏置来执行。重要的是,研究者仅使用以往工作的 1% 的标记数据就实现了这种归纳偏置,显示出了所提方法面向样本的高效性。

在实验中,研究者展示了在真实世界高维黑盒优化问题(包括属性引导的分子生成)上的 SOTA 结果。他们希望,本文展示的结果可以作为实现高效高维贝叶斯优化的指导原则。

![]()

这是一篇发表在机器学习研究杂志 JMLR 2021 上的论文,标题为《Are We Forgetting about Compositional Optimisers in Bayesian Optimisation?》,全篇共 78 页。研究者来自华为英国研发中心。

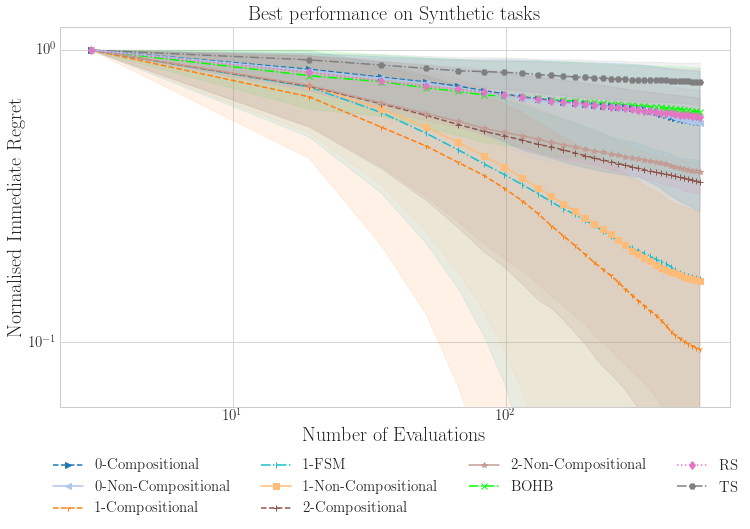

![]()

贝叶斯优化为全局优化提供了一种面向样本高效的方法。在这个框架内,采集函数(acquisition function)的最大化是决定性能的关键因素。但是,由于采集函数往往是非凸的,因此不容易优化,导致其最大化变得复杂。

华为的这篇论文对最大化采集函数的方法进行了全面的实证研究。此外,通过为流行的采集函数推导出全新但数学上等效的组合形式,研究者将采集函数的最大化任务重新定义为组合优化问题,从而能够从领域大量文献中获益。他们特别强调了 3,958 个单独实验中采集函数最大化组合方法的实证优势,这些实验包括组合优化任务和贝叶斯任务。

鉴于采集函数最大化方法的通用性,研究者认为采用组合优化器有可能在当前贝叶斯优化应用的所有领域内实现性能提升。

![]()

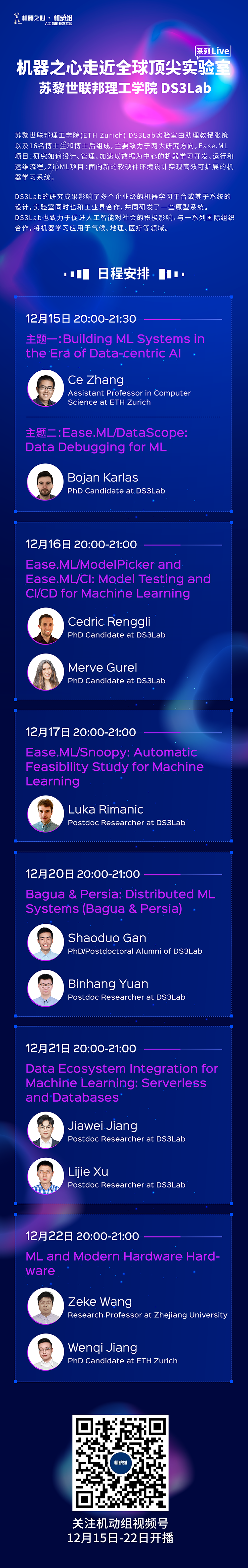

苏黎世联邦理工DS3Lab:构建以数据为中心的机器学习系统

苏黎世联邦理工学院(ETH Zurich) DS3Lab实验室由助理教授张策以及16名博士生和博士后组成,主要致力于两大研究方向,Ease.ML项目:研究如何设计、管理、加速以数据为中心的机器学习开发、运行和运维流程,ZipML项目:面向新的软硬件环境设计实现高效可扩展的机器学习系统。

12月15日-12月22日

,来自苏黎世联邦理工学院DS3Lab实验室的11位嘉宾将带来6期分享:构建以数据为中心的机器学习系统,详情如下:

![]()

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com