【优博微展2019】李志泽:简单快速的机器学习优化方法

简单快速的机器学习优化方法

Simple and Fast Optimization Methods for Machine Learning

作 者:李志泽

指导教师:李建

培养院系:交叉信息研究院

学 科:计算机科学与技术

读博感言:自强不息,宁静致远

机器学习被广泛应用于现实生活中,比如图像分类、语音识别、语言翻译、视频预测、自动驾驶等。它通常是从数据集中学习和总结规律然后对新的数据进行预测,即让计算机具备自动学习的能力去解决相关任务。机器问题通常被建模为凸优化问题(比如逻辑回归和支持向量机)或非凸优化问题(比如深度神经网络),因此设计更快的优化算法变得越来越重要。论文针对凸优化和非凸优化中的几个重要开放问题设计了几种简单高效的优化算法。论文结果具有重要的理论意义和应用价值。

优化问题一般被表示成最小化一个目标函数f(x)。在机器学习中,目标函数f(x)通常是数据集在训练模型上的损失函数。求解目标通常是找到一组模型参数使得损失函数足够小,即拟合数据集。求解方法(即优化算法)通常是经典的梯度下降方法的各种变种。

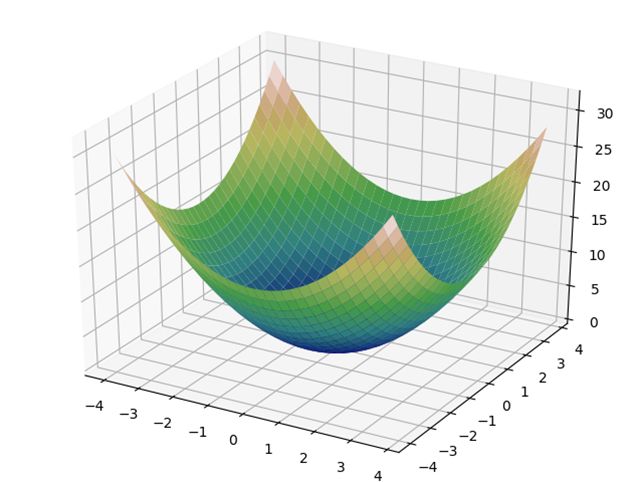

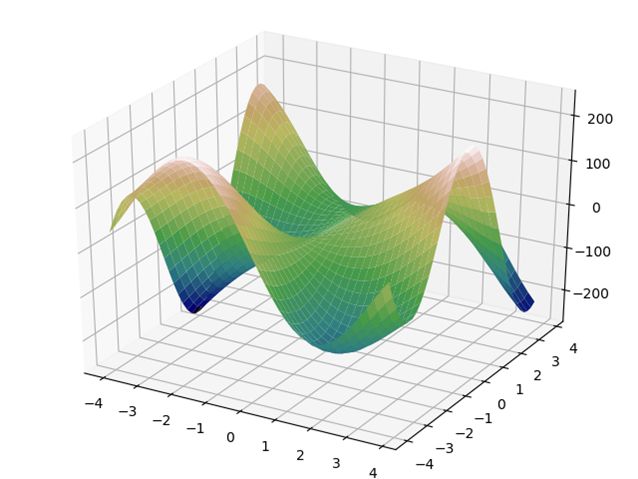

本文不仅系统地研究了目标函数f(x)是凸函数的情形(如图1),也研究了更一般更难的非凸情形(如图2)。论文设计的几个优化算法不仅是理论上最优或几乎最优,而且算法足够简单易于实际应用于求解各种机器学习问题。

1. 对于凸优化问题,论文提出了第一个统一的最优算法。该算法可以直接加速非强凸的一般凸问题而不需要添加额外的强凸正则项间接求解。

2. 对于更一般的非光滑非凸优化问题,论文提出了第一个比全梯度下降算法更好的常数批尺寸的随机梯度算法。此外还证明了它可以自适应非凸目标函数的局部结构来加速到线性收敛率。

3. 对于非凸优化问题中的鞍点,论文提出了一个几乎最优的随机算法来逃离鞍点和局部最大值,进而能够收敛到局部最小值。

1. Zhize Li. SSRGD: Simple Stochastic Recursive Gradient Descent for Escaping Saddle Points. arXiv:1904.09265, 2019.

2. Guanghui Lan, Zhize Li, and Yi Zhou (alphabetical order). A Unified Variance-Reduced Accelerated Gradient Method for Convex Optimization. arXiv:1905.12412, 2019.

3. Rong Ge, Zhize Li, Weiyao Wang, Xiang Wang (alphabetical order). Stabilized SVRG: Simple Variance Reduction for Nonconvex Optimization. In COLT 2019.

4. Zhize Li, Jian Li. A Simple Proximal Stochastic Gradient Method for Nonsmooth Nonconvex Optimization. In NeurIPS 2018 (spotlight).

5. Zhize Li, Jian Li, Hongwei Huo. Optimal In-Place Suffix Sorting. In SPIRE 2018 (invited). A short version in DCC 2018.

转载须经作者同意授权