最新关于NLP中的扩散模型综述

这篇综述文章全面回顾了扩散模型在自然语言处理(NLP)中的使用情况。扩散模型是一类数学模型,旨在捕获信息或信号在网络或流形中的扩散。在NLP中,扩散模型已被用于各种应用,如自然语言生成、情感分析、主题建模和机器翻译。本文讨论了在NLP中使用的不同形式的扩散模型,它们的优点和限制,以及它们的应用。我们还对扩散模型和其他生成模型进行了详细的比较,特别强调了自回归(AR)模型,同时也研究了不同的架构如何结合Transformers模型和扩散模型。与AR模型相比,扩散模型在并行生成、文本插值、诸如语法结构和语义内容的标记级控制,以及鲁棒性方面具有显著的优势。进一步探索如何将Transformers模型整合到扩散模型中的可能组合将是有价值的追求。此外,开发多模态扩散模型和大规模扩散语言模型,对于少样本学习具有显著能力,将是推动NLP中扩散模型未来进步的重要方向。

扩散模型(Sohl-Dickstein等人,2015b;Ho等人,2020;Song等人,2020)在图像生成中展示了显著的性能,并在人工智能领域引起了巨大关注。研究者们也将这些模型应用到自然语言处理(NLP)领域,并刚开始探索它们在该领域的生成能力(图1)。迄今为止,扩散模型已被应用到了各种生成性NLP任务中,如无条件的文本生成、可控的文本生成、机器翻译和文本简化。

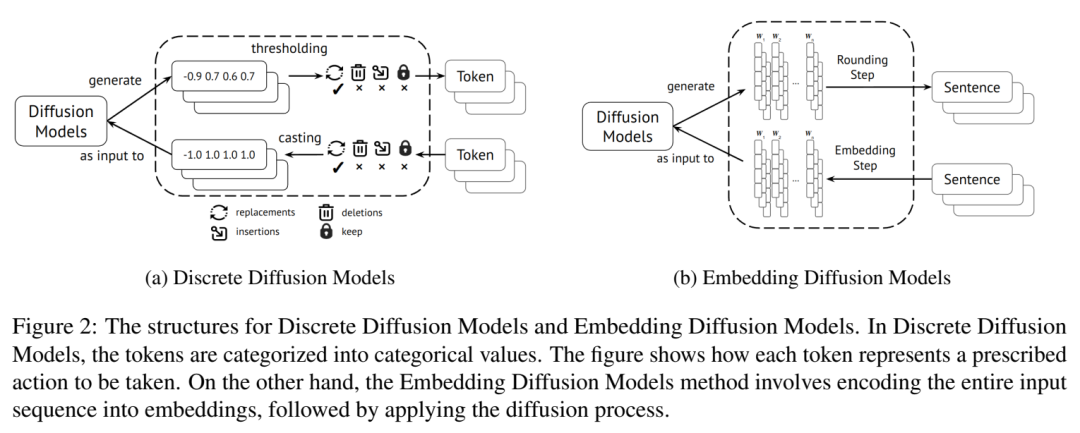

将扩散模型融入NLP的主要挑战在于文本的离散性,这与扩散模型所在的连续空间形成了对比。为了应对这个挑战,研究者们对模型进行了改进,我们将其分类为两种方法:

• 基于类别分布构建的离散扩散模型。这种方法通过在标记级别污染和精炼句子,将扩散过程推广到离散域。 • 嵌入式扩散模型将离散文本编码到连续空间并执行高斯噪声。作为这种方法的一部分,可以分别在正向和反向过程中使用额外的嵌入和舍入步骤,将标记转换为嵌入。

在接下来的部分中,我们首先在第2节介绍了原生扩散模型的一般框架以及用于离散状态空间的改进架构。在第3节中,我们根据已提出的特定标准,将调查的架构分类为两种前述方法(离散扩散模型与嵌入扩散模型)。在第4节中,我们对NLP领域的扩散模型与其他生成模型进行了详细的比较分析。根据实证证据,我们强调了扩散模型相较于自回归(AR)模型的优势,特别是在并行生成、文本插值、标记级控制和鲁棒性方面。此外,我们探索了各种调查架构如何将Transformers模型与NLP的扩散模型结合。我们在第5节中突出了为NLP中的扩散模型提出的算法和技术。最后,在第6节中,我们讨论了那些既及时又值得探索的潜在未来方向。

2. 通用框架

传统上,扩散模型主要专注于连续状态空间,但最近的进步已将其应用扩展到离散状态空间。离散扩散模型操作离散变量,如文本或分类数据,这些都呈现出独特的特性和挑战。一个关键的区别在于噪声的处理。连续扩散模型使用加性高斯噪声,而离散扩散模型引入离散扰动或变换来修改离散状态。这使得能够探索不同的状态并增强样本多样性。过渡概率在连续和离散扩散模型之间也有所不同。连续模型使用随机微分方程,而离散模型使用条件分布定义过渡概率。这些分布捕获当前状态和先前状态之间的依赖关系,促进信息传播并指导离散状态空间中的扩散过程。

去噪扩散概率模型(Denoising Diffusion Probabilistic Models,DDPMs)最初由(Sohl-Dickstein等人,2015a)提出,并由(Ho等人,2020)加以改进。DDPMs采用两步过程:添加高斯噪声并执行反向过程以恢复原始数据。 (Ho等人,2020)开发了具有嵌入函数的DDPMs,该函数将离散文本映射到连续空间,达到了与像生成对抗网络(Generative Adversarial Networks,GANs)这样的最新生成模型相媲美的结果。后续的工作(Song等人,2020; Dhariwal和Nichol,2021; Nichol和Dhariwal,2021; Rombach等人,2021)进一步提高了DDPMs的质量和效率。

3. 扩散模型 NLP应用

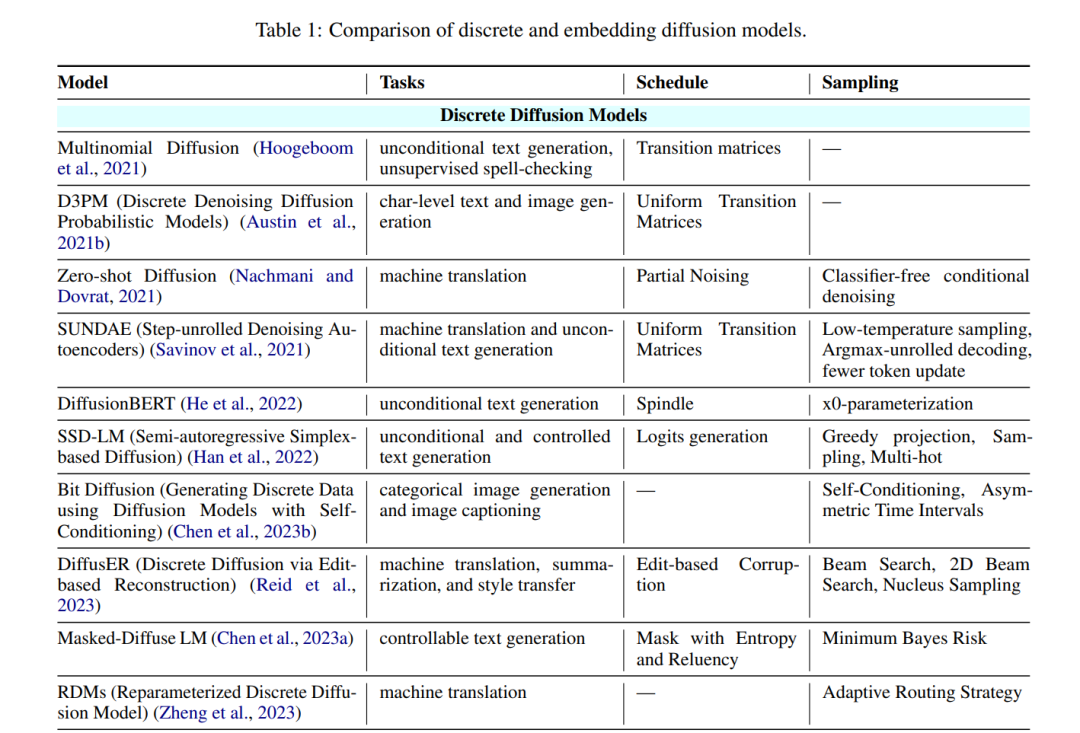

我们根据他们适应文本领域的扩散过程的方法,对自然语言处理中的扩散模型进行了几项研究,并将它们分为两类:离散扩散模型和嵌入扩散模型(图2)。前者直接在离散输入空间中操作,而后者涉及将离散输入提升到连续空间。对于每个类别,我们根据以下几个标准将扩散模型分类为多视角分类:(1)它们应用的任务,(ii)正向过程中的调度方法,以及(iii)用于反向过程的采样方法。我们注意到,“调度”列中的Reluency表示通过tf-idf权重衡量一个句子中词语w的相关性的语言特性。熵是一个用于衡量词语w中含有的信息量H的度量,以反映该词的重要性。表1显示了分类。

3.1 离散扩散模型

在离散扩散过程中,数据通过在离散值之间切换来产生混淆。离散扩散模型通过在令牌级别损坏和优化句子,将扩散模型扩展到离散状态空间。多项式扩散(Hoogeboom等人,2021)引入了一个专为非序数离散数据设计的基于扩散的生成模型。它通过将数据扩散到均匀的类别分布来实现这一点,有效地捕捉基础结构,同时保持控制的随机性。该模型的过渡机制涉及独立决定是重新抽样还是保留值,重新抽样是从均匀的类别分布进行的。D3PMs(Austin等人,2021b)用马尔科夫过渡矩阵替换高斯噪声,以扩散现实世界的数据分布。它结合了各种类型的过渡矩阵,如高斯核,最近邻,和吸收状态,以扩展损坏过程。此外,D3PMs(Austin等人,2021b)引入了一个新的损失函数,将变分下界与辅助交叉熵损失相结合。与连续扩散不同,D3PMs(Austin等人,2021b)通过选择公式7中的Qt,可以精确控制数据的损坏和去噪过程,超越了加性高斯噪声的使用。 Zero-Shot Diffusion (Nachmani和Dovrat,2021)利用带有基于时间的位置编码的编码器-解码器架构进行神经机器翻译。它使用一个Transformer编码器处理源语言句子,以及一个Transformer解码器来处理噪声目标句子。值得注意的是,这项工作首次使用扩散模型进行条件文本生成。Bit Diffusion (Chen等人,2023b)将离散数据编码为二进制位,并训练一个将这些二进制位视为实数的连续扩散模型。它首先引入了自我调整技术,大大提高了样本质量,并被广泛应用于后续的工作(Strudel等人,2023;Dieleman等人,2022;Yuan等人,2022)。

SUNDAE (Savinov等人,2021)提出了步骤展开的文本生成,并且是第一个在机器翻译和无条件文本生成中都显示出强大结果的非自回归方法。DiffusER (Reid等人,2023)采用二维束搜索和基于编辑的文本生成。系统将任务分为编辑标记和生成,而不是采用纯粹的端到端方法。它生成一个编辑序列,将随机噪声分布转化为高质量的输出。

DiffusionBERT (He等人,2022)通过逆序训练BERT,将扩散模型与预训练语言模型(PLMs) (Devlin等人,2018;Lewis等人,2019;Raffel等人,2019;Brown等人,2020;Qiu等人,2020)结合起来。它引入了一个新的噪声调度方案,用于前向扩散过程,并将时间步长并入BERT (Devlin等人,2018)。通过包含时间步长,DiffusionBERT捕获了在扩散过程中丢失的时间信息,提高了反向过程的准确性。

SSD-LM (Han等人,2022)因两个关键特性而引人注目。首先,它是半自回归的,能够在解码过程中迭代生成文本块并动态调整长度。其次,它是基于单纯形的,直接在自然词汇空间上应用扩散,而不是在学习得到的潜在空间中。这种方法方便地结合了分类器指导和模块化控制,无需对现有的分类器进行修改。

Masked-Diffuse LM (Chen等人,2023a)采用受语言特性指导的策略性软掩蔽,来损坏离散和连续的文本数据。它通过预测类别分布来迭代地去噪数据。通过软掩蔽逐渐引入扰动,遵循先易后难的生成方法,增强了文本生成的结构连贯性、整体质量和灵活性。这项开创性的工作利用语言特性有效地损坏和恢复输入文本数据,提高了生成过程。

RDMs (Zheng等人,2023)为离散扩散模型引入了一种新的重新参数化技术。它采用一种随机路由机制,为每个令牌决定是去噪还是噪声重置。路由器通过给所有令牌分配等概率,确保了均匀的处理。这种重新参数化简化了训练并使采样更加灵活。

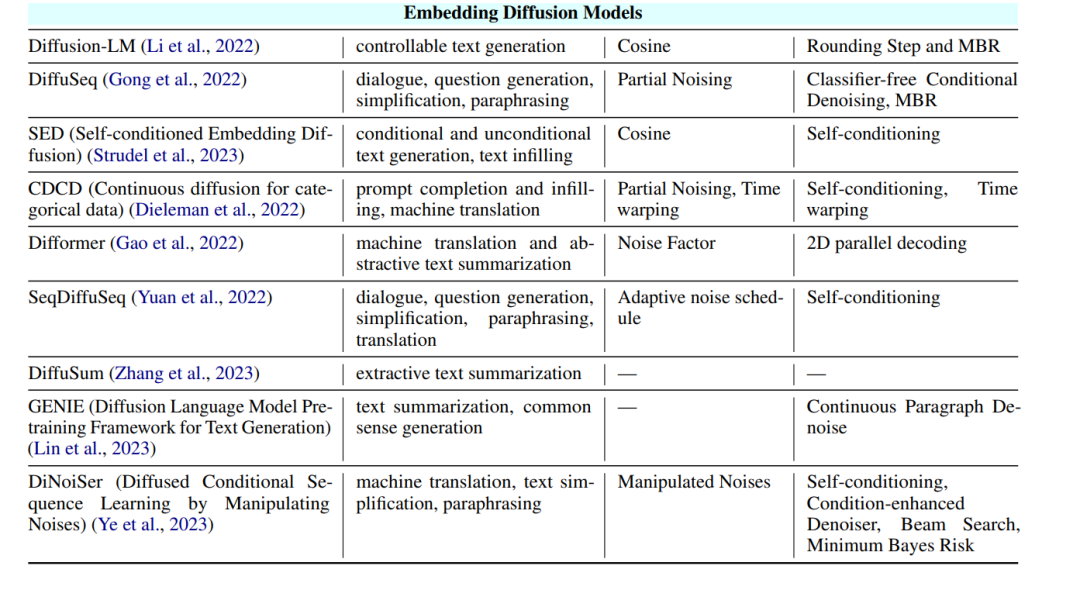

3.2 嵌入扩散模型

近期的研究(Li等人,2022;Gong等人,2022;Strudel等人,2023)利用扩散过程生成离散令牌的连续表示(嵌入),这被称为嵌入扩散模型。Diffusion-LM(Li等人,2022)在连续的词嵌入空间上构建扩散模型,并结合辅助损失,共同学习嵌入和网络参数。DiffuSeq(Gong等人,2022)专注于使用仅编码器的Transformer和部分噪声定义扩散过程并学习去噪函数的序列到序列生成。SED(Strudel等人,2023)基于Diffusion-LM的建模和目标,引入了一个自我调节机制,增强了基线性能。值得注意的是,它成功地扩展到大型文本数据集,如C4(Raffel等人,2019)。Difformer(Gao等人,2022)解决了将连续扩散模型应用到离散文本生成中的挑战,包括解决去噪目标崩溃,嵌入规模失衡和训练过程中的噪声不足的问题。它引入了三个关键组件:一个锚损失函数,嵌入的层归一化,以及增加的噪声因子,以增强添加的噪声的规模。 3.3 离散扩散模型 vs 嵌入扩散模型

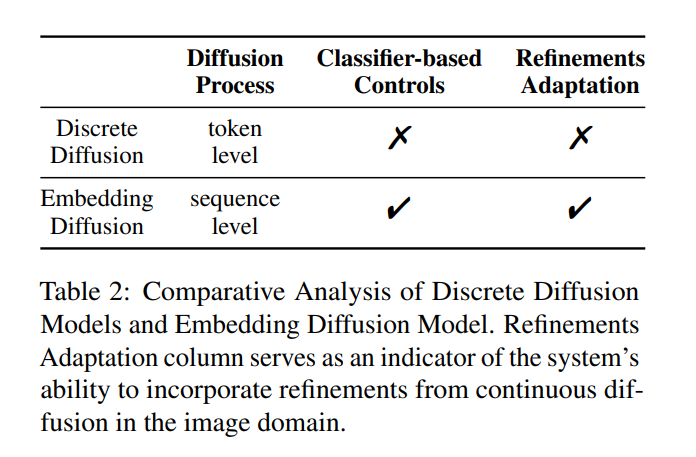

在表2中,我们总结了嵌入扩散模型相对于离散扩散模型的优点: • 扩散过程:嵌入扩散模型将离散输入转化为连续空间,使得在中间时间步可以表示多个结果,这在捕获语言建模中的令牌级别的不确定性中尤为关键。相比之下,在离散输入空间中运作的去噪模型缺乏这种能力,被限制在特定的令牌。 • 基于分类器的控制:嵌入扩散模型可以集成基于分类器的指导,通过利用分类器的额外信息指导采样过程,提高生成样本的质量。相比之下,离散扩散模型缺乏这种能力,从而限制了它们生成高质量样本的能力。 • Refinements适应:Strudel等人(2023)显示,离散扩散方法并未从图像处理领域的连续扩散方法的进步中获得优势。相反,嵌入扩散模型展示了利用这些精化的能力,使得它们在这个环境中更有优势和价值。

4 算法和技术

在这个部分,我们将重点介绍为自然语言处理中的扩散模型提出的算法和技术。这些方法主要有两种:(1)将模型适应到离散变量;(2)改善采样程序。图5描绘了从调查论文中提出的算法。

5 结论

本综述报告广泛讨论了自然语言处理中扩散模型的公式化、优点、局限性和应用。我们对扩散模型和其他生成模型进行了全面的比较,重点关注自回归(AR)模型。此外,我们还探讨了如何在各种架构中将Transformer结构与扩散模型相结合。我们的研究结果表明,扩散模型在与AR模型的比较中有显著的优势。它们在并行生成方面表现出色,能够更快、更有效地生成文本。扩散模型在句子插值、令牌级控制和对输入破坏的鲁棒性方面也表现出优越的性能。进一步研究将Transformer集成到扩散模型中,以及为少数样本学习开发多模态和大规模扩散语言模型是至关重要的。

总的来说,这篇综述报告对自然语言处理中的扩散模型进行了全面的概述,强调了它们的好处,与AR模型的比较分析,以及未来研究的途径。我们希望这篇报告能有助于理解和推进自然语言处理领域的扩散模型的发展。