主题: Why Batch Norm Causes Exploding Gradients

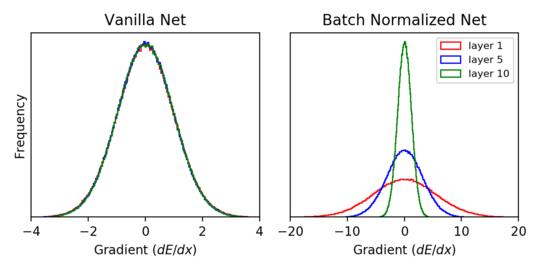

摘要: 深度学习从业人员知道,使用Batch Norm通常可以更轻松地训练深层网络。他们还知道爆炸梯度的存在通常会使训练深层网络变得更加困难。因此,Yang等人最近的工作。一切似乎令人惊讶;他们表明,我们钟爱的Batch Norm实际上至少在初始化时会导致爆炸梯度。在这篇文章中,作者将为梯度爆炸现象提供更直观的解释。通过一些“包络线”计算(当然,还有一个大包络),我们可以在简化的设置中显示,通过批归一化,梯度范数在ReLU网络的每一层中以π/(π-1)增长。

成为VIP会员查看完整内容

相关内容

专知会员服务

44+阅读 · 2020年6月29日

专知会员服务

19+阅读 · 2020年6月29日

Arxiv

5+阅读 · 2019年2月7日

Arxiv

8+阅读 · 2018年11月21日