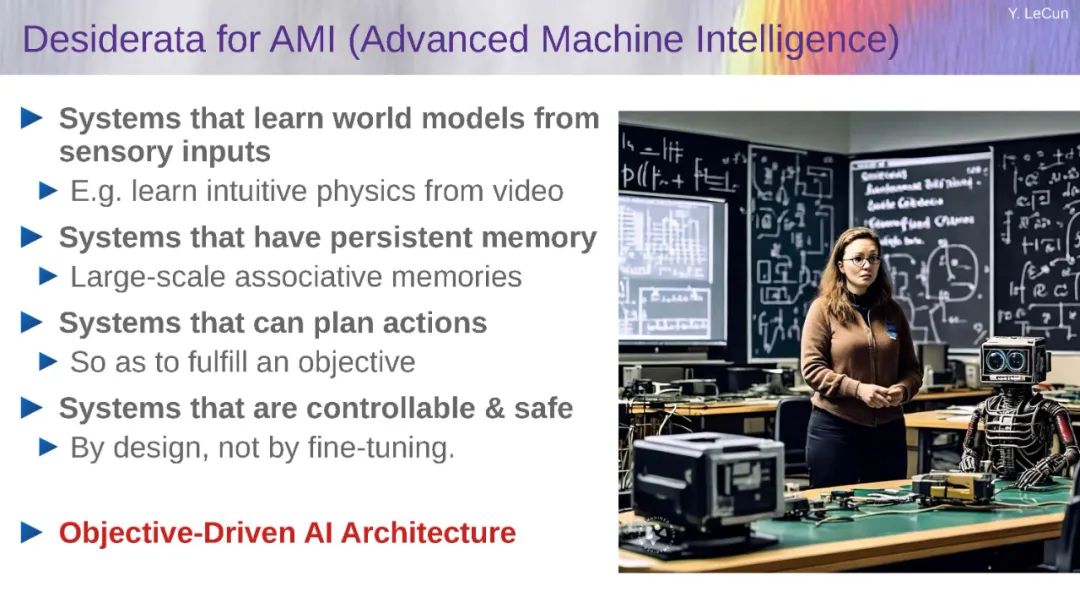

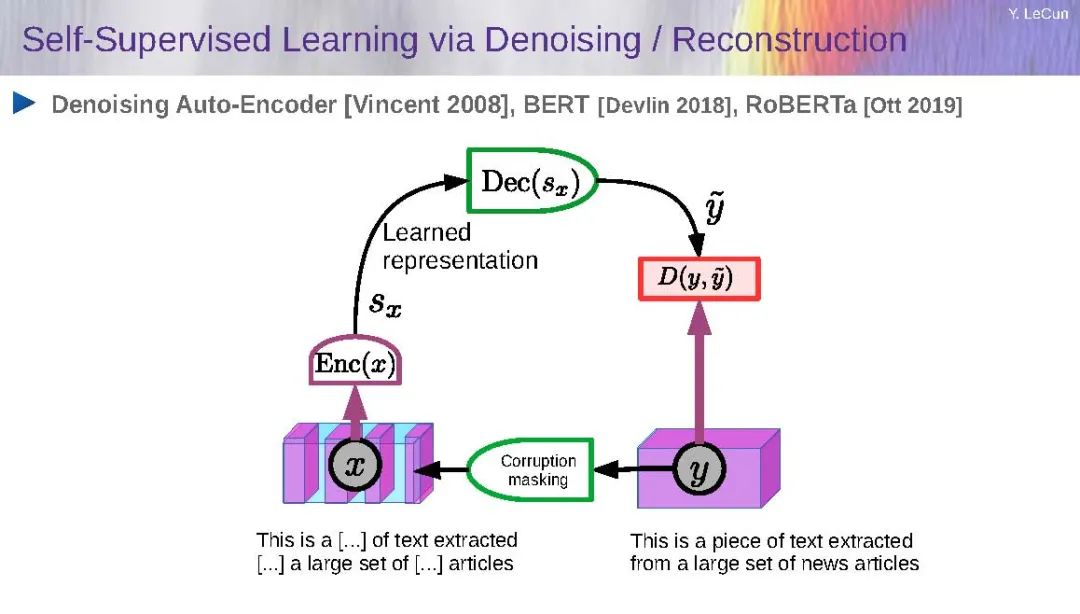

如何使机器像人类和动物一样高效地学习?如何让机器了解世界运作方式并获得常识?如何使机器学会推理和计划?当前的AI架构,比如自回归大型语言模型,在这方面存在不足。我将提出一种模块化的认知架构,可能构成回答这些问题的途径。该架构的核心是一个预测性世界模型,该模型允许系统预测其行动的后果,并规划一系列行动来优化一组目标。这些目标包括确保系统可控性和安全性的保障措施。世界模型采用了一种层次化联合嵌入预测架构(H-JEPA),通过自监督学习进行训练。JEPA学习感知的抽象表示,这些表示同时最大限度地提供信息且最大限度地可预测。相关的工作论文可在此处获得:https://openreview.net/forum?id=BZ5a1r-kVsf

成为VIP会员查看完整内容

相关内容

杨立昆(法语:Yann Le Cun,英语:Yann LeCun,1960年7月8日-)(原中文译名:扬·勒丘恩)是一位计算机科学家,他在机器学习、计算机视觉、移动机器人和计算神经科学等领域都有很多贡献。他最著名的工作是在光学字符识别和计算机视觉上使用卷积神经网络 (CNN),他也被称为卷积网络之父。他同Léon Bottou和Patrick Haffner等人一起创建了DjVu图像压缩技术。他同Léon Bottou一起开发了Lush语言。

Arxiv

42+阅读 · 2023年4月19日

Arxiv

86+阅读 · 2023年4月4日

Arxiv

152+阅读 · 2023年3月29日