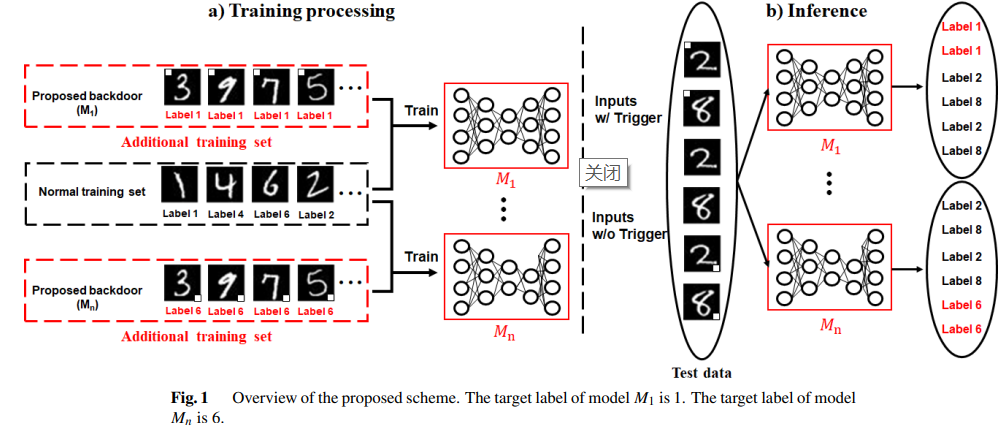

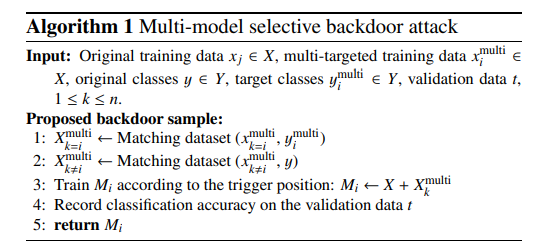

深度神经网络在图像识别、语音识别和模式分析方面表现出良好的性能。然而,深度神经网络显示出弱点,其中之一是容易受到后门攻击。后门攻击对包含特定触发器的后门样本进行目标模型的额外训练,因此没有触发器的正常数据将被模型正确分类,但包含特定触发器的后门样本将被模型错误地分类。关于这种后门攻击的各种研究已经进行。然而,现有的后门攻击会导致一个分类器的错误分类。在某些情况下,可能需要在有多个模型的环境中对特定模型进行选择性的后门攻击。在本文中,我们提出了一种多模型的选择性后门攻击方法,根据触发器的位置,误导每个模型将样本误分到不同的类别。本研究的实验使用MNIST和Fashion-MNIST作为数据集,TensorFlow作为机器学习库。结果显示,所提出的方案对每个模型的平均攻击成功率为100%,同时对MNIST和Fashion-MNIST的原始样本分别保持97.1%和90.9%的准确性。

成为VIP会员查看完整内容

相关内容

Arxiv

15+阅读 · 2018年5月24日