本报告定义了用于分析战场压力下卷积神经网络模型形式的二维(图像)分类器的方法。在此背景下,战场压力被定义为那些改变了传感器数据相对于用于训练神经网络图像的压力。战场压力可以是有意的,如伪装或扭曲,也可以是无意的,如遮蔽物或过度的背景(或前景)杂乱。首先描述了进行分析所需的部分,然后是用于对神经网络分类器进行排名和评级的方法步骤,报告最后以一个实际的分析案例作为结束。

在过去十年中,在深度神经网络和卷积分类方法的发现推动下,二维分类系统取得了巨大的进展。这一进展得到了开发自动驾驶车辆的推动。自主驾驶车辆已经被部署在某些驾驶环境中,但由于分类错误的严重后果,一直远离人口稠密的环境。

一旦意识到这些分类错误,研究人员已经分析了其原因,甚至研究了对分类系统的有意攻击。其中一种攻击被称为对抗性攻击,即待分类图像中的关键像素被改变以故意误导分类系统。针对这些攻击的缓解技术已经被提出。对抗性攻击是在 "微观"(像素)层面上进行的,其目的是为了让普通人的眼睛无法察觉。

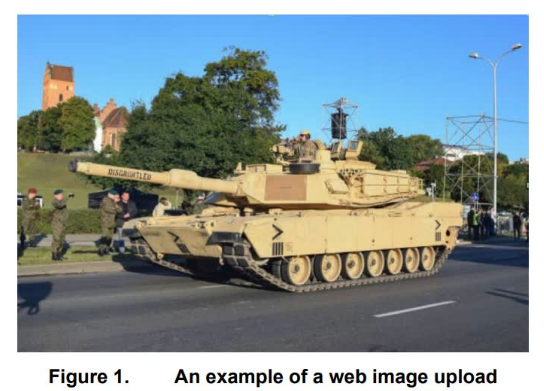

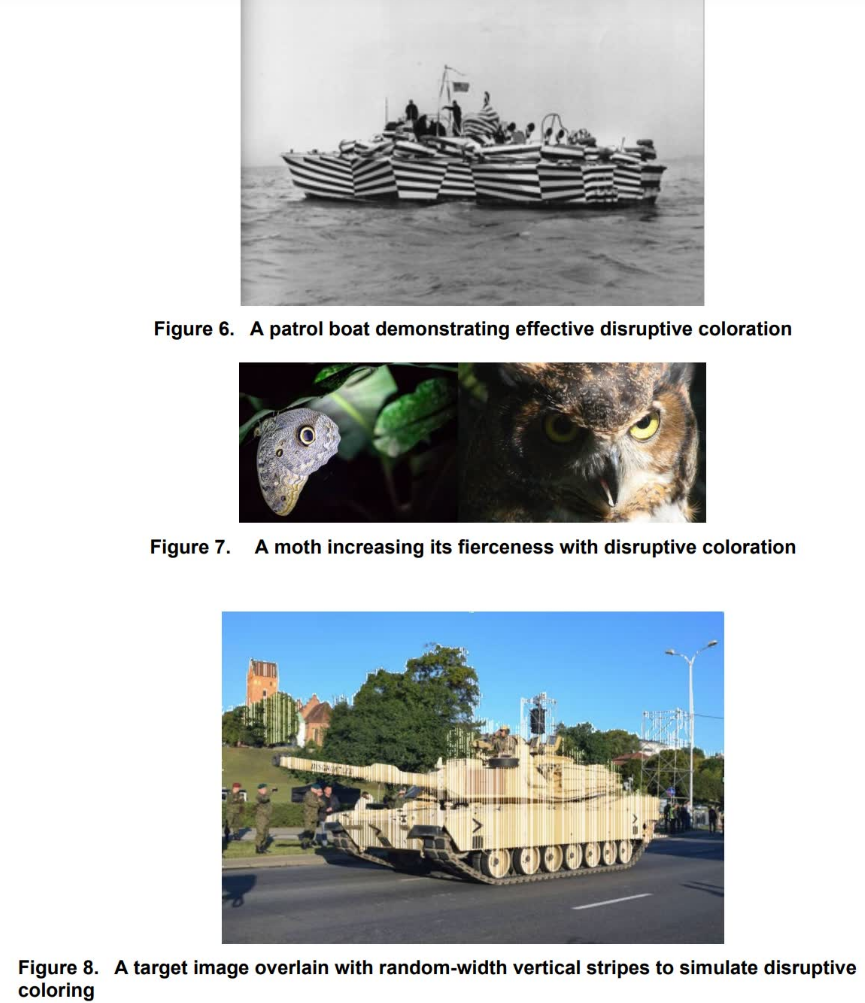

本研究没有分析这种类型的微观攻击,而是着眼于"宏观"攻击对神经网络模型分类器的影响。这些宏观攻击是非常明显的,如目标伪装、破坏性着色、故意扭曲和船体消隐等。这些是在战场环境中会出现的分类系统攻击,被称为战场压力。由于宏观攻击的复杂性和可变性,我们进行了一个 "黑箱 "分析,以确定暴露在战场压力下的卷积神经网络(CNN)的稳健性。用于开发这个分析框架的神经网络是已发布的、经过预训练的神经网络模型,使用转移学习法对感兴趣的分类类别进行了微调。同样的神经网络也是从中立的权重和偏差中训练出来的,它们的稳健性用包含战场压力的测试图像进行测试。

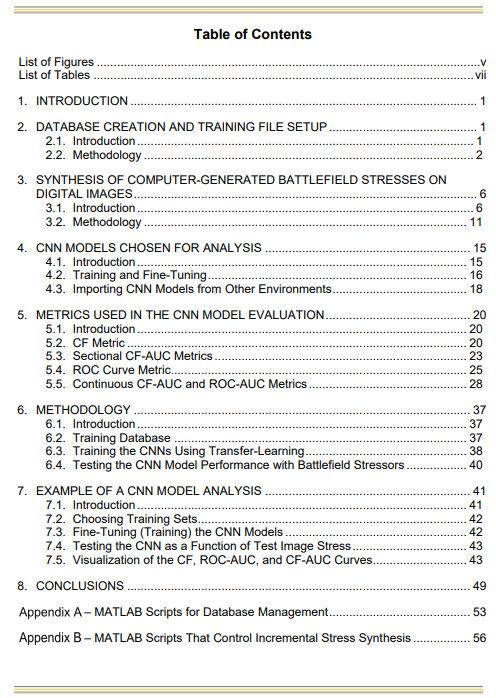

本报告的结构如下。第2节描述了用于训练和测试被测卷积神经网络模型的图像数据库。第3节描述了所使用的不同的战场压力,它们是如何被合成的,以及它们是如何被逐步添加到用于测试神经网络的图像中的。第4节描述了用于本报告所述分析的预训练的CNN模型的选择。第5节描述了用于针对战场压力对不同神经网络进行评级的指标。第6节和第7节提供了关于从网上下载的微调预训练神经网络的方法和分析实例。报告的最后是对所做工作的总结,随后是为进行分析而编写的所有MATLAB脚本的附录。