随着深度学习系统对数据和计算资源的快速需求,越来越多的算法利用协同机器学习技术,例如联邦学习,在多个参与者之间训练一个共享的深度模型。它可以有效地利用每个参与者的资源,获得一个更强大的学习系统。然而,这些系统中的完整性和隐私威胁极大地阻碍了协同学习的应用。在不同的协同学习系统中,为了保持模型的完整性和减少训练数据在训练阶段的隐私泄露,已经提出了大量的工作。与现有的主要针对某一特定协同学习系统的调研查相比,本调研旨在对协同学习中的安全和隐私研究进行系统、全面的综述。我们的调研首先提供了协同学习的系统概述,然后简要介绍了完整性和隐私威胁。然后,我们将以一种有组织的方式详细介绍现有的完整性和隐私攻击以及它们的防御。我们还列出了这一领域的一些开放问题,并将GitHub上的相关论文开源: https://github.com/csl-cqu/awesome-secure-collebrativelearning-papers。

深度学习在计算机视觉、自然语言处理、生物信息学和桌面游戏程序等多个领域都取得了巨大的成功。DL系统采用深度神经网络(DNNs),通过对庞大的训练数据集[1]-[4]的经验自动改进。为了有效地训练DL模型,学习系统主要依赖于两个组件:大量高质量的训练样本和高性能的GPU。但是由于各种原因,训练数据集和GPU可能分布在不同的地方。考虑以下两个例子[5]-[7]:医学图像分类。一家医院想要学习一种肺癌探测器模型,以帮助医生从他们的计算机断层扫描(CT)图像中识别肺癌患者。由于医院接收的肺癌患者数量有限,学习一个高度准确的模型对医院来说是困难的。为了保证诊断的准确性,医院联合其他医院共同协同学习共享模型。考虑到患者的隐私,所有医院都需要局部保留CT图像。

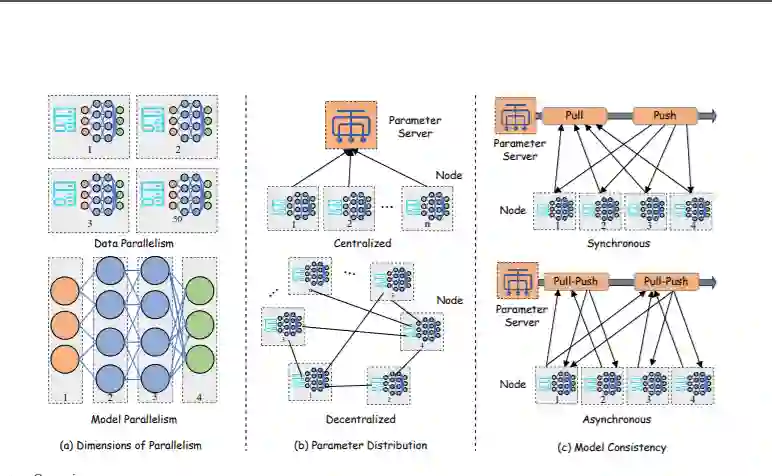

最近,协同学习作为一种很有前途的解决方案在[8]-[14]这样的应用场景中很受欢迎。具体来说,协同学习允许两个或更多参与者协作训练一个共享的全局DL模型,同时保持他们的训练数据集在本地。每个参与者在自己的训练数据上训练共享模型,并与其他参与者交换和更新模型参数。协同学习可以提高共享模型的训练速度和性能,同时保护参与者的训练数据集的隐私。因此,对于训练数据敏感的场景(如医疗记录、个人身份信息等),它是一种很有前途的技术。已经提出了几种用于协同学习的学习架构:有或没有中央服务器,有不同的模型聚合方式,等等[15]-[22]。协同学习的一个重要分支是[23]联邦学习,它使手机能够协同学习一个共享的预测模型,同时将所有的训练数据保存在设备上,将机器学习的能力与将数据存储在云端的需求分离开来。

虽然每个参与者在本地存储训练数据集,并且每次迭代时只共享全局模型的更新,但对手也可以在训练过程中进行破坏模型完整性和数据隐私的攻击,即[24]-[27]。最严重的威胁之一是模型完整性,当一些参与者不值得信任[28],[29]时,很容易损害模型完整性。例如,恶意参与者用一些精心设计的恶意触发器毒害他们的训练数据集。然后,在每次迭代中,利用触发器生成恶意更新,并通过共享恶意更新,逐步将后门等触发器注入到全局模型中,以获取额外利润或增加自身优势[30],[31]。敌人也可以伪装成参与者加入协同学习过程,并通过向其邻居或参数服务器[25]、[32]、[33]发送恶意更新来破坏学习过程。Blanchard et al.[28]和Guo et al.[29]表明,只有一个恶意参与者能够控制整个协同学习过程。

除了模型完整性威胁,另一个关键的挑战是保护每个参与者的数据隐私。研究表明,尽管参与者不与他人共享原始训练样本,但共享更新是由样本生成的,并间接泄露了训练数据集的信息。例如,Melis et al.[34]发现,在训练过程中,可以从共享梯度中捕获成员和意外特征泄漏。更严重的是,Zhu等人[26]提出了一种优化方法,可以从相应的更新中重构出训练样本。针对上述完整性和隐私威胁,提出了多种方法来防御[24]、[26]、[28]、[35]-[48]、[48]、[49]、[49]-[66]。例如,为了实现byzantine弹性协同学习,Blanchard et al.[28]在每次迭代中使用统计工具检查参与者的更新,并在聚合更新时放弃潜在的恶意更新。在隐私保护方面,Gao等[67]提出了搜索保护隐私的变换函数,并使用保护隐私的变换函数对训练样本进行预处理,以抵御重构攻击,同时保持训练后DL模型的准确性。一些防御[68]-[72]也提出了健壮的和隐私保护的防御方法来防御完整性和隐私威胁。

在这篇论文中,我们关注在协同学习的训练过程中的完整性和隐私攻击和防御,并提出了一个最新的解决方案的全面综述。具体来说,我们从不同的角度系统地介绍了不同类型的协同学习系统(第二节)。然后,我们在第三节中总结总结了协同学习中的隐私和完整性威胁。一方面,我们在第四节和第五节分别展示了现有的攻击和相应的防御。另一方面,我们在第五节中分别展示了最先进的完整性隐私攻击和相应的防御。我们总结了混合防御方法来实现鲁棒和隐私保护的协同学习和对抗训练算法来提高模型推理的鲁棒性。我们在第IX节阐述了协同学习中一些开放的问题和未来的解决方案,然后在第X节中总结了这篇文章。我们还在GitHub上开源了论文的攻防方法列表:https://github.com/csl-cqu/awesome-securecollebrative-learning-papers。