CVPR2022 | 医学图像分析中基于频率注入的后门攻击

本工作由京东探索研究院和西北工业大学联合完成,已经被CVPR2022接收。在本文中我们提出了一个基于频域信息注入的后门攻击方法(Frequency-Injection based Backdoor Attack,FIBA)。具体来说,我们设计了一个频域触发器,通过线性组合两幅图像的振幅谱图,将触发器图像的低频信息注入有毒图像。由于 FIBA 保留了受污染图像像素的语义,因此既可以对分类模型进行攻击,也可以对密集预测模型进行攻击。我们在医学图像领域的三个基准上进行了实验(用于皮肤病变分类的 ISIC-2019数据集,用于肾脏肿瘤分割的 KiTS-19 数据集,以及用于内镜伪像检测的 EAD-2019 数据集),以验证 FIBA 攻击医学图像分析模型的有效性以及其在绕过后门防御方面的优势。

01

研究背景

近年来,人工智能系统的安全性引起了越来越多的研究关注,特别是在医学成像领域。为了开发安全的医学图像分析(Medical Image Analysis,MIA)系统,对可能存在的后门攻击(backdoor attack, BAs) 的研究不可缺少。后门攻击的目标是在模型训练时嵌入一个隐藏后门,在测试阶段对于良性的测试样本后门不激活, 模型表现正常;然而,一旦后门被有毒样本中的触发器激活,预测结果将会改变为攻击者预期的特定目标标签。

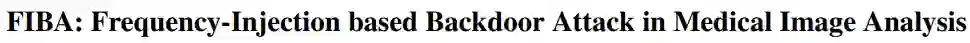

然而,由于医学图像成像模式(如x线、CT和MRI图像)和分析任务(如分类、检测和分割)的多样性,设计一种适用于各种MIA系统的统一的后门攻击方法颇具挑战性。现有的后门攻击方法大多是针对自然图像分类模型进行攻击,将时域触发器直接应用于训练图像[1,2,3],不可避免地会破坏受污染图像部分像素的语义(如图1所示),导致对密集预测模型的攻击失败。

视觉心理物理学[4,5]证明,视觉皮层的模型是基于根据傅里叶频谱(振幅和相位)进行的图像分解。其中振幅谱图可以捕捉低层次的分布,而相位谱可以捕捉高层次的语义信息[6]。此外,据观察,振幅谱图的变化并不对高层次语义的感知没有显著影响[6,7]. 基于这些富有洞察力和启发性的观察,我们提出了一种新的隐形频率注入后门攻击(FIBA)范式,其中触发器是在图像的振幅谱图中注入,而相位谱图的信息则保持不变。由于所提出的触发器被注入到振幅谱图中而不影响相位谱图,所以FIBA通过保留空间布局,保护了中毒像素的语义,因此能够攻击分类和密集预测模型。

图 1 不同后门攻击方法的可视化对比

02

方法介绍

1、算法概述

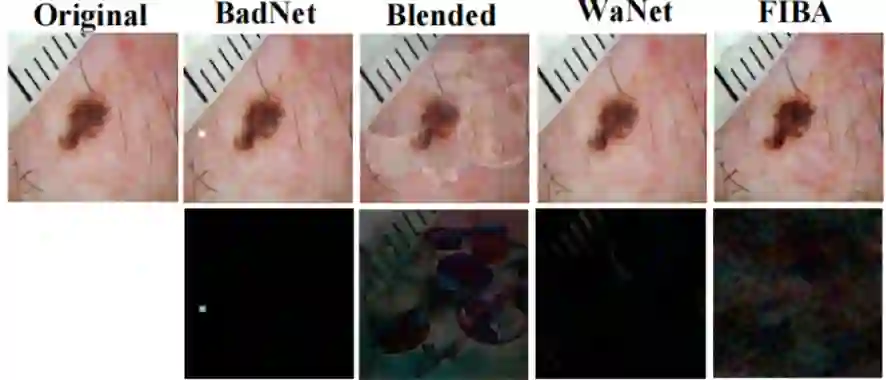

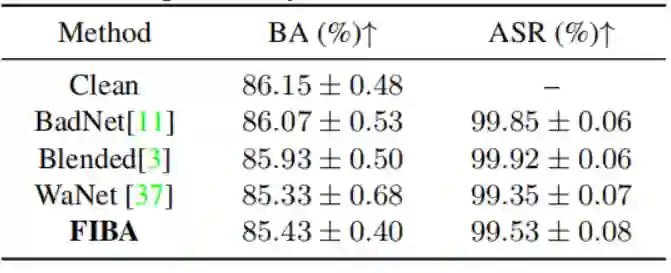

具体来说,给定一个触发器图像和一个良性图像,我们首先采用快速傅里叶变换(FFT)来获得两个图像的振幅谱图和相位谱图。然后,我们保持良性图像的相位谱不变,以保证隐蔽性,同时通过混合两幅图像的振幅谱合成一个新的振幅谱图。最后,通过对良性图像的合成振幅谱图和原始相位谱图应用反傅里叶变换(iFFT),得到中毒图像。但是,我们也注意到如果有来自同一域的其他伪触发器图像,也是有可能激活模型中的后门。为了解决这个问题,受到[3]的启发,我们还利用伪触发器鲁棒后门训练机制来保证触发器图像的唯一性。

图 2 基于频率注入的后门攻击(FIBA)框架

2、算法详述

如图2(a)所示,给定一个良性图像

相对应的

我们将触发器图像的振幅谱图

并和良性图像的相位谱图

获得了中毒图像之后,我们可以利用良性图像和中毒图像,通过两种模式(干净模式和攻击模式)训练模型并嵌入后门:

其中

如图1(b)所示,在训练过程中,我们在每一个batch中通过

03

实验结果

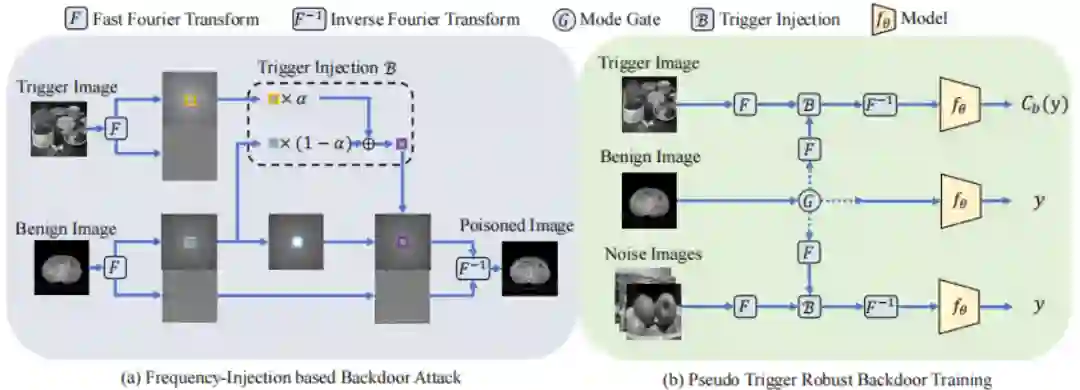

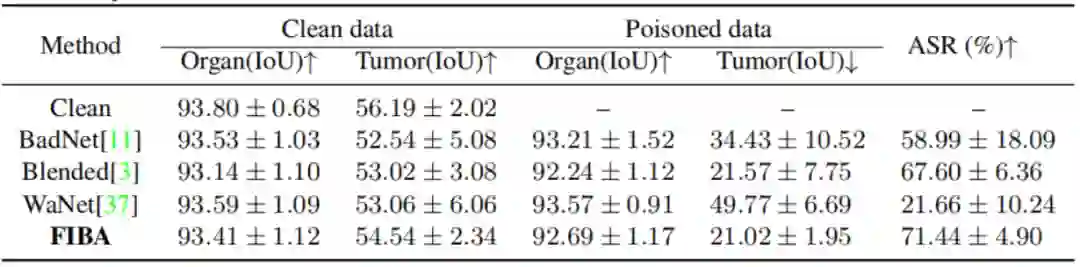

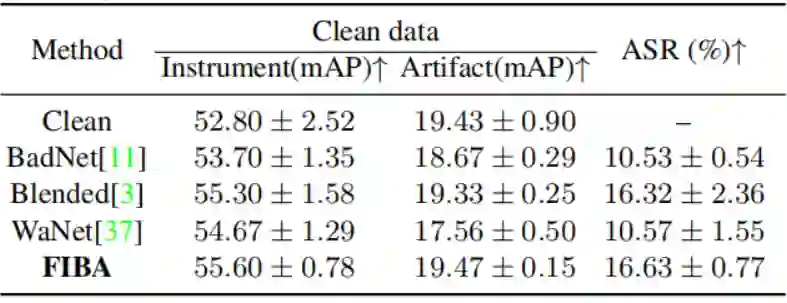

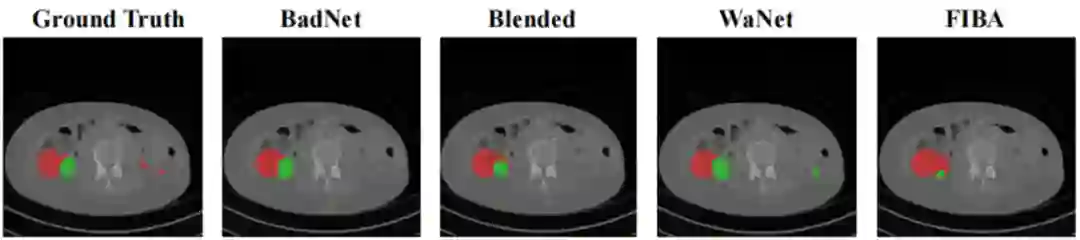

我们分别在用于皮肤病变分类的ISIC-2019数据集,用于肾脏肿瘤分割的KiTS-19数据集,以及用于内镜伪影检测的EAD-2019 数据集上进行实验。实验使用Attack Success Rate (ASR)来衡量攻击效果,即中毒样本被成功预测为特定目标类别的比例(分类任务上体现在样本层次,分割任务体现在像素层次,检测任务上体现在边界框层次)。在皮肤癌分类任务中,不难看出FIBA方法优于同样隐性的攻击方法WaNet。虽然显性的攻击方法BadNet和Blended攻击方法略微取得了比FIBA更好的攻击效果,但是后续实验中发现FIBA在隐蔽性和对于防御方法的抵抗性上更胜一筹。此外在分割和检测任务上,FIBA的表现均优于其他的方法。图3可视化展示了不同攻击方法对于分割任务的影响。

表 1 对ISIC-2019不同后门攻击方法的实验结果对比

表 2 对KiTS-19不同后门攻击方法的实验结果对比

表 3 表 4 对EAD-2019不同后门攻击方法的实验结果对比

图 3 KiTS-19数据集在不同攻击下中毒样本的分割结果可视化。红色代表肾脏,绿色代表肿瘤

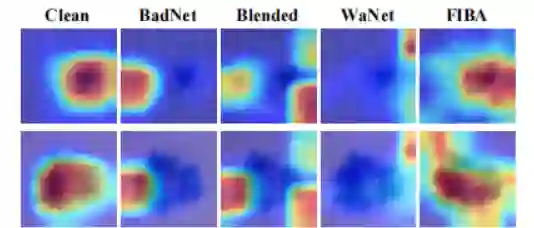

在图4中,我们使用Grad-CAM[8]对中毒样本进行分析,以评估不同攻击方法对于模型行为的影响。GradCAM能够成功识别BadNet、Blended和WaNet生成的异常触发区域。然而,由于FIBA在频域注入触发器,它没有在特定的空间区域引入异常激活,与Clean模型具有相似的行为。

图 4 使用Grad-CAM对干净和中毒模型在不同攻击下进行可视化分析

04

结论

我们在医学图像分析领域引入了一种名为FIBA的新型后门攻击方法。FIBA在频域的振幅谱图中注入触发器。它通过保持相位信息保留了中毒图像像素的语义,使得它能够向分类和密集预测模型提供攻击。在三个有代表性的医学图像分析任务上进行的广泛实验证明了FIBA的有效性,以及它在攻击性能和对各种防御技术的抵抗力方面优于最先进的方法。

在现实生活中,当医院将患者数据委托给第三方进行模型培训或在联邦学习框架下进行时,可能会发生后门攻击,这可能会导致误诊或漏诊。我们的研究指出了在医学图像分析领域的深度学习模型在后门攻击下的弱点,通过促进相应的模型防御研究,有助于开发更安全的人工智能系统。从这个意义上说,我们认为我们的工作对开发值得信赖的人工智能技术的未来研究有积极的影响。

论文链接:https://www.zhuanzhi.ai/paper/10e04e678441bb521d7a56a32dc1dd9f

代码链接: https://github.com/HazardFY/FIBA

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“FIBA” 就可以获取《CVPR2022 | 医学图像分析中基于频率注入的后门攻击》专知下载链接