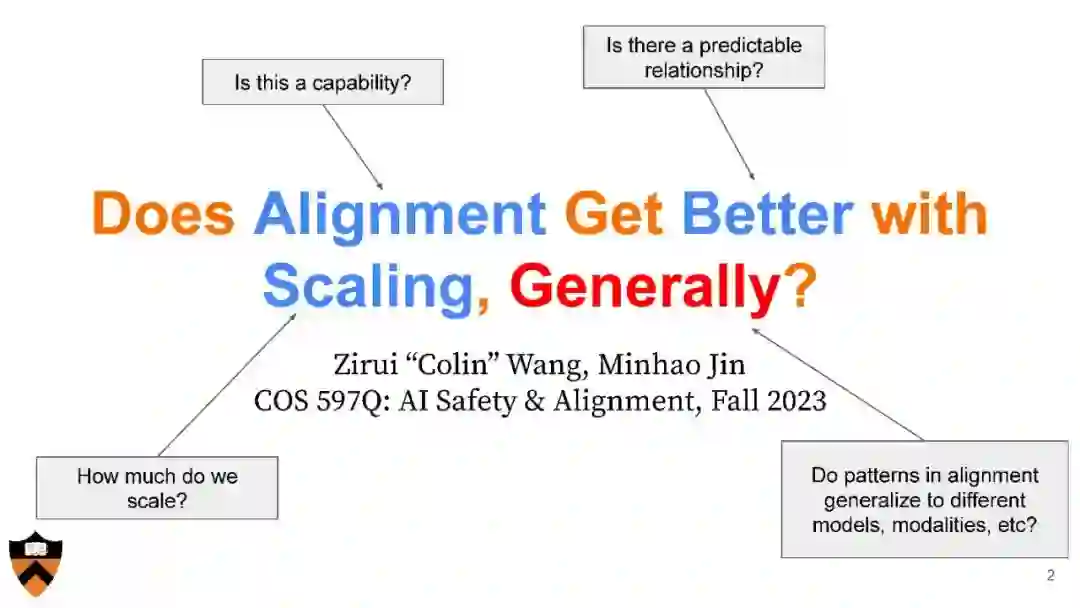

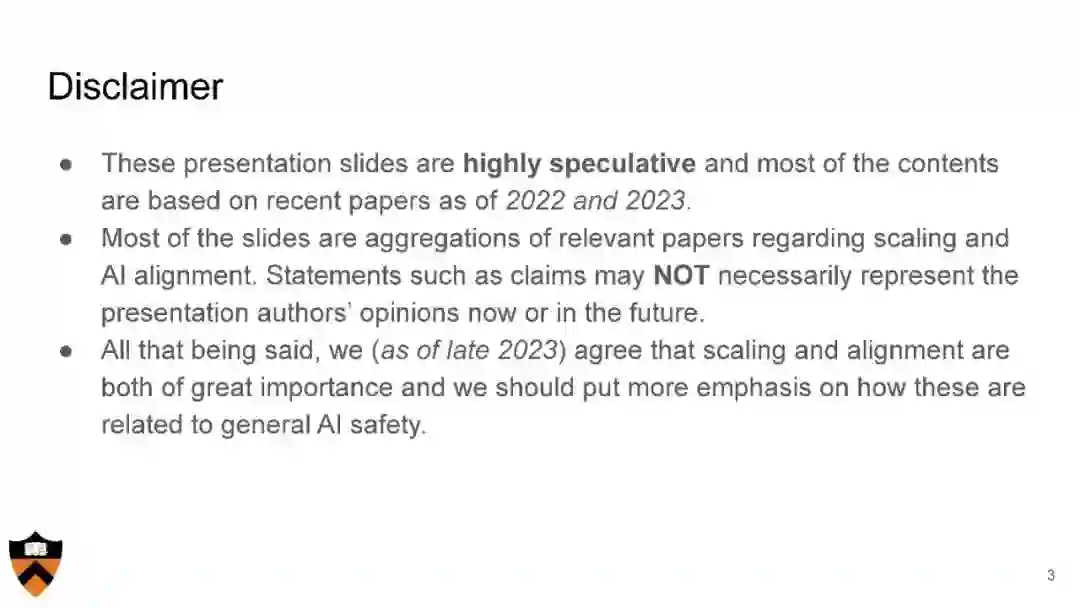

现代AI系统和方法带来了哪些存在性和社会风险?我们如何缓解这些风险,确保AI系统安全且与其构建者的意图保持一致?目前正在采取哪些措施以确保AI系统的安全性?当前的安全保障措施是否足够,如果不足,我们又该如何改进? 这些是我们将在本高级研讨会中考虑的问题。将考虑来自多个学科的多样化主题,包括用于对齐的算法和优化方法、应用于AI的身心问题、责任与自由选择问题、AI突破预测的经济影响等。 本课程的主题不包括AI公平性,因为这一重要主题已在其他课程中涵盖。

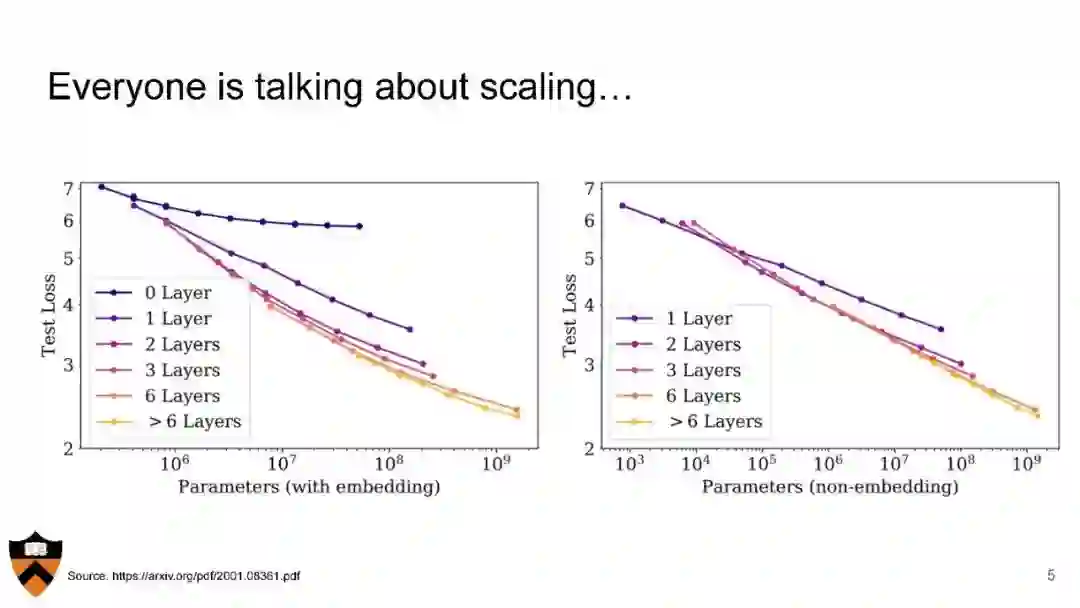

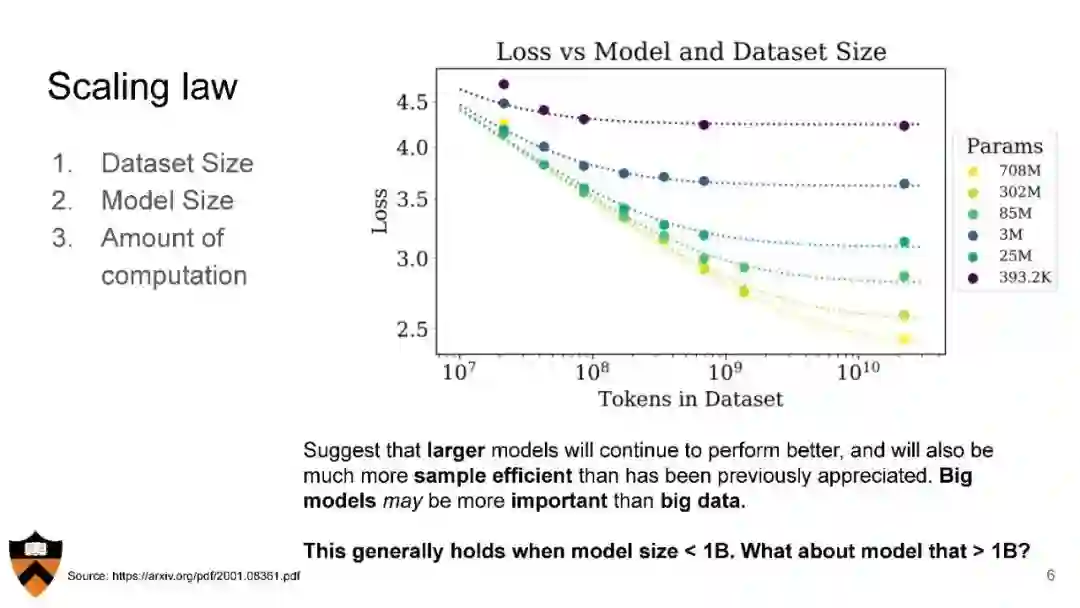

课程将呈现AI对齐和安全领域领先思想家的讲座,以及学生对讲师选定阅读材料的演讲。 这是一门高级研究生课程,面向所有研究生和本科生开放,尽管预期需要在机器学习/人工智能方面有广泛的准备(需要COS 324或等同课程)。 引言 能力与扩展 奖励与目标 理解与匹配伦理 对抗性攻击与红队操作 对齐的博弈论方法 可解释性 人工通用智能(AGI)的经济影响 AGI在黑客/计算机安全方面的影响 对AI风险的批评

https://sites.google.com/view/cos598aisafety/home?authuser=0

成为VIP会员查看完整内容

相关内容

Arxiv

153+阅读 · 2023年3月29日