论文题目: Dynamic graph representation learning via self-attention networks

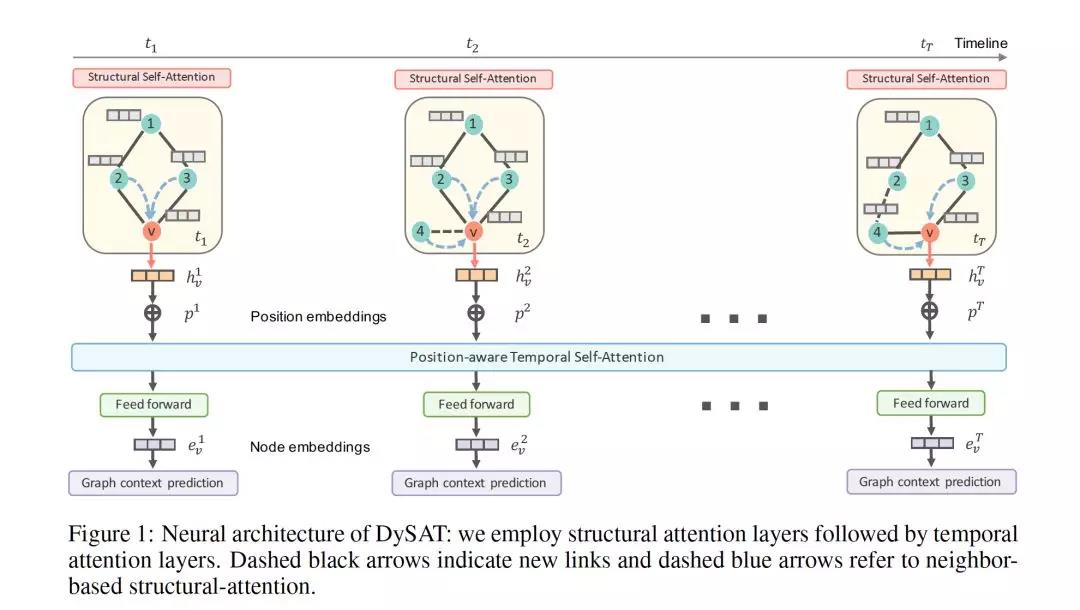

论文摘要: 学习图中节点的潜在表示是一项重要且普遍存在的任务,在链接预测、节点分类和图可视化等领域有着广泛的应用。以往的图表示学习方法主要集中在静态图上,而现实世界中的很多图都是动态的、随时间变化的。在这篇论文中,我们提出了Dynamic Self-Attention Network (DySAT),这是一种新型的神经架构,它操作在动态图上,并学习节点表示,以捕捉结构特性和时间演化模式。具体来说,DySAT通过在两个维度(结构邻域和时间动态)上联合使用self-attention层来计算节点表示。我们对两类图进行了链接预测实验:通信网络和二分评级网络。我们的实验结果表明,DySAT在几种不同的最先进的图嵌入baseline上有显著的性能提升。

作者简介: 武延宏,Visa Research的研究员。在加入Visa之前,他是IBM T.J.Watson研究中心的博士后研究员,负责金融领域的异常检测和分析。他还曾在Aviz | INRIA和Microsoft Research Asia担任访问学者,专注于大型图挖掘和可视化。他于2013年6月从香港理工大学获得博士学位,并于2013年6月在复旦大学软件学院获得学士学位。他的研究兴趣包括图形建模、深入学习和可视化分析。等

成为VIP会员查看完整内容

相关内容

专知会员服务

147+阅读 · 2019年12月16日

专知会员服务

74+阅读 · 2019年11月20日

Arxiv

7+阅读 · 2018年1月8日