与"半人马作战(centaur warfighting)"概念以及自主武器系统将取代人类作战人员的想法不同,本文提出,未来的有人-无人协同作战更可能是“牛头人”,即在人工智能控制、监督或指挥下的人类团队。它研究了未来部队的可能组成,并促使人们对牛头人作战引起的伦理问题进行必要的对话。

前言

人类将在未来的战争中扮演什么角色?对这个问题的一个有影响力的答案是,他们将与先进的机器合作,利用双方的独特能力。保罗-沙尔创造了 "半人马作战 "一词来描述有人-无人组队的使用,他认为相对于使用自主武器系统(AWS),它们拥有一些关键的优势。通过让人类控制、监督或指挥多个无人系统,人类的判断力和认知的灵活性可以与机器的反应速度、传感器、力量和功率相结合,从而胜过人类和机器单独作战。

半人马是一种神话中的生物,其头部和上身是人,下身是马。当被用来描述有人-无人团队时,半人马的形象促进了人类将领导团队的想法。我们概述了对有人-无人团队性质的另一种看法,这种看法更有可能在未来战争的关键作战领域实现。我们怀疑人工智能(AI)将指导多个人类的活动,而不是人类指挥多个机器人。未来的机器人士兵更有可能是牛头人--一种具有人的身体和牛的头的神话生物,而不是半人马:他们将有一个可怕的头而不是一个可怕的身体。

牛头人是思考人类参与战争未来的一个更好的形象,其原因与技术动态和道德要求有关。可以说,人工智能在执行与战争最相关的认知任务方面的能力已经超过了机器人在执行与战争最相关的人体功能方面的能力。此外,人工智能应用方面的进展比机器人应用方面的进展出现得更快。因此,在可预见的未来,在许多领域,当人类扮演执行角色时,用机器代替人类将比人类扮演涉及操纵物体或在杂乱环境中移动的角色更有说服力。事实上,将人类置于机器的控制、监督或指挥之下往往是一种道德上的需要。随着新技术的引入,军事行动的节奏加快,将战场指挥的一些功能转移给人工智能,将有助于防止友军交火事件,并提高人类作战人员的生存能力。

鉴于人工智能的发展速度,迫切需要考虑牛头人作战的影响,这既是为了未来作战部队的有效性,也是为了将越来越多地在机器的指导下进行战争的人类。本文讨论了推动我们走向由牛头人作战的未来因素,并开始了关于牛头人作战的伦理影响的对话。

半人马作战

沙尔在关于使用自主武器的影响和伦理的辩论中提出了半人马作战的想法。沙尔承认,完全自主的武器系统可能在未来的战争中发挥作用,但他认为,在大多数情况下,人类和机器的团队在单独运作时将胜过两者。机器人和人工智能程序在整合大量数据、快速反应和实施精确打击方面表现出色。但目前,在涉及到对作战至关重要的其他角色时,它们的能力不如人类。特别是,他认为,人工智能仍然难以在复杂和意外的情况下做出正确的决定,特别是在解决战争中经常出现的道德困境方面,行使必要的道德判断。由于这个原因,据沙尔说,在许多应用中,人类和机器人(或人工智能)组成的团队一起工作,在战斗和其他军事行动中,将胜过自主系统和人类的单独战斗。

半人马作战的想法具有很大的影响力,这体现在人们对现有武器系统运作的理解上,也体现在如何设计和使用机器人和人工智能来进行未来的战争的模式上。

沙尔本人用半人马的形象来分析美国反火箭、火炮和迫击炮系统(C-RAM)的运作,该系统自2010年以来一直在运行。该系统由一门雷达和计算机控制的高速加特林炮组成。它是高度自动化的,能够在没有人类监督的情况下攻击和摧毁目标。然而,目前的理论要求有一个人在回路中(意味着系统不能在没有人类操作员输入的情况下运行),以授权参与特定目标,以减少自相残杀的风险。Scharre将这种安排作为半人马作战的典范,应尽可能地加以模仿。他还指出,类似的系统只包括人类的 "循环"(意味着人类主管可以选择干预以改变系统的运作),并建议这种安排可能会变得越来越普遍,甚至是必要的,因为在更多的角色中使用自主系统而导致行动节奏加快。

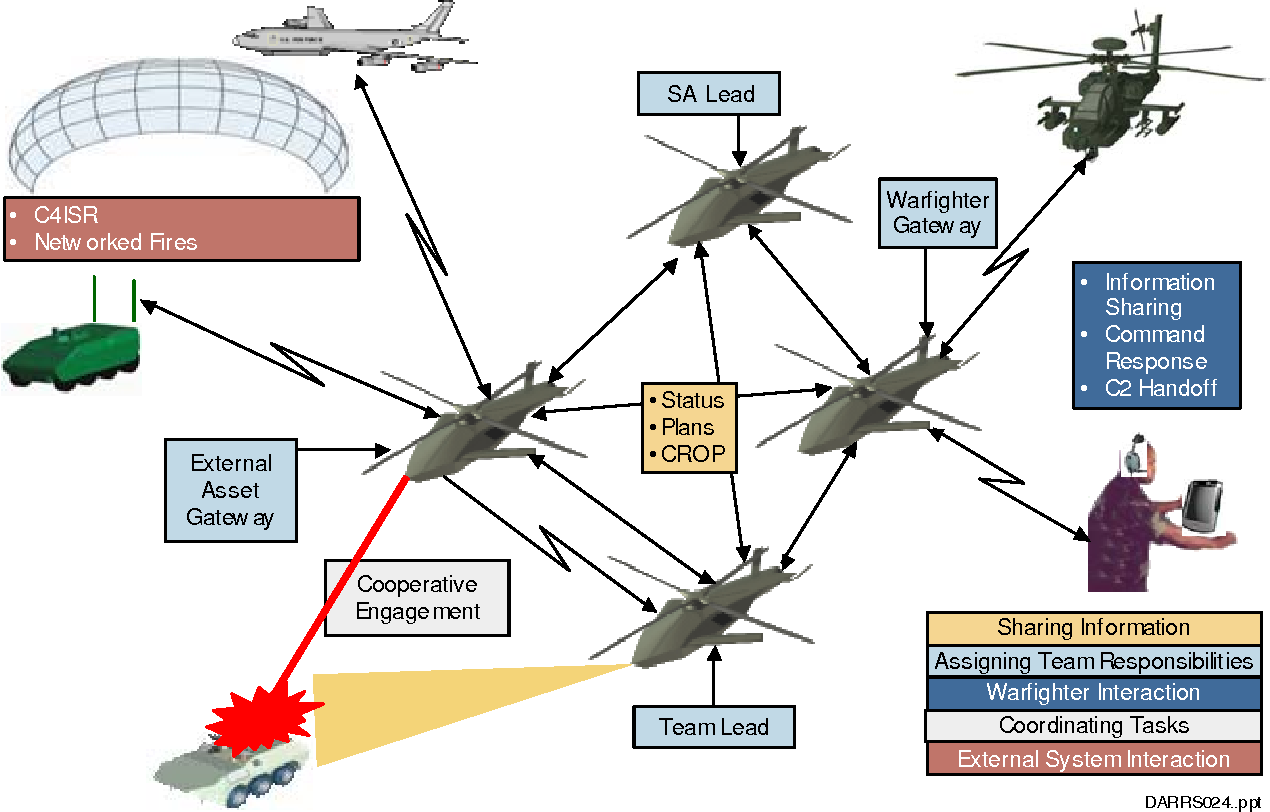

重要的是,半人马座作战可以作为目前正在开发的使用机器人和自主系统的未来行动模式。美国国防部无人系统综合路线图2017-2042声称,"未来的军事行动将需要无人系统和人类之间的协作",并强调了 "人机合作 "的重要性。人机协作(MUM-T)是美国陆军无人机系统2010-2035年路线图的一个关键目标,在美国海军的无人机运动框架中也占有重要地位。虽然有人-无人团队合作与团队中的机器和人类之间的一系列关系兼容,但文件中提供的背景和例子清楚地表明,这些有人-无人团队被想象成半人马。此外,无人系统的旗舰例子包括美国陆军的机器人战车-轻型,美国海军陆战队的远程操作地面部队的远征(ROGUE)-消防平台,美国空军的SkyBorg项目,以及澳大利亚皇家空军的Loyal Wingman项目(最近更名为MQ-28A Ghost Bat)。这些例子几乎都被宣传为提高人类作战人员的效率--也就是说,促进半人马作战。

人类在负责?

半人马的形象意味着,当人类与机器人或人工智能合作时,人类将负责团队的工作。准确地说,他们将如何负责仍然是开放的。Scharre通过使用人类在循环中和在循环中的例子来介绍半人马作战的想法。Scharre似乎允许半人马作战与人类只发挥较远的监督作用的情况兼容,尽管据推测,机器将需要保持在 "有意义的人类控制 "之下,以便在这种情况下谈论人类监督。Scharre对 "有人-无人小组 "中人类负责的含义做了慷慨的解释。即使在这种情况下,我们相信,与Scharre相反,许多人类和机器的合作将被更准确地描述为牛头人(无人驾驶的团队)而不是半人马(有人驾驶的-无人驾驶的团队),因为团队中的机器将有效地负责。

关键技术动态

人工智能发展的最初时期的特点是认为关键的挑战是创造出能够完成认知任务的机器--例如下棋、完成数学运算和处理大型数据集--我们觉得很难,并认为是智力成就的巅峰。例如,臭名昭著的是,被广泛认为是现代人工智能研究起点的达特茅斯夏季研讨会的原始拨款申请提出:将尝试寻找如何使机器使用语言,形成抽象和概念,解决现在留给人类的各种问题,并改进自己。我们认为,如果一个精心挑选的科学家小组在一个夏天共同研究这些问题,就可以在其中一个或多个问题上取得重大进展。

然而,很快就可以看出,真正的挑战在于其他方面。我们认为很容易的任务(而且我们认为这些任务不需要智力,因为儿童和动物与成人一样能很好地完成)对机器来说证明是困难的。现在,感知、运动和操纵被认为是人工智能和机器人学的难点。尽管过去十年来机器视觉取得了重大进展,但机器在非结构化环境中定位和识别物体的能力仍然有限,而灵巧的操纵仍然是一个关键的挑战。现实世界操作条件下的鲁棒性对机器人系统来说也是一个挑战,能源要求也是如此。在当前,令人震惊的是,人工智能研究的进展比机器人研究快得多。一般来说,人工智能的脑袋仍然比机器人的身体好。正如计算机科学家唐纳德-克努斯(Donald Knuth)所观察到的,"到目前为止,人工智能基本上已经成功地完成了所有需要'思考'的事情,但却未能完成人和动物'不需要思考'的大部分事情--这一点,不知为何,要难得多。" 鉴于体现在与物理世界的接触中所涉及的挑战程度,在可预见的未来,这种情况可能仍然存在。

人工智能和机器人技术的相对优势在许多民事应用中是显而易见的。今天,当人类和智能机器在工业领域的团队中一起工作时,机器往往执行脑力劳动,而人类则从事体力劳动。

也许牛头人最突出的民用例子是亚马逊的履行中心。这些中心的工人是由机器指挥和监督的。复杂的算法决定了哪些货物必须被运送,在哪里,以及如何运送,但人类必须收集和(有时)包装它们。机器通过手持设备告诉工人要收集什么,从哪里收集。因为仓库使用算法包装系统,它存储货物以尽量减少收集货物所需的时间,而不是在一个固定的位置,如果没有机器,人类就无法找到他们被要求收集的产品。越来越多的机器人化的叉车、托盘或存储单元将产品箱带到桌子上,人类在那里提升和包装货物或将它们放入另一台机器:人类因此沦为了机器的手。正如诺姆-谢伯在《纽约时报》上指出的,"[从工作中]不断剥离人类的判断力是自动化最普遍的后果之一--与其说是用机器人取代人,不如说是让人变得像机器人"。

另一个平民牛头人的例子是由长途卡车运输的演变提供的。卡车司机越来越多地收集和运送物品,并遵循算法物流系统分配给他们的路线。将数据传回给这些算法的传感器监测司机的速度、路线和驾驶表现。司机甚至可能因为各种违规行为而被自动处罚。自主系统不是由人类选择自主车辆行驶的目的地,而是指示人类何时、何地、如何行驶。这些人机团队的发展和繁荣,主要是因为它们在技术上比其他选择(如人类选择路线或机器驾驶)更可行,但也因为它们减少了道路死亡。

在讨论未来战争中的有人和无人合作时,人工智能和机器人的性能差异一直没有被充分认识到,因为无人系统在军事应用中的成功案例都是在空中领域操作(或攻击目标)的机器。与感知、导航和运动有关的问题对无人驾驶航空器来说是相对容易解决的,而与操纵和灵巧操作有关的问题则不会出现。如果考虑到无人系统在陆地战争中的核心任务的表现,情况就会非常不同。

城市环境、森林、泥地、雪地、冰地和沙地对机器人来说都极具挑战性。在战时安全地通过这些地形需要不断地判断物体和表面如何相互作用,选择最佳路线,其他友方和敌方单位的目标,以及其他代理的可用信息。虽然人类是凭直觉做出这些判断,而且往往是无意识的,但这种身体和感知的知识很难在算法中呈现。物理环境的非结构化和难处理的性质给机器人带来了深刻的挑战,这一点在涉及到在陆战中发挥关键作用的其他活动时更加明显。例如,运输和安放军械、设置防御工事或清理建筑物都需要人类。不过,机器可以通过整合多种来源的信息(如无人机、卫星、安装在武器或头盔上的摄像机的视频资料以及信号情报),越来越多地(近乎)实时识别敌方军事目标和人员,这项任务可能超过人类的能力,但现在已经在机器的能力范围之内。Scharre和其他人认为,机器可能很难考虑到对适用战争法很重要的背景线索,或作出确定适当目标所需的道德或战略判断。然而,在许多情况下,环境实际上会使机器作出这样的决定是可行的。例如,在一个特定的地区或交战中,所有的敌方潜艇、坦克或战斗机都可能是合法的目标,而现有的人工智能有能力将这些系统与民用物体区分开来,这是可信的。

对于人工智能和机器人技术在海战中的应用,也可以进行类似的观察。许多对舰艇操作至关重要的任务将很难实现自动化或分配给机器人,因为它们依赖于人类在复杂环境中识别、移动和操纵一系列不同物体的能力。特别是,在可预见的未来,人类将需要装载和维护武器以及维修发动机。然而,对海战至关重要的认知任务(如确定船只的最佳路线、控制防空系统、识别目标并确定其优先次序)似乎完全在现有或未来的人工智能能力范围之内。

将我们的注意力从天空转移到陆战和海战,突出了物理环境对机器操作构成的挑战,而我们离解决这些问题还很远,而我们离创造能够识别目标和为作战人员确定优先次序的人工智能还很远。

牛头人作战

牛头人团队在平民生活中的出现表明,牛头人在未来的军事行动中也将发挥一定的作用。至少,军事仓库和后勤可能会效仿民用模式,创建牛头人团队来执行关键职能。

谈到作战行动,牛头人的合理用例比比皆是。

尽管最近在一些功能的自动化方面取得了进展,但拖曳或驾驶、放置和装载军械需要多个人类。不过,识别、跟踪和确定目标的优先次序可以由机器完成。在所谓的以网络为中心的战争时代,进入敌人的 "观察-东方-决定-行动 "循环的最佳方式是让计算机分配目标,甚至是瞄准和发射武器。事实上,据报道,在目前与俄罗斯的战争中,乌克兰军方已经朝着这个方向采取了重大步骤。当人类拖拽和装载的武器被瞄准和发射到机器选择的目标时,我们就有了牛头人作战。

新兴技术也有可能将步兵小队变成牛头人。美国陆军的综合视觉增强系统将利用基于微软HoloLens的混合现实头盔为作战人员提供战术数据。美国陆军最近的一份 "信息请求 "提供了线索,说明其开发者预计人工智能将如何被用来扩展该系统的能力。这份文件将 "人工智能目标检测算法"、"机器辅助任务规划"、"人工智能战术预测 "和 "人工智能数字战场助理 "列为感兴趣的领域。虽然要求的措辞暗示人工智能将作为助理或顾问,但有充分的理由相信,人工智能不会长期局限于这些角色。

对人机交互(HCI)的研究表明,人们倾向于过度信任人工智能,尤其是当人工智能已经证明自己普遍可靠时--这种现象被称为自动化偏见。如果目标检测算法或战场助手表明某个特定的物体或人是一种威胁,那么作战人员不太可能否定人工智能,特别是考虑到综合视觉增强系统的前提是它有助于减少战争的迷雾。此外,如果人工智能可以利用来自多个平台和传感器的信息来制定威胁评估或任务目标,考虑到机器更好的有利条件,违背其建议行事可能是错误的。一旦人工智能的性能达到一定水平,主张自己的判断高于人工智能的判断的作战人员将把自己和周围人的生命置于危险之中;他们还将减损团队的作战效率。最终,人工智能的建议将在心理上,甚至在规范和制度上具有命令的力量,参与小单位战斗的作战人员将把大部分时间用于实现人工智能为他们设定的目标。

正如托马斯-亚当斯在20多年前所认为的那样,随着人工智能的影响加速了战斗的节奏,减少了人类的有效决策时间,军队除了将许多决策外包给人工智能之外,可能没有其他选择。不过,在可预见的未来,战争的成功起诉将涉及人类处理目前机器处理不好的平凡的物理和物质挑战。如果在未来,人工智能在一个有人-无人(或者更准确地说,无人-有人)的团队中通过选择目标和设定目标来完成认知工作,而人类在人工智能的指导下辛勤工作,我们将有一个牛头人而不是半人马。亚当斯确定的同样的动态表明,牛头人将在未来的战斗中战胜半人马,为军队采用牛头人作战创造了强大的动力。

最终的牛头人作战部队将由一队人类和机器人组成,由相当于将军的AI指挥。虽然还不可行,但从长远来看,这个想法没有表面上那么牵强。人工智能往往擅长游戏,包括战争游戏,因为人工智能可以从一个游戏的多次迭代的经验中学习。如果战争只是在屏幕上移动单位或根据一套复杂的规则使分数最大化,机器在指挥军事行动方面已经超过了人类。他们还没有做到这一点的原因是,在军事模拟中准确表现不同武器系统和军事单位的能力,以及行动所处的地形(包括人类地形)的承受力方面存在着困难。如果军事模拟的技术得到改进,使真实世界的行动能够在战争游戏中得到准确体现,那么就会为开发复杂的战争算法打开大门。最终,对胜利的追求可能需要将指挥权交给机器,而胜利可能由哪支部队拥有更好的人工智能决定。

同样值得注意的是,自动化偏见表明,目前人们认为的一些高度自动化系统是半人马,实际上是牛头人。如果 "在圈内 "的人不太可能反驳机器,那么有人-无人团队就是一个牛头人,而不是半人马。我们怀疑Phalanx近程武器系统和反火箭、火炮和迫击炮系统可能就是这种情况。

最后,认识到即使是所谓的 "自主 "系统也要依靠人类来装载、修理和维护它们,这表明许多自主武器系统应该被理解为牛头人的头,其人类支持团队是身体。

伦理影响

至关重要的是,军事政策制定者和更广泛的社会现在开始就牛头人作战的伦理问题进行对话,以准备或塑造未来。

牛头人作战有强大的伦理论据。牛头人作战很可能是为了响应避免自相残杀的道德要求而出现的。更具争议性的是,民间社会对作战人员的义务,以及指挥官对其部队的义务,即避免将友军暴露在不必要的风险中,也往往会成为支持牛头人作战的理由。通过迅速识别和确定目标的优先次序,牛头人将减少敌人使用武器的机会。最后,牛头人有可能在不远的将来击败半人马,这在伦理上是很突出的;如果我们为正义事业而战,就有强烈的伦理理由让我们派出尽可能强大的军事力量。

然而,牛头人作战也有一些令人深为不安的方面。事实上,在赋予机器超越人类的力量,以至于将它们送上战场被杀死的时候,牛头人作战预示着当代关于机器和人类之间关系的辩论中正在讨论的伦理问题,更普遍。

一个担心是,机器将不会充分关心,或以正确的方式关心,或者,也许根本不关心他们所指挥的人的生命。例如,人工智能将军可能会把人类当作炮灰,为更强大的无人驾驶系统扫清道路。在这里,重要的是要区分对机器会不必要地拿人的生命冒险的担忧和对它们拿人的生命冒险的担忧。前者实际上是对军事人工智能有效性的怀疑,最终应该由牛头人赢得战斗和减少(人类)作战人员的风险的证据来缓解。

人的生命不应该在机器的决定中受到威胁,这种担忧也出现在关于使用AWS的伦理的辩论中,可以用伊曼纽尔-康德的哲学来表达。康德坚持认为,人类应该始终被视为 "目的",而不是仅仅作为手段。与机器不同,人类有自由意志。康德认为,我们必须尊重对方的这种能力,避免将他人仅仅作为工具来推进我们的目的。我们很难看到机器如何表现出这样的尊重,也很容易担心牛头人作战会将人类沦为单纯的手段。

这种反对意见还有一个共和派的版本。根据这一传统,自由与法律是兼容的,而法律是追踪公民利益的审议过程的结果。不过,如果个人只能在强权的支配下按自己的意愿行事,那么他们就会被支配,在这个程度上,就不是自由。公民的平等自由要求他们不受制于主权者或其他公民的任意权力。人们很容易认为,机器行使权力总是任意的,因为机器不能参与构成商议的推理实践。

这两种反对意见都是有道理的。然而,要以一种不会招致回答的方式来表述这些反对意见是很困难的,因为当人类命令其他人类上战场时也存在类似的情况。当士兵入伍时,他们同意被用来为更大的目的服务,而且可以说,他们受制于上级的任意权力。虽然人们希望指挥官只以他们可以向下属证明其利益的方式来对待他们手下的人,但军事上的需要有时可能会有不同的要求。因此,机器指挥的伦理看起来与更普遍的指挥伦理没有什么区别。

然而,很难避免一种感觉,即授予机器权力让人类去送死是有问题的。人类的价值是机器无法比拟的。将人类置于机器的指挥之下,似乎表达了这样一种想法:机器比人类更重要,或者至少比人类更好。不出所料,这种直觉也出现在关于使用自主武器系统的伦理的辩论中,它在其中发挥了重要作用。

另一个问题是自主武器系统和牛头人都会出现的,它涉及到机器所做决定的责任归属问题。当父母得知他们的孩子在被机器送上战场后被杀时,他们可能想知道应该责备谁。如果有一天,让机器对 "它 "的行为承担道德责任是合适的,这仍然是一个激烈的哲学辩论的话题。我们猜测,对于悲伤的父母的问题,如果不是道德问题,也将最终作为一个法律问题来解决,即把对人工智能的决定和牛头人的行动的后果的责任分配给更高层次的人类。

这里指出的牛头人作战引起的伦理问题足以令人不安,而且随着牛头人队伍的使用推广,无疑会出现更多问题。然而,在军事背景下,牛头人的理由--他们将赢得战斗并拯救友军的生命--是非常强大的。出于这个原因,我们的分析表明,正如新技术通常的情况一样,对牛头人作战进行全面考虑的伦理评估需要解决康德和后果主义直觉之间的冲突。

像我们用来理解世界的许多区别一样,半人马和牛头人之间的对比无疑是过度的。在现实中,当人类和机器一起工作时,他们之间会有一系列的关系。即使在特定的团队中,一些任务将更多地委托给人类,而另一些则委托给机器人或AI。然而,牛头人的形象提醒我们,这种谈判不会总是有利于人类。

同样,就军事是一个系统的系统而言,人类和机器之间的特定合作是半人马还是牛头人,将是分析水平的一个函数。如果我们以一种方式画出团队周围的边界,那么这个系统看起来就像一个牛头人,如果我们以另一种方式画出它,它就可能是一个半人马。因此,如果人工智能战场助手发展成为人工智能班长,人们希望人类官员能指挥他们。如果指挥国家军队的将军是一个人工智能,人们就会认为国家的文职领导层会制定人工智能的战争目标。然而,认识到在某些分析层面上,机器将负责,有助于我们理解不同形式的有人-无人团队合作的优势和局限。正如我们所论证的,当人们承认一些人类实际上是在机器的指挥下,即使这些机器反过来是在人类的指挥下,伦理问题也会显得非常不同。

思考

牛头人作战将在关键的作战领域得到发展,因为无人驾驶团队的表现将超过有人-无人驾驶团队或单独操作的人类或自主武器系统。在这种新兴的有人-无人团队作战模式中,人类和机器之间的关系的性质提出了深刻的伦理问题。我们还预计,牛头人作战的发展对那些毕生都在磨练人类判断能力的人来说,在个人和体制上都是一种挑战,而这种能力目前在作战中发挥着核心作用。尽管牛头人带来了伦理和制度上的挑战,但那些负责赢得战争的人应该抵制牛头人作战的发展,这一点还不明确。

如果军队或社会确实决定将作战人员置于机器的控制、监督或指挥之下是一个太远的步骤,我们认为有三项任务--一项是技术,一项是伦理,一项是政治--需要作为紧急事项加以面对。

首先,必须投入大量的财政和智力资源来开发能够在非结构化环境中长期有效运行的机器人。这项任务的一个挑战是,在成功的同时,也要让把战争中涉及的关键认知任务交给人工智能更有说服力。一个真正的危险是,机器人应对物理环境的不确定性和复杂性所需的软件进步,只会进一步赋予人工智能战略和对军事力量行使作战控制权。

其次,必须澄清和加强作为不将人类置于机器指挥之下的道德和政治承诺的基础的直觉。这样做也有可能意味着自主武器系统的开发和应用比许多军事伦理学家和政策制定者所承认的问题更多。如果允许机器告诉人类该做什么在道德上是错误的,那么很难看到允许机器杀人在道德上是被允许的。

第三,国际社会必须考虑在国际法律上禁止在战争中或在战争的某些角色中使用牛头人团队是否可取,或者甚至是可行的。每个国家也需要考虑如果其他国家开始在战争中使用牛头人团队,它将如何应对。

这些挑战是否能够成功应对,或者是否应该尝试,目前还不清楚。我们希望这次讨论已经证明了直面这些问题的重要性。在人类战士将战场让给牛头人之前,我们需要知道,他们胜利的代价不会是我们的人性。