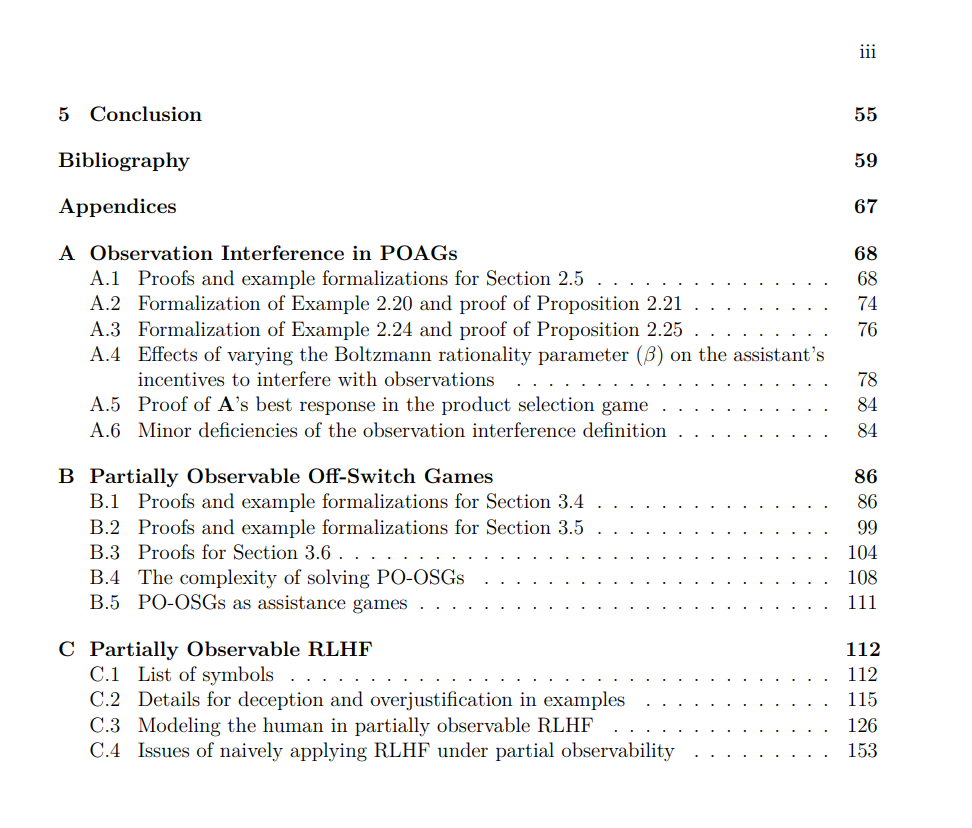

我们采用博弈论框架中的辅助博弈(assistance games)来研究人类与AI的对齐问题。过去关于辅助博弈的研究探讨了人类和AI助手都能完全观察环境的物理状态的情况。在此基础上,我们将研究推广到人类和助手可能只能部分观察环境的情况,并提出了部分可观察辅助博弈(POAG)。通过POAG框架,我们证明了关于AI助手的多种理论结果。我们首先考虑了观察干扰的问题,展示了三种可能导致最优AI助手干扰人类观察的因素。然后,我们重新审视了关于所谓**关闭开关问题(off-switch problem)**的过去保证,表明部分可观察性对设计能够自我关闭的AI助手提出了新的挑战。最后,我们分析了部分可观察性如何导致通过人类反馈进行强化学习——一种广泛应用于训练AI助手的算法——陷入欺骗性失败模式。我们最后讨论了将这些理论见解转化为改进有益AI助手技术的可能路径。

成为VIP会员查看完整内容

相关内容

Arxiv

37+阅读 · 2023年4月19日

Arxiv

203+阅读 · 2023年4月7日

Arxiv

79+阅读 · 2023年4月4日

Arxiv

140+阅读 · 2023年3月29日