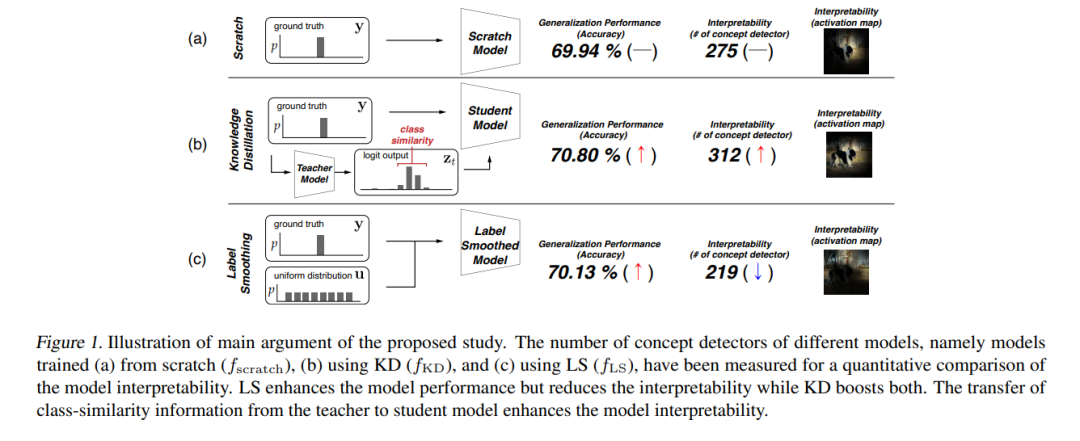

最近的一些研究阐明了为什么知识蒸馏(KD)可以提高模型性能。然而,KD算法除了能提高模型性能外,还具有其他优点,目前研究较少。在这项研究中,我们试图表明KD增强了模型的可解释性和准确性。我们测量了网络解剖中识别的概念检测器的数量,以定量比较模型的可解释性。我们将可解释性的提高归因于从教师模型传递到学生模型的类相似度信息。首先,通过logit蒸馏确定类相似度信息从教师模型向学生模型的迁移;然后,从类相似信息的存在与否和相似信息的程度两个方面分析了类相似信息对模型可解释性的影响;我们进行了各种定量和定性的实验,并根据不同的数据集、不同的KD方法和不同的可解释性度量检查了结果。我们的研究表明,由大型模型组成的KD模型可以更可靠地应用于各种领域。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2023年7月14日

Arxiv

0+阅读 · 2023年7月13日

Arxiv

0+阅读 · 2023年7月13日

Arxiv

223+阅读 · 2023年4月7日