将大型语言模型(LLM)适应于新的多样化知识,对于其在实际应用中的长期有效性至关重要。本综述概述了扩展LLM知识的最先进方法,重点介绍了整合多种知识类型的方法,包括事实信息、领域专业知识、语言能力和用户偏好。我们探讨了持续学习、模型编辑和基于检索的显式适应等技术,同时讨论了知识一致性和可扩展性等挑战。本综述旨在为研究人员和实践者提供指导,阐明了将LLM发展为可适应且强大的知识系统的机会。 https://arxiv.org/abs/2502.12598

1 引言

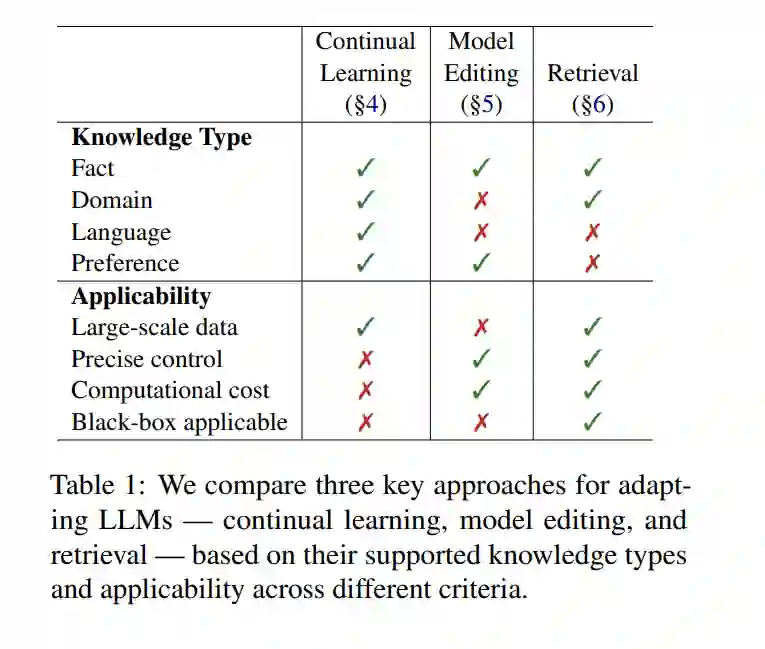

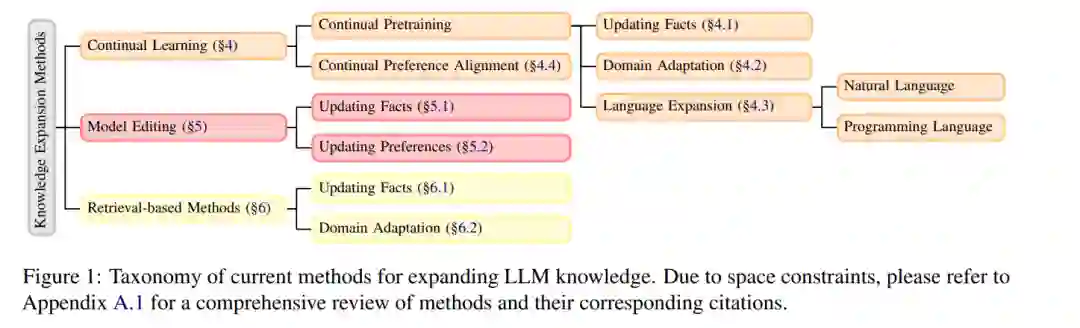

随着大型语言模型(LLM)在实际应用中的逐渐普及,它们适应不断变化的知识的能力对于保持相关性和准确性变得至关重要。然而,LLM 通常只进行一次训练,因此它们的知识更新仅限于某个截止日期,限制了它们与新信息保持同步的能力。本综述全面概述了使 LLM 能够整合各种类型新知识的方法,包括事实知识、领域特定知识、语言知识和用户偏好知识。我们调查了适应策略,包括持续学习、模型编辑和基于检索的方法,并旨在为研究人员和实践者提供指导。 为了保持有效性,LLM 需要在多个维度上进行更新。事实知识包括一般真理和实时信息,而领域知识则涉及特定领域,如医学或法律。语言知识增强了多语言能力,偏好知识使模型的行为与用户的期望和价值观保持一致。确保 LLM 能够在这些维度上整合更新对于其持续的实用性至关重要。 现有的 LLM 适应方法在方法和应用上有所不同。持续学习使得模型的参数化知识能够进行增量更新,减轻灾难性遗忘(McCloskey 和 Cohen,1989),同时确保长期表现。模型编辑允许精确修改已学习的知识,提供受控的更新,而不需要完全重新训练。与这些隐式知识扩展方法不同,基于检索的方法在推理过程中显式地动态访问外部信息,从而减少对静态参数化知识的依赖。不同知识类型的这些方法的适用性和一般性已在表 1 中总结。通过利用这些策略,LLM 可以保持准确性、上下文意识,并适应新信息。 在第二节中,我们将我们的工作置于背景中(第 2 节),并在第三节中定义本文涉及的知识类型。我们还概述了不同的知识扩展方法,如图 1 所示。因此,本工作综述了多种研究努力,并可作为研究人员和实践者开发和应用可适应且强大的 LLM 的指南。我们强调了研究机会,并提供了优化适应技术以应对各种实际应用的见解。