视频生成是一个迅速发展的研究领域,由于其广泛的应用范围而获得了重大关注。这一领域的一个关键方面是长时视频的生成,这呈现了独特的挑战和机遇。本文呈现了对长视频生成近期进展的第一个综述,并将其总结为两个关键范式:分而治之或时间自回归。我们深入探讨了每个范式中常用的模型,包括网络设计和条件技术的方面。此外,我们提供了数据集和评估指标的全面概述和分类,这对于推进长视频生成研究至关重要。以现有研究的总结结束,我们还讨论了这一动态领域中出现的挑战和未来方向。我们希望这篇综述能成为长视频生成领域的研究人员和实践者的重要参考。

https://www.zhuanzhi.ai/paper/6fcdf09712b06f301551fccf2dc693f8

计算机视觉和人工智能领域经历了变革性的增长,特别是在视频生成领域。最近,开发出能够产生高质量和逼真视频序列的算法激增。值得注意的是,长视频的生成,以其延长的持续时间和复杂的内容为特征,为社区提出了新的挑战并激发了新的研究方向。

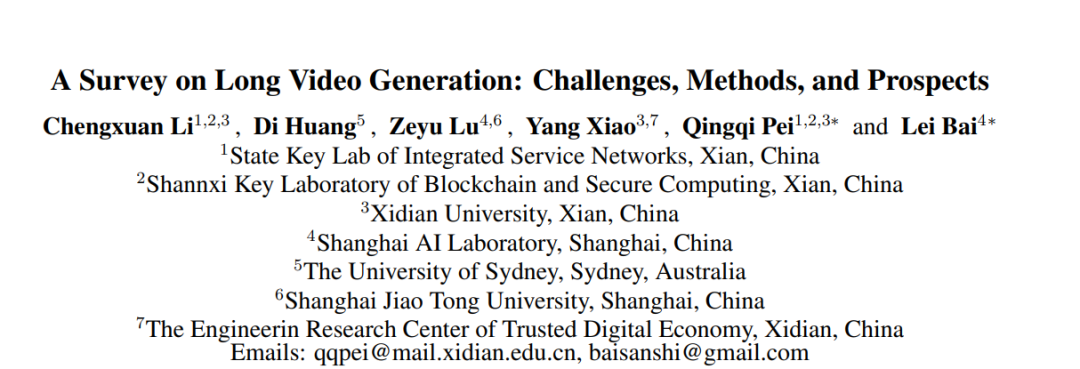

尽管如此,关于长视频生成的研究仍存在差距。当前研究中的一个缺口是缺乏长视频的标准定义。长短视频之间的区别通常依赖于不同工作中的相对度量,如帧数(例如,512,1024或3376帧)或持续时间(例如,3、5分钟),与较短视频(例如,30、48或64帧)相比。考虑到研究标准的多样性,我们在图1中总结了现有研究中声称的长视频生成的视频长度,基于此我们提出了长视频的定义。具体而言,如果视频的持续时间超过10秒,假设标准帧率为10fps,或者等价地,如果视频包含超过100帧,则将视频分类为“长”视频。这一定义旨在为各种研究背景中长视频的识别提供一个明确的基准。

根据这一定义,长视频长度已取得显著进展。Yin等人(2023)提出了一种分而治之的扩散结构,专门针对长视频进行训练,以消除推理和训练之间的差距,成功生成长达1024帧的视频。Zhuang等人(2024)利用大型语言模型(LLM)的强大能力,将输入文本扩展为脚本,以指导生成分钟级长视频。最近,Sora(OpenAI,2024)实现了高保真且无缝生成长达一分钟的长视频,特色包括多分辨率和镜头转换等高质量效果。此外,许多杰出的研究在现有视频生成模型上引入了新的结构和思想,为长视频生成铺平了道路。

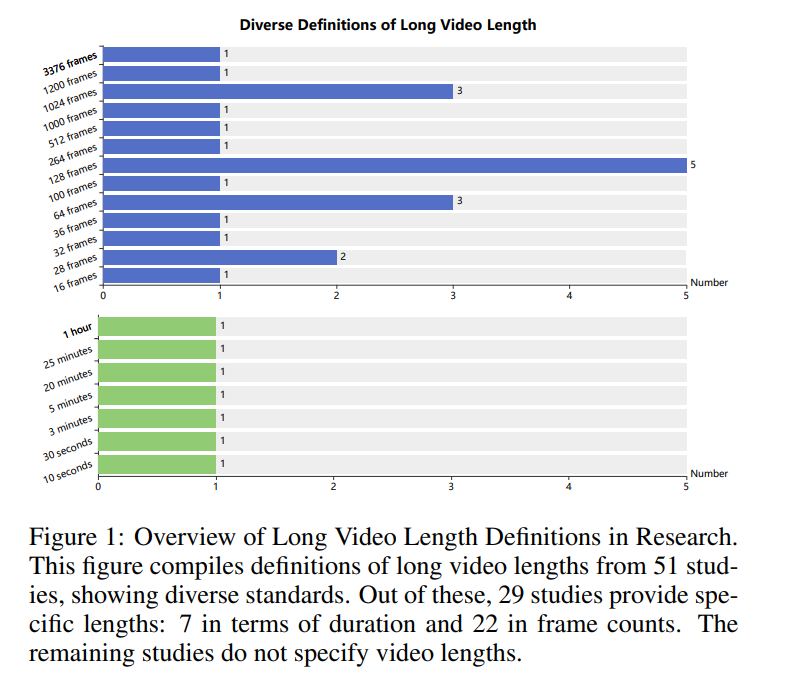

即便如此,长视频的生成仍面临诸多挑战。其核心是,长视频的固有多维复杂性对处理和生成的硬件资源提出了巨大的需求,导致训练和生成成本在时间和资源上的显著增加。这提出了在现有资源约束下生成长视频的挑战。此外,长视频数据集的稀缺性未能满足训练要求,阻止研究人员直接获得支持长视频模型生成的最优参数。在这种情况下,当生成的视频长度超过某些阈值时,难以保持长视频生成的时间一致性、连续性和多样性。此外,当前研究表面上出现了几种偏离现实世界既定物理定律的现象,提出了尚未被现有方法理解或直接操纵的未预见挑战。因此,长视频生成研究仍处于早期阶段,有许多挑战待解决,需要进一步的探索和发展。 在这项综述中,我们对长视频生成的现有研究进行了全面调查,旨在提供当前发展状态的清晰概述,并为其未来进展做出贡献。本文其余部分的组织概述在图2中。最初,我们在第1节中定义了长视频持续时间。第2节讨论了四种不同类型的视频生成模型和控制信号。根据第1节和第2节,我们在第3.1节和第3.2节中分别介绍了简化长视频生成任务的两种常见范式:分而治之和时间自回归。第4节和第5节讨论了视频质量改进和硬件要求。最后,本文以长视频生成的总结和对新兴趋势及机会的讨论结束。

我们详细介绍了四种流行的视频生成模型,包括扩散模型、自回归模型、生成对抗网络(GAN)和掩码建模。 扩散模型用于视频生成,采用了传统扩散技术的迭代细化过程,这些技术最初是为静态图像设计的(Ho等,2020),适应了视频的动态领域。这些模型的核心是从一系列随机噪声开始,通过一系列步骤逐步去噪,以生成一个连贯的视频序列。每一步都由学习到的梯度指导,这些梯度能够基于单个帧的空间内容及连续帧之间的时间关系预测性地去噪。这种方法允许生成的视频不仅每一帧在视觉上与其前序帧一致,而且还有助于整个序列的流畅性。 在视频生成中,空间自回归模型(Alex Graves,2013)采用了一种独特的方法,通过基于补丁的方法合成内容,每个补丁的创建依赖于与之前生成的补丁的空间关系。这个过程类似于递归算法,一次生成一个补丁。因此,它一帧一帧地构建视频,直至完成。在这个框架内,补丁之间的空间关系至关重要,因为每个后续补丁必须与其邻居无缝对齐,以确保整个帧在视觉上的连贯性。这种方法利用了视频内容中固有的空间依赖性,确保视频在时间上进展时,每一帧都与其前序帧保持一致和连续,不仅仅是在时间上,也在空间上。 GAN(生成对抗网络)(Creswell等,2020)在使用GAN进行视频生成的过程中,从生成器开始,将简单的噪声模式转换为一系列视频帧。这个本质上随机的噪声作为视频制作的初始空白状态。通过神经网络的层,生成器逐渐将这个噪声塑造成看起来像视频帧的图像,确保每一帧逻辑上紧跟上一帧,创造平滑的动作和可信的叙述。 这种从噪声到视频的演变通过来自鉴别器的反馈进行精炼,鉴别器是一个判断生成的视频看起来是真实还是假的组件。生成器从这个判断中学习,随着时间的推移提高其产生更逼真视频的能力。最终目标是生成的视频与真实视频无法区分,并展示自然的动作和过渡。 掩码建模在视频生成中,掩码建模利用了选择性遮盖视频帧部分区域以增强模型学习过程的概念。这种技术通过在视频的某些段落应用掩码开始,有效地在训练期间将它们隐藏起来。模型随后学习基于可见的上下文和视频的时间流动来预测这些遮盖的部分。这个过程不仅迫使模型理解视频内容的基本结构和动态,还提高了其生成连贯和连续视频序列的能力。通过在部分可见数据上进行迭代训练,模型变得擅长填补缺失的信息,确保生成的视频保持场景和动作的自然进展。 长视频生成范式

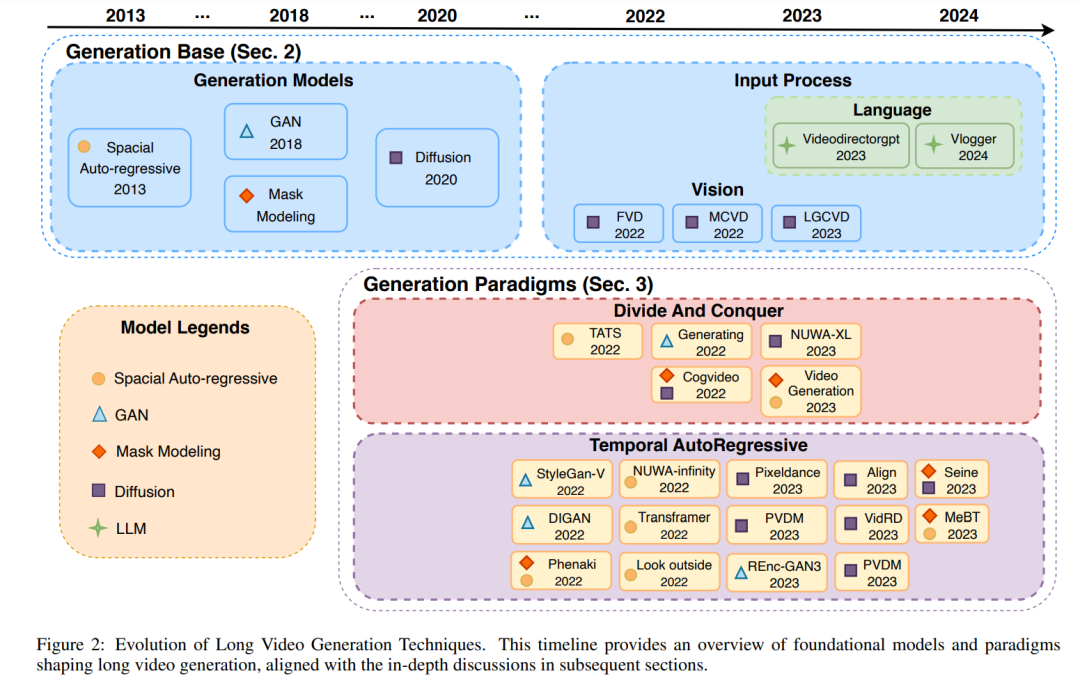

在长视频生成的领域中,有限的计算资源的挑战以及现有模型直接生成显著持续时间视频的能力不足,导致提出了两个不同的范式:分而治之和时间自回归,如图3所示。这些范式旨在将长视频生成的复杂任务解构为更易管理的过程,专注于创建单个帧或短片段,这些片段可以逻辑上组装以完成长视频的生成。 分而治之范式首先通过识别概述主要叙事的关键帧开始,然后生成介于关键帧之间的帧,以编织出一个连贯的长视频。另一方面,时间自回归范式,也简称为自回归,采用序列方法基于先前条件生成短视频段。这一范式旨在确保片段之间的流畅过渡,从而实现连续的长视频叙述。与分而治之采取层次化方法通过区分故事线关键帧和补充填充帧不同,时间自回归范式放弃了层次结构,转而专注于直接生成由前序帧信息指导的详细片段。 在这一部分,讨论集中在两个范式上,考察当前研究如何策略性地将长视频生成任务简化为更小、更易管理的任务。此外,它还突出了现有模型是如何被用于生成的,这些输出随后被组装成完整的视频叙述。

结论与未来方向

本文提供了长视频生成领域最新研究进展的全面回顾。我们系统地回顾了四种视频生成模型,并深入探讨了基于这些模型生成长视频的范式,将它们归类为两大类型:分而治之和自回归。此外,我们的工作包括了长视频生成质量特性的综合总结。为旨在增强这些质量的现有研究提供了详细解释。还讨论了聚焦于资源需求解决方案的研究。为了进一步推进该领域,我们识别了几个未来发展的有希望方向。 数据资源扩展现有方法面临着在训练长视频生成模型时由于长视频数据集资源不足的挑战,这些数据集未能满足通过训练数据获得最优模型参数的要求。因此,这导致了如长视频生成不连贯和内容重复等问题。为了解决这一问题,Gu等人(2023)提出了一种使用大型语言模型并转换现有视频内容以扩展数据集的方法,有效解决了数据稀缺问题。未来的研究可以探索更有效的方法来丰富长视频数据集。 统一生成方法的开发长视频生成的现有范式被总结为两大类:分而治之和自回归。虽然它们能够利用现有模型生成长视频,但每种方法都有其缺点。具体而言,分而治之受制于长视频训练数据集的稀缺性,需要显著的生成时间,面临在长时间跨度上预测关键帧的挑战,且关键帧的质量显著影响填充帧的质量。自回归倾向于累积错误,并在多次推断后遭受内容退化。总体而言,每种范式都有其优势和弱点。未来的研究可能旨在开发一种高质量的统一范式,整合两种范式的优势以解决它们各自的局限性。 具有灵活长度和宽高比的生成当前的研究主要侧重于训练和创建具有预定尺寸的长视频内容。然而,对多样化视频内容和模拟现实世界的日益增长的需求,要求生成具有可变长度和宽高比的视频。Sora(OpenAI,2024)和FiT(Lu等人,2024)在这一领域取得了进展,Sora实现了灵活视频大小的生成,FiT在图像生成的两个维度上展示了适应性。未来的研究可能会强调改善视频生成的灵活性,旨在提高生成模型在现实世界设置中的适用性,并进一步激发视频内容利用的创新。 超长视频的生成在图1中描述的调查中,现有研究中长视频的最长持续时间为1小时(Skorokhodov等人,2022)。然而,在现实生活中,如电影和驾驶模拟中,视频持续时间通常为90分钟甚至更长。我们将这些称为“超长视频”。因此,未来的研究可以集中于生成超长视频,并解决随着持续时间延长而出现的视角转换、角色和场景发展以及动作和情节丰富化的挑战。 增强的可控性和现实世界模拟在长视频生成中,当前模型在生成过程中和内部操作像黑盒一样,使得理解错误的原因(如违反物理定律的错误,由Sora(OpenAI,2024)展示)变得具有挑战性。现有解决方案缺乏对问题起源的洞察以及直观、可控的补救措施。因此,需要新的方法和技术来增强我们对生成模型的理解和控制,使它们更适合于现实世界的应用。