互联网拥有巨大的视频库,每秒钟都有成千上万的视频上传到YouTube等平台。这些视频代表了多模态信息的宝贵资源库,为理解音频-视觉-文本关系提供了宝贵的资源。此外,理解长视频(比如2小时)的内容是一个开放性问题。本文研究了视频中不同模态(音频、视觉和文本)之间的错综复杂的相互作用,并利用它们的潜力来理解长视频中的语义细微差别。我的研究探索了从这些模态中组合信息的多种策略,从而在视频摘要和教学视频分析方面取得了重大进展。

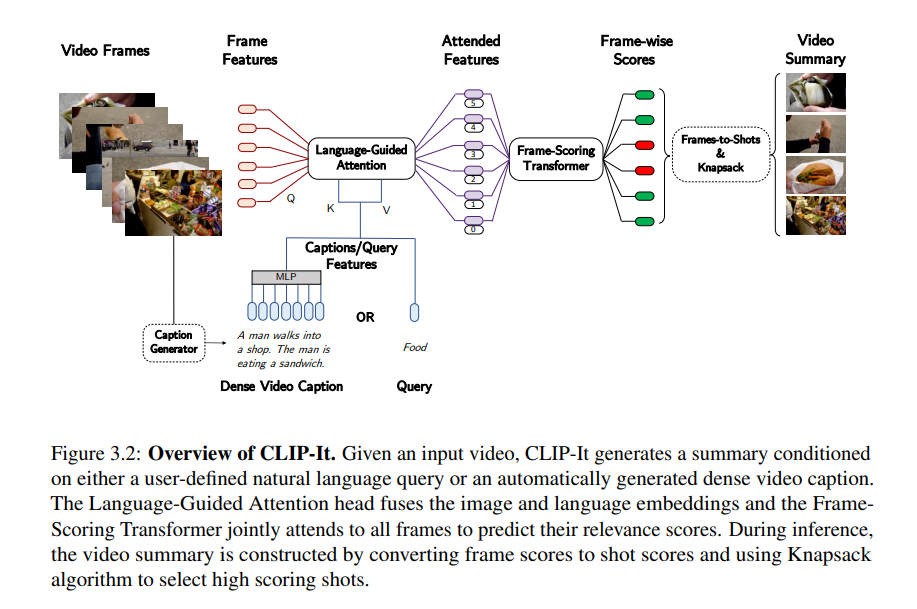

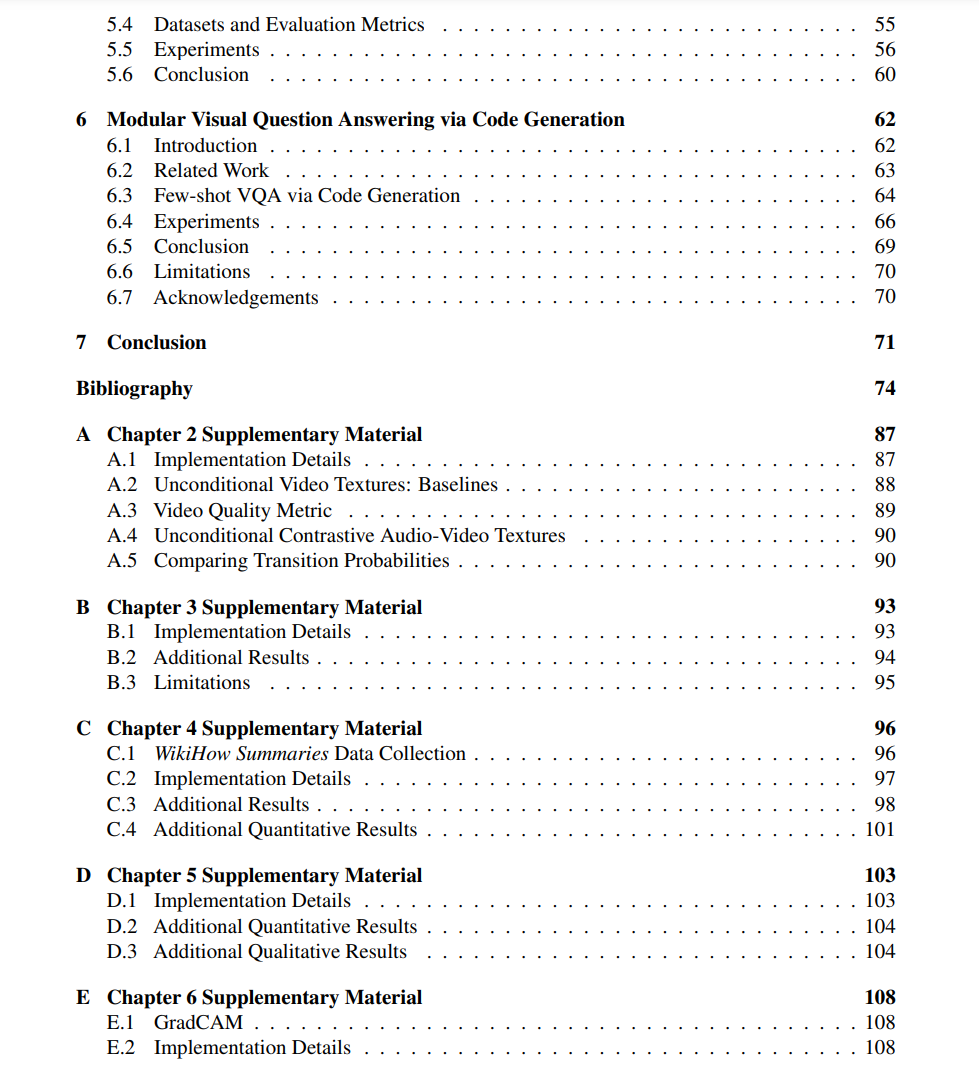

第一部分介绍了一种通过连贯地重新排列片段来从短片段合成长视频纹理的方法,同时还考虑了音频条件。第二部分讨论了一种新的技术,用于在自然语言提示的指导下生成长视频的简明视觉摘要。此外,我们特别关注于总结教学视频,利用视听对齐和任务结构来生成信息摘要。为了进一步丰富对教学视频的理解第一部分介绍了一种通过连贯地重新排列片段来从短片段合成长视频纹理的方法,同时还考虑了音频条件。第二部分讨论了一种新的技术,用于在自然语言提示的指导下生成长视频的简明视觉摘要。此外,我们特别关注于总结教学视频,利用视听对齐和任务结构来生成信息摘要。为了进一步丰富对教学视频的理解,本文介绍了一种前沿的方法,以促进教学内容中程序步骤的学习和验证,使模型能够掌握长而复杂的视频序列,并确保程序准确性。最后,通过代码生成探索了大型语言模型的潜力,以回答关于图像的问题。通过全面的实验,研究证明了所提出方法的有效性,并通过集成音频、视觉和文本关系,展望了长视频语义领域的美好前景。

成为VIP会员查看完整内容

相关内容

加州大学伯克利分校(University of California, Berkeley),是美国最负盛名且是最顶尖的一所公立研究型大学,位于旧金山东湾伯克利市的山丘上。创建于1868年,是加州大学十个分校中历史最悠久的一所。加州大学伯克利分校在世界范围内拥有崇高的学术声誉,拥有丰富的教学资源,研究水平非常坚厚,与斯坦福大学、麻省理工学院等一同被誉为美国工程科技界的学术领袖。

Arxiv

42+阅读 · 2023年4月19日

Arxiv

223+阅读 · 2023年4月7日

Arxiv

86+阅读 · 2023年4月4日

Arxiv

152+阅读 · 2023年3月29日