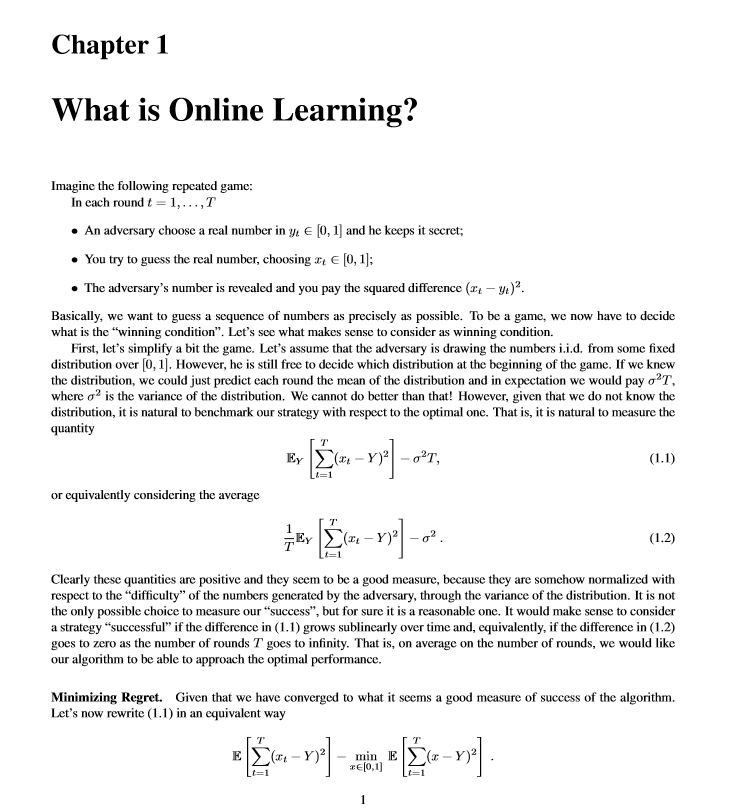

简介: 作者通过在线凸优化的现代观点介绍在线学习的基本概念。这里,在线学习是指在最坏情况下的假设中将regret最小化的框架。作者介绍了在欧几里得和非欧几里得设置下具有凸损失的在线学习的一阶和二阶算法。清楚地表示了所有算法,以表示Online Mirror Descent或遵循正规领导及其变体。通过自适应和无参数的在线学习算法,特别关注调整算法参数和在无界域中学习的问题。非凸损失通过凸智能损失和随机化处理。还简要讨论了非凸的情况,这些说明不需要先有凸分析的知识,并且对所有所需的数学工具进行了严格的解释。而且,所有的防护措施都经过仔细选择,以使其尽可能的简单。

作者介绍: Francesco Orabona,目前是波士顿大学电气与计算机工程系的助理教授, 之前,曾在石溪大学,纽约雅虎研究中心,芝加哥的丰田技术学院,米兰大学,IDIAP研究所和热那亚大学任教。研究兴趣是无参数机器学习,尤其对在线学习,批处理/随机优化和统计学习理论感兴趣。个人主页:http://francesco.orabona.com/

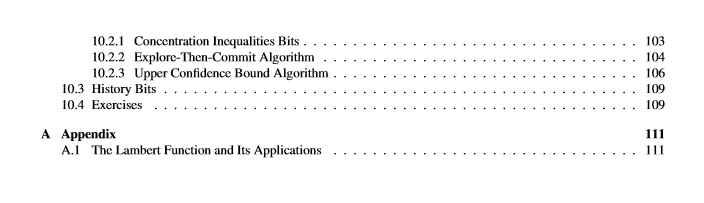

目录:

成为VIP会员查看完整内容

相关内容

波士顿大学(Boston University) 创校于1839年,是一所历史悠久的顶级私立院校,同时也是全美第三大私立大学。波士顿大学位于波士顿市中心,与哈佛、麻省理工等著名院校隔河相对,校园闹中取静,交通便利,地下铁横穿校园,又临查理士河畔,是一所拥有理想学习环境的大学。波士顿大学不但拥有一流的师资、设备,也拥有健全的科系。全校共有十七个学院,共包括两百五十个以上不同的科系,为一所完整的综合大学。

专知会员服务

69+阅读 · 2019年11月30日

Arxiv

5+阅读 · 2018年5月15日

Arxiv

10+阅读 · 2018年1月29日