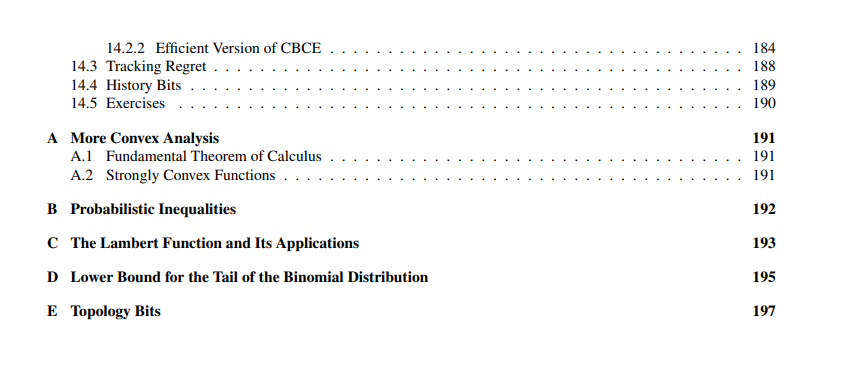

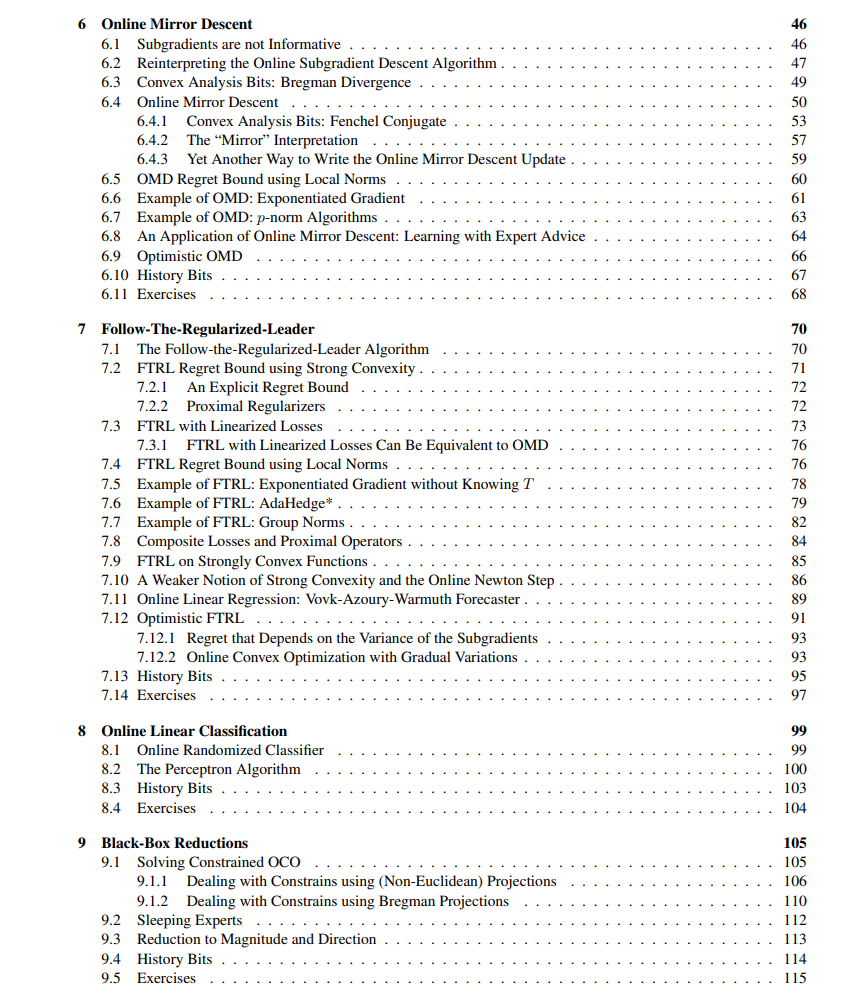

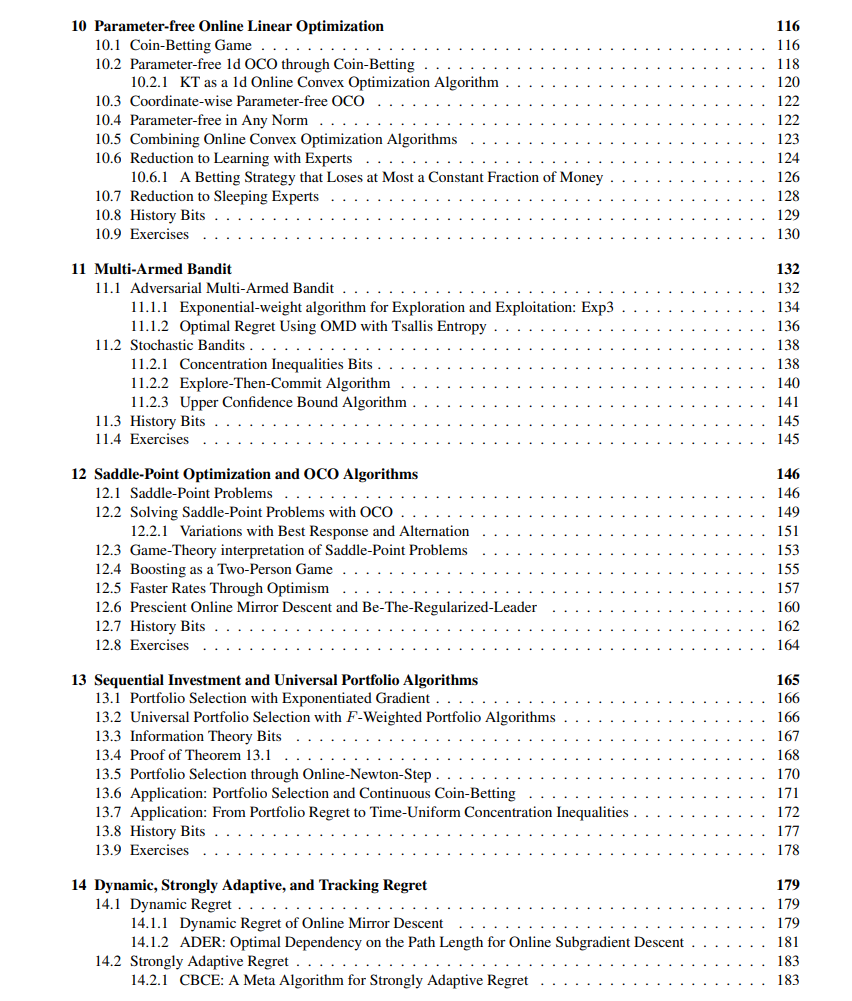

在本专著中,我从现代在线凸优化(Online Convex Optimization, OCO)的视角出发,介绍了在线学习(Online Learning)的基本概念。这里所说的在线学习,指的是在最坏情况下最小化后悔值(regret minimization)的理论框架。我展示了适用于凸损失函数的在线学习一阶与二阶算法,涵盖欧几里得(Euclidean)与非欧几里得(Non-Euclidean)空间的情形。所有算法均被清晰地呈现为在线镜像下降(Online Mirror Descent, OMD)或正则化引导法(Follow-The-Regularized-Leader, FTRL)及其变种的具体实例。

本书特别关注算法参数调优问题及在无界域(unbounded domains)中学习的挑战,主要通过自适应(adaptive)与无参数(parameter-free)在线学习算法加以解决。针对非凸损失函数,则引入凸替代损失(convex surrogate losses)和随机化方法进行处理。书中亦简要讨论了bandit问题,涉及对抗性与随机性多臂赌博机(multi-armed bandits)场景下的挑战。 本讲义不要求读者具备凸分析的先验知识,所需的数学工具均进行了严格、清晰的解释。此外,书中所附证明均经过精心挑选,力求简明易懂、尽可能简短。

成为VIP会员查看完整内容