大型语言模型(LLMs)在许多不同的自然语言处理(NLP)任务中表现出色。提示工程在提升LLMs已有能力的基础上,实现显著性能提升方面发挥了关键作用。提示工程需要撰写称为提示的自然语言指令,以结构化方式引导LLMs挖掘知识。与之前的最新技术(SoTA)模型不同,提示工程不需要根据特定NLP任务进行广泛的参数重新训练或微调,而是完全依赖于LLMs的内嵌知识。此外,LLM爱好者可以通过基本的自然语言对话交流或提示工程,智能地提取LLMs的知识,使更多没有深厚数学和机器学习背景的人也能尝试使用LLMs。随着提示工程在过去两年中越来越受欢迎,研究人员提出了许多围绕提示设计的工程技术,以提高从LLMs提取信息的准确性。在本文中,我们总结了不同的提示技术,并根据它们所应用的不同NLP任务进行分类。我们进一步细化地展示了这些提示策略在不同数据集上的性能,讨论了所使用的相应LLMs,提供了一个分类图,并探讨了特定数据集可能的最新技术。总的来说,我们阅读并总结了44篇研究论文,涵盖了39种不同的提示方法,涉及29个不同的NLP任务,其中大多数论文在过去两年内发表。

人工智能随着大型语言模型(LLMs)的引入显著进步。LLMs在包含数百万和数十亿个标记的大规模文本语料库上进行训练。研究表明,随着模型参数数量的增加,机器学习模型的性能会提高,这也正是LLMs的情况。Chang等人(2023)的研究表明,LLMs在广泛的NLP任务上取得了前所未有的性能,因此引起了学术界和包括医学、法律、金融等在内的各个行业的广泛关注。目前对LLMs的研究阶段侧重于通过提示(prompts)来提升其推理能力,而不仅仅是下一个标记的预测,这开启了围绕提示工程的新研究领域。

提示工程是指创建自然语言指令或提示,以有组织地从LLMs中提取知识的过程。与早期的传统模型相比,提示工程仅依赖于LLMs的内嵌知识,而不需要根据基础的NLP任务进行广泛的参数重新训练或微调。理解模型参数中所嵌入的现实世界知识超出了人类的能力,因此这个新的提示工程领域引起了大家的关注,因为它允许研究人员与LLMs之间进行自然语言交流,以实现基础NLP任务的目标。

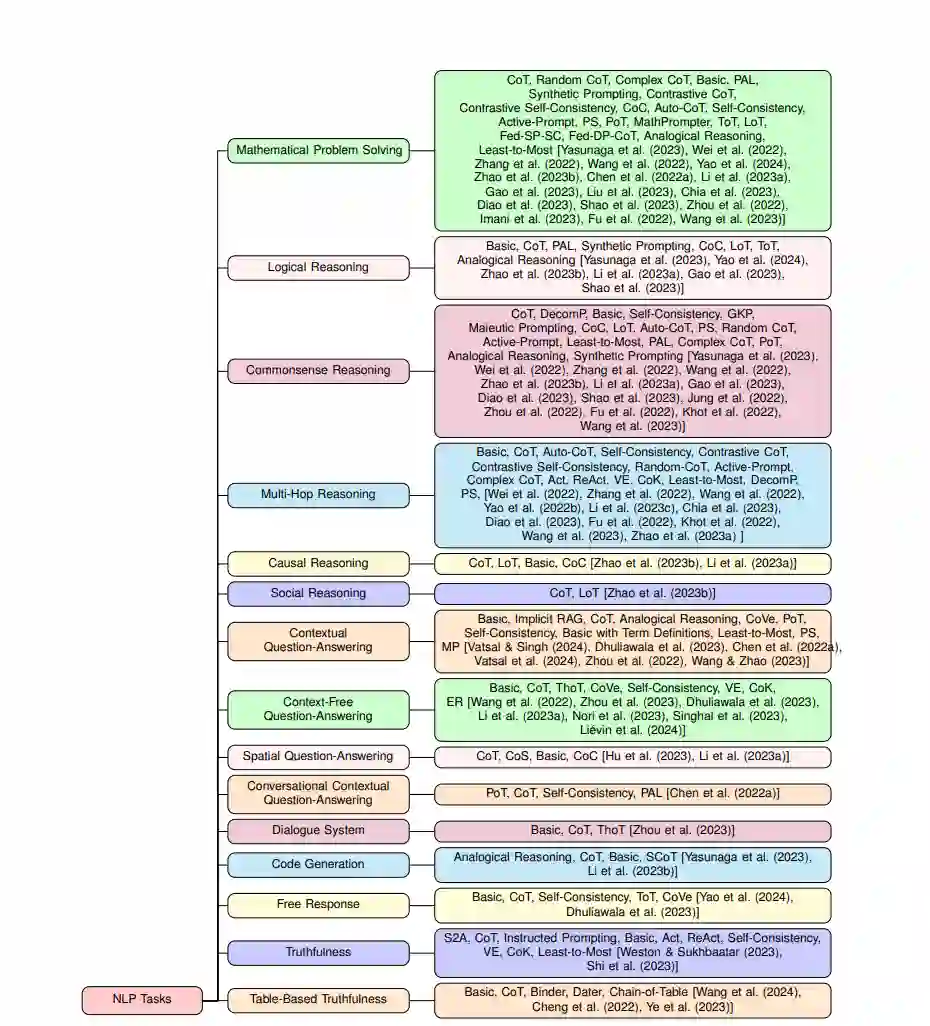

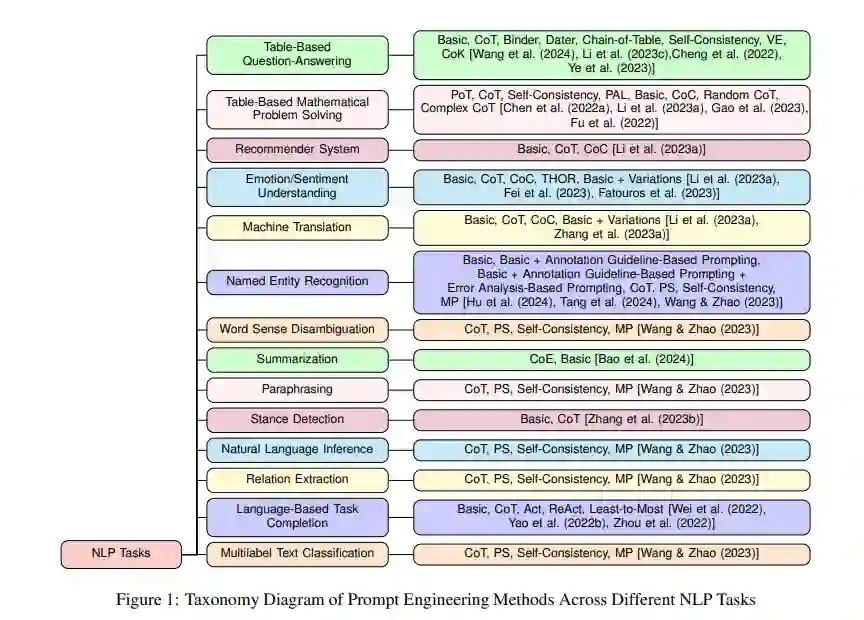

在这项工作中,我们列举了几种提示策略,并根据它们所应用的不同NLP任务进行分类。我们提供了一个分类图,列出了在各种数据集上尝试的提示技术,讨论了所使用的LLMs,并列出了每个数据集的潜在最新技术(SoTA)方法。作为本次调查的一部分,我们总共审查并分析了44篇研究论文,其中大部分发表在过去两年,涵盖了39种提示技术,应用于29个不同的NLP任务。此前关于提示工程的系统性综述并不多见。Sahoo等人(2024)调查了基于其应用的29篇提示技术论文。这是一种非常广泛的分类,因为单一应用可以包含众多NLP任务。例如,他们讨论的一个应用是推理和逻辑,它可以包含大量NLP任务,如常识推理、数学问题解决、多跳推理等。这与我们的方法不同,我们根据NLP任务对提示策略进行更细致的分类。Edemacu和Wu(2024)提供了关于隐私保护提示方法的概述,因此侧重于提示工程的一个相对较小的子领域。Chen等人(2023)将提示策略的讨论限制在9-10种方法,并且没有基于NLP任务对其进行分类。

本文的其余部分安排如下。第二节讨论各种提示工程技术,第三节重点介绍不同的NLP任务。第三节的各个子部分讨论了在给定NLP任务上应用的不同提示策略及其相应的结果。第四节总结全文。

提示工程技术

在本节中,我们简要讨论了不同的提示方法,以及它们在发表时如何改进现有的性能。需要注意的是,大多数以下提示策略都在两种不同的变体或设置下进行了实验,这两种变体包括零样本和少样本。有些提示技术可能本质上只存在于零样本或少样本变体中,不可能存在其他变体。

在零样本设置中(Radford等,2019),没有涉及训练数据,通过提示指令要求LLM执行任务,完全依赖于其在预训练阶段学习的内嵌知识。另一方面,在少样本变体中(Brown等,2020),提供少量训练数据点以及基于任务的提示指令,以便更好地理解任务。各种提示工程工作的结果显示,少样本变体有助于提高性能,但这需要仔细准备少样本数据点,因为LLM可能对精心编制的少样本数据点表现出无法解释的偏见。

不同NLP任务上的提示工程

不同的研究论文在将数据集分类为NLP任务时使用了不同的标准,这在不同的研究中有所不同。在本节中,我们尝试标准化这些分类方法,通过定义不同的NLP任务并将不同的数据集归入这些任务来构建一个结构。我们还讨论了用于这些任务的各种提示方法。图1展示了这种分类的一个示意图。需要注意的是,一个数据集可能同时属于不同的NLP任务,但这会导致复杂的结构化分析纠缠,不利于分析提示技术在各个NLP任务中的表现。因此,在我们的工作中,我们确保每个数据集只属于一个与之最强相关的NLP任务。

以下各小节分别定义了不同的NLP任务、相应的数据集以及应用于这些数据集的各种提示策略。它们还包含每个数据集的潜在最新技术(SoTA)提示技术。提示方法的性能因使用的LLM而异。因此,我们还列出了在给定数据集上与提示策略一起使用的LLM列表。对于SoTA,我们只提及了提示方法的名称,因为在许多情况下,特定的LLM尚未与给定的提示方法进行实验,因此不清楚它是否能达到SoTA性能。因此,如果列表中的任何LLM与提示策略一起用于实验,并在给定数据集中取得了最佳性能,我们将其指定为SoTA,而不论用于该技术的确切LLM是什么。另一个需要强调的点是,在许多研究中,作者使用了同一数据集的不同版本进行实验,使得不同提示技术的绝对比较变得困难。基于我们的理解,我们考虑了上述所有因素,并在选择每个数据集的SoTA时运用了最佳判断。