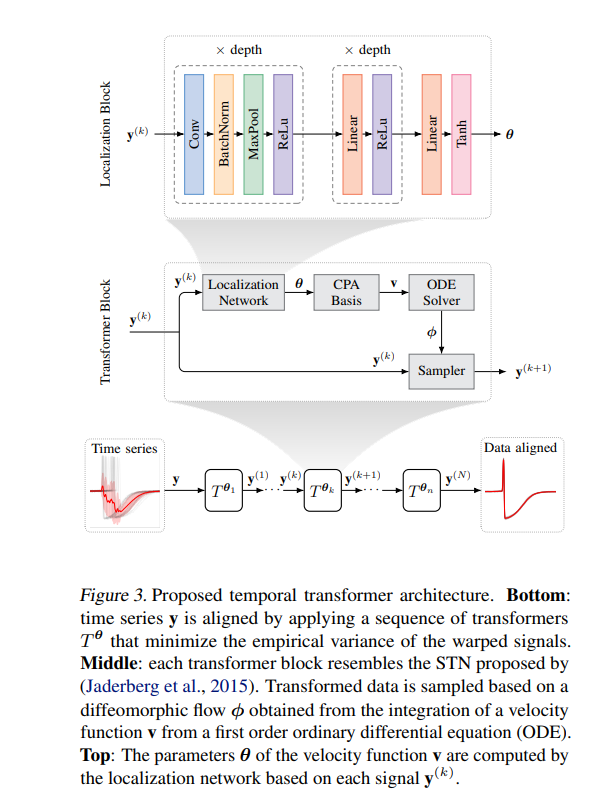

时间序列对齐方法需要具有高度表达性、可微性和可逆性的扭曲函数来保持时间拓扑,即差分同构。在常微分方程(ODE)控制下的速度场积分可以产生异形扭曲函数。包含异构变换的基于梯度的优化框架需要计算微分方程的解对模型参数的导数,即敏感性分析。不幸的是,深度学习框架通常缺乏自动微分兼容的灵敏度分析方法;隐函数,比如ODE的解,需要特别小心。目前的解决方案呼吁伴随灵敏度方法,特别的数值求解或ResNet的欧拉离散化。在这项工作中,我们提出了一个闭合形式的ODE解及其梯度在连续分段仿射(CPA)速度函数。我们提出了一个高度优化的结果在CPU和GPU上的实现。此外,我们在多个数据集上进行了大量的实验,以验证我们的模型对不可见数据的泛化能力。结果表明,在效率和准确性方面都有显著提高。 https://www.zhuanzhi.ai/paper/6bf12cef7552c6267240f4067265d338

成为VIP会员查看完整内容