报告题目:图神经网络在自然语言处理中的应用

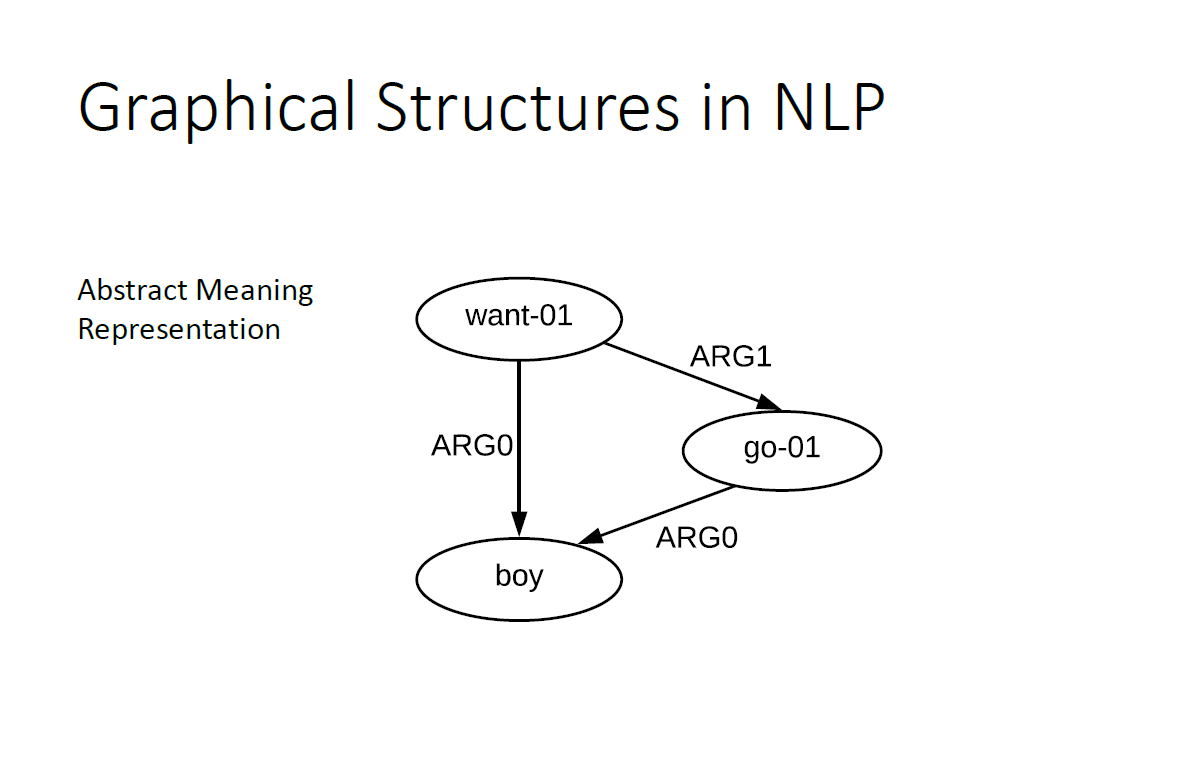

报告摘要:自然语言处理中的很多结构,包括序列结构、树状结构、以及有环图结构,可以归纳为普通的图结构。对图结构的神经网络编码,有助于自然语言处理任务中提取有用信息。近几年来,图神经网络在自然语言处理中得到一系列研究。这个讲座总结图神经网络的两种基本模式,即卷积图神经网络和循环图神经网络,并且讨论他们在自然语言处理中的应用。具体任务包括语义理解、信息抽取和问答等。

嘉宾介绍:张岳目前是西湖大学的副教授。他的研究兴趣包括自然语言处理和计算金融。他一直致力于基础句法分析,文本生成,自然语言生成,机器翻译,信息抽取,情感分析和股票市场分析等工作。他获得了IALP 2017和COLING 2018的最佳论文奖。张岳担任Transactions of ACL编委,ACM TALLIP副主编和IEEE Transactions on Big Data副主编,以及COLING 2014/18,NAACL 2015/19,EMNLP 2015/17/19,ACL 2017/18/19的领域主席。张岳在NAACL2010,ACL 2014和EMNLP 2016/18做过讲习班。

成为VIP会员查看完整内容

相关内容

Attention机制最早是在视觉图像领域提出来的,但是真正火起来应该算是google mind团队的这篇论文《Recurrent Models of Visual Attention》[14],他们在RNN模型上使用了attention机制来进行图像分类。随后,Bahdanau等人在论文《Neural Machine Translation by Jointly Learning to Align and Translate》 [1]中,使用类似attention的机制在机器翻译任务上将翻译和对齐同时进行,他们的工作算是是第一个提出attention机制应用到NLP领域中。接着类似的基于attention机制的RNN模型扩展开始应用到各种NLP任务中。最近,如何在CNN中使用attention机制也成为了大家的研究热点。下图表示了attention研究进展的大概趋势。

专知会员服务

33+阅读 · 2019年10月23日

专知会员服务

48+阅读 · 2019年10月21日

Arxiv

5+阅读 · 2018年9月24日