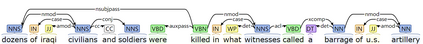

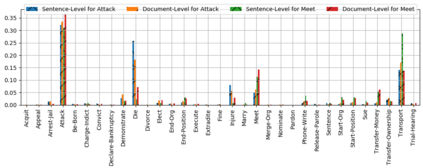

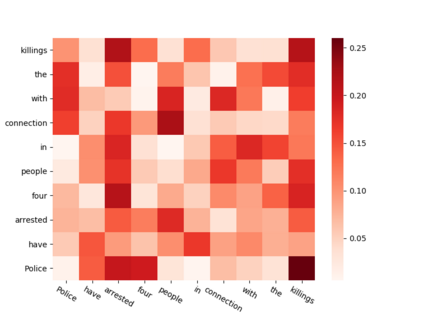

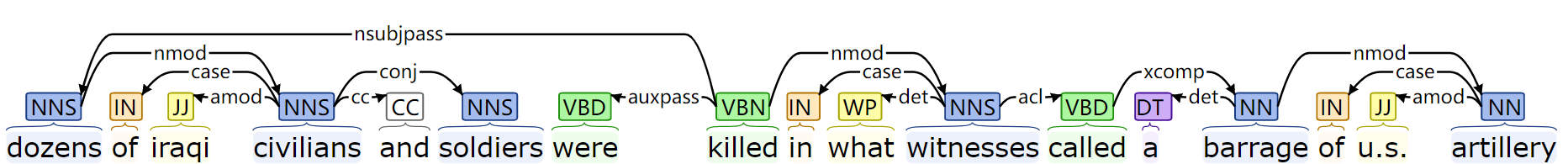

Event extraction is of practical utility in natural language processing. In the real world, it is a common phenomenon that multiple events existing in the same sentence, where extracting them are more difficult than extracting a single event. Previous works on modeling the associations between events by sequential modeling methods suffer a lot from the low efficiency in capturing very long-range dependencies. In this paper, we propose a novel Jointly Multiple Events Extraction (JMEE) framework to jointly extract multiple event triggers and arguments by introducing syntactic shortcut arcs to enhance information flow and attention-based graph convolution networks to model graph information. The experiment results demonstrate that our proposed framework achieves competitive results compared with state-of-the-art methods.

翻译:事件提取在自然语言处理中是实用的。 在现实世界中,一个常见的现象是,在同一句中存在多种事件,从中提取比提取单一事件更难。以前通过顺序建模方法模拟事件之间关联的工作,由于在捕捉非常远距离依赖性方面效率低下而深受其害。在本文中,我们提出一个新的“联合多重事件提取(JMEE)框架 ”, 以联合提取多个事件触发器和论据, 采用合成捷径弧, 以加强信息流动和关注的图形图集网络, 以模拟图形信息。实验结果表明,我们提议的框架取得了与最新方法相比的竞争效果。