主题: Residual Energy-Based Models for Text Generation

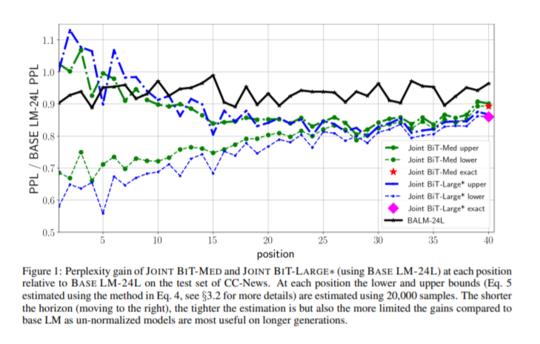

摘要: 从摘要到对话机器翻译,文本生成在许多NLP任务中无处不在。主导参数方法基于局部标准化模型,该模型一次预测一个单词。尽管这些工作非常出色,但由于发电过程的贪婪性,它们受到暴露偏差的困扰。在这项工作中,我们研究了基于非标准化能量的模型(EBM),该模型不是在令牌上运行,而是在序列级别上运行。为了使训练易于处理,我们首先在预训练的局部归一化语言模型的残差中进行工作,其次我们使用噪声对比估计进行训练。此外,由于EBM在序列级别起作用,因此我们可以利用预训练的双向上下文表示,例如BERT和RoBERTa。我们在两个大型语言建模数据集上的实验表明,与本地标准化基准相比,残留EBM的困惑度更低。此外,根据人类评估,通过重要性抽样进行的生成比基线模型非常有效且质量更高。

成为VIP会员查看完整内容

相关内容

专知会员服务

36+阅读 · 2020年4月14日

专知会员服务

17+阅读 · 2020年4月10日

微软发布DialoGPT预训练语言模型,论文与代码 Large-Scale Generative Pre-training for Conversational Response Generation

专知会员服务

28+阅读 · 2019年11月8日