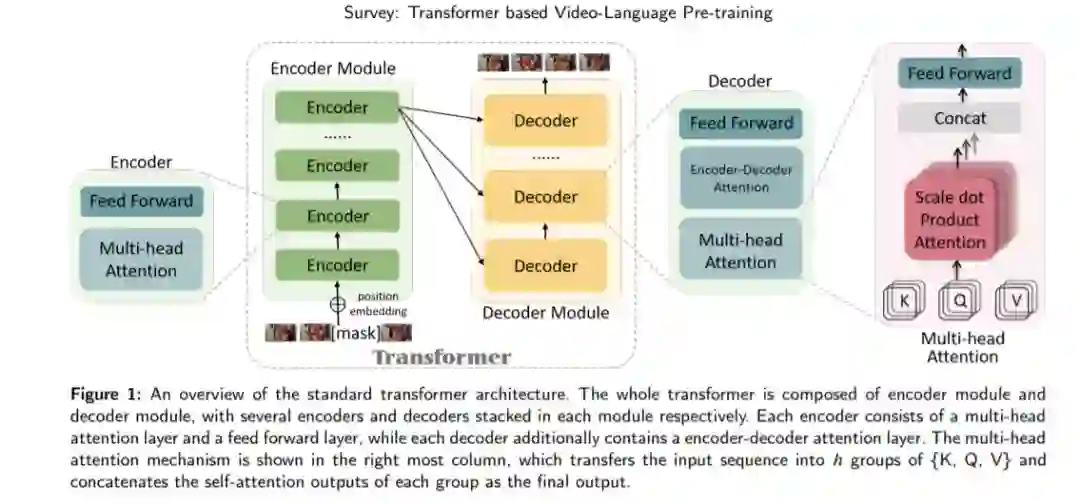

受基于Transformer的预训练方法在自然语言任务和计算机视觉任务中的成功启发,研究人员开始将Transformer应用于视频处理。本研究旨在对基于transformer的视频语言学习预训练方法进行全面综述。首先简单介绍了transformer的结构作为背景知识,包括注意力机制、位置编码等。然后从代理任务、下游任务和常用视频数据集三个方面描述了典型的视频语言处理预训练和微调范式。接下来,我们将transformer模型分为单流和多流结构,突出它们的创新并比较它们的性能。最后,分析和讨论了当前视频语言前训练面临的挑战和未来可能的研究方向。

https://www.zhuanzhi.ai/paper/f7141b8c767225eb6839b5e7236d3b03

Transformer网络(Vaswani et al. 2017)在性能上表现出了巨大的优势,并在深度学习(Deep Learning, DL)中得到了广泛的应用。与传统的深度学习网络如多层感知机(Multi-Layer Perceptrons, MLP)、卷积神经网络(Convolutional Neural networks, CNNs)和递归神经网络(Recurrent Neural networks, RNNs)相比,Transformer网络结构容易加深,模型偏差小,更适合进行预训练和微调。典型的预训练和微调范式是,首先在大量(通常是自我监督的)训练数据上对模型进行训练,然后在较小的(通常是特定任务的)数据集上对下游任务进行微调。训练前阶段帮助模型学习通用表示,这有利于下游任务。

在自然语言处理(NLP)任务中首次提出了基于Transformer 的预训练方法,并取得了显著的性能提高。例如,Vaswani等(Vaswani et al. 2017)首先提出了具有自注意力机制的机器翻译和英语选区解析任务的Transformer 结构。BERT - Bidirectional Encoder representation (Devlin et al. 2018)可以认为是NLP的一个里程碑,它采用Transformer 网络对未标记文本语料库进行预训练,并在11个下游任务上取得了最先进的性能。GPT -生成预训练Transformer v1-3 (Radford and Narasimhan 2018; Radford et al. 2019; Brown et al. 2020)设计为具有扩展参数的通用语言模型,在扩展训练数据上进行训练,其中GPT-3在45TB、1750亿参数的压缩纯文本数据上进行训练。受基于Transformer 的预训练方法在自然语言处理领域的突破启发,计算机视觉研究人员近年来也将Transformer 应用于各种任务中。例如,DETR (Carion et al. 2020)消除了基于Transformer 网络的目标检测的边界盒生成阶段。Dosovitskiy等人(Dosovitskiy et al. 2021)应用了一种纯Transformer ViT,直接处理图像斑块序列,证明了其在基于大训练集的图像分类中的有效性。

视频分析和理解更具挑战性,因为视频本身就含有多模态信息。对于具有代表性的视频语言任务,如视频字幕(Das et al. 2013)和视频检索(Xu et al. 2016),现有的方法主要是基于视频帧序列和相应字幕学习视频的语义表示。在本文中,我们重点提供了基于transformer的视频语言处理前训练方法的最新进展,包括相应基准的常用指标,现有模型设计的分类,以及一些进一步的讨论。我们希望跟踪这一领域的进展,并为同行研究人员,特别是初学者提供相关工作的介绍性总结。

本文的其余部分组织如下: 第2节介绍了相关的基本概念,包括带自注意力机制的标准transformer 、预训练和微调方法的范式以及常用数据集。第三节根据现有的主要方法的模型结构进行了介绍,并指出了它们的优缺点。第四节进一步讨论了几个研究方向和挑战,第五节总结了综述结果