【复旦大学】最新《预训练语言模型》2020综述论文大全,50+PTMs分类体系,25页pdf205篇参考文献

【导读】预训练语言模型Pre-trained Models是当前自然语言处理以及其他应用的研究热点,在众多任务中取得SOTA性能。近日,复旦大学邱锡鹏等学者发布了自然语言处理处理中预训练模型PTMs的综述大全,共25页pdf205篇参考文献,从背景知识到当前代表性PTM模型和应用研究挑战等,是绝好的预训练语言模型的文献。

近年来,预训练模型(PTMs)的出现将自然语言处理(NLP)带入了一个新的时代。在这项综述中,我们提供了一个全面的PTMs调研。首先简要介绍了语言表示学习及其研究进展。然后,我们根据四种观点对现有的PTMs进行了系统的分类。接下来,我们将描述如何将PTMs的知识应用于下游任务。最后,我们概述了未来PTMs研究的一些潜在方向。本调查旨在为理解、使用和开发各种NLP任务的PTMs提供实际指导。

地址:

https://www.zhuanzhi.ai/paper/09d78eda59ebfb6f51a54a3ba0a4c4b1

1. 概述

随着深度学习的发展,各种神经网络被广泛用于解决自然语言处理(NLP)任务,如卷积神经网络(convolutional neural networks, CNNs)[75,80,45]、递归神经网络(neural networks, RNNs)[160, 100]、基于图的神经网络(graphbased neural network, GNNs)[146, 161, 111]和注意力机制[6,171]等。这些神经模型的优点之一是能够缓解特征工程问题。非神经NLP方法通常严重依赖于离散的手工特征,而神经方法通常使用低维和稠密的向量(又称分布式表示)隐式地表示语言的语法或语义特征。这些表示是在特定的NLP任务中学习的。因此,神经方法使人们可以很容易地开发各种NLP系统。

尽管神经模型在NLP任务中取得了成功,但与计算机视觉(CV)领域相比,性能改进可能不那么显著。主要原因是,当前用于大多数监督的NLP任务的数据集相当小(机器翻译除外)。深度神经网络通常具有大量的参数,使其对这些小的训练数据过度拟合,在实际应用中泛化效果不佳。因此,许多NLP任务的早期神经模型相对较浅,通常只包含1 ~ 3个神经层。

最近大量的工作表明,在大型语料库上的预训练模型(PTMs)可以学习通用语言表示,这对后续的NLP任务是有益的,可以避免从零开始训练新模型。随着计算能力的发展,深层模型(即随着训练技能的不断提高,PTMs的体系结构由浅向深推进。第一代PTM的目标是学习好的词嵌入。由于下游任务不再需要这些模型本身,它们在计算效率方面通常非常肤浅,如Skip-Gram[116]和GloVe[120]。虽然这些预训练的嵌入可以捕获单词的语义含义,但它们是上下文无关的,不能捕获文本的高级概念,如语法结构、语义角色、回指等。第二代PTMs主要学习上下文词嵌入,如CoVe[113]、ELMo[122]、OpenAI GPT[130]、BERT[32]等。这些学习过的编码器仍然需要在上下文中通过下游任务来表示单词。此外,还提出了各种预训练的任务,以学习PTMs的不同目的。

这篇综述的贡献可以总结如下:

1. 全面调研。我们为NLP提供了PTMs的全面回顾,包括背景知识、模型架构、预训练任务、各种扩展、适应方法和应用。给出了典型模型的详细描述,进行了必要的比较,总结了相应的算法。

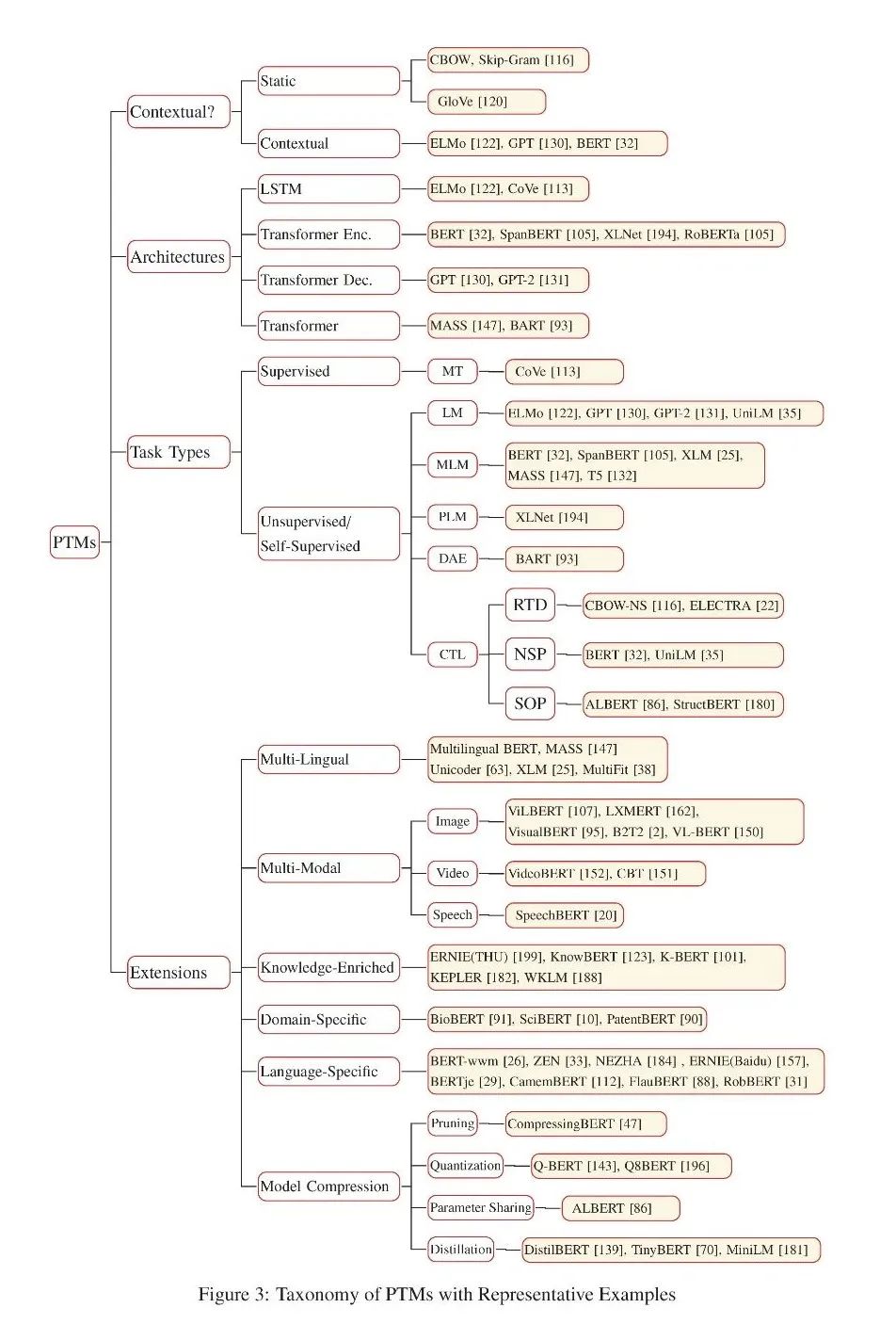

2. 新分类法。我们提出了一种基于自然语言处理的PTMs分类方法,该方法从四个不同的角度对现有的PTMs进行了分类:1)单词表示的类型;2) PTMs架构;3)培训前的任务类型;4)特定类型场景或输入的扩展。

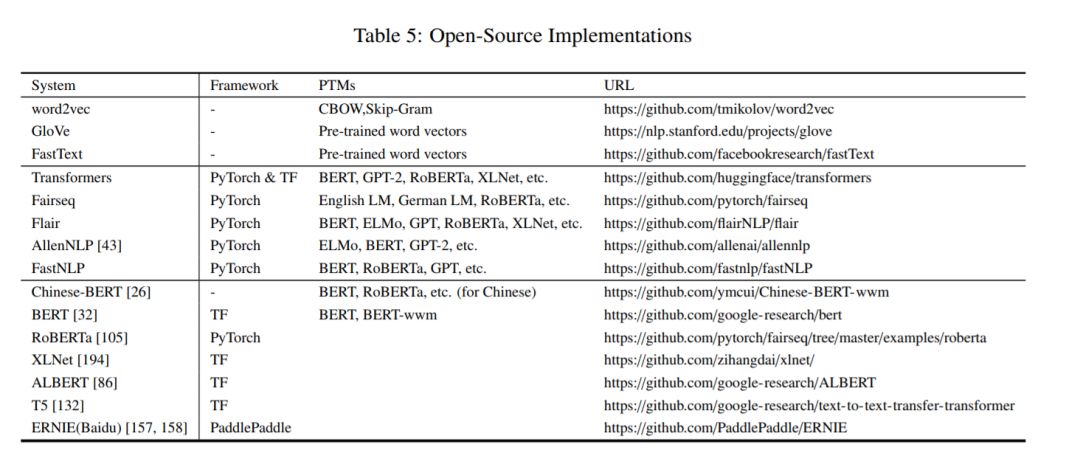

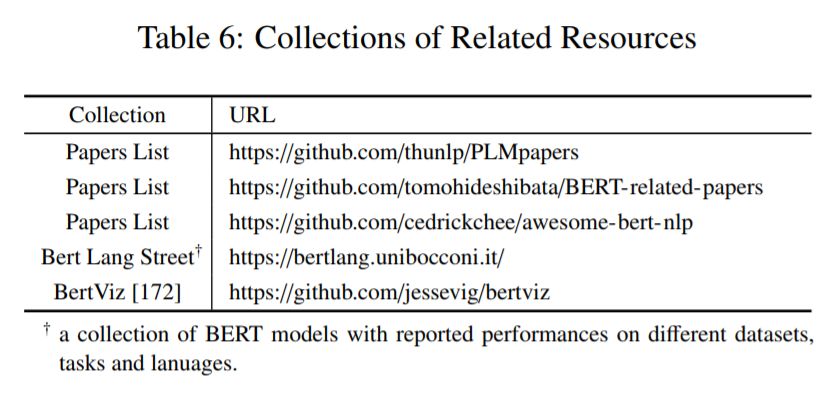

3.资源丰富。我们在PTMs上收集了丰富的资源,包括开源系统、论文列表等。

4. 未来的发展方向。我们讨论并分析了现有PTMs的局限性。并提出未来可能的研究方向。

综述的其余部分组织如下。第2节概述了PTMs的背景概念和常用符号。第3节简要概述了PTMs,并澄清了PTMs的分类。第4节提供了PTMs的扩展。第5节讨论如何将PTMs的知识迁移到下游任务。第6节给出了PTMs的相关资源,包括开源系统、论文列表等。第7节介绍了跨各种NLP任务的应用程序集合。第8节讨论了当前的挑战并提出了未来的方向。第9节对本文进行了总结。

2. 背景

2.1 语言表示学习

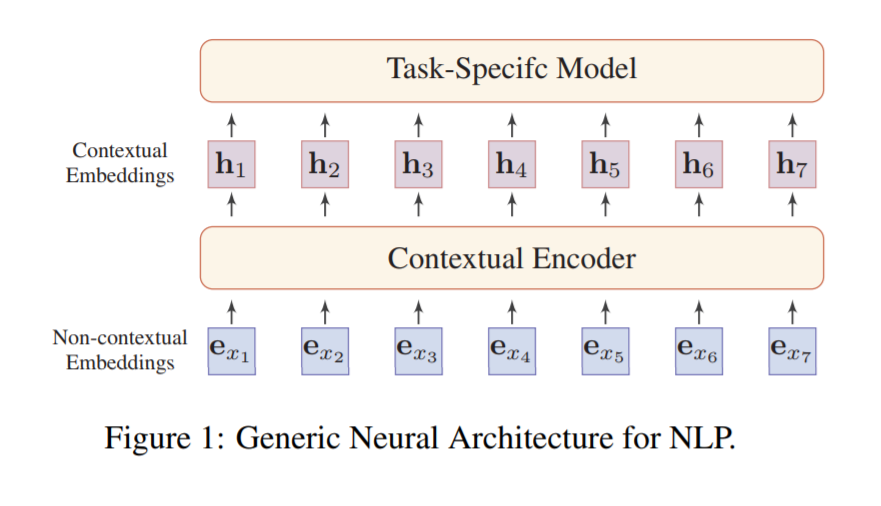

分布式表示的核心思想是用低维实值向量来描述文本的意义。而向量的每一个维度都没有对应的意义,而整体则代表一个具体的概念。图1说明了NLP的通用神经体系结构。词嵌入有两种:非上下文嵌入和上下文嵌入。它们之间的区别是,一个词的嵌入是否根据它出现的上下文动态变化。

2.2 神经上下文编码器

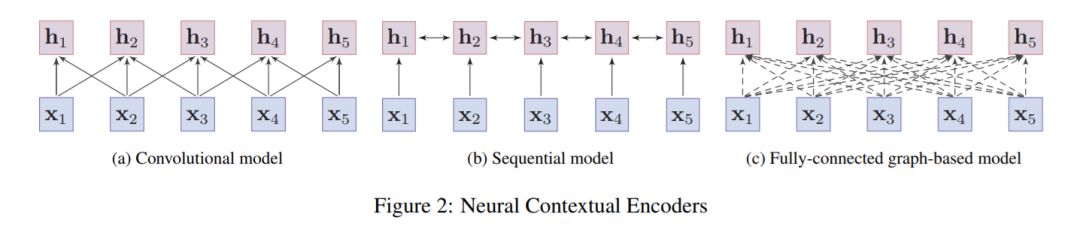

大部分的神经上下文编码器可以分为三类:卷积模型、序列模型和基于图的模型。图2说明了这些模型的体系结构。

(1) 卷积模型。卷积模型采用单词在输入句中的嵌入,通过卷积运算将相邻词的局部信息聚合起来,从而获取单词的意义[80]。卷积模型通常易于训练,能够捕获局部上下文信息。

(2 )序列模型。序列模型通常采用rns(如LSTM[60]和GRU[21])来捕获单词的上下文表示。在实践中,双向RNNs被用来收集单词两边的信息,但其性能往往受到长期依赖问题的影响。

(3) 基于图模型。与上述模型不同的是,基于图的模型以单词为节点,学习单词之间具有预定义语言结构的上下文表示,如句法结构[146,161]或语义关系[111]。

2.3 为什么要预训练?

随着深度学习的发展,模型参数的数量迅速增加。需要更大的数据集来充分训练模型参数并防止过度拟合。然而,对于大多数NLP任务来说,构建大规模的标记数据集是一个巨大的挑战,因为注释成本非常昂贵,特别是对于语法和语义相关的任务。

相比之下,大规模的未标记语料库相对容易构建。为了利用巨大的未标记文本数据,我们可以首先从它们那里学习良好的表示,然后将这些表示用于其他任务。最近的研究表明,借助从大型无注释语料库的PTMs中提取的表示,许多NLP任务的性能都有显著提高。

预训练的好处可以总结如下:

在大型文本语料库上的预训练可以学习通用语言表示并帮助完成后续任务。

预训练提供了更好的模型初始化,这通常会带来更好的泛化性能,并加速对目标任务的收敛。

预训练可以看作是一种正则化,以避免小数据[39]的过拟合。

3. 预训练语言模型分类

为了明确现有PTMs与NLP之间的关系,我们构建了PTMs的分类法,该分类法从不同的角度对现有PTMs进行了分类: (1) PTMs使用的单词表示类型,(2) PTMs使用的主干网络,(3) PTMs使用的预训练任务类型,(4) 为特定类型的场景或输入设计的PTMs。图6显示了分类以及一些相应的代表性PTMs。

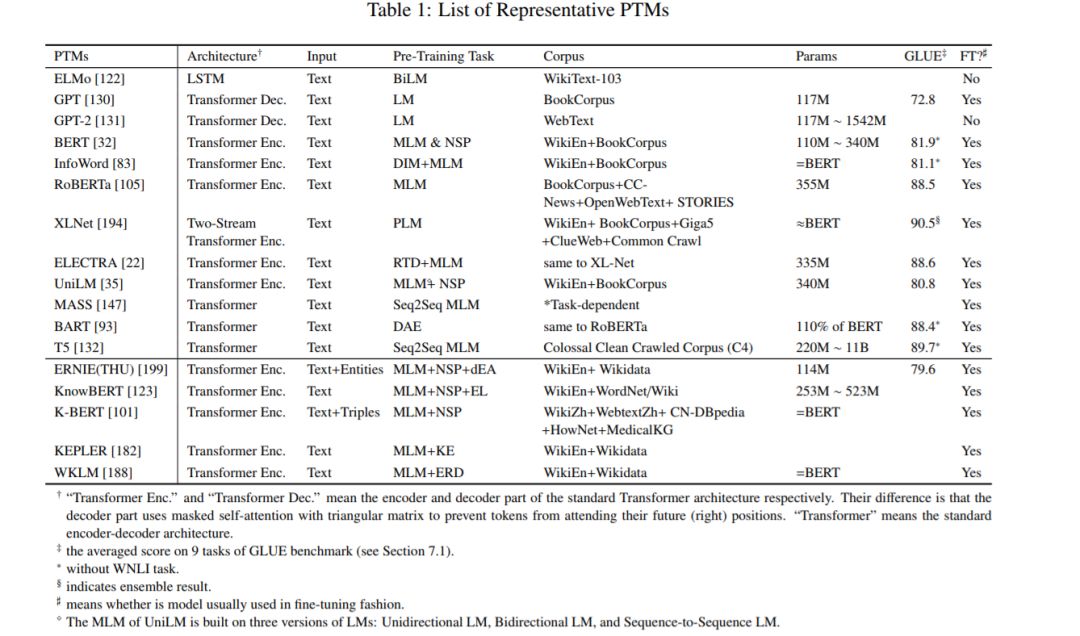

此外,表1详细区分了一些有代表性的PTMs。

4. 预训练语言模型扩展

4.1 知识增强的PTMs

PTMs通常从通用的大型文本语料库中学习通用语言表示,但缺乏领域特定的知识。将来自外部知识库的领域知识整合到PTM中已被证明是有效的。外部知识范围从语言学[87,78,123,178],语义[92],常识[48],事实[199,123,101,188,182],到具体领域的知识[54]。

4.2 多模态PTMS

由于PTMs在许多NLP任务上的成功,一些研究集中在获得PTMs的跨模态版本上。这些模型中的绝大多数是为一般的视觉和语言特征编码而设计的。这些模型是在一些巨大的跨模态数据语料库上进行预训练的,例如带有口语单词的视频或带有字幕的图像,结合扩展的预训练任务来充分利用多模态特征。VideoBERT[152]和CBT[151]是视频和文本的联合模型。为了获得用于预训练的视觉和语言标记序列,视频分别由基于cnn的编码器和现成的语音识别技术进行预处理。在处理后的数据上训练一个变压器编码器,以学习下游任务(如视频字幕)的视觉语言表示。此外,UniViLM[109]提出引入生成任务来进一步预训练下游任务中使用的解码器。

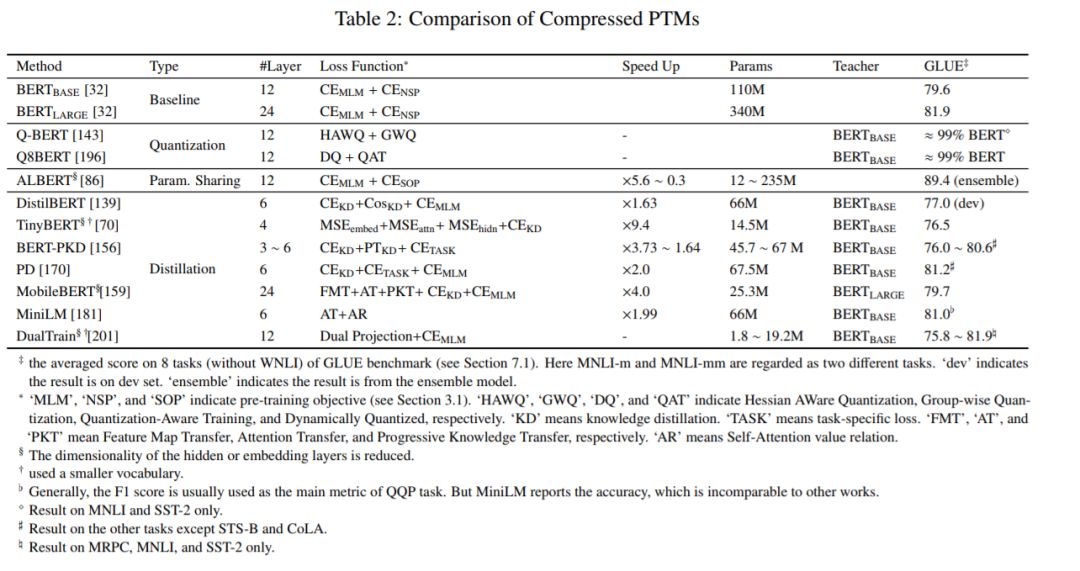

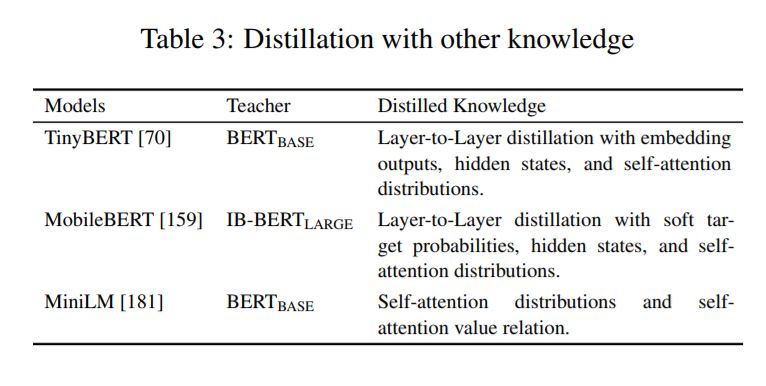

4.3 模型压缩

5. 下游任务应用

6. PTM资源

7. 应用

应用基准、机器翻译、问答、情感分析、摘要、命名实体识别

8. 未来方向

(1) PTMs的上界

目前,PTMs还没有达到其上限。现有的PTMs大多可以通过更多的训练步骤和更大的语料库来进一步完善。

通过增加模型的深度可以进一步提高NLP的技术水平,如Megatron-LM[144](83亿个参数,72个隐藏尺寸为3072和32个注意头的变压器层)和Turing-NLG(170亿个参数,78个隐藏尺寸为4256和28个注意头的Transformer层)。

通用型PTM一直是我们学习语言固有的通用知识(甚至是世界知识)的追求,但此类PTM通常需要更深入的体系结构、更大的语料库和更具挑战性的训练前任务,这又进一步导致了更高的训练成本。然而,训练大模型也是一个具有挑战性的问题,需要更复杂、更高效的训练技术,如分布式训练、混合精度、梯度积累等。因此,更实际的方向是使用现有的硬件和软件设计更有效的模型架构、自我监督的训练前任务、优化器和训练技能。ELECTRA[22]是这个方向的一个很好的解决方案。

(2) 面向任务的预训练和模型压缩

在实践中,不同的下游任务需要不同的PTMs能力。PTMs与下游任务之间的差异通常表现在两个方面:模型体系结构和数据分布。较大的差异可能导致PTMs的益处可能不明显。尽管较大的PTM通常可以带来更好的性能,但一个实际问题是如何在特殊场景(如低容量设备和低延迟应用程序)中利用这些巨大的PTM。因此,我们可以为下游任务精心设计特定的模型架构和预训练任务,或者从现有的PTMs中提取部分特定于任务的知识。

此外,我们可以通过使用模型压缩等技术,用通用的现有PTM来教他们,而不是从头开始训练面向任务的ptm(参见4.3节)。虽然在CV[17]中,针对CNNs的模型压缩已经得到了广泛的研究,但针对NLP的PTMs的模型压缩才刚刚开始。Transformer 的全连接结构也使模型压缩更具挑战性。

(3) PTMs架构

Transformer已被证明是一种有效的预训练体系结构。然而,Transformer 的主要限制是它的计算复杂度,它是输入长度的平方。由于GPU内存的限制,目前大多数PTM不能处理512个标记以上的序列。打破这一限制需要改进Transformer的架构,比如Transformer- xl[27]。因此,为PTMs搜索更有效的模型体系结构对于捕获更长期的上下文信息非常重要。

深度架构的设计具有挑战性,我们可以从一些自动化方法中寻求帮助,如神经架构搜索(neural architecture search, NAS)[205]。

(4)超越微调的知识迁移

目前,将PTMs的知识传递给下游任务的主要方法是微调,但其缺点是参数效率低下:每个下游任务都有自己的微调参数。一种改进的解决方案是对原有PTMs的参数进行修正,并为特定的任务添加小的可调自适应模块[149,61]。因此,我们可以使用一个共享的PTM来服务多个下游任务。事实上,从PTMs中挖掘知识可以更加灵活,如特征提取、知识提取[195]、数据扩充[185,84],利用PTMs作为外部知识[125]等。期望有更有效的方法。

(5) PTMs的可解释性和可靠性

虽然PTM的性能令人印象深刻,但其深层的非线性架构使得决策过程高度不透明。

近年来,可解释人工智能[4]已经成为人工智能领域的一个研究热点。与用于图像的CNN不同,由于Transformer的架构和语言的复杂性,解释PTMs更加困难。人们做了大量的工作(见3.3节)来分析PTMs中包含的语言和世界知识,这有助于我们以某种程度的透明性理解这些PMTs。然而,许多模型分析工作依赖于注意力机制,注意力对可解释性的有效性仍存在争议[66,142]。

此外,随着PTMs在生产系统中的广泛应用,PTMs的可靠性也成为一个备受关注的问题。深层神经模型容易受到对抗性样本的影响,这些例子可能会误导模型,使其产生一个特定的错误预测,而这种预测会受到来自原始输入的难以察觉的干扰。在CV中,对抗性攻击和防御被广泛研究。然而,由于语言的离散性,文本仍然面临着挑战。为文本生成对抗性样本需要具备以下品质:(1)不易被人类法官察觉,但容易被神经模型误导;(2)语法流利,语义与原输入一致。Jin等人[71]用对抗性的例子成功地在文本分类和文本蕴涵方面攻击了经过微调的BERT。Wallace等人[175]定义了通用的对抗触发器,当将模型连接到任何输入时,该触发器可以诱导模型产生特定目的的预测。有些触发器甚至会导致GPT-2模型生成带有种族主义色彩的文本。对PTM进行对抗性攻击的研究有助于我们了解它们的能力,从而充分暴露它们的弱点。Sun等人[155]的研究表明,BERT对拼写错误并不敏感。此外,针对PTMs的对抗防御也很有前途,它提高了PTMs的鲁棒性,使其对对抗攻击免疫。

总的来说,作为许多NLP应用中的关键组件,PTMs的可解释性和可靠性在很多方面还有待进一步的探索,这有助于我们理解PTMs是如何工作的,并为更好的使用和进一步的改进提供指导。

参考文献:

Akbik et al. [2018] Alan Akbik, Duncan Blythe, and Roland Vollgraf. Contextual string embeddings for sequence labeling. In COLING, pages 1638–1649, 2018.

Alberti et al. [2019] Chris Alberti, Jeffrey Ling, Michael Collins, and David Reitter. Fusion of detected objects in text for visual question answering. In EMNLP-IJCNLP, pages 2131–2140, 2019.

Alsentzer et al. [2019] Emily Alsentzer, John R. Murphy, Willie Boag, Wei-Hung Weng, Di Jin, Tristan Naumann, and Matthew B. A. McDermott. Publicly available clinical BERT embeddings. arXiv preprint arXiv:1904.03323, 2019.

Arrieta et al. [2020] Alejandro Barredo Arrieta, Natalia Díaz-Rodríguez, Javier Del Ser, Adrien Bennetot, Siham Tabik, Alberto Barbado, Salvador García, Sergio Gil-López, Daniel Molina, Richard Benjamins, et al. Explainable artificial intelligence (xai): Concepts, taxonomies, opportunities and challenges toward responsible ai. Information Fusion, 58:82–115, 2020.

Baevski et al. [2019] Alexei Baevski, Sergey Edunov, Yinhan Liu, Luke Zettlemoyer, and Michael Auli.Cloze-driven pretraining of self-attention networks. In Kentaro Inui, Jing Jiang, Vincent Ng, and Xiaojun Wan, editors, EMNLP-IJCNLP, pages 5359–5368, 2019.

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“PTM” 就可以获取《【复旦大学】最新《预训练语言模型》2020综述论文大全,50+PTMs分类体系,25页pdf205篇参考文献》专知下载链接