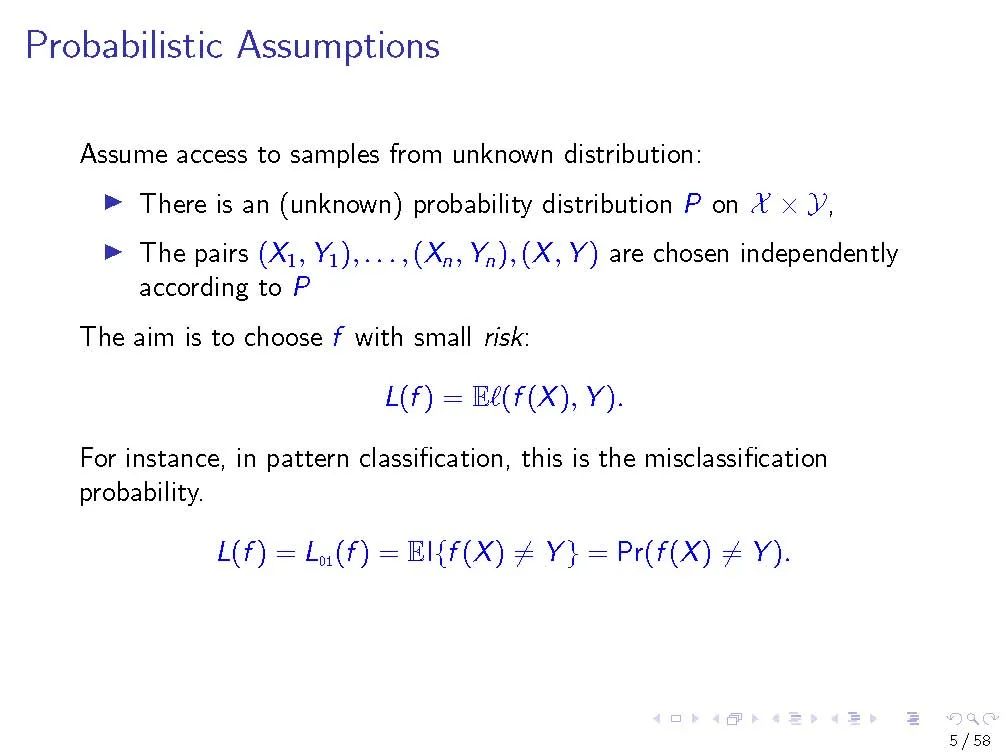

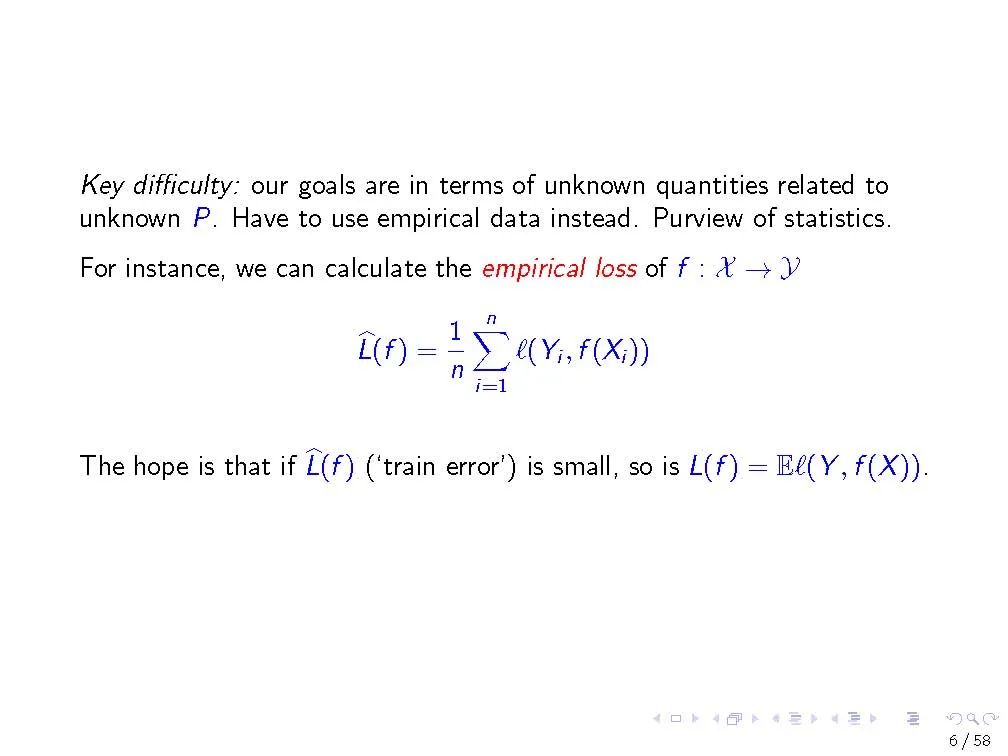

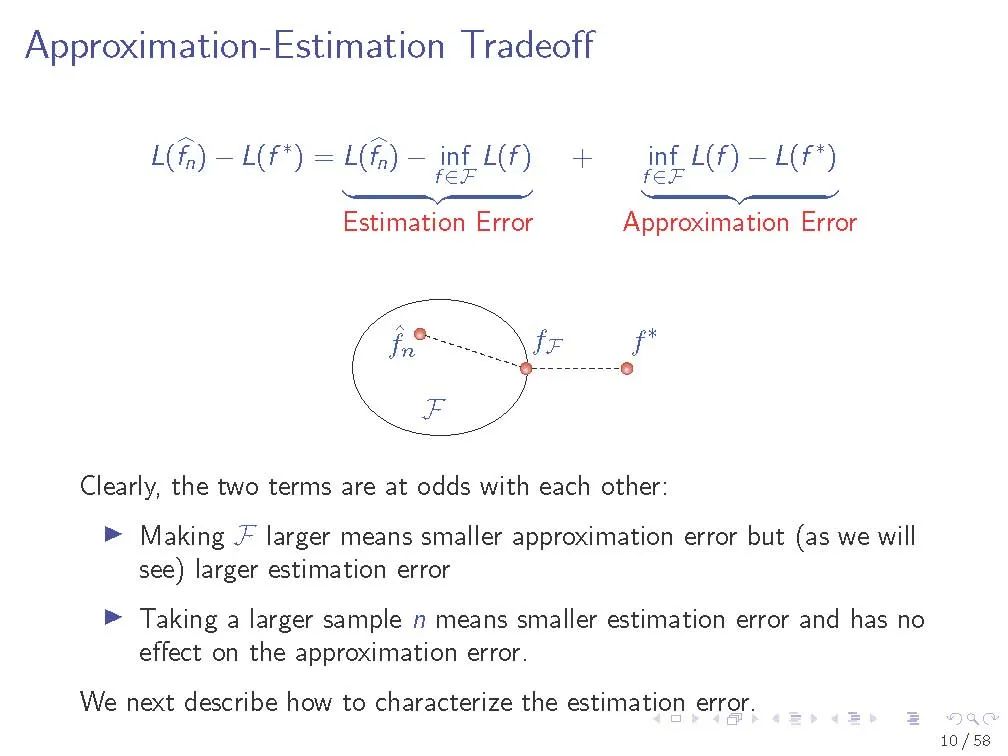

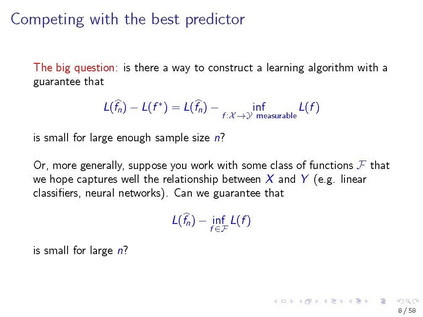

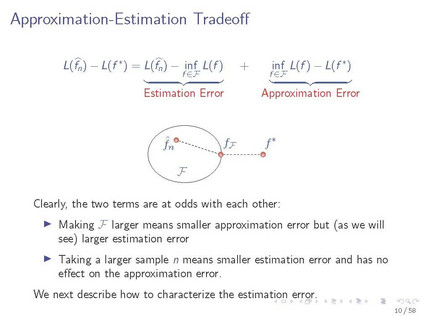

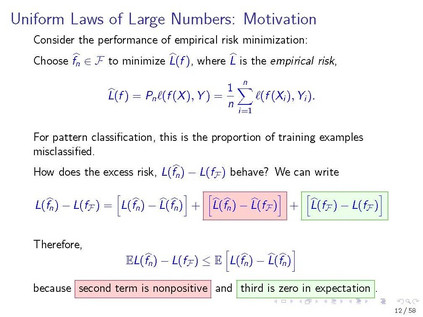

在第一个教程中,我们回顾了来自经典统计学习理论的工具,这些工具对理解深度神经网络的泛化性能很有用。我们描述大数的统一定律,以及它们如何依赖于感兴趣的函数类的复杂性。我们专注于一个特定的复杂性度量,Rademacher复杂性,以及深度ReLU网络中这种复杂性的上界。我们研究了现代神经网络的行为如何与在经典设置中发展的直觉相冲突。

在第二篇教程中,我们将从优化的角度回顾理解神经网络训练的方法。我们回顾了凸目标和光滑目标的梯度下降的经典分析。我们描述了Polyak- Lojasiewicz (PL)不等式,并讨论如何在神经网络训练的背景下解释这样的不等式。我们描述了一种特殊的神经网络训练机制,它可以通过核方法很好地逼近,被称为神经切线核(NTK)机制。我们展示了如何用两种方法建立神经网络的PL不等式:一种基于NTK近似的一般方法,另一种在线性可分离数据的特殊设置中。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2022年10月4日