来自华中科技大学最新《研究用户友好和开源的大型GPT模型:关于语言、多模态和科学GPT模型的调查》,值得关注!

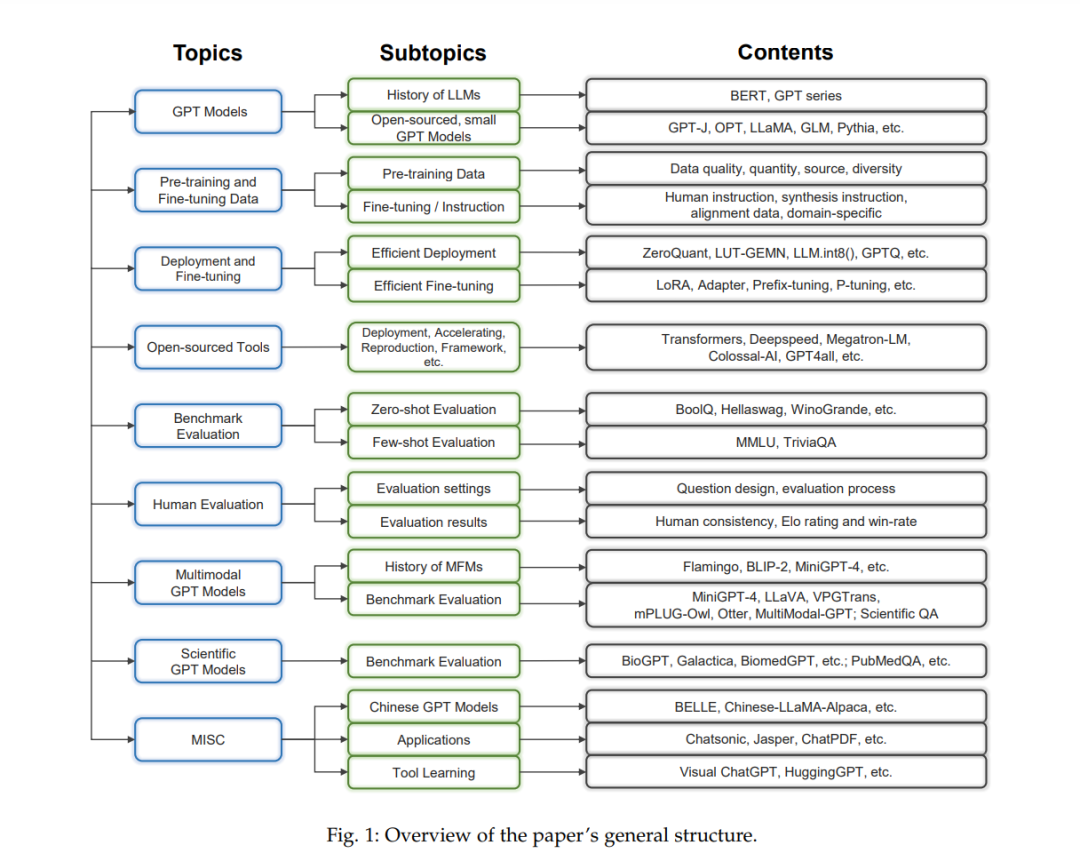

生成预训练变换器(GPT)模型已经彻底改变了自然语言处理(NLP)领域,它们在多种任务中表现出色,而且也扩展到了多模态领域。尽管取得了成功,像GPT-4这样的大型GPT模型却面临着固有的限制,例如庞大的大小、高计算需求、复杂的部署过程以及封闭的开发循环。这些约束限制了它们的广泛应用,并引起了对负责任开发和使用的担忧。由于希望克服这些限制同时保持高性能,因此产生了对用户友好、相对小型且开源的GPT模型的需求。在这篇综述论文中,我们检查了大型GPT的开源替代模型,侧重于用户友好且相对小型的模型,以便更容易部署和使用。本文的主要内容分为以下几点:(1) 调查用户友好且相对小型的替代GPT模型的架构、设计原则和权衡,重点关注它们克服大型GPT模型带来的挑战的能力。(2) 提出数据收集并分析预训练数据源、数据质量、数量、多样性,微调数据包括指令数据、对齐数据以及领域特定模型的领域特定数据。(3) 调查这些GPT模型的高效部署和微调技术。(4) 介绍正在进行的开源项目和倡议,以实现用户友好的GPT模型的复制和部署。(5) 提供对这些相对小型GPT模型的基准评估的全面分析,并提供这些模型在实际使用中的人类评价,以给出一些人类喜欢的推荐。(6) 探讨GPT模型在多模态环境中的扩展,侧重于将NLP与计算机视觉整合的模型,也特别关注用户友好的科学GPT模型和生物医学领域。通过这个广泛的调查,我们旨在为研究人员、实践者和爱好者提供关于大型GPT的用户友好且相对小型的开源模型的全面理解,了解它们目前的状态、挑战和未来的研究方向,激发开发更为高效、可访问和多功能的GPT模型,满足更广泛的科学社区的需求,并推动通用人工智能领域的发展。源内容将持续在 https://github.com/GPT-Alternatives/gpt_alternatives 上更新。

生成预训练变换器(GPT)模型的出现,在自然语言处理(NLP)领域带来了重大变革。这些基于变换器[1]架构的模型,在多种NLP任务中展现了卓越的能力[2, 3]。GPT模型的持续发展导致了越来越大且越来越复杂的版本,例如,大型GPT模型如GPT-4[3]以其无与伦比的性能获得了极大的关注。然而,尽管它们具有卓越的能力,大型GPT模型也存在固有的局限性,限制了它们的广泛采用、可用性和微调。

这些模型的庞大规模导致了高计算需求、巨大的内存使用和复杂的部署过程。例如,最新的模型GPT-4[3]使用了前所未有的计算和数据规模进行了训练。这些限制不仅妨碍了资源有限的研究人员和实践者获取大型GPT模型,还引发了关于它们的能耗和环境影响的担忧。除了这些与资源有关的挑战外,大型GPT模型经常面临与训练数据相关的问题,包括生成偏见或不适当内容的可能性、对刻板印象的加强以及数据收集和预处理的透明度不足。解决这些局限性对于确保GPT模型在各种应用和领域中负责任的发展和部署至关重要。

由于渴望克服上述局限性同时保持大型GPT模型原有的高性能,因此产生了对替代GPT模型的需求。在这篇综述论文中,我们进行了对大型GPT的用户友好、相对小型和开源模型的深入检查,专注于它们的架构、效率、部署策略和微调方法。通过探索这些替代模型,我们旨在提供对它们解决原始大型GPT模型带来的挑战的潜力的见解,并促进更为高效、可访问和负责任的NLP技术的发展。

我们首先对这些开源GPT模型进行全面概述,讨论它们的独特功能、设计原则以及在开发过程中遇到的权衡。我们通过探索减小模型规模、内存使用和计算需求的技术而不牺牲性能,强调这些模型中效率的重要性。这个分析使我们能够确定有前途的方法,这些方法可以帮助减轻大型GPT模型在资源需求和环境影响方面的局限性。

除了资源效率外,我们还研究了在这些GPT模型的发展中起关键作用的各个方面的数据。我们讨论了作为训练这些模型基础的预训练数据源,接着探讨了影响模型性能[2, 4–6]的数据质量、数量和多样性这些重要因素。此外,我们还研究了微调数据,包括指令数据和对齐数据,这些对于改善模型并确保它们能够适应特定任务至关重要[7–10]。最后,我们探讨了针对专业领域的挑战和应用量身定制的模型的域特定数据。 随后,我们研究了部署和微调替代GPT模型的方法和途径,解决了与部署相关的挑战,如硬件限制[11]。我们还讨论了微调策略,包括零射击和少数射击学习,这些可以使这些模型定制用于特定任务和领域,同时减少生成偏见或不适当内容的风险[12–16]。此外,我们还深入研究了不同的开源努力和工具开发。我们检查了开源倡议、库[17–19]和平台[20, 21],这些有助于在研究社区中开发、共享和合作GPT模型,促进更高效、可访问和多功能模型的创新和发展。

重要的是,我们在这些开源GPT替代品的基准评估和人类评估中都赋予了重要的重点,确保了对它们性能的周到评估。具体来说,我们在多个领域的著名基准数据集上测试了这些模型[22–26],提供了它们能力的强健比较。此外,我们通过收集一系列多样化、有意义和具有代表性的指令来进行人类评估,这使我们能够收集到宝贵的实际反馈。深入的结果分析提供了对这些模型的优缺点的宝贵见解。

我们还探讨了多模态[27–29]和科学GPT模型[30, 31]的新兴领域,突出了它们在专业领域的潜在应用和性能。最后,我们总结了整个调查,并深思了替代GPT模型对人工智能领域和整个社会的广泛影响,对GPT模型的现有挑战和局限性进行了讨论,并强调了开发更高效、可访问、可靠和多功能GPT模型的未来方向。

我们研究的替代模型有三个要求:(1)它在大量数据上进行预训练,并且模型的大小相对较小,便于用户友好地使用(近100亿参数)。(2)它满足基本要求,可以生成(主要是基于文本的)内容。(3)模型检查点可访问,因此从业者可以将其用于进一步的研究和下游应用。

2.1 大型语言基础模型的历史

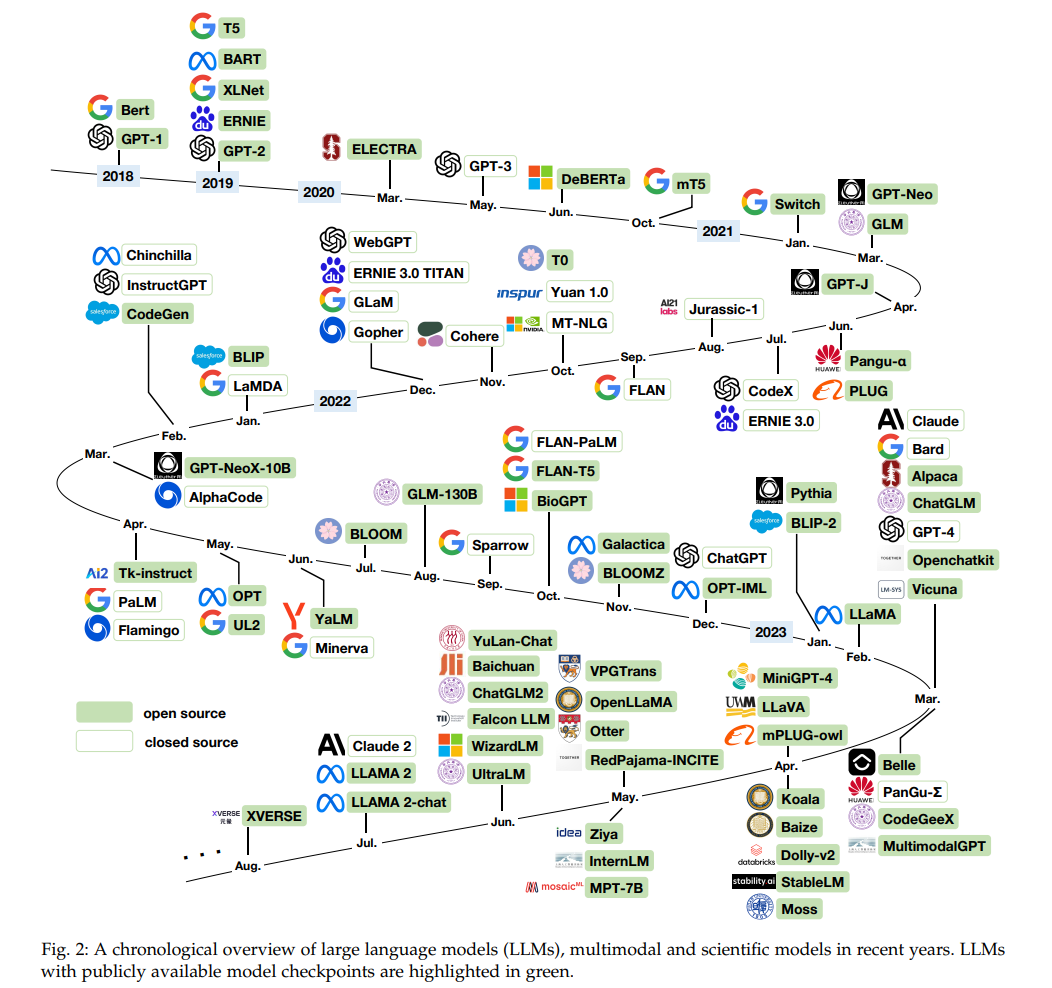

自Transformer[32]模型出现以来,自然语言处理领域发生了重大变革。Transformer模型不仅在性能方面优越(例如,用于机器翻译[32]),而且比RNN[33]模型如LSTM[34]和GRU[35]更易于并行化。GPT-1[36]和Bert[37]是最早尝试利用Transformer模型进行无监督预训练的尝试。通过在大量无标签数据上预训练并在下游数据上微调,它们成为了NLP排行榜上的最先进模型。Bert和GPT-1的不同预训练目标,即遮蔽语言建模和下一个令牌预测,促使了他们的专长。当通过微调比较类似的模型大小时,人们观察到BERT在语言理解任务上的表现优于GPT,而GPT更适合语言生成任务。从GPT-1[36]和GPT-2[38]到GPT-3[2]的GPT模型的演变,观察到了自回归语言模型的两个突出特征:(1)通过增加模型大小和预训练数据大小,可以提高性能。(2)GPT-3通过执行上下文学习和提示,展现出了非凡的少样本和零样本性能。自GPT-3成功以来,已经开发出越来越多的大型语言模型。此后,大型语言模型的发展中的一个里程碑是ChatGPT1的出现,这是一个经过强化学习人类反馈(RLHF)微调的会话模型,并建立在GPT-3.5的基础上,这是GPT-3的升级版本。通过人类偏好的对齐,ChatGPT展现出了出色的会话熟练度,并迅速在公众中得到了认可。继ChatGPT的卓越成就之后,社区最近见证了GPT-4[3]的发布。GPT-4展示了改进的会话熟练度、增强的上下文理解能力和更准确、连贯的回应。通过采用前沿技术并基于ChatGPT和GPT-3.5的成功,GPT-4在多个领域(例如,多模式)取得了重大进展,这标志着大型语言模型演变的另一里程碑,展示了在不久的将来实现更多突破性创新和应用的潜力。在这个过程中,整个AI社区为开发类似GPT的大型语言模型付出了巨大的努力,既有大公司(例如Bard2)旨在构建更强大的模型,也有创建开源替代品(例如LLaMA[39])以促进基础模型的发展。近年来,这些大型语言模型(LLMs)的概述历史如图2所示。

2.2 开放式语言基础模型

在本节中,我们介绍了由整个社区开发的开源语言模型的努力。对于这些语言基础模型,我们主要集中在以下几个方面:1)模型结构:Transformer[32]架构已成为大型语言模型的通用架构。Transformer架构主要有三种适应,即仅编码器,仅解码器和编码器-解码器。顾名思义,仅编码器Transformer只利用编码器部分,例如Bert[37],ERNIE[83],ELECTRA[84]等。仅解码器Transformer只利用解码器部分,例如GPT系列[2, 36, 38],OPT[46],BLOOM[6],PaLM[4],LLaMA[85]等。编码器-解码器Transformer利用整个Transformer架构,例如T5[40],Bart[86],GLM[87]等。值得注意的是,本次调查论文主要关注基于解码器的GPT类模型。

2)预训练数据集:模型的性能和泛化能力受到预训练数据的质量和大小的显著影响。重点主要在公共数据集上。数据集的两个常用来源是网络爬取和书籍/文学。以LLaMA[39]为例,预训练数据集是多个公开可用源的混合,包括English CommonCrawl、C4[40]、Github、维基百科、Gutenberg和Books3以及Stack Exchange。

3)预训练任务:语言建模,即下一个标记预测,在大型语言模型中是主导的预训练任务。最早从GPT-3[2]观察到,扩大模型规模和预训练数据可以极大地提高模型的少样本/零样本能力。使用此预训练任务的其他代表性模型包括PaLM[4],LLaMA[39]等。早期工作,例如Bert[37],RoBERTa[88]采用了掩蔽语言建模目标。尽管这些模型擅长自然语言理解,但它们在语言生成和少样本/零样本能力方面却不如人意。其他工作,如T5[40]和GLM[87]使用去噪预训练目标。

接下来,我们将介绍几个在上述方面开源的语言模型。这些模型的历史总结在图2中。

T5[40]是一个基于C4[40]用1T标记预训练的编码器-解码器transformer模型。预训练目标是去噪目标,即掩蔽连续范围的标记并仅预测丢弃的标记。发布的模型检查点包括60M、220M、770M、3B和11B。基于T5的Flan-T5[89]在链式思维数据上进行微调,其在下游任务上的性能比T5好得多。

mT5[41]是一个覆盖101种语言的多语言编码器-解码器transformer模型,用1T标记预训练。预训练目标与T5相同。发布的预训练模型检查点包括300M、580M、1.2B、3.7B和13B。

GPT-J[45]是一个基于Pile[43]训练的开源英语自回归语言模型(GPT-like),拥有60亿参数。它是一个仅使用下一个标记预测目标训练的解码器模型。

GPT-Neo[42]是GPT3-like模型的实现。它是一个解码器模型,用下一个标记预测目标进行训练,并在Pile[43]数据集上进行训练。发布的预训练模型检查点包括125M、350M、1.3B和2.7B。GPT-NeoX-20B[44]是GPT-Neo的更大扩展版本,发布的是一个200亿参数模型。

OPT[46]是一套仅解码器的预训练transformer。训练目标也是下一个标记预测。发布的模型检查点包括125M、1.3B、2.7B、6.7B、13B、30B、66B和175B。

Bloom[6]是一个开放存取的多语言语言模型。它是一个仅使用下一个标记预测目标训练的解码器模型。发布的模型检查点包括560M、1B1、1B7、3B、7B1和176B。BloomZ是基于Bloom的多任务提示微调模型。 GLM[50, 52]是一个预训练的编码器-解码器模型,具有自回归空白填充目标。发布的预训练模型检查点包括110M、335M、410M、515M、2B、10B和130B。ChatGLM-6B和ChatGLM2-6B是基于GLM进行微调的两个开源的中英文双语聊天模型。 LLaMA[39]是一个与GPT-3相似的开源自回归语言模型,进行了适度的架构修改。发布的预训练模型检查点包括7B、13B、33B和65B。由于LLaMA是第一个被广泛认可的性能满意(与GPT-3相当)的开源大型语言模型,因此我们认为LLaMA是在大型语言模型领域开放源码的里程碑。

2.3 评估模型

在本次调研中,我们的主要贡献是探索了各种类似GPT的开放模型的潜力,通过在多个维度上进行全面评估。这些维度包括通用语言基准,这是这些语言模型的主要关注点,还包括科学领域数据集和多模态数据集,作为这些多模态基础模型和科学GPT模型的额外评估。另一个重要的是我们付出了大量努力的人工评估。因此,评估的模型在表2中列出,用于语言模型和科学语言模型,在表3中列出,用于多模态模型。所有评估中的模型都来自Huggingface [17] 或原始的 Github 仓库。

总之,我们对大约10B不同模型大小的32个开源模型进行了评估。更具体地说,我们对表2中的24个模型进行了语言和科学GPT模型的基准评估,对表3中的8个模型进行了多模态GPT模型的基准评估。对于人工评估,我们评估了其中的16个模型,进行了相对全面的研究,以得出更有说服力的结果。

2.4 评估提示

为了建立基线模型的性能并实现公平比较,我们采用了与[97]的工作中使用的类似的提示结构,贯穿我们的整个评估和研究。我们使用的提示模板在图3中说明。而且,在图3中,占位符{{System meta instructions}}将用表4中的相应文本替代,用于已正式发布系统元指令的模型。对于没有这样的指令的模型,我们使用一个空字符字符串来替换占位符。此外,我们遵循[97],利用logit_bias来鼓励模型仅产生有效的响应。

结论

在这项调查中,我们对大型生成预训练变换器(GPT)系统的替代开源模型进行了全面审查,特别关注了用户友好且相对较小的模型,这些模型克服了其更大的同类所带来的限制。我们的研究强调了这些开源的GPT类似模型的潜力,它们能够解决与尺寸、复杂性和封闭开发环路相关的挑战,同时仍然能够在各种任务中维持高性能,并将其功能扩展到多模态领域。

我们展望未来,可以看到更多的研究和发展集中在创建更加有效、可扩展和用户友好的开源模型上。这些模型将克服当前大型模型的限制,提供更加灵活和多样化的解决方案,满足不同的应用需求。同时,这也推动了多模态学习和生成模型的研究,加深了我们对模型和数据的理解,为进一步的创新和发展奠定了基础。 未来方向可能会集中在减小模型大小和复杂性、提高模型泛化能力、开发多模态和跨模态模型、实现更有效的训练和微调方法等方面。此外,将持续关注开发更多用户友好和易于使用的模型,以及进一步推动开源和共享资源的发展,使更多人能够受益。