摘要——多模态大语言模型(Multimodal Large Language Models,MLLMs)通过融合视觉与语言推理能力,能够应对图像描述、视觉问答等复杂任务。尽管 MLLMs 展现出卓越的通用性,但在特定应用场景中的性能仍然受限。针对下游任务对 MLLMs 进行调优主要面临两大关键挑战:任务专家化(Task-Expert Specialization),即预训练数据分布与目标任务数据分布之间的差异限制了目标性能的提升;以及开放世界稳定性(Open-World Stabilization),即灾难性遗忘会导致模型丧失原有的通用知识。本文系统性地综述了近年来 MLLM 下游调优方法的最新进展,并将其归纳为三种范式:(I)选择性调优(Selective Tuning)、(II)加性调优(Additive Tuning)以及(III)重参数化调优(Reparameterization Tuning)。此外,我们在多种主流 MLLM 架构和多样化下游任务上对这些调优策略进行了系统基准评测,以建立标准化的评估分析框架和系统性的调优原则。最后,我们总结了该领域中仍然存在的若干开放挑战,并提出了未来的研究方向。为促进这一快速发展领域的持续进步,我们还提供了一个持续更新的公共资源库,用于跟踪相关研究进展:https://github.com/WenkeHuang/Awesome-MLLM-Tuning。 **关键词——**多模态大语言模型,下游调优,专用能力提升,泛化稳定性

1 引言

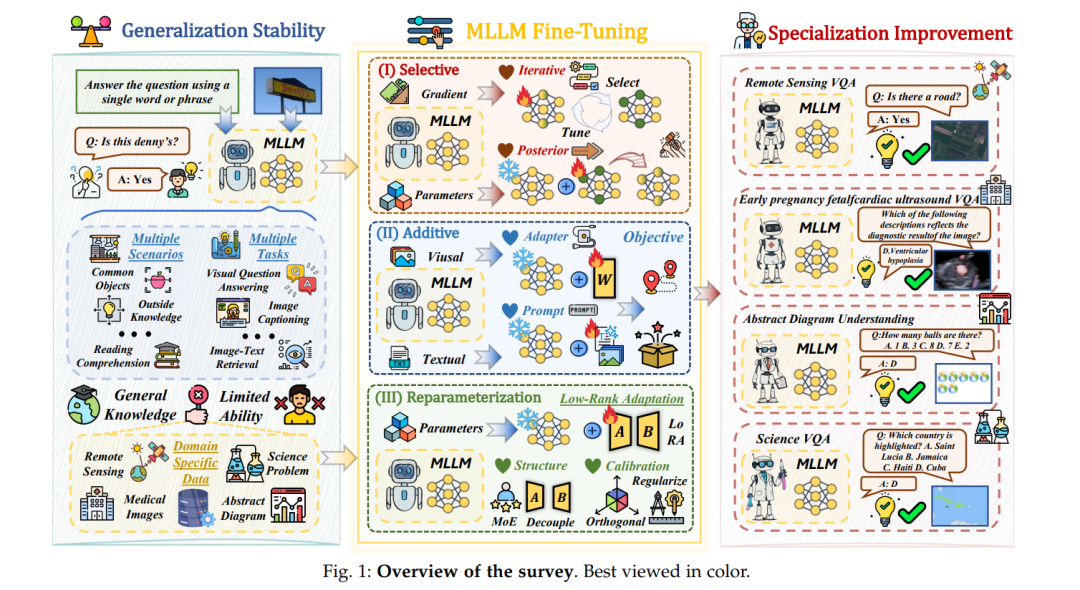

大型语言模型(Large Language Models,LLMs)的成功显著重塑了人工智能领域的发展格局,在自然语言理解与生成方面展现出前所未有的能力 [1]–[5]。其卓越的通用性与可扩展性在多个领域树立了新的性能基准,从对话式智能体到复杂问题求解任务均取得了突破性进展。为进一步拓展 LLM 的应用边界,研究者们投入了大量努力,将 LLM 扩展为多模态大语言模型(Multimodal Large Language Models,MLLMs)。这类模型在处理视觉输入并生成连贯且上下文相关的文本描述方面表现出色 [6]–[10]。这种跨模态融合显著拓宽了人工智能的能力边界,使模型具备多模态理解与交互能力。 近年来,MLLM 已迅速从图像描述、视觉问答等基础任务,发展为能够执行复杂推理与创造性生成的高级系统。鉴于 MLLM 通常在大规模、多类型的多模态指令跟随数据集上进行优化 [11]–[15],其在开放世界场景下对相关任务展现出强大的泛化能力。MLLM 的快速发展推动了其在众多实际应用中的落地,包括自动驾驶 [16]、[17]、医疗诊断 [18]、[19] 以及遥感分析 [20] 等。 尽管具备上述优势,MLLM 在某些专业领域或私有数据集上的表现仍然不尽如人意 [21]–[25]。因此,针对下游任务对 MLLM 进行调优(tuning)已成为提升性能的有效途径。在调优阶段,MLLM 能够进一步增强特定任务性能,或使模型行为更好地对齐人类期望 [26]、[27]。然而,尽管调优具有显著潜力,MLLM 在保持良好泛化能力方面仍面临严峻挑战。这主要源于下游数据集往往与预训练阶段所学习到的通用数据分布存在显著差异。模型在适应目标分布的过程中,可能会丧失在预训练阶段获得的通用能力。此外,新知识的学习对已有通用知识产生的负面影响——即灾难性遗忘(catastrophic forgetting)——也是下游适配中一个众所周知的问题 [22]、[23]、[28]–[30]。 为明确本综述的研究动机,我们形式化地总结了 MLLM 下游调优中的两个核心挑战: ♠ 任务专家化(Task-Expert Specialization):当下游数据集呈现出与预训练阶段显著异构的分布特性时,预训练 MLLM 在目标任务上的性能往往受到限制,因此需要通过下游调优使模型演化为特定领域的专家模型。 ♣ 开放世界稳定性(Open-World Stabilization):在针对下游分布进行优化后,MLLM 可能遭受灾难性遗忘,从而丢失在预训练阶段获得的通用知识,最终损害其整体泛化能力。 针对上述挑战,近年来研究者提出并发展了多种先进的调优策略,整体可归纳为以下三大类:(I)选择性调优(Selective Tuning,§3.1),通过选择与下游任务高度相关的参数子集进行更新;(II)加性调优(Additive Tuning,§3.2),在输入空间或模型内部结构中引入额外的可训练模块;(III)重参数化调优(Reparameterization Tuning,§3.3),利用低秩矩阵分解等技术对原始参数权重进行重构。 尽管现有调优方法已被广泛研究,多模态大语言模型领域仍缺乏统一的评估分析框架,用以系统性地衡量不同调优策略在 MLLM 场景下的有效性与独特性。此外,缺乏系统化的调优原则也导致实现流程存在不确定性,进而引发冗余的超参数实验和低效的资源配置。因此,构建全面的评估体系与严格的调优指导原则,对于加速 MLLM 在时间和人力成本受限的真实应用场景(如医学影像分析和遥感任务)中的部署至关重要。本文在图 1 中给出了整体研究概览。

1.1 相关综述工作

随着多模态大语言模型(MLLM)近年来迅速成为研究热点,大量综述性论文相继出现。现有综述大致可分为两类:第一类侧重于 MLLM 的整体发展脉络,强调其在多个应用领域中的潜力,但由于聚焦于概念框架与宏观指导,往往忽视了对具体下游挑战与问题的深入探讨;第二类工作对现有调优方法提供了宽泛的总结,但缺乏系统性的概念框架和针对具体调优技术的深入评估。 尽管少数研究 [31]、[32] 讨论了模型稳定性问题,但其主要关注持续学习(continual learning)范式,即研究神经网络如何在持续学习新知识的同时保持已有知识 [33]–[38],难以直接适配到 MLLM 场景中。MLLM 不仅具有独特的模型结构,还涉及多样化的调优选择,使得传统持续学习方法难以直接迁移。 总体而言,随着该领域的快速发展,**专家化(Specialization)与稳定性(Stabilization)**已成为下游调优多模态大语言模型的两个关键维度:前者确保模型在目标分布上的性能,后者保障模型在广泛通用任务上的适应能力。尽管近年来涌现出大量新工作,现有综述多从碎片化视角出发,缺乏统一分析。相比之下,我们认为这两个方面是相互耦合、共同决定 MLLM 实际部署效果的核心因素。本文是首个同时系统研究下游专家化与上游稳定性,并在多视角实验分析中进行统一基准评测的综述工作。

1.2 论文结构

本文结构如图 1 所示,具体安排如下: §1 介绍多模态大语言模型(MLLM)的发展背景,并概述其在真实场景下调优所面临的两大技术挑战:任务专家化与开放世界稳定性。 §2 系统介绍 MLLM 的建模形式及其调优流程,并进一步指出专家化提升与稳定性遗忘问题。 §3 给出调优方法的分类体系:§3.1 讨论选择性调优方法,通过更新部分已有参数以适应下游分布;§3.2 介绍加性调优方法,通过引入额外参数模块实现领域适配;§3.3 探讨重参数化调优方法,如 LoRA 等模块对参数空间的重构。 §4 进行 MLLM 调优的系统性基准分析,其中 §4.1 描述实验设置、数据集与评估指标,§4.2 比较不同调优方法在多种下游数据集上的表现,§4.3 总结调优原则并分析其内在机理。 §5 讨论开放挑战与潜在研究方向,§5.1 展望未来工作,§5.2 对全文进行总结,强调 MLLM 调优在实际应用中的重要性。

1.3 主要贡献

为弥补现有研究空白,本文对 MLLM 调优过程中专家化与稳定性行为的产生机制进行了系统而及时的综述,主要贡献包括: * 全面综述:深入分析 MLLM 调优过程中专家化与稳定性问题,提供首个系统性、最新进展导向的多模态大语言模型调优综述,涵盖该领域数百篇相关研究。 * 深入分析:选取发表于顶级期刊与会议的代表性调优方法,对现有 MLLM 调优技术进行系统分类,并深入剖析各类方法的优势与局限。 * 系统基准评测:在多种下游场景下对不同调优策略进行全面基准实验,结合专家化与稳定性评估指标,为研究者选择合适基线方法提供实践指导。 * 前瞻性展望:讨论未来潜在研究方向,推动社区重新思考并改进多模态大语言模型在实际应用中的调优设计,促进该领域的持续发展。