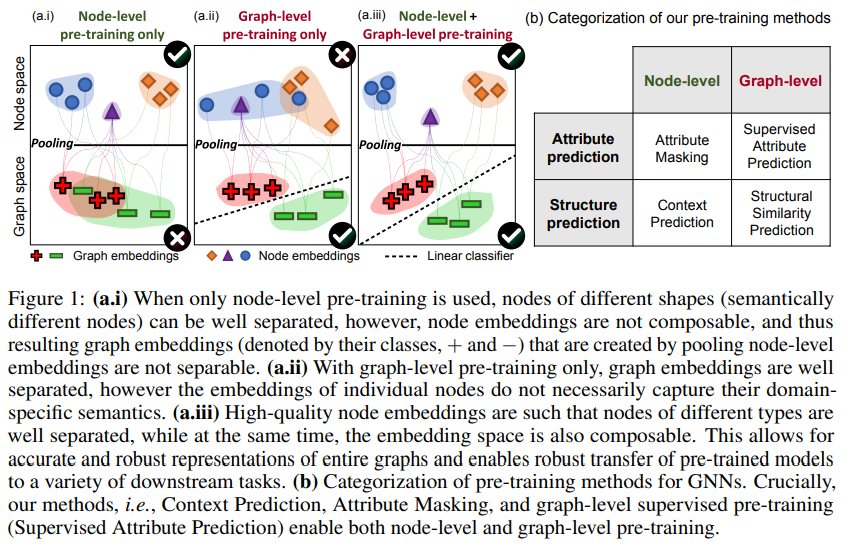

机器学习的许多应用都需要一个模型来对测试样本做出准确的预测,这些测试样本在分布上与训练示例不同,而在训练期间,特定于任务的标签很少。应对这一挑战的有效方法是,在数据丰富的相关任务上对模型进行预训练,然后在下游任务上对其进行微调。尽管预训练在许多语言和视觉领域都是有效的,但是如何在图数据集上有效地使用预训练仍是一个有待解决的问题。本文提出了一种新的图神经网络训练策略和自监督方法。我们的策略成功的关键是在单个节点以及整个图的层次上预训练一个具有强表示能力的GNN,以便GNN能够同时学习有用的局部和全局表示。我们系统地研究了多类图分类数据集的预处理问题。我们发现,在整个图或单个节点级别上对GNN进行预训练的朴素策略改进有限,甚至可能导致许多下游任务的负迁移。相比之下,我们的策略避免了负迁移,显著提高了下游任务的泛化能力,使得ROC-AUC相对于未经训练的模型提高了9.4%,实现了分子特性预测和蛋白质功能预测的最好性能。

成为VIP会员查看完整内容

相关内容

专知会员服务

99+阅读 · 2020年7月3日

专知会员服务

26+阅读 · 2020年3月26日

专知会员服务

140+阅读 · 2019年12月16日

Arxiv

16+阅读 · 2020年3月30日

Arxiv

13+阅读 · 2019年5月22日

Arxiv

8+阅读 · 2019年5月20日

Arxiv

13+阅读 · 2018年9月7日