论文浅尝 | GMNN: Graph Markov Neural Networks

论文笔记整理:吴锐,东南大学硕士研究生,研究方向为自然语言处理

来源:ICML 2019

链接:http://proceedings.mlr.press/v97/qu19a/qu19a.pdf

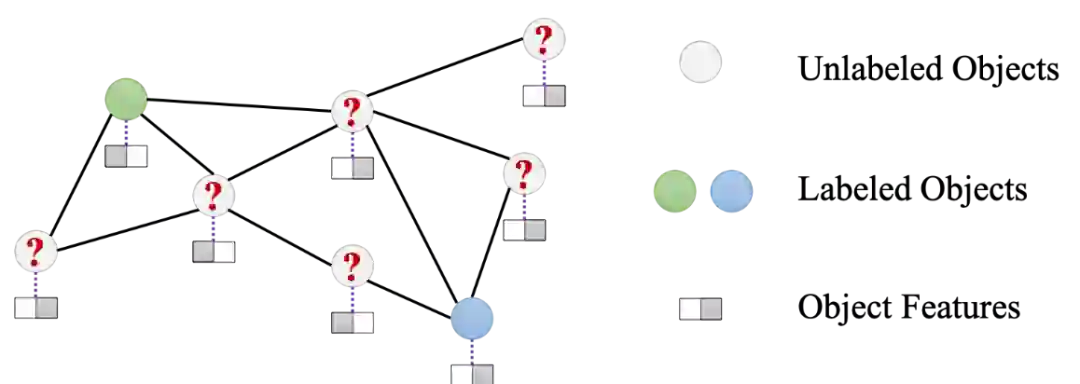

问题定义

弱监督下的在关系数据中的对象分类。形式化地来说,给定一个图G,图上有结点V表示一系列对象,在对象间存在有一系列边E,且每个结点都有对应的属性XV。当前已知部分结点L的标签,目的是推测出剩余结点U的标签值。

相关工作

该问题当前主要可以从两个方向进行研究:

1)统计关系学习(SRL, Statistical Relational Learning)

以统计模型来对关系数据进行建模,代表性的方法有条件马尔可夫网络(relational Markov networks)和马尔可夫逻辑网(Markov logic networks)。这些方法通常使用条件随机场来对对象之间的依赖关系进行建模,也正是因为这种建模的有效性,这些方法能够在弱监督的对象分类上取得不错的效果。

2)图神经网络(GNN, Graph Neural Network)

通过非线性的神经结构,能够以端到端的方式学习到有效的对象表示(representation),从而解决对象分类的问题。例如图卷积网络(graph convolutional networks)可以有效地将周围结点的信息学习到结点的表示当中。这类方法由于能够有效地从关系数据中学习到对象的表示,目前已经达到了SOTA的表现。

存在的问题

在传统的统计关系学习方法中,存在着以下缺陷:

1) 由于这些方法通常采用CRF进行建模,因此需要手动地构造一些特征函数来作为势函数的组成部分,而这些特征函数往往是启发式的,从而导致了模型的能力有限;

2) 由于对象之间关系结构的复杂性,导致难以推理(inference)出未知标签的结点U的后验分布(posterior distribution)。

在图神经网络的方法中,由于各个结点的标签是根据相关的表示分别预测的,因此忽略了各个结点的标签之间的依赖性

方法

提出图马尔可夫神经网络(GMNN, Graph Markov Neural Network),结合了SRL与GNN的优点,既能够学习到有效的结点表示,也能够对结点标签之间的依赖进行建模。

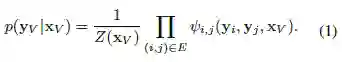

具体来说,GMNN仍然以CRF对已知结点标签之间的联合条件概率分布(以所有结点的属性为条件)进行建模。

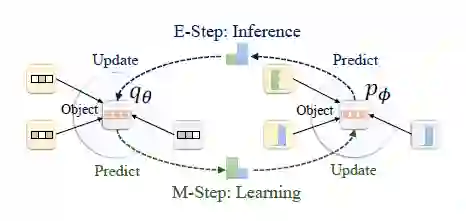

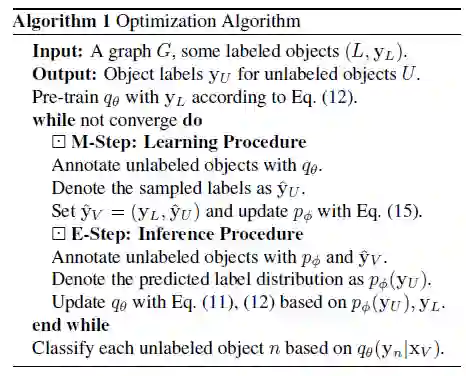

该模型可以有效且高效地通过变分EM框架进行优化,在推断(E步)与学习(M步)中不断交替、迭代。

在E步中,由于具体的后验分布是难以计算的,因此引入了平均场近似(mean-field approximation)。

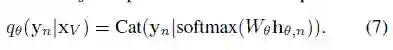

受摊还推断(amortized inference)的启发,同样使用一个GNN来参数化结点标签的后验分布,该GNN能够学习到有利于标签预测的结点的表示。

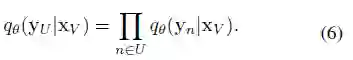

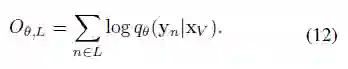

目标函数如下:

可以理解用变分的方法,不断减小q与真实的后验分布之间的KL散度,使得q不断逼近真实的后验分布(式11),同时由于部分已知标签的存在,因此该部分结点标签的概率分布直接使用真实值即可(式12)。

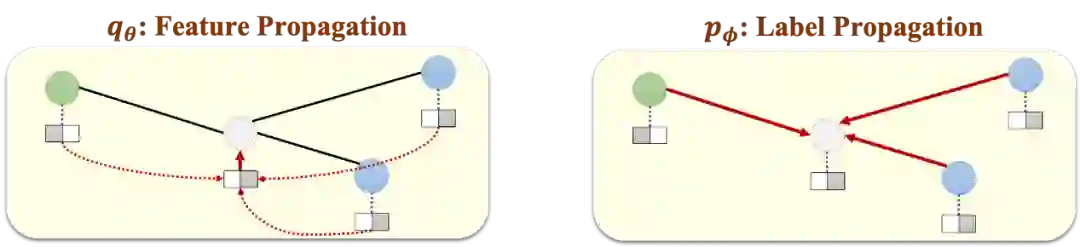

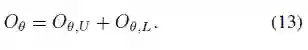

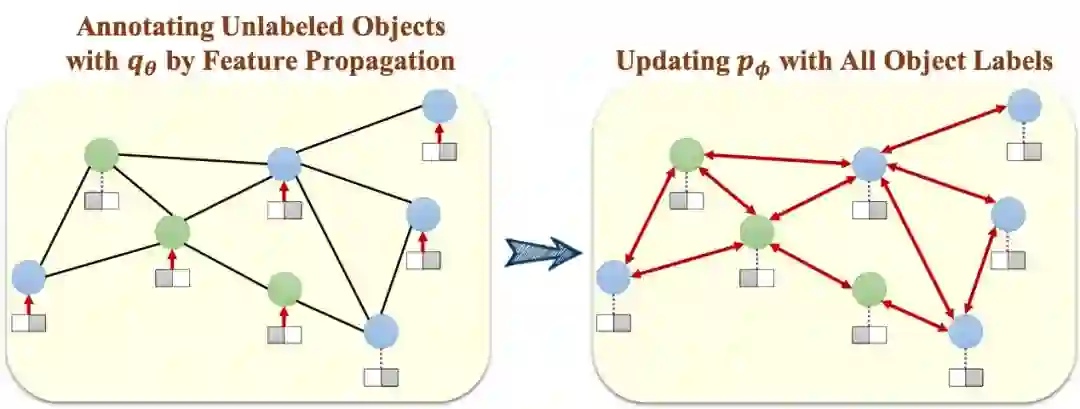

E步的形式化过程如下图:

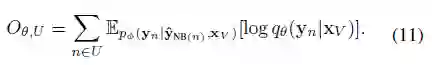

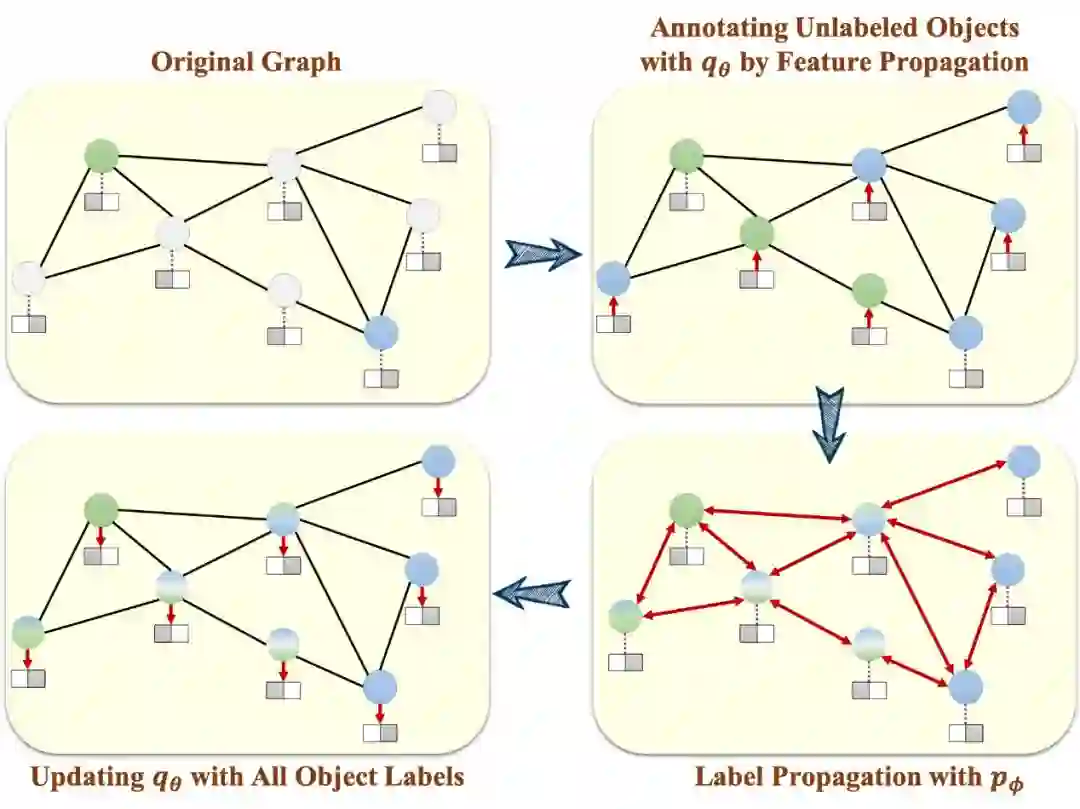

在M步中,由于直接优化似然函数存在困难,因此以优化伪似然(pseudolikelihood)的方式来代替极大似然方法。

用一个GNN来参数化局部的结点标签的条件概率分布。

这样就能够对结点标签之间的依赖性进行建模,并且不需要手动构建势函数。目标函数如下:

M步的形式化过程如下图:

具体的优化算法如下:

OpenKG

开放知识图谱(简称 OpenKG)旨在促进中文知识图谱数据的开放与互联,促进知识图谱和语义技术的普及和广泛应用。

点击阅读原文,进入 OpenKG 博客。